- •Глава I. Введение

- •Часть I/1. Вступление

- •Часть I/2. Благодарности

- •Часть I/3. Предисловие

- •Часть I/4. Содержание

- •Глава II. Цифры, числа... Берем врага количеством

- •Часть II/1. 5 причин ставить внешние ссылки у себя на сайте

- •Часть II/2. 5 способов увеличить продажи при продвижении сайта

- •Часть II/3. 5 советов по созданию практичной 404-ой страницы

- •Часть II/4. 7 секретов успешного сайта

- •Часть II/5. 7 признаков покупных ссылок

- •Часть II/6. 7 спорных вопросов, возникающих при покупке ссылок

- •Часть II/7. 7 способов превратить Ваш сайт в Линкомагнит

- •Часть II/8. 9 экспертных SEO советов для маленького бизнеса

- •Часть II/9. 10 самых популярных SEO мифов

- •Часть II/10. 10 практических советов по обмену ссылками

- •Часть II/11. 10 правил внутренней перелинковки страниц

- •Часть II/12. 10 актуальных способов получить бесплатные ссылки на сайт

- •Часть II/13. 10 способов доказать ценность вашей SEO работы

- •Часть II/14. 10 заповедей SEO-оптимизатора

- •Часть II/15. 11 советов по составлению успешных URL адресов

- •Часть II/16. 13 факторов оценки конкуренции по запросу

- •Часть II/17. Как заставить ссылки работать? 15 принципов наращивания ссылок

- •Часть II/18. 15 советов по раскрутке сайта или блога

- •Часть II/19. 17 факторов которые учитывают поисковики при расчете веса ссылки

- •Часть II/20. 32 самых важных SEO подсказок

- •Часть II/21. 44 каталога статей

- •Часть II/22. Продвижение сайтов пресс-релизами и 53 каталога, куда их можно добавить

- •Часть II/23. 69 методов наращивания ссылочной массы прошедшего года

- •Часть II/24. 100 новых способов получения внешних ссылок

- •Часть II/25. 101 совет по покупке текстовых ссылок

- •Часть II/26. 149 англоязычных каталогов статей

- •Часть II/27. Как я увеличил посещаемость этого блога с 350 до 1000 человек

- •Часть II/28. Как из одной статьи сделать тысячи

- •Часть II/29. Как увеличить посещаемость с 0 до 3600 посетителей в сутки за 1 год

- •Часть II/30. Как получить 10000 ссылок за 3 недели

- •Глава III. Продвижение ссылками

- •Часть III/1. Искусство покупки ссылок

- •Часть III/2. Как правильно покупать ссылки на блог? Часть 1

- •Часть III/3. Как правильно покупать ссылки на блог? Часть2!

- •Часть III/4. Естественные и неестественные (SEO) ссылки

- •Часть III/5. Как влияют плохие ссылки на позиции сайта

- •Часть III/6. Как не купить ссылку с плохого сайта?

- •Часть III/7. Понимание методов выявления ссылочного спама

- •Часть III/8. Описание поискового спама

- •Часть III/9. Непот фильтр: особенности и методы определения

- •Часть III/10. Как создать ГС и попасть под АГС?

- •Часть III/11. За что я попал под фильтр АГС и как из него выйти?

- •Часть III/12. Что делать с сайтом под АГС?

- •Часть III/13. Как быстро Google снимает фильтры с сайта

- •Часть III/14. Как выйти из-под фильтров Google?

- •Часть III/15. Как вывести сайт из-под фильтра

- •Часть III/17. Обратные ссылки с профилей трастовых ресурсов за бесплатно

- •Часть III/18. Вечные ссылки, трафик, околоссылочный текст

- •Часть III/19. Околоссылочный текст и анкор-листы

- •Часть III/20. Как разместить бесплатную ссылку на сайт

- •Часть III/21. Вечные ссылки: что должен знать оптимизатор?

- •Часть III/22. Покупаем ссылки с минимальным риском и максимальной пользой

- •Часть III/23. Внешние ссылки из профилей

- •Часть III/24. Инструкция по покупке ссылок в подписях на форумах

- •Часть III/25. Google дает больший вес естественным ссылкам, располагающимся в тексте

- •Часть III/26. Как определить передает ли сайт вес ссылкам?

- •Часть III/27. Стоит ли обмениваться взаимными ссылками?

- •Часть III/28. Секрет ссылочного обмена, или почему обмен ссылками держит сайты в Топе

- •Часть III/29. Ссылки с футера все еще работают!!

- •Часть III/30. Внутренние ссылки: сколько ссылок слишком много?

- •Часть III/31. Вспоминаем главное свойство ссылок

- •Часть III/32. Вопрос Sevab - польза от nofollow ссылок

- •Часть III/33. Методы получения обратных ссылок на Интернет-магазин

- •Часть III/34. Плановая раскрутка интернет-магазина

- •Часть III/35. Ценность ссылок и разнообразие доменов

- •Часть III/36. Факторы, влияющие на работоспособность ссылок

- •Часть III/37. Как добыть ссылки в трудных нишах

- •Часть III/38. Разбавляем ссылки при продвижении сайта

- •Часть III/39. Естественные ссылки за деньги

- •Часть III/40. Покупка ссылок: классификация параметров для отсева

- •Часть III/41. Практические советы по наращиванию ссылочной массы

- •Часть III/42. 33 способа привлечения ссылок на сайт

- •Часть III/43. Есть ли разница между покупными и бесплатными ссылками?

- •Часть III/44. Как проверить наличие ссылок на сайт

- •Часть III/45. Почему все так боятся исходящих ссылок?

- •Часть III/46. Вред от исходящих ссылок

- •Глава IV. Грамотное составление анкоров ссылок

- •Часть IV/1. Распределение анкоров ссылочной массы

- •Часть IV/2. Составляем анкоры и описания для продвижения сайта

- •Часть IV/3. Анкор — что это такое и насколько важны анкор листы в продвижении сайта

- •Часть IV/4. Советы по грамотному составлению анкоров

- •Часть IV/5. Составляем анкоры ссылок – 5 ключевых моментов

- •Глава V. Сервисы по анализу и получению ссылок

- •Часть V/1. Лучшие SEO сервисы

- •Часть V/2. Биржи ссылок

- •Часть V/3. Обзор англоязычных бирж, где можно взять ссылки с разовой оплатой

- •Часть V/4. Купить трастовые ссылки теперь просто

- •Часть V/5. Cапа. Советы новичкам

- •Часть V/6. Сервисы покупки постовых и контекстных ссылок

- •Часть V/7. 30 полезных инструментов для SEO-аналитики

- •Часть V/8. Сервисы определения ссылочного бюджета

- •Глава VI. Индексация сайта

- •Часть VI/1. Среднее время индексации

- •Часть VI/2. Часто задаваемые вопросы по индексации страниц сайта

- •Часть VI/3. Nofollow и noindex или как закрыть от индексации ссылки и не потерять статический вес

- •Часть VI/4. 10 проверенных методов ускорить индексацию сайта

- •Часть VI/5. 15 советов по ускорению индексации сайта и блога!

- •Часть VI/6. Как ускорить индексацию сайта - 18 эффективных способов

- •Часть VI/7. Индексация сайта - еще 16 способов, как ее ускорить

- •Часть VI/9. Robots.txt – правильный robots для WordPress, dle, joomla, smf

- •Часть VI/10. Влияет ли Sitemap на индексацию?

- •Глава VII. Продвижение в буржнете

- •Часть VII/1. Как вывести сайт в топ под англоязычный сегмент

- •Часть VII/2. Где брать ссылки для англоязычного сайта

- •Часть VII/3. Продвижение сайта в США

- •Часть VII/4. 7 мифов, которые нужно забыть при продвижении сайта в США под Google.com

- •Часть VII/5. Продвижение сайтов в США – выжимаем поисковой трафик

- •Часть VII/6. Продвижение англоязычного сайта - часть 1

- •Часть VII/7. Продвижение англоязычного сайта – часть 2

- •Часть VII/8. 42 бесплатных инструмента для подбора ключевых слов в буржнете

- •Глава VIII. Блоги, форумы, движки. Использование, оптимизация, раскрутка

- •Часть VIII/1. 5 серьезных признаков наличия ошибок настройки блога

- •Часть VIII/2. Как сделать блог-многотысячник

- •Часть VIII/3. Сладкий зефир — моя схема продвижения блога

- •Часть VIII/4. Сладкий зефир — схема продвижения блога! Часть 2

- •Часть VIII/5. Закрывать ли от индексации облако тегов?

- •Часть VIII/6. Как легко и быстро найти рекламодателя для блога

- •Часть VIII/7. Общение: блог или форум

- •Часть VIII/8. Особенности развития и продвижения форумов

- •Часть VIII/9. Как увеличить PR сайта - ищем dofollow блоги

- •Часть VIII/10. Куда добавить блог - мой список полезных ресурсов

- •Часть VIII/11. Использование блогуна для раскрутки сайтов

- •Часть VIII/12. Почему я покупаю верхние постовые?

- •Часть VIII/13. Как выбрать блоги для покупки постовых

- •Часть VIII/14. Платные посты в западных блогах

- •Часть VIII/15. Блог на поддомене или или в папке - как лучше?

- •Часть VIII/16. Лучшие плагины Wordpress - 103 плагина

- •Часть VIII/17. Внутренняя оптимизация WP

- •Часть VIII/18. Внутренняя поисковая оптимизация блога на WordPress, установка и настройка плагина All in One SEO Pack

- •Часть VIII/19. Внутренняя оптимизация uCoz

- •Часть VIII/20. SEO в phpBB3

- •Часть VIII/21. SMF: Удаляем мусорные слова

- •Часть VIII/22. SEO настройка joomla - соберем мозги в кучку

- •Часть VIII/23. Компоненты SEO для Joomla - отзывы и советы

- •Глава IX. Послесловие

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Часть VI/9. Robots.txt – правильный robots для WordPress, dle, joomla, smf

Автор: Денис Тумилович (CLASSIK)

Что такое robots

Давайте вместе разберемся что такое robots.txt. Пусть это не будет для вас сюрпризом – это файл!. Да, это просто текстовый файлик, в котором что-то написано. Надо только разобраться ЧТО. Дело в том, что на наш сайт с той или иной периодичностью заходят различные роботы. В одном из блогов мне понравилось разделение этих роботов на культурных и некультурных.

Некультурные роботы – это такие роботы, которые «тибрят» у вас ваш контент, занимаются спамом или сбором почт из комментариев, в общем всякая «шушара» и мусор, которые мешает жить честным личностям типа нас с вами.

Культурные же роботы – это в основном роботы поисковых систем, которые заходят на ваш сайт с целью узнать, а что же у вас обновилось и это что-то выдать в поисковую выдачу, если оно конечно того заслуживает. Так вот эти – культурные роботы – прежде чем начать вообще лазить по вашему сайту – заходят сначала в «предбанник» или можно сказать «прихожую» , которой и является файл robots.

В файле robots прописаны все инструкции, которым обязан следовать культурный робот. Если в файле robots написано нельзя – значит нельзя! Кстати, находится этот файл robots в корневой папке вашего сайта.

Итак, файл Robots.txt – это набор инструкций, которым обязан следовать поисковой робот! С помощью файла robots можно запратить или разрешить индексировать файлы и каталоги, определить главное зеркало домена и даже можно указать интервал между скачиваниями файлов с сайта с целью уменьшения нагрузки

История Robots

История файла начинается в 90х годах, когда активно начинал развиваться сам интернет. Начало появляться большое количество сайтов и поисковые роботы индексировали все подряд, тем самым нагружая сайты и затрудняя пользователям работу или серфинг. Поэтому нужно было создать какое-то решение, которое бы явно указывало поисковому роботу на страницы, которые необходимо индексировать, а какие не стоит. И в 1994 году было подписано соглашение администраторами

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 405 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

поисковиков, в результате которого появился файл robots.txt . Это конечно не отдельный сервис и не программа, на что все надеялись, но тоже неплохо выполняет поставленные задачи.

Как работает Robots.txt

Файл robots.txt должен находиться в корне вашего сайта и входя на сайт, робот любой поисковой системы в первую очередь обращается именно к этому файлу и получает набор инструкций, которые ему можно и нужно выполнить на этом сайте, а какие не стоит. Если у вас несколько поддоменов, то роботс должен находиться в корне каждого из поддоменов.

Вот как выглядит примерный Robots:

Примерный роботос выглядит так:

•User-agent: *

•Disallow: /tmp/

•Disallow: /cgi-bin/

Звездочка возле User-Agent говорит о том, что следующие инструкции предназначены для роботов любой поисковой системы. А дальше идет просто перечисление каталогов или файлов, которые не нужно индексировать. Все остальное индексироваться будет!

Собственно, вы уже наверное поняли, что параметр Disallow как раз и говорит о том чего «нельзя делать».

Можно запрещать индексировать не только каталоги, но и группы файлов или отдельные страницы вашего сайта.

Структура Robots.txt

Структура здесь небольшая. Сам файл состоит просто из списка инструкций. Каждая инструкция – это одна строка, в которой прописано одно правило.

Итак, каждый файлик роботс состоит из списка записей. Каждая запись – каждая строка – состоит из двух полей: директивы (приказа) и значение директивы. Между приказом и его значением всегда стоит символ

«:».

имя_поля:[необязательные пробелы]значение[необязательные пробелы]

Например User-Agent – это поле, которое обозначает идентификацию конкретного робота конкретного поисковика.

Если User-agent = “ * ” – это значит что следующие инструкции предназначены для всех поисковых роботов. Очень часто мы видим строки user-agent: yandex или user-agent: googlebot – эти строки означают что инструкции, которые перечисляются чуть ниже относятся именно к ботам яндекса или гугла соответственно.

Чуть ниже строки с идентификацией поискового робота идут директивы – приказы для робота, которые говорят индексировать или не индексировать конкретные страницы или папки. Например, поле Disallow говорит о том, что поисковой робот не должен индексировать те файлы или папки, которые стоят в значении этого поля, например

Disallow: /cgi-bin/

Или

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 406 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Disallow: /about.html

Директива Disallow работает методом подстановки, т.е. в нашем примере про папку cgi-bin запрещена к индексации именно папка, а также все её содержимое. Но если бы строка строилась так:

Disallow: /cgi-bin/

То в этом случае поисковой робот получил бы приказ к запрету индексации всех документов и папок, в пути которых встречается последовательность символов «cgi-bin», например /cgi-bin.html или /cgibin/index.html – все это было бы под запретом.

Что такое метод подстановки в Robots.txt

Метод подстановки в Robots – это когда в инструкции указано что-то вроде:

Disallow: file

Есть URL вида http://site.ru/catalog/file/file.html и Robots при выполнении этой инструкции начинает подставляет значение поля Disallow (т.е. «file») в этот URL, и там где есть совпадения – считает необходимым выполнить указание, т.е. в данном примере НЕ БУДУТ индексироваться

каталог - http://site.ru/catalog/file/

файл - http://site.ru/catalog/file/file.html

Комментарии в Robots

Да, в роботсе также можно держать комментарии, чтобы поставить комментарий, нужно использовать перед ним символ решетки «#».

Disallow: /cgi-bin/ #comment

Такой стиль , так скажем, не запрещен. Однако это считается плохим стилем, правильней было бы писать каждую директиву на отдельной строке, а комментарий к ней на отдельной.

ВАЖНО!

Под каждым user-agent должен быть хотя бы один Disallow

Как создать robots txt

Чтобы создать файл Robots.txt – нужно воспользоваться любым текстовым редактором (например, тем же Блокнотом), создайте файлик с именем «robots.txt» и заполните его в соответствии с правилами, о которых мы тут рассуждаем. Конечно, не стоит забывать, что после создания файла Robots.txt нужно его «залить» в корневую директорию вашего сайта.

Анализируем Robots.txt

Самое интересное – что есть автоматические анализаторы подобных файлов.

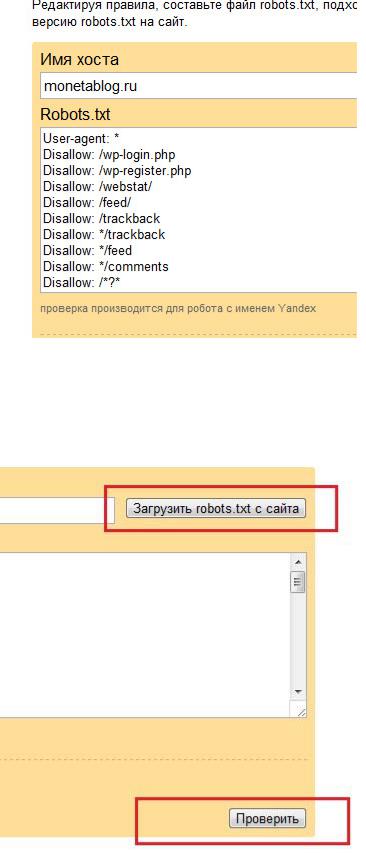

Вот например, Анализатор Яндекса.

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 407 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Здесь мы видим два поля: «Имя хоста» и «Robots.txt», мы можем заполнить любое, потому что и так и так, мы сможем выполнить наш анализ. Дело в том что в поле «Имя хоста» мы можем ввести URL нашего сайта и справа этой строчки мы видим кнопку «Загрузить Robots с сайта». Нажимая её, файл Robots.txt автоматически переноситься к поле «Robots.txt». И дальше уже можно будет анализировать.

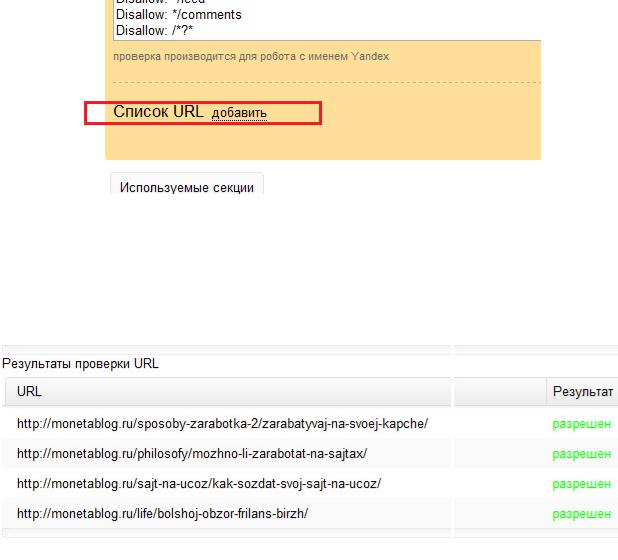

В окне, где появился файл Robots.txt , который находится у вас на сайте – вы можете редактировать этот файлик и проверять, правильно ли индексируется фаш сайт. Внизу окна анализа можно увидеть кнопку «Список URL». Давайте её нажмем. Откроется окно, куда можно вставить список ваших страниц, про индексацию которых вы беспокоитесь и нужно проверить, а Robots вообще позволяет поисковикам из индексировать?

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 408 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Я взял первые попавшиеся, наугад, страницы, которые были выделены на главной странице, и решил проверить их индексируемость, чтобы показать вам наглядно, как это может происходить. Итак, открыли мы это окошко и вбили туда списки наших урлов. Нажали уже показанную ранее кнопку «Проверить». И в самом низу нам показывается список страниц, которые проверены и их статус.

Статус может быть двух видов «Разрешен» или «Запрещен», в смысле к индексации.

Следует заметить, что файл robots.txt не является панацеей, так как его правила исключения используют только «культурные» роботы, а наряду с ними существует целый список роботов, сервисов и программ, которые не следуют правилам исключения, либо игнорируют существование файла robots.txt на сайте.

Кроме этого в файл исключений не стоит добавлять пути к файлам, о существовании которых не следует знать посторонним людям. Файл robots.txt доступен всем, поэтому присутствие там строк, вроде Disallow: /admin, только подзадорит некоторых посетителей к совершению вредоносных деяний.

1.В некоторых случаях используется динамическое формирование файла robots.txt, для сайтов с зеркалами.

2.Некоторые системы поддерживают дополнительные поля. Яндекс, например, использует поле Host для определения основного зеркала сайта.

3.Некоторые системы разрешают использование регулярных выражений. Так Гугл, который имеет поиск по изображениям, файлам PDF и другим, поддерживает в поле Disallow символы «*» (любая последовательность символов) и «$» (окончание строки ссылки). Это позволяет запретить индексирование определенного типа файлов:

User-agent: Googlebot Disallow: *.pdf$

#Запрет индексации файлов PDF

По мнению автора это избыточное расширение, так как с тем же успехом можно вынести все документы PDF в отдельный каталог и запретить его индексирование:

User-agent: * Disallow: /pdf/

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 409 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Директива Crawl-delay

Задает таймаут в секундах, с которым поисковый робот закачивает страницы с вашего сервера (Crawldelay).

Если сервер сильно нагружен и не успевает отрабатывать запросы на закачку, воспользуйтесь директивой «Crawl-delay». Она позволяет задать поисковому роботу минимальный период времени (в секундах) между концом закачки одной страницы и началом закачки следующей. В целях совместимости с роботами, которые не полностью следуют стандарту при обработке robots.txt, директиву «Crawl-delay» необходимо добавлять в группе, начинающейся с записи «User-Agent», непосредственно после директив

«Disallow» («Allow»).

Поисковый робот Яндекса поддерживает дробные значения Crawl-Delay, например, 0.5. Это не гарантирует, что поисковый робот будет заходить на ваш сайт каждые полсекунды, но дает роботу больше свободы и позволяет ускорить обход сайта.

Пример: User-agent: Yandex

Crawl-delay: 2 # задает таймаут в 2 секунды

User-agent: *

Disallow: /search

Crawl-delay: 4.5 # задает таймаут в 4.5 секунды

Директива Host для Яндекса

Внимание!

Эта директива используется только Яндексом

Если ваш сайт имеет зеркала, специальный робот, который специализируется на зеркалах определит их и сформирует группу зеркал вашего сайта. В поиске будет участвовать только главное зеркало. Вы можете указать его при помощи robots.txt, используя директиву ‘Host’, определив в качестве ее параметра имя главного зеркала. Директива ‘Host’ не гарантирует выбор указанного главного зеркала, тем не менее, алгоритм при принятии решения учитывает ее с высоким приоритетом.

Пример:

#Если www.glavnoye-zerkalo.ru главное зеркало сайта, то robots.txt для #www.neglavnoye-zerkalo.ru выглядит так

User-Agent: * Disallow: /forum Disallow: /cgi-bin

Host: www.glavnoye-zerkalo.ru

В целях совместимости с роботами, которые не полностью следуют стандарту при обработке robots.txt, директиву ‘Host’ необходимо добавлять в группе, начинающейся с записи ‘User-Agent’, непосредственно после директив ‘Disallow’(‘Allow’). Аргументом директивы ‘Host’ является доменное имя с номером порта (80 по умолчанию), отделенным двоеточием. Параметр директивы Host обязан состоять из одного корректного имени хоста (т.е. соответствующего RFC 952 и не являющегося IP-адресом) и допустимого номера порта. Некорректно составленные строчки ‘Host:’ игнорируются.

Недостатки файла robots.txt

Многие хакеры могут проникнуть на ваш сайт, изучив файл robots.txt, и просмотреть данные ограниченного доступа. При эффективном контроле безопасности содержащейся на вашем сайте информации какие-либо хакеры, конечно, не представляют для вас серьезной опасности.

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 410 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Например, если вы хотите запретить доступ к страницу с адресомwww.domain.com/stats/index.php, необходимо прописать в файле robots.txt следующую команду:

User-agent: *

Disallow: /stats/

Однако хакерам не трудно догадаться, как зайти на эту страницу – нужно просто ввести в адресной строке браузера URL www.domain.com/stats. От вас же в этом случае потребуется принятие следующих мер:

• Смените имя файла:

Поменяйте имя файла stats index.php на другое, например, stats-new.php. Тогда полный адрес страницы будет выглядеть следующим образом www.domain.com/stats/stats-new.php

Разместите по старому адресу страницы index.php простой текстовый файл, например, содержащий следующую информацию: «извините, но у вас нет прав для доступа к этой странице».

В этом случае хакерам будет трудно угадать имя файла и проникнуть на страницу ограниченного доступа.

• Установите пароль:

Защитите паролем информацию, прописанную в robots.txt файле.

Правильный Robots.txt для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Host: monetablog.ru

Sitemap: http://monetablog.ru/sitemap.xml.gz

Sitemap: http://monetablog.ru/sitemap.xml

Правильный Robots.txt для DLE

User-agent: Yandex

Disallow: /autobackup.php

Disallow: /user/

Disallow: /cache/

Disallow: /favorites/

Disallow: /cgi-bin/

Disallow: /engine/

Disallow: /language/

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 411 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Disallow: /backup/

Disallow: /rek/

Disallow: /languages/

Disallow: /index.php?do=pm

Disallow: /index.php?do=search

Disallow: /index.php?do=register

Disallow: /index.php?do=feedback

Disallow: /index.php?do=lostpassword

Disallow: /index.php?do=stats

Disallow: /index.php?do=addnews

Disallow: /index.php?subaction=newposts

Disallow: /?do=lastcomments

Disallow: /statistics.html

Sitemap: http://сайт.ru/sitemap.xml

Host: сайт.ru

Этот Robots справедлив когда вы ориентируетесь только на поисковую систему Яндекс. Если же вам интересны многие поисковые системы, то вам будет проще написать User-Agent: *

Правильный Robots.txt для Joomla

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /xmlrpc/

User-agent: Yandex

Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /media/ Disallow: /modules/ Disallow: /plugins/ Disallow: /templates/ Disallow: /tmp/ Disallow: /xmlrpc/

Host: vash_sait.ru

Sitemap: http://vash_sait.ru/index.php?option=com_xmap&sitemap=1&view=xml&no_html=1

Правильный Robots.txt для SMF форума

User-agent: *

Allow: /forum/*sitemap

Allow: /forum/*arcade # если не стоит мод игр, удалить без пропуска строки

Allow: /forum/*rss Allow: /forum/*type=rss

Disallow: /forum/attachments/ Disallow: /forum/avatars/ Disallow: /forum/Packages/ Disallow: /forum/Smileys/ Disallow: /forum/Sources/ Disallow: /forum/Themes/ Disallow: /forum/Games/

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 412 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава VI. Индексация сайта

Disallow: /forum/*.msg

Disallow: /forum/*.new

Disallow: /forum/*sort

Disallow: /forum/*topicseen

Disallow: /forum/*wap

Disallow: /forum/*imode

Disallow: /forum/*action

Disallow: /forum/*prev_next

Disallow: /forum/*all

Disallow: /forum/*go.php # либо тот редирект что стоит у вас

Host: www.мой сайт.ru # указать ваше главное зеркало

User-agent: Slurp

Crawl-delay: 100

Вэтом шаблоне, есть явное отличие от остальных – это наличие Slurp – это бот Yahoo , и он выполняет проверку в несколько потоков, что может негативно сказаться на производительности вашего форума. Чтобы этого не происходило – здесь включена директива задержки.

Впринципе, это все что нужно знать блоггеру или начинающему вебмастеру. Сложного вроде бы ничего нет, но пошевелить мозгами придется.

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 413 из 578 |

21.03.2013 |