- •Глава I. Введение

- •Часть I/1. Вступление

- •Часть I/2. Благодарности

- •Часть I/3. Предисловие

- •Часть I/4. Содержание

- •Глава II. Цифры, числа... Берем врага количеством

- •Часть II/1. 5 причин ставить внешние ссылки у себя на сайте

- •Часть II/2. 5 способов увеличить продажи при продвижении сайта

- •Часть II/3. 5 советов по созданию практичной 404-ой страницы

- •Часть II/4. 7 секретов успешного сайта

- •Часть II/5. 7 признаков покупных ссылок

- •Часть II/6. 7 спорных вопросов, возникающих при покупке ссылок

- •Часть II/7. 7 способов превратить Ваш сайт в Линкомагнит

- •Часть II/8. 9 экспертных SEO советов для маленького бизнеса

- •Часть II/9. 10 самых популярных SEO мифов

- •Часть II/10. 10 практических советов по обмену ссылками

- •Часть II/11. 10 правил внутренней перелинковки страниц

- •Часть II/12. 10 актуальных способов получить бесплатные ссылки на сайт

- •Часть II/13. 10 способов доказать ценность вашей SEO работы

- •Часть II/14. 10 заповедей SEO-оптимизатора

- •Часть II/15. 11 советов по составлению успешных URL адресов

- •Часть II/16. 13 факторов оценки конкуренции по запросу

- •Часть II/17. Как заставить ссылки работать? 15 принципов наращивания ссылок

- •Часть II/18. 15 советов по раскрутке сайта или блога

- •Часть II/19. 17 факторов которые учитывают поисковики при расчете веса ссылки

- •Часть II/20. 32 самых важных SEO подсказок

- •Часть II/21. 44 каталога статей

- •Часть II/22. Продвижение сайтов пресс-релизами и 53 каталога, куда их можно добавить

- •Часть II/23. 69 методов наращивания ссылочной массы прошедшего года

- •Часть II/24. 100 новых способов получения внешних ссылок

- •Часть II/25. 101 совет по покупке текстовых ссылок

- •Часть II/26. 149 англоязычных каталогов статей

- •Часть II/27. Как я увеличил посещаемость этого блога с 350 до 1000 человек

- •Часть II/28. Как из одной статьи сделать тысячи

- •Часть II/29. Как увеличить посещаемость с 0 до 3600 посетителей в сутки за 1 год

- •Часть II/30. Как получить 10000 ссылок за 3 недели

- •Глава III. Продвижение ссылками

- •Часть III/1. Искусство покупки ссылок

- •Часть III/2. Как правильно покупать ссылки на блог? Часть 1

- •Часть III/3. Как правильно покупать ссылки на блог? Часть2!

- •Часть III/4. Естественные и неестественные (SEO) ссылки

- •Часть III/5. Как влияют плохие ссылки на позиции сайта

- •Часть III/6. Как не купить ссылку с плохого сайта?

- •Часть III/7. Понимание методов выявления ссылочного спама

- •Часть III/8. Описание поискового спама

- •Часть III/9. Непот фильтр: особенности и методы определения

- •Часть III/10. Как создать ГС и попасть под АГС?

- •Часть III/11. За что я попал под фильтр АГС и как из него выйти?

- •Часть III/12. Что делать с сайтом под АГС?

- •Часть III/13. Как быстро Google снимает фильтры с сайта

- •Часть III/14. Как выйти из-под фильтров Google?

- •Часть III/15. Как вывести сайт из-под фильтра

- •Часть III/17. Обратные ссылки с профилей трастовых ресурсов за бесплатно

- •Часть III/18. Вечные ссылки, трафик, околоссылочный текст

- •Часть III/19. Околоссылочный текст и анкор-листы

- •Часть III/20. Как разместить бесплатную ссылку на сайт

- •Часть III/21. Вечные ссылки: что должен знать оптимизатор?

- •Часть III/22. Покупаем ссылки с минимальным риском и максимальной пользой

- •Часть III/23. Внешние ссылки из профилей

- •Часть III/24. Инструкция по покупке ссылок в подписях на форумах

- •Часть III/25. Google дает больший вес естественным ссылкам, располагающимся в тексте

- •Часть III/26. Как определить передает ли сайт вес ссылкам?

- •Часть III/27. Стоит ли обмениваться взаимными ссылками?

- •Часть III/28. Секрет ссылочного обмена, или почему обмен ссылками держит сайты в Топе

- •Часть III/29. Ссылки с футера все еще работают!!

- •Часть III/30. Внутренние ссылки: сколько ссылок слишком много?

- •Часть III/31. Вспоминаем главное свойство ссылок

- •Часть III/32. Вопрос Sevab - польза от nofollow ссылок

- •Часть III/33. Методы получения обратных ссылок на Интернет-магазин

- •Часть III/34. Плановая раскрутка интернет-магазина

- •Часть III/35. Ценность ссылок и разнообразие доменов

- •Часть III/36. Факторы, влияющие на работоспособность ссылок

- •Часть III/37. Как добыть ссылки в трудных нишах

- •Часть III/38. Разбавляем ссылки при продвижении сайта

- •Часть III/39. Естественные ссылки за деньги

- •Часть III/40. Покупка ссылок: классификация параметров для отсева

- •Часть III/41. Практические советы по наращиванию ссылочной массы

- •Часть III/42. 33 способа привлечения ссылок на сайт

- •Часть III/43. Есть ли разница между покупными и бесплатными ссылками?

- •Часть III/44. Как проверить наличие ссылок на сайт

- •Часть III/45. Почему все так боятся исходящих ссылок?

- •Часть III/46. Вред от исходящих ссылок

- •Глава IV. Грамотное составление анкоров ссылок

- •Часть IV/1. Распределение анкоров ссылочной массы

- •Часть IV/2. Составляем анкоры и описания для продвижения сайта

- •Часть IV/3. Анкор — что это такое и насколько важны анкор листы в продвижении сайта

- •Часть IV/4. Советы по грамотному составлению анкоров

- •Часть IV/5. Составляем анкоры ссылок – 5 ключевых моментов

- •Глава V. Сервисы по анализу и получению ссылок

- •Часть V/1. Лучшие SEO сервисы

- •Часть V/2. Биржи ссылок

- •Часть V/3. Обзор англоязычных бирж, где можно взять ссылки с разовой оплатой

- •Часть V/4. Купить трастовые ссылки теперь просто

- •Часть V/5. Cапа. Советы новичкам

- •Часть V/6. Сервисы покупки постовых и контекстных ссылок

- •Часть V/7. 30 полезных инструментов для SEO-аналитики

- •Часть V/8. Сервисы определения ссылочного бюджета

- •Глава VI. Индексация сайта

- •Часть VI/1. Среднее время индексации

- •Часть VI/2. Часто задаваемые вопросы по индексации страниц сайта

- •Часть VI/3. Nofollow и noindex или как закрыть от индексации ссылки и не потерять статический вес

- •Часть VI/4. 10 проверенных методов ускорить индексацию сайта

- •Часть VI/5. 15 советов по ускорению индексации сайта и блога!

- •Часть VI/6. Как ускорить индексацию сайта - 18 эффективных способов

- •Часть VI/7. Индексация сайта - еще 16 способов, как ее ускорить

- •Часть VI/9. Robots.txt – правильный robots для WordPress, dle, joomla, smf

- •Часть VI/10. Влияет ли Sitemap на индексацию?

- •Глава VII. Продвижение в буржнете

- •Часть VII/1. Как вывести сайт в топ под англоязычный сегмент

- •Часть VII/2. Где брать ссылки для англоязычного сайта

- •Часть VII/3. Продвижение сайта в США

- •Часть VII/4. 7 мифов, которые нужно забыть при продвижении сайта в США под Google.com

- •Часть VII/5. Продвижение сайтов в США – выжимаем поисковой трафик

- •Часть VII/6. Продвижение англоязычного сайта - часть 1

- •Часть VII/7. Продвижение англоязычного сайта – часть 2

- •Часть VII/8. 42 бесплатных инструмента для подбора ключевых слов в буржнете

- •Глава VIII. Блоги, форумы, движки. Использование, оптимизация, раскрутка

- •Часть VIII/1. 5 серьезных признаков наличия ошибок настройки блога

- •Часть VIII/2. Как сделать блог-многотысячник

- •Часть VIII/3. Сладкий зефир — моя схема продвижения блога

- •Часть VIII/4. Сладкий зефир — схема продвижения блога! Часть 2

- •Часть VIII/5. Закрывать ли от индексации облако тегов?

- •Часть VIII/6. Как легко и быстро найти рекламодателя для блога

- •Часть VIII/7. Общение: блог или форум

- •Часть VIII/8. Особенности развития и продвижения форумов

- •Часть VIII/9. Как увеличить PR сайта - ищем dofollow блоги

- •Часть VIII/10. Куда добавить блог - мой список полезных ресурсов

- •Часть VIII/11. Использование блогуна для раскрутки сайтов

- •Часть VIII/12. Почему я покупаю верхние постовые?

- •Часть VIII/13. Как выбрать блоги для покупки постовых

- •Часть VIII/14. Платные посты в западных блогах

- •Часть VIII/15. Блог на поддомене или или в папке - как лучше?

- •Часть VIII/16. Лучшие плагины Wordpress - 103 плагина

- •Часть VIII/17. Внутренняя оптимизация WP

- •Часть VIII/18. Внутренняя поисковая оптимизация блога на WordPress, установка и настройка плагина All in One SEO Pack

- •Часть VIII/19. Внутренняя оптимизация uCoz

- •Часть VIII/20. SEO в phpBB3

- •Часть VIII/21. SMF: Удаляем мусорные слова

- •Часть VIII/22. SEO настройка joomla - соберем мозги в кучку

- •Часть VIII/23. Компоненты SEO для Joomla - отзывы и советы

- •Глава IX. Послесловие

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава III. Продвижение ссылками

Часть III/40. Покупка ссылок: классификация параметров для отсева

Автор: Александр Люстик (MyOST)

Работа по покупке ссылок должна быть максимально автоматизирована, но для этого нужно провести большую подготовительную работу. Любой робот будет следовать вашим указаниям, но можно совершить ряд ошибок и испортить казалось бы конечную, отличную, идею.

Только кажется, что на бирже ссылок много ресурсов, на самом деле их нужно расходовать достаточно аккуратно. Поэтому вопрос о правильной классификации параметров для отсева ссылок встает довольно остро.

На самом деле, все фильтры, которые вы создаете – имеют довольно малую корреляцию с эффективностью, а если сказать точнее – то не выбор фильтра определяет его эффективность.

У меня в аккаунтах присутствует более 50 разных фильтров (если брать все аккаунты в сапе), включая клиентские, но при этом ни они определяют стратегию выбора донора.

Сайт с нулевыми показателями может сработать не хуже чем «с пузомерками», сайт не тематичный может сработать лучше, чем 100% верная тематика.

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 278 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава III. Продвижение ссылками

Если у вас нет большой выборки сайтов, по которой можно составить белые списки, то придется действовать немного иначе (кстати белые сайты часто становятся серыми и черными , их нужно проверять постоянно).

Основной упор – на формирование черных списков, для этого нужна четкая классификация параметров.

Я знаю достаточно людей, у которых за год-два работы черный список перевалил за 70 тысяч сайтов, при этом многие из них считают это абсолютно нормальным и они не заморачиваются с классификацией параметров.

Достаточно всего одного параметра для занесения площадки в черный список – это не правильный и не рациональный подход.

Чтобы собрать параметры для классификации – придется поработать руками и глазами, частично мозгом. А дальше все полученные результаты должны пойти в обработку автоматом, ведь автоматизация позволяет экономить кучу времени.

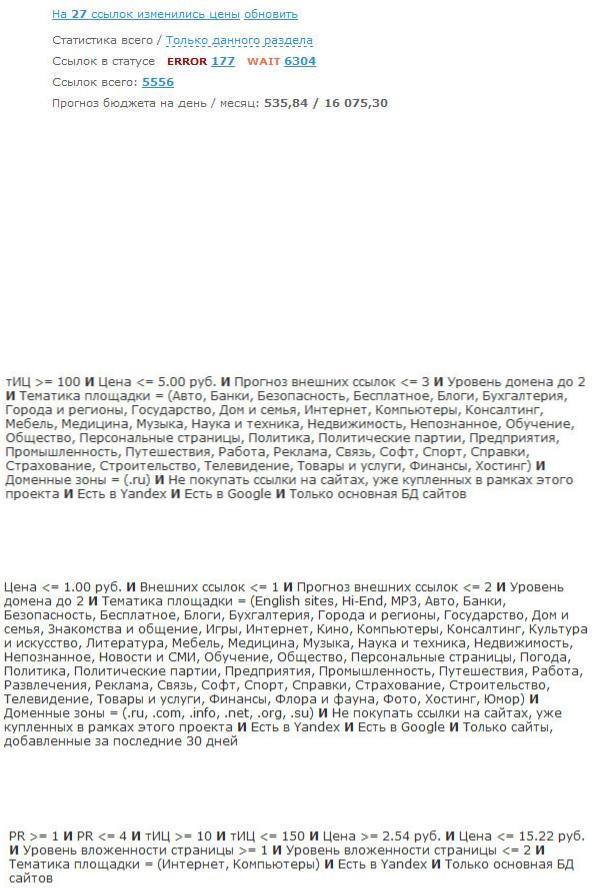

Методика отсева по плагину винка такова: LF, H, Cn, TF, ВС, УВ, YAP, YAC.

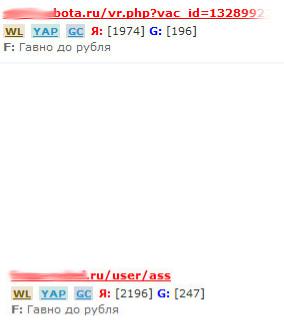

Первый барьер, который проходят сайты – это фильтр по URL (LF), которым мы пытаемся выявить заранее те сайты, которые имеют довольно большую вероятность к выпадению, а также не желательные страницы.

Как мы видим – у нас уже 2 классификатора:

•Вероятность бана/фильтра.

•Вероятность выпадения страницы.

Вероятность бана или фильтра могут иметь достаточное количество сайтов, например это может быть сайт-галерея, специально созданный под сапу, мы ввели параметры:

•Displayimage (галерея изображений)

•Thumbnails (галерея изображений)

•dn=photos (галерея изображений)

•.php?vac_id= (распарсенная база вакансий)

Отмечаем эти сайты и можем смело заносить их в глобальный черный список или черный список проекта.

Следующие параметры – не имеют четкой привязанности к характеристикам сайта, они имеют определенные характеристики страницы:

•User

•Tag

•Archive

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 279 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава III. Продвижение ссылками

Этими параметрами мы можем отсеивать системные страницы, которые могут быть в индексе, но будут рано или поздно выпадать, как содержащие дублированный контент, если это страницы тегов или архивов, либо системные страницы профилей юзеров, регистраций и прочего.

Этот классификатор не дает нам права метить площадку черным списком, ведь это не характеристики целого сайта, поэтому мы отменяем эти страницы, не добавляя их в черные списки, в следующий раз нам придут другие страниц этого сайта.

Надеюсь я доступно объяснил, что есть признаки сайта и страницы, их нужно четко различать, иначе будете "расходовать доноров" не правильно.

Второй барьер – количество страниц в индексе, здесь нужно быть аккуратным. Основная его цель – отсеять сайты попавшие под АГС, по количеству проиндексированных страниц.

Я бы советовал не ориентироваться на показатели SAPE и перед кнопкой Cn (по количеству страниц) нажать H (проверка количества проиндексированных страниц), что позволить получить реальные данные на нынешний момент. В результате мы получим именно сегодняшние данные и сможем нажать заветную кнопку Cn, которая отметит сайты достойные черного списка (допустим содержащие менее 15 страниц в индексе Яндекса).

Третий барьер – контент фильтр или TF. Частично методику я уже описывал, мы можем фильтровать достаточно доноров по разным параметрам. Допустим на сайте есть "porno" и мы его заметили. Если не углубляться в детали – этот параметр достоин черного списка.

Но не каждый сайт содержащий параметры, перечисленные ниже, достоин черного списка:

•Keygen

•IFolde

•RapidShare

•Megaupload

Здесь мы можем либо отменить и нам предложат новые страницы, либо добавить в черный список конкретного проекта (BL), т.к. глобального он может быть и не достоин. TF я касался уже, поэтому не будем затрагивать его детально, отвечу на вопросы в комментариях, если будут.

Четвертый барьер – это количество внешних ссылок, количество внутренних, а также количество контента на странице (ВС).

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 280 из 578 |

21.03.2013 |

«SEO: Поисковая Оптимизация от А до Я» - Средний уровень => Глава III. Продвижение ссылками

Здесь все просто – нужно четко понимать, что это характеристика страницы, а значит не подходит под глобальный черный список, лучше всего отменять и нам будет предложена новая страница.

При этом, если мы четко видим 500 внутренних ссылок на странице или больше, то здесь можно и в черный список добавить, перед этим просмотрев донора (часто мы можем встретить плагины пиксельной карты сайта и т.п. – их можно фильтровать TF фильтром), эту часть мы можем смело вносить в черный список, а значит у нас уже 2 классификатора. Но все-таки, я настаиваю на том, что нужно различать параметры страницы и параметры сайта.

Последний этап, который мы проходим – это уровень вложенности (УВ), а также наличие страницы в индексе (YAP) и в КЭШе (YAC) яндекса. Это тоже характеристики страницы, мы не имеем права добавлять такие сайты в черные списки, т.к. делаем выводы лишь по одной странице.

На сегодня мне пришло 5 тысяч 413 ссылок на подтверждение, результаты таковы:

LF для черного списка – 35 сайтов, LF для отмены – 1766 сайтов. H, Cn для отсева АГСных сайтов – 81.

TF для черного списка – 320 сайтов, TF для отмены – 840 сайтов. ВС для черного списка – 15 сайтов, ВС для отмены – 2140 сайтов. YAP и YAC для отмены – 230 сайтов.

В результате при сбалансированной работе у нас в черный список попал 361 сайт, а на отмену ушло

4076 сайтов. Значит из 5 тысяч 413 ссылок мы отсеяли 4976, оставив себе на рассмотрение более детальное 437 ссылок.

Если бы мы по-идиотски расходовали ссылочную массу и добавляли все в черные списки, без классификации факторов, то у нас получилось бы 4976 сайтов в черном списке только за 1 день.

По-моему – это не разумно, а я знаю многих людей, которые так делают, не разграничивая и не классифицируя параметры.

На сегодняшний день, в моем личном аккаунте, за несколько лет, накопилось всего 41 тысяча сайтов, которые отсеивались по очень жестким параметрам, если бы я огульно слал все в черный список, то было бы уже в раза 3-4 больше сайтов.

На аккаунтах заказчиков – меньше черные списки, но и работают они пока что меньше.

Скачать последнее издание этого учебника - http://www.seobuilding.ru/seo-a-z.php |

стр. 281 из 578 |

21.03.2013 |