- •Единицы измерения количества информации

- •Формула Хартли

- •Формула Шеннона

- •Алфавитный подход

- •Приближение равной вероятности символов в тексте

- •«Без труда не вытащишь рыбку из пруда.»

- •Приближение разной вероятности встречаемости символов в тексте

- •Частотный словарь русского языка – словарь вероятностей (частот) появления букв в произвольном тексте – приведен ниже. Определите, какое количество информации несет каждая буква этого словаря.

- •Содержательный подход

- •Неравновероятные события (вероятностный подход)

- •Пример 4. В корзине лежат 32 клубка шерсти, из них 4 красных. Сколько бит информации несет сообщение о том, что достали клубок красной шерсти?

- •Задачи для самостоятельного решения

Слово «информация» происходит от латинского словаinformation, что в переводе означает сведения, разъяснение, ознакомление.

Под «информацией» понимаются сведения (данные), которые воспринимаются живым существом или устройством и сообщаются (получаются, передаются, преобразуются, сжимаются, разжимаются, теряются, находятся, регистрируются) с помощью знаков.

Информация по-разному трактуется и изучается в различных областях знания.

Информация в кибернетике.В кибернетике (науке об управлении) понятие «информация» связано с процессами управления в сложных системах (живых организмах или технических устройствах). Жизнедеятельность любого организма или нормальное функционирование технического устройства зависит от процессов управления, благодаря которым поддерживаются в необходимых пределах значения их параметров. Процессы управления включают в себя получение, хранение, преобразование и передачу информации.

Виды информации(Босова Л. Л., 8 кл.)

визуальная(с помощью органов зрения мы воспринимаем буквы, цифры, рисунки, различаем цвет, форму, размеры и расположение предметов);

аудиальная (с помощью органов слуха воспринимается звуковая информация – речь, музыка, звуковые сигналы, шум);

обонятельная (с помощью органов обоняния люди получают информацию о запахах окружающего мира);

вкусовая(с помощью вкусовых рецепторов языка можно получить информацию о том, каков предмет – горький, кислый, сладкий, соленый);

тактильная(органы осязания (кончики пальцев и весь кожный покров) дают человеку информацию о температуре предмета, о качестве его поверхности).

Свойства информации (Босова Л. Л., 8 кл.)

Объективность – И не зависит от чьего-либо мнения, суждения. Объективную И можно получить с помощью исправных датчиков, измерительных приборов. Но, отражаясь в сознании конкретного человека, И перестает быть объективной.

Достоверность– И отражает истинное положение дел. Недостоверной информация может быть: в случае преднамеренного искажения; в результате воздействия помех; при преуменьшении или преувеличении значения реального факта.

Полнота– И достаточно для понимания ситуации и принятия решения.

Актуальность– И важна, существенная для настоящего времени. Только своевременно полученная информация может принести необходимую пользу.

Полезность– И оценивается по тем задачам, которые можно решить с ее помощью. Оценка полезности И всегда субъективна.

Понятность– И выражена на языке, доступном для получателя.

Процессы, связанные с изменением информации или действиями с использованием информации, называют информационными процессами. Выделяют следующие: процессы сбора, обработки, накопления, хранения, поиска и распространения информации.

Защита информации.В жизни человека информация играет очень важную роль. От нее зависит принятие решений, влияющих на развитие общества.

Для предотвращения потери информации разрабатываются различные механизмы ее защиты, которые используются на всех этапах работы с ней.

Для защиты информации используют различные способы защиты:

контроль доступа;

разграничение доступа;

дублирование каналов связи;

криптографическое преобразование информации с помощью шифров.

Количество информации как мера уменьшения неопределенности знания

Получение информации можно связать с уменьшением неопределенности знания. Это позволяет количественно измерять информацию, что чрезвычайно важно для информатики. Рассмотрим вопрос об определении количества информации более подробно на конкретных примерах.

Пусть у нас имеется монета, которую мы бросаем на ровную поверхность. С равной вероятностью произойдет оно из двух возможных событий –монета окажется в одном из двух положений: «орел» или «решка».

Можно говорить, что события равновероятны, если при возрастающем числе опытов количества выпадений «орла» и «решки» постепенно сближается. Например, если мы бросим монету 10 раз, то «орел» может выпасть 7 раз, а «решка» –3 раза, если бросим монету 100 раз, то «орел» может выпасть 60 раз, а «решка» –40 раз, если бросим монету 1000 раз, то «орел» может выпасть 520 раз, а «решка» –480 и т.д. В итоге при очень большой серии опытов количества выпадений «орла» и «решки» практически сравняются.

Перед броском существует неопределенность нашего знания (возможны два события), и как упадет монета, предсказать невозможно. После броска наступает полная определенность, так как мы видим (получаем зрительное сообщение), что монета в данный момент находится в определенном положении (например, «орел»). Это сообщение приводит к уменьшению неопределенности нашего знания в два раза, так как из двух возможных равновероятных событий реализовалось одно.

Чем больше количество возможных событий, тем больше начальная неопределенность нашего знания и соответственно тем больше количество информации будет содержать сообщение о результатах опыта.

Единицы измерения количества информации

За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность знания в два раза. Такая единица названа бит.

Минимальной единицей измерения информации является бит, а следующей по величине единицей – байт, причем

1 байт = 23 бит = 8 бит

Так кратные байту единицы измерения количества информации вводятся следующим образом:

1Кбайт = 210 байт = 1024 байт;

1Мбайт = 210 Кбайт = 1024 Кбайт;

1Гбайт = 210 Мбайт = 1024 Мбайт;

1Терабайт (Тб) = 210 Гбайт =1024 Гбайт;

1Петабайт (Пб) = 210 Тбайт = 1024 Тбайт.

Практическое задание (Босова Л. Л., 8 кл.)

Выразите объем информации в различных единицах, заполняя таблицу:

Бит

Байт

Кбайт

1

1536

16384

2560

215

23

Расположите величины в порядке убывания: 1024 бита, 1000 байтов, 8 бит, 1 байт, 10 Кбайт.

Расположите величины в порядке возрастания: 1010 байтов, 2 байта, 1 Кбайт, 20 битов, 10 битов.

Сколько Кбайт информации содержит сообщение следующего объема: 216 битов, 216 байтов, ¼ Мбайт, 1/512 Гбайт?

Информационный объем одного сообщения составляет 0,5 Кбайт, а другого – 500 байтов. На сколько битов информационный объем первого сообщения больше объема второго сообщения?

Информационный объем одного сообщения составляет 0,5 Кбайт, а другого – 128 битов. Во сколько раз информационный объем первого сообщения больше объема второго сообщения?

Заполните пропуски (степени двойки).

|

1 байт |

23 битов |

|

|

|

|

|

|

1 Кбайт |

2— битов |

210 байтов | ||||

|

1 Мбайт |

2— битов |

2— байтов |

210 Кбайт | |||

|

1 Гбайт |

2— битов |

2— байтов |

2— Кбайт |

210 Мбайт | ||

|

1 Тбайт |

2— битов |

2— байтов |

2— Кбайт |

2— Мбайт |

210 Гбайт | |

|

1 Пбайт |

2— битов |

2— байтов |

2— Кбайт |

2— Мбайт |

2— Гбайт |

210 Тбайт |

Найдите х.

а) 8х битов = 32 Кбайт; б)16х битов = 128 Кбайт.

Формула Хартли

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I = log2 N,

Где N- количество равновероятных событий; I - количество бит в сообщении, такое, что любое изNсобытий произошло. ТогдаN=2I.

Иногда формулу Хартли записывают так:

I=log2 N=log2 (1 / р) = -log2 р,

т. к. каждое из К событий имеет равновероятный исход р = 1 / N, то К = 1 / р.

Формула Шеннона

Существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например, если монета несимметричная (одна сторона тяжелее другой), то при ее бросании вероятности выпадения «орла» и «решки» будут различаться.

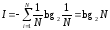

Формулу для вычисления количества информации для событий с различными вероятностями предложил К. Шеннон в 1948 году. В этом случае количество информации определяется по формуле:

,

,

где I - количество информации,

N – количество возможных событий,

pi – вероятности отдельных событий.

Для частного, но широко распространенного и рассматриваемого выше случая, когда события равновероятны (pi = 1/N), величину информации I можно рассчитать по формуле:

Практическое задание «Бросание пирамидки». Определить количество информации, которую мы получаем в результате бросания несимметричной и симметричной пирамидок.

При бросании несимметричной четырехгранной пирамидки вероятности отдельных событий равны: p1 =1/2, p2 = 1/4 , p3 = 1/8, p4 = 1/8.

Количество информации, которую мы получим после бросания несимметричной пирамидки, можно рассчитать по формуле :

I = - (1/2· log21/2 + 1/4·log21/4 + 1/8·log21/8 + 1/8·log21/8) бит = (1/2·log22 + 1/4·log24 + 1/8·log28 + 1/8·log28) бит = (1/2 + 2/4 + 3/8 +3/8) бит = 14,8 бит = 1,75 бит.

При бросании симметричной четырехгранной пирамидки вероятности отдельных событий равны между собой: p1 = p2 = p3 = p4 = 1/4.

Количество информации, которую мы получим после бросании симметричной пирамидки, можно рассчитать по формуле: I = log24 = 2 бита.

Таким образом, при бросании симметричной пирамидки, когда события равновероятны, мы получим большее количество информации (2 бита), чем при бросании несимметричной пирамидки, когда события неравновероятны (1,75 бита).

Выбор правильной стратегии в игре «угадай число». На получение максимального количества информации строится выбор правильной стратегии в игре «Угадай число», в которой первый участник загадывает целое число (например, 3) из заданного интервала (например, от 1 до 16), а второй должен «угадать» задуманное число. Если рассмотреть эту игру с информационной точки зрения, то начальная неопределенность знания для второго участника составляет 16 возможных событий (вариантов загаданных чисел).

При правильной стратегии интервал чисел всегда должен делиться пополам, тогда количество возможных событий (чисел) в каждом из полученных интервалов будет одинаково и их отгадывание равновероятно. В этом случае на каждом шаге ответ первого игрока («Да» или «Нет») будет нести максимальное количество информации (1 бит).

Как видно из таблицы, угадывание числа 3 произошло за четыре шага, на каждом из которых неопределенность знания второго участника уменьшалась в два раза за счет получения сообщения от первого участника, содержащего 1 бит информации. Таким образом, количество информации, необходимой для отгадывания одного из 16 чисел, составило 4 бита.

Информационная модель игры «Угадай число»

|

Вопрос второго участника |

Ответ первого участника |

Неопределенность знания (количество возможных событий) |

Полученное количество информации |

|

|

|

16 |

|

|

Число больше 8? |

Нет |

8 |

1 бит |

|

Число больше 4? |

Нет |

4 |

1 бит |

|

Число больше 2? |

Да |

2 |

1 бит |

|

Это число 3? |

Да |

1 |

1 бит |

Практическое задание «Определение количества информации».

В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика?

Так как количество шариков различных цветов неодинаково, то вероятности зрительных сообщений о цвете вынутого из мешочка шарика также различаются и равны количеству шариков данного цвета, деленному на общее количество шариков: pб = 0,1 ; pк = 0,2; pз =0,3; pс= 0,4

События неравновероятны,

поэтому для определения количества

информации, содержащейся в сообщении

о цвете шарика, воспользуемся формулой:

I = - (0, 1·log2 0, 1 + 0,2· log2 0,2 + 0,3· log20,3 + 0,4· log20,4) = 1,85 бита

Практическое задание «Определение количества информации в тексте». Система оптического распознавания символов позволяет преобразовать отсканированные изображения страниц документа в текстовой формат со скоростью 4 страницы в минуту и использует алфавит мощностью 65 536 символов. Какое количество информации будет нести текстовый документ, каждая страница которого содержит 40 строк по 50 символов, после 10 минут работы приложения?

По формуле: N = 2i определим информационную емкость символа алфавита: 65536 = 2i => 216 = 2i => I = 16 бит.

По формуле: Ic = I·К определим количество информации на странице: 16 бит·40·50 = 32000 бит = 4000 байт.

Определим количество

информации, которое будет нести текстовый

документ: 4000 байт·4·10

= 160000 байт.

156 Кбайт.

156 Кбайт.