Лекции / ЛЕКЦИЯ 3.doc Дискретный источник

..docЛЕКЦИЯ 3

ДИСКРЕТНЫЙ ИСТОЧНИК. ОСНОВНАЯ ТЕОРЕМА К. ШЕННОНА ДЛЯ ДИСКРЕТНОГО КАНАЛА БЕЗ ШУМА.

ЦЕЛЬ ЛЕКЦИИ: Дать определение и характеристику дискретного источника, определить энтропию источника, доказать, что при заданных ограничениях всегда можно сформировать последовательность символов, энтропия которой будет сколь угодно близка к энтропии источника, что, в свою очередь, позволяет при использовании статистического кодирования максимально использовать пропускную способность канала связи.

В предыдущей лекции было приведено определение источника сообщений как источника, который может в каждый момент времени с некоторой вероятностью принять одно из конечного множества возможных состояний. Источник, принимающий возможные вероятные состояния в дискретные моменты времени называется дискретным источником (ДИ). Характеристикой ДИ является отсутствие или наличие внутренней памяти. Рассмотрим эти два типа ДИ.

Дискретный источник называется источником Бернулли, если очередное сообщение (символ или последовательность) не зависит от всех предыдущих, иными словами все сообщения независимы и характеризуются только своими вероятностями. Примером процессов, порождаемых источником Бернулли являются, например, результаты бросания монеты или игрального кубика. Результаты бросания кубика - сигнал с равными вероятностями всех событий. Источник такого сигнала называют еще комбинаторным. Если же на кубик нанести числа 1, 2, 2, 3, 3, 3, то мы получим прекрасный источник разновероятных сообщений Бернулли. Если в ансамбле сообщений соблюдается одно из двух правил:

p(xi) ³ p(xj) для любого i > j или

p(xi) £ p(xj) для любого i < j,

то такой источник называется монотонным.

Дискретный источник Бернулли не обладает внутренней памятью.

Источник Маркова - более сложная модель. В ней предполагается, что вероятность появления очередного сигнала зависит от n предыдущих сигналов. Соответственно получается источник сигнала Маркова n-го порядка. Чем больше n, тем сложнее учет и оценка зависимостей, поэтому на практике ограничиваются значением n=1..2. Очевидно, что модель Бернулли-это модель Маркова при n=0.

Если для источника Бернулли необходимо знать только вероятности отдельных сообщений, то для источника Маркова необходимо получить условные вероятности в виде n+1-мерных матриц. Для Марковского источника первого порядка это будет двумерная матрица размера LxL, где каждый i-й столбец показывает вероятность перехода от сообщения xi к сообщению xj, например:

Таблица 1.

|

|

x1 |

... |

xi-1 |

xi |

xi+1 |

... |

xL |

|

x1 |

p1,1 |

... |

... |

p1,i |

... |

... |

p1,L |

|

... |

... |

... |

... |

... |

... |

... |

... |

|

xj-1 |

pj-1,1 |

... |

... |

pj-1,i |

... |

... |

pj-1,L |

|

xj |

pj,1 |

... |

... |

pj,i |

... |

... |

pj,L |

|

xj+1 |

pj+1,1 |

... |

... |

pj+1,i |

... |

... |

pj+1,L |

|

... |

... |

... |

... |

... |

... |

... |

... |

|

xL |

pL,1 |

... |

... |

pL,i |

... |

... |

pL,L |

(Сумма вероятностей любой строки или столбца должна равняться единице.)

Примером источника Маркова являются буквы русского (или, например, английского алфавита), поскольку появление в слове очередной буквы очень сильно зависит от предыдущих букв или даже слов.

Дискретный источник Маркова является источником с внутренней памятью. При дальнейшем обсуждении материалов данной части курса в качестве дискретного источника Маркова будет рассматриваться процесс с дискретным состоянием (возможные состояния процесса xi , xi+1… можно заранее определить и переход в состояние xj , xj+1 … происходит скачком) и непрерывным временем (моменты возможных переходов из состояния в состояние случайны). Для обсуждения материалов темы следует установить, что при каждом переходе от xi к х j создается один символ.

Энтропия дискретного источника независимых сообщений.

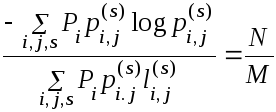

Рассмотрим ДИ с конечным числом состояний. Для каждого возможного состояния i имеется некоторое множество вероятностей pi(j) создания различных возможных символов j. Следовательно, для каждого состояния i существует энтропия Hi. Энтропия источника определяется как среднее значение величин Hi, которые осреднены в соответствии с вероятностями осуществления соответствующих событий

![]()

[1]

Выражение [1] определяет энтропию на символ текста. Если Марковский процесс развивается с определенной скоростью, можно говорить об энтропии в секунду

![]() ,

,

где fi – средняя частота (появлений в секунду) состояния i.

Если m – среднее число символов, создаваемых за одну секунду, то

H` = mH.

Величины Н или Н` измеряют количество информации, создаваемое источником, на символ или в секунду. При основании логарифмов 2 – количество битов (бит) на символ или в секунду.

Если символы в последовательности независимы,

![]()

где pi – вероятность символа i.

Рассмотрим длинное сообщение, состоящее из N символов. Оно будет с большой вероятностью содержать piN раз первый символ, pi+1N раз второй символ и т. д. Тогда вероятность данного конкретного сообщения будет приближенно равна

p =pi piN pi+1 pi+1N …pn pnN .

Прологарифмировав, получим

![]()

или log p = - NH.

Окончательно

[2]

[2]

Таким образом, энтропия Н длинной последовательности приближенно равна логарифму обратной величины вероятности типичной длинной последовательности, поделенному на число символов в последовательности. Этот вывод верен для любого источника.

ТЕОРЕМА 3. Для любых заданных ε>0 и δ>0 можно найти такое N0 , что последовательности любой длины N ≥ N0 распадаются на два класса:

-

множество последовательностей, суммарная вероятность которых меньше, чем ε;

-

остаток, все члены которого обладают вероятностями, удовлетворяющими неравенству

Последнее

выражение можно трактовать следующим

образом: почти достоверно, что

отношение![]() весьма

близко к Н, когда N

велико.

весьма

близко к Н, когда N

велико.

Доказательство.

Предположив источник эргодическим, можем применить закон больших чисел к заданной последовательности. Подобное допущение позволяет утверждать, что число непосредственных переходов из состояния i в состояние j в последовательности большой длины N приблизительно пропорционально вероятности нахождения в состоянии i , (обозначим как Pi), умноженной на вероятность перехода pi,j, т. е. определяется произведением Pi p i,jN. Если N достаточно велико, то вероятность ошибки, не превосходящей δ, будет в этом случае меньше, чем έ, так что все числа, кроме множества малой вероятности, заключены в пределах (Pi p i,j ±δ)N (для удобства написания обозначим данное произведение буквой v)

Следовательно, все последовательности, за исключением сколь угодно малой доли, имеют вероятность p:

p = Πpijv

и имеет место

соотношение![]()

или![]() Что

и требовалось доказать.

Что

и требовалось доказать.

Рассмотрим ряд последовательностей длины N, имеющих определенные суммарные вероятности. Расположим их в ряд в порядке уменьшения вероятностей. Введем величину n(q) – число последовательностей, которые необходимо взять из ряда, начиная с наиболее вероятной последовательности, для того чтобы для взятых последовательностей накопилась суммарная вероятность q.

ТЕОРЕМА 4. Когда q не равно нулю или единице,

![]() [3]

[3]

Mожно интерпретировать величину log n(q) как число бит, требуемых для задания последовательности, когда рассматриваются только наиболее вероятные последовательности с суммарной вероятностью q. Тогда

есть число бит на символ, необходимых для задания последовательностей. Теорема свидетельствует, что для больших N это число не зависит от q и равно H. Быстрота возрастания логарифма числа сравнительно вероятных последовательностей определяется величиной H независимо от толкования смысла слов “сравнительно вероятный”. Выводы показывают, что в большинстве случаев длинные последовательности можно рассматривать так, как если бы их было 2HN, и каждая имела вероятность 2 -HN. Величины H и H’ могут быть найдены с помощью предельных операций непосредственно из статистической структуры последовательности сообщений без привлечения вероятностей состояний и переходных вероятностей.

ТЕОРЕМА 5. Пусть p(Bi) – вероятность того, что источник создает последовательность символов Bi. Пусть

GN

= - 1/N

![]() p(Bi)

log (Bi),

p(Bi)

log (Bi),

где суммирование распространяется на все последовательности B, содержащие N символов. Тогда G – монотонно убывающая функция от N и

lim

GN

= H

при N![]()

ТЕОРЕМА 6. Пусть p(Bi, Sj) – вероятность того, что появится последовательность Bi и после нее появится символ Sj, а

pBi (Sj) = p(Bi, Sj)/ p (Bi)

условная вероятность того, что после Bi появится Sj. Пусть

![]()

где суммирование проводится по всем возможным последовательностям Bi из (N – 1) символов и по всем символам Sj. Тогда FN – монотонно убывающая функция от N

FN = NGN – (N – 1)GN - 1

FN

![]() GN

и,

следовательно,

GN

и,

следовательно,

lim FN = H.

N→∞

Доказательство.

Если вероятность перехода из состояния с N – 1 буквой в состояние с N буквами определяется выражением p Bi (S j) = p(B i, S j) / p(B i), то , подставив его в выражение для FN, получим

![]() С учетом свойства

N

– грамм второе слагаемое можно представить

в виде

С учетом свойства

N

– грамм второе слагаемое можно представить

в виде

![]()

Таким образом, FN = NHN – (N-1)HN --1

Далее выпишем все последовательности Вi , начиная с первой

F1 = H1

F2 =2H2 – H1

F3 = 3H3 – 2H2

…

FN = NHN – (N – 1)HN--1

Просуммировав равенства, получим

![]()

Так как FN ≤ FN-1, то FN ≤ HN ≤ H . Последнее означает, что с учетом вероятностей переходов Марковская модель источника дает лучшее приближение к истинной энтропии H, чем модель источника на основе N – грамм.

![]()

Что и требовалось доказать.

Отметим, что рассмотренные теоремы показывают, какой ряд приближений к H может быть получен с помощью рассмотрения только статистической структуры последовательностей, охватывающей 1, 2, …, N символов. FN является лучшим приближением. Фактически FN является энтропией N – го приближения к источнику рассмотренного нами типа. Если нет никаких статистических связей, распространяющихся более чем на N символов, т.е., если условная вероятность появления следующего символа при условии, что значения предшествовавших (N – 1) символов известны, не изменяется от добавления сведений о любых ранее стоящих символах, то тогда FN = H F. является условной энтропией следующего символа, когда известны (N – 1) предыдущих. В то же время GN – есть энтропия на символ последовательности из N символов.

Отношение энтропии источника к максимальному значению, которого могла бы достичь энтропия при тех же символах, назовем относительной энтропией источника.

Относительная энтропия является МАКСИМАЛЬНЫМ СЖАТИЕМ, которое можно осуществить кодированием при помощи того же самого алфавита.

Единица минус относительная энтропия есть ИЗБЫТОЧНОСТЬ. Исследованиями показано, что избыточность английского текста, если не рассматривать статистическую структуру, относящуюся более чем к восьми буквам, составляет примерно 50 %. Это значит, когда англичане пишут текст, половина знаков текста определяется структурой языка, и только половина выбирается свободно.

Представление операций кодирования и декодирования.

Мы рассмотрели энтропию источника для случаев длинных последовательностей, установив, что логарифм обратной величины вероятности, поделенный на число символов последовательности, сколь угодно близок к величине энтропии источника. Реальный источник накладывает ограничения, выражающиеся в том, что последовательности ограничены по длине. Представим математические операции, выполняемые передатчиком телекоммуникационной системы при кодировании. Назовем передатчик дискретным преобразователем. На вход преобразователя поступает последовательность входных символов, а на выходе получается последовательность выходных символов. Поскольку преобразователь может обладать внутренней памятью, отметим, что выходной символ зависит не только от данного входного символа, но и от всех предыдущих. Предположим, что внутренняя память конечна, т. е. существует конечное число m возможных состояний преобразователя и при этом очередной выходной символ является функцией от соответствующего входного символа и от состояния, в котором находится преобразователь. Следующее состояние преобразователя будет другой функцией от этих же аргументов. Таким образом, преобразователь может быть описан двумя функциями:

y = f(xn, an)

an+1 = g(xn, an),

где xn – n-й входной символ,

an – cсостояние преобразователя к моменту ввода n-го входного символа,

yn – выходной символ (или группа выходных символов), создаваемый, когда на вход поступает x и преобразователь находится в состоянии an.

Если выходные символы одного преобразователя могут служить входными символами для другого, то преобразователи могут быть соединены последовательно. В результате также получится некоторый преобразователь. Если существует второй преобразователь, который при соединении его входа с выходом первого восстанавливает исходный сигнал, то первый преобразователь называется невырожденным, а второй - обратным к первому.

ТЕОРЕМА 7. Выход преобразователя с конечным числом состояний, подключенный к статистическому источнику с конечным числом состояний, представляет собой статистический источник с конечным числом состояний, причем энтропия этого источника (в единицу времени) меньше или равна энтропии источника на входе. Если преобразователь невырожденный, то энтропии равны.

Пусть ά представляет собой состояние источника, который создает последовательность символов x, и пусть β – состояние преобразователя, который создает на выходе блоки символов y. Система, полученная в результате соединения источника с преобразователем, может быть представлена с помощью произведения “пространств состояний”, состоящего из пар (ά, β). Переход из точки (ά1, β1) этого пространства в точку (ά2,β2) соответствует созданию источником такого символа x, который изменит состояние преобразователя β1 на β2. При этом преобразователем создается блок символов yi. Энтропия источника на выходе может быть вычислена как взвешенная сумма по всем состояниям. Если мы просуммируем сначала по β, то каждый получающийся в результате член будет не больше соответствующего члена для ά и, следовательно, энтропия не увеличивается. Для преобразователя на передающей стороне H1 = H2..

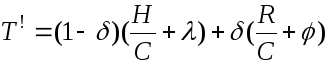

ТЕОРЕМА 8. Пусть система ограничений, рассматриваемая как канал, имеет пропускную способность C = logW. Если положить

где

![]() - длительность s

– го символа, ведущего от состояния i

к состоянию j,

а Bi

удовлетворяет

условию

- длительность s

– го символа, ведущего от состояния i

к состоянию j,

а Bi

удовлетворяет

условию

то энтропия Н максимальна и равна С.

Доказательство.

Допустим, что в канал поступают последовательности символов, на которые наложен ряд ограничений, задающих систему с конечным числом состояний, описываемую Марковским процессом. Пусть li,j(s) есть длительности различных символов, которые могут появиться при переходе из состояния хi в состояние xj (см. табл.1).Каково распределение вероятностей для различных состояний Pi и вероятностей рi,j(s) выбора символов s при переходе из состояния xi в состояние х j., для которого максимизируется скорость создания информации при данных ограничениях? Эти ограничения определяют дискретный канал, а максимальная скорость должна быть меньше или равна пропускной способности С этого канала. Действительно, если все группы большой длительности были бы равновероятны, то в результате получилась бы именно эта скорость, и, если это возможно, такая скорость была бы наилучшей. Покажем, что эта скорость может быть достигнута при надлежащем выборе Pi и Р ijs

Рассматриваемая скорость равна

Пусть по предположению

где Вi удовлетворяет системе уравнений

Эта однородная система имеет ненулевое решение, так как W обращает в нуль детерминант из коэффициентов

Определенные таким образом вероятности pi,j(s) могут служить переходными вероятностями, так как сумма вероятностей выхода из любой фиксированной узловой точки равна 1, что подтверждается следующими преобразованиями

Эти вероятности неотрицательны. Подставляя значения pi,j(s) в общее выражение для скорости, получим

Следовательно, скорость, достигаемая для этого набора вероятностей перехода, равна С, и так как эта скорость не может быть превышена, то она максимальна.

Основная теорема для канала без шума.

Выше мы определили величину Н как скорость создания информации источником. Подтвердим это определение доказательством того, что энтропия источника определяет пропускную способность канала, необходимую при наиболее эффективном кодировании.

ТЕОРЕМА 9. Пусть источник имеет энтропию Н (бит на символ), а канал имеет пропускную способность С (бит в секунду). Тогда можно закодировать сообщения на выходе источника таким образом, чтобы передавать символы по каналу со средней скоростью С / Н – ε символов в одну секунду, где ε – сколь угодно мало. Передавать со средней скоростью, большей, чем С/Н, невозможно.

Доказательство.

Заменим выражение r = (С/H – ε) симв./с на выражение R = rH = C – ξ бит/ с, а выражение r > C/H симв./с на выражение R = rH > C бит/с. Тогда R = rH бит/с – производительность источника, чтд.

Рассмотрим множество всех последовательностей из N символов, создаваемых источником. Применим для доказательства теорему об ε – энтропии. При большом N все последовательности можно разделить на две группы: одна из групп содержит меньше 2(H+η)N членов; другая содержит меньше чем 2RN членов (где R – логарифм числа различных символов) и имеет суммарную вероятность, меньшую μ. С ростом N величины η и μ стремятся к нулю. Число сигналов в канале, имеющих длительность Т, больше 2(С-θ)Т , где θ мало, когда Т велико. Выберем длительность сигнала из условия

Тогда найдется достаточное число последовательностей символов в канале для высоко вероятностной группы, когда N и T достаточно велики (сколь бы малым ни было выбрано λ), и несколько добавочных последовательностей. Высоковероятная группа произвольным, взаимнооднозначным образом кодируется в это множество последовательностей символов канала. Остающиеся последовательности источника кодируются в более длинные последовательности канала, начинающиеся и заканчивающиеся одной из добавочных последовательностей, не использованных для высоковероятной группы, причем эта последовательность действует как начальный и конечный сигналы, указывающие на использование в промежутке иного кода. Между этими сигналами оставляют временной интервал, достаточный для того, чтобы для этого временного интервала в канале существовало достаточно различных последовательностей для всех маловероятных сообщений. Условие для выбора данного интервала запишем следующим образом

![]()

φ – сколь угодно малая величина.

Тогда среднее время передачи символов сообщения в секунду Т‘ должно быть не меньше суммы

Т` = Т + Тi

В соответствии с теоремой об ε – энтропии имеем

Подставив значения Т и Тi , получим

При увеличении N величины δ , λ и φ стремятся к нулю и скорость передачи символов сообщения в секунду 1/Т` стремится к величине отношения С/Н.