Устранение автокорреляции случайных составляющих.

Что можно сделать в отношении автокорреляции?

Во-первых, определить фактор, ответственный за автокорреляцию, и включить его в уравнение регрессии или изменить форму связи.

Во-вторых, построить уравнение регрессии не для исходных переменных y и x, а для их конечных разностей 1-го порядка Δyt=yt-yt-1 и Δxt=xt-xt-1.

В-третьих, в случае автокорреляции, подчиненной авторегрессионному процессу 1-ого порядка (т.е. ut=·ut-1+t , t=1;n), мы могли бы полностью устранить автокорреляцию, если бы знали величину .

Предположим, что истинная модель задается выражением:

yt= b0 + b1·xt+ut (*) (t=1;n).

Тогда наблюдение (t-1) формируется как: yt-1=b0+ b1·xt-1 +ut-1.

Умножим полученное выражение на и вычтем его из обеих частей уравнения (*). В результате получим:

yt-·yt-1=(1-)b0+b1(xt-xt-1)+ut-·ut-1.(**)

y*t = b*0 +b1· x*t + t

Обозначим y*t=yt-·yt-1 ; x*t=xt-·xt-1, b*0=(1-)b0, t= ut-ut-1 (t=2;n).

Значения

t

(случайной составляющей в модели

зависимости ut

от ut-1)

для различных t

не зависят друг от друга, поэтому проблемы

автокорреляции остатков в полученном

уравнении для преобразованных переменных

нет. Параметры данного уравнения

оцениваются обычным МНК. Получаем

оцененную регрессию: y*’t=

![]() *+

*+

![]() ·x*t.

·x*t.

Затем

определяем оценку

![]() =

=![]() */(1-

)

и окончательно оцененное исходное

уравнение регрессии: y’t=

*/(1-

)

и окончательно оцененное исходное

уравнение регрессии: y’t=![]() +

+![]() ·xt.

·xt.

Однако,

если в выборке нет данных предшествующих

1-ому наблюдению, мы не можем вычислить

значения y*1,

x*1.

Уменьшение числа степеней свободы на

единицу приведет к потере эффективности,

которая может в небольших выборках

перевесить повышение эффективности от

устранения автокорреляции. Эту проблему

решают с помощью поправки Прайса-Уинстена:

y*1=![]() ·y1,

x*1=

·y1,

x*1=![]() ·x1.

·x1.

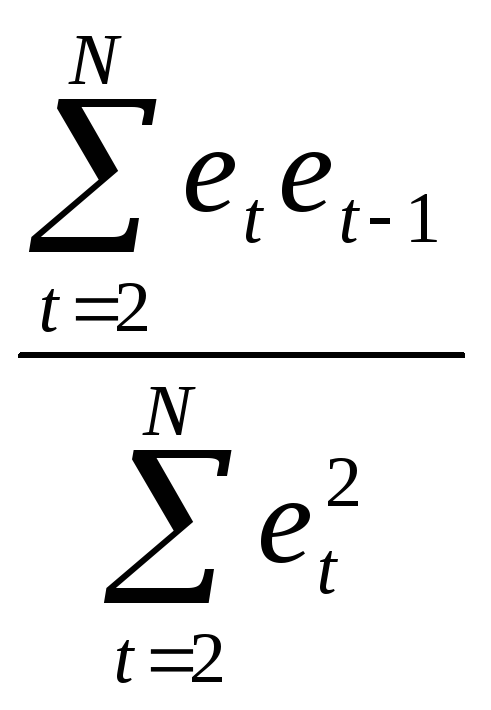

На практике величина конечно неизвестна, его оценка получается одновременно с оценками параметров b0 и b1. В качестве оценки обычно используют выборочный коэффициент автокорреляции остатков 1-ого порядка ret,et-1: = ret,et-1.

(ret,et-1= ,et=yt-(

,et=yt-(![]() +

+![]() xt),где

xt),где

![]() ,

,![]() –МНК-оценки

параметровb0,

b1).

–МНК-оценки

параметровb0,

b1).

Другой способ оценки используется в методе Кохрейна-Оркатта. Алгоритм метода Кохрейна-Оркатта носит итеративный характер:

1)

обычным МНК оценивается регрессия

y(1)’t=![]() (1)+

(1)+![]() (1)·xt

(*);

(1)·xt

(*);

2) вычисляются остатки et(1)=yt - y(1)’t (t=1;n);

3) оценивается регрессионная зависимость e(k)t от e(k)t-1: e’(k)t=*(k)·e(k)t-1, коэффициент при e(k)t-1 равный (k)* представляет собой оценку , k –номер итерации;

4) с этой оценкой ((k)*) уравнение (*) преобразуется к виду:

y*(k)t= b*(k)0+ b1·x*(k)t+u*(k)t (**),

где y*(k)t=yt-*(k)·yt-1; b*(k)0=(1-*(k))b0; х*(k)t=хt-*(k)·хt-1; u*(k)t=ut- *(k)·ut-1.

5)

обычным МНК оценивается уравнения (**):

y*(k)’t=

![]() *(k)

+

*(k)

+![]() (k)·x*(k)t.

Затем вычисляют оценку параметра

(k)·x*(k)t.

Затем вычисляют оценку параметра

![]() (k)

=

(k)

=![]() *(k)/(1-*(k)).

*(k)/(1-*(k)).

6) повторно вычисляются остатки et и процесс возвращается к этапу 3.

Процесс обычно заканчивается, когда очередное приближение *(k) мало отличается от предыдущего *(k-1). Иногда просто фиксируется количество итераций.

Еще один способ оценки - метод Хилдрета-Лу:

Для каждого значения из определенного диапазона с заданным шагом внутри (например, =-1; 1; 0,01) его оценивается преобразованное уравнение регрессии:

y*t= b0*+ b1·x*t+u*t (**),

где y*t=yt-*·yt-1; b*0=(1-*)b0; х*t=хt-*·хt-1; u*t=ut- *·ut-1.

Значение

,

которое дает минимальную сумму квадратов

отклонений для преобразованного

уравнения (**), принимается в качестве

оценки .

Оценка параметра исходного уравнения

регрессии (*) :

![]() =

=![]() */(1-*).

*/(1-*).

Обобщенный метод наименьших квадратов- ОМНК (GLS).

Обобщенный метод наименьших квадратов (ОМНК) применяется в том случае, если нарушена третья, либо четвертая предпосылки нормальной линейной регрессионной модели, т.е. если случайные составляющие не имеют постоянной дисперсии или коррелированы между собой. Это характерно для неоднородной совокупности, состоящей из сильно отличающихся друг от друга единиц.

В этом случае имеет место обобщенная линейная модель множественной регрессии, которая в матричной форме выглядит так:

Y=X·b+U

X - неслучайная матрица, имеющая полный ранг, т.е. х1, х2, …, хm – неслучайные переменные.

M(U)=0n

СU=u2C0, где C0 – некоторая заранее известная матрица.

Основное отличие обобщенной регрессионной модели от нормальной состоит в виде матрицы ковариации случайных составляющих – СU. В нормальной модели предполагается, что матрица С0 равна единичной матрице. В обобщенной модели допускается, что ковариации (следовательно, дисперсии и корреляции) остатков могут быть произвольными, следовательно, и матрица С0 может содержать произвольные значения. В этом – суть обобщения нормальной модели.

Применение традиционного (обычного) МНК к обобщенной регрессионной модели дает состоятельные и несмещенные оценки. Однако данные оценки становятся неэффективными. Поэтому для оценивания параметров обобщенной модели пользуются обобщенным МНК. При этом вектор оценок параметров модели определяется по формуле:

![]() =(XT·C0-1·X)-1

XT

·C0-1·Y

(*).

=(XT·C0-1·X)-1

XT

·C0-1·Y

(*).

Следует отметить, что для обобщенной регрессионной модели, в отличие от нормальной, коэффициент детерминации R2 не может служить удовлетворительной мерой качества модели. Он даже не обязан лежать в интервале от 0 до 1, а добавление или удаление независимой переменной не обязательно приводит к его увеличению или уменьшению.

Проверка гипотез о значимости коэффициентов регрессии проводится также как и в случае нормальной линейной модели.

Ковариационная

матрица МНК-оценок параметров регрессии

(которая используется для определения

дисперсий и стандартных ошибок оценок

параметров) будет рассчитываться как:

![]() =σu2(XT·C0-1·X)-1.

=σu2(XT·C0-1·X)-1.

В отличие от нормальной модели в рамках обобщенной модели регрессии σu2 уже нельзя интерпретировать как величину дисперсии случайной составляющей. Однако для получения ковариационной матрицы МНК-оценок его нужно оценить. Для его оценки используют следующую формулу:

![]() .

.

Для применения ОМНК необходимо знать матрицу СU, что на практике бывает редко. Рекомендуется оценить каким-либо образом матрицу СU, а затем использовать эту оценку в формуле (*) вместо СU. Для этого вводят априорные ограничения на структуру матрицы СU. Данный подход составляет суть так называемого доступного обобщенного метода наименьших квадратов (FGLS) и используется при оценивании параметров в модели с гетероскедастичностью, а также в случае автокорреляции случайных составляющих.

Рассмотрим ковариационную матрицу случайных составляющих в случае их гетероскедастичности и взаимной независимости. Если предположить, что ui приблизительно пропорциональна хi, т.е. xi=·ui, то ковариационная матрица может быть представлена в виде:

Сu=

=

= .

.

Рассмотрим ковариационную матрицу случайных составляющих в случае их автокорреляции. При сохранении свойства гомоскедастичности и в предположении, что случайные составляющие связаны автокорреляционной зависимостью 1-ого порядка: ut=·ut-1+t, ковариационная матрица может быть представлена в виде:

Сu= .

.

Напомним,

что

![]() .

.