Численные методы (Шапошникова Д.А.) / Лекции / Лекция_15-16_ИЭТ 2011

.docМетоды

вычислений. ИЭТ. 4-й семестр. Лекция 15

Стр.

МЕТОДЫ ВЫЧИСЛЕНИЙ

ИЭТ, 4-й семестр, 22

Лекция 15

Методы многомерной оптимизации. Покоординатный спуск, градиентные методы

Основные понятия

и обозначения. Простановка задачи.

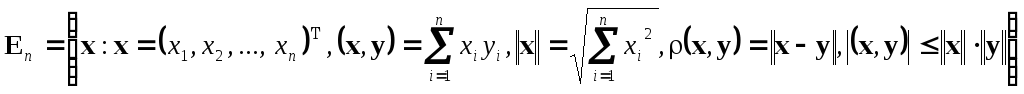

Пусть

![]() — действительная функция многих

переменных, определенная в n-мерном

евклидовом пространстве

— действительная функция многих

переменных, определенная в n-мерном

евклидовом пространстве

![]() :

:

.

Точка

.

Точка

![]() называется точкой

глобального минимума функции

называется точкой

глобального минимума функции

![]() ,

если

,

если

![]() для всех

для всех

![]() .

В этом случае

.

В этом случае

![]() — минимальное значение функции. Точка

— минимальное значение функции. Точка

![]() называется точкой

локального минимума функции

называется точкой

локального минимума функции

![]() ,

если существует такая окрестность

,

если существует такая окрестность

![]() этой точки, что неравенство

этой точки, что неравенство

![]() справедливо для всех

справедливо для всех

![]() .

.

Поверхностями

(линиями) уровня гладкой

функции нескольких переменных называются

поверхности (линии) заданные уравнением

![]() .

.

Обозначим

![]() — дифференциал аргумента,

— дифференциал аргумента,

![]() — градиент функции

— градиент функции

![]() ,

градиент функции в малой окрестности

точки указывает направление наискорейшего

возрастания функции, он ортогонален

линии уровня

,

градиент функции в малой окрестности

точки указывает направление наискорейшего

возрастания функции, он ортогонален

линии уровня

![]() ,

проходящей через точку

,

проходящей через точку

![]() ;

первый дифференциал функции

;

первый дифференциал функции

![]() с помощью градиента можно записать в

виде:

с помощью градиента можно записать в

виде:

![]() ;

а второй дифференциал функции

;

а второй дифференциал функции

![]() можно записать в виде

можно записать в виде

![]() ,

где

,

где

![]() — матрица Гессе:

— матрица Гессе:

.

.

Задачу безусловной

минимизации

функции нескольких переменных будем

записывать следующим образом:

![]() .

Здесь

.

Здесь

![]() — целевая

функция.

— целевая

функция.

Задачу безусловной минимизации функции нескольких переменных называют еще общей задачей нелинейного программирования без ограничений.

Классическое решение задачи минимизации

Приращение дважды

непрерывно дифференцируемой функции

![]() в окрестности минимума можно записать

в виде:

в окрестности минимума можно записать

в виде:

![]() ,

,

![]() .

.

Необходимое условие экстремума дифференцируемой функции нескольких переменных:

![]() ,

— стационарная точка. При этом в

окрестности точки

,

— стационарная точка. При этом в

окрестности точки

![]() :

:

![]() .

.

Достаточное

условие

экстремума (минимума) дважды дифференцируемой

функции нескольких переменных:

![]() и

и

![]() .

.

Условие

![]() выполняется тогда и только тогда, когда

матрица Гессе (гессиан) — положительно

определенная матрица.

выполняется тогда и только тогда, когда

матрица Гессе (гессиан) — положительно

определенная матрица.

Напомним, матрица

![]() называется положительно определенной,

если для любого вектора

называется положительно определенной,

если для любого вектора

![]() справедливо

справедливо

![]() .

.

Необходимое и достаточное условия минимума дважды дифференцируемой функции нескольких переменных лежат в основе классического метода отыскания минимума:

Находим все решения

нелинейной системы уравнений

![]() ,

затем среди них выбираем те, для которых

,

затем среди них выбираем те, для которых

![]() (матрица Гессе положительно определена),

а среди этих точек выбираем ту, в которой

значение функции наименьшее.

(матрица Гессе положительно определена),

а среди этих точек выбираем ту, в которой

значение функции наименьшее.

Поскольку в

окрестности точки минимума приращение

функции

![]() ,

т.е. график функции в окрестности минимума

имеет вид, близкий к параболоиду, методы

минимизации функции нескольких переменных

принято называть методами

спуска.

,

т.е. график функции в окрестности минимума

имеет вид, близкий к параболоиду, методы

минимизации функции нескольких переменных

принято называть методами

спуска.

Методы спуска.

Большинство

численных методов спуска состоит в

построении последовательности векторов

![]() ,

удовлетворяющих условию

,

удовлетворяющих условию

![]() .

.

В методах спуска

элементы последовательности

![]() вычисляются по формуле

вычисляются по формуле

![]() ,

где

,

где

![]() — направление спуска,

— направление спуска,

![]() — длина шага в направлении спуска.

Методы спуска отличаются друг от друга

способами выбора направления спуска

— длина шага в направлении спуска.

Методы спуска отличаются друг от друга

способами выбора направления спуска

![]() .

Если

.

Если

![]() — ограниченная снизу (дифференцируемая)

функция, и для некоторой начальной точки

— ограниченная снизу (дифференцируемая)

функция, и для некоторой начальной точки

![]() множество

множество

![]() также ограничено, то последовательность

также ограничено, то последовательность

![]() либо сходится к точке минимума при

либо сходится к точке минимума при

![]() ,

либо минимум достигается за конечное

число шагов. В практических вычислениях

используют одно из трех условий окончания

итераций:

,

либо минимум достигается за конечное

число шагов. В практических вычислениях

используют одно из трех условий окончания

итераций:

![]() ,

,

![]() или

или

![]() .

Если условие окончания итерационного

процесса выполнено, то полагают

.

Если условие окончания итерационного

процесса выполнено, то полагают

![]() .

.

Простейший метод

спуска — метод

покоординатного спуска.

Выбирают

некоторое нулевое приближение

![]() .

Затем "спускаются" по первой

координате:

.

Затем "спускаются" по первой

координате:

![]() ,

т.е.

,

т.е.

![]() ,

,

![]() ,

аналогично производится спуск по второй

координате:

,

аналогично производится спуск по второй

координате:

![]() ,

,

![]() ,

,

![]() ,

и т.д., до

,

и т.д., до

![]() ,

,

![]() ,

,

![]() .

.

На каждом шаге

проверяют условие окончания итераций.

Если за n

шагов минимум не будет достигнут, то

полагают

![]() и снова начинают покоординатный спуск.

Именно поэтому метод покоординатного

спуска иногда называют методом

циклического

покоординатного

спуска. Метод допускает простую

геометрическую интерпретацию.

и снова начинают покоординатный спуск.

Именно поэтому метод покоординатного

спуска иногда называют методом

циклического

покоординатного

спуска. Метод допускает простую

геометрическую интерпретацию.

Методы градиентного

спуска.

Все методы спуска

![]() ,

в которых направление спуска

,

в которых направление спуска

![]() совпадает с анитградиентом

совпадает с анитградиентом

![]() называются градиентными

методами:

называются градиентными

методами:

![]() .

Градиентные методы отличаются друг от

друга способами выбора шага

.

Градиентные методы отличаются друг от

друга способами выбора шага

![]() .

Наиболее распространенные среди них

— метод половинного деления и метод

наискорейшего спуска. В методе

наискорейшего

спуска при

выборе шага решается задача одномерной

минимизации

.

Наиболее распространенные среди них

— метод половинного деления и метод

наискорейшего спуска. В методе

наискорейшего

спуска при

выборе шага решается задача одномерной

минимизации

![]() ,

т.е.

,

т.е.

![]() .

Одномерная задача минимизации решается,

как правило,

методом золотого сечения.

.

Одномерная задача минимизации решается,

как правило,

методом золотого сечения.

Опишем один шаг

метода (один шаг итераций). Пусть

вычислено k-е

приближение точки минимума

![]() .

Вычисляем

.

Вычисляем

![]() и находим шаг

и находим шаг

![]() как

решение одномерной задачи минимизации.

Тогда

как

решение одномерной задачи минимизации.

Тогда

![]() .

В качестве условия окончания итерационного

процесса здесь чаще всего используют

условие

.

В качестве условия окончания итерационного

процесса здесь чаще всего используют

условие

![]() .

Когда условие выполнено, полагают

.

Когда условие выполнено, полагают

![]() .

Метод допускает простую геометрическую

интерпретацию (на рисунке вектор

.

Метод допускает простую геометрическую

интерпретацию (на рисунке вектор

![]() —

—

![]() ).

).

Методы

сопряженных градиентов.

Метод градиентного спуска очень медленно

сходится в случае, когда поверхности

уровня (линии уровня) функции

![]() сильно вытянуты. Этот факт известен в

литературе как "эффект оврагов".

сильно вытянуты. Этот факт известен в

литературе как "эффект оврагов".

Суть эффекта в том, что небольшие изменения одних переменных приводят к резкому изменению значений функции — эта группа переменных характеризует "склон оврага", а по остальным переменным, задающим направление "дна оврага", функция меняется незначительно. Для овражных функции траектория градиентного метода, как видно из рисунка, характеризуется довольно быстрым спуском на "дно оврага", и затем медленным зигзагообразным движением в точку минимума.

Например, для минимизации "овражной" функции, известной как "функция Брукса"

![]() ,

,

(ее минимум

достигается в точке

![]() ),

при спуске из точки

),

при спуске из точки

![]() с начальным шагом

с начальным шагом

![]() для достижения минимума с погрешностью

для достижения минимума с погрешностью

![]() потребовалось

более 100 шагов.

потребовалось

более 100 шагов.

Для отыскания минимума овражных функций применяют метод сопряженных градиентов.

Одна из наиболее популярных форм метода сопряженных градиентов — алгоритм Флетчера-Ривса. Опишем алгоритм Флетчера-Ривса.

-

Вычисляем

.

. -

На k-м шаге, k = 1, 2, … решаем задачу одномерной минимизации

и полагаем

и полагаем

.

. -

Вычисляем величины

и

и

.

. -

Если

,

то

,

то

— решение задачи, в противном случае

вычисляем коэффициент

— решение задачи, в противном случае

вычисляем коэффициент

по формуле

по формуле

.

Значения k

для которых

.

Значения k

для которых

называют моментами

обновления метода.

называют моментами

обновления метода.

-

Вычисляем

по формуле

по формуле

.

.

При обновлении процесс повторяют с п.1, в противном случае — с п.2.

Метод сопряженных

градиентов обладает замечательным

свойством: положительно определенная

квадратичная форма

![]() ,

,

![]() ,

,

минимизируется не более чем за n шагов.

Обусловленность

задачи минимизации.

Исследование обусловленности задачи

многомерной минимизации производится

так же, как обусловленность задачи

одномерной минимизации. Пусть

![]() — точка локального минимума дважды

непрерывно дифференцируемой функции

— точка локального минимума дважды

непрерывно дифференцируемой функции

![]() ,

ее матрица Гессе положительно определена

в точке

,

ее матрица Гессе положительно определена

в точке

![]() .

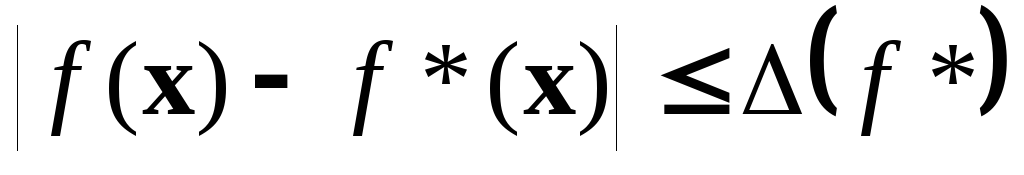

Предположим, что в некоторой окрестности

точки минимума значения функции

вычислены с некоторой погрешностью

.

Предположим, что в некоторой окрестности

точки минимума значения функции

вычислены с некоторой погрешностью

.

Тогда для радиуса соответствующей

окрестности

неопределенности справедлива грубая

оценка

.

Тогда для радиуса соответствующей

окрестности

неопределенности справедлива грубая

оценка

,

,

![]() — наименьшее

собственное значение матрицы Гессе

(оно положительно в силу положительной

определенности матриц Гессе). Это

означает, что ни один численный метод

оптимизации не может гарантировать

погрешность, меньшую, чем

— наименьшее

собственное значение матрицы Гессе

(оно положительно в силу положительной

определенности матриц Гессе). Это

означает, что ни один численный метод

оптимизации не может гарантировать

погрешность, меньшую, чем

![]() .

Это означает,

что даже для хорошо масштабированных

задач (т.е. для

.

Это означает,

что даже для хорошо масштабированных

задач (т.е. для

![]() )

неизбежна потеря примерно половины

верных значащих цифр из тех, которые

были верными при вычислении

)

неизбежна потеря примерно половины

верных значащих цифр из тех, которые

были верными при вычислении

![]() .

Как и в методах одномерной минимизации

задача вычисления стационарной точки

обусловлена значительно лучше:

.

Как и в методах одномерной минимизации

задача вычисления стационарной точки

обусловлена значительно лучше:

![]() ,

,

.

.