- •О.Т.Данилова Теория информации

- •Введение

- •Глава 1. Основные понятия теории информации

- •1.1. Свойства информации

- •1.2. Этапы обращения информации

- •1.3. Определение системы передачи информации. Каналы связи.

- •1.4. Алфавит сообщения

- •1.5. Источник информации

- •Глава 2. Количество информации

- •2.1. Объемный подход к измерению информации

- •2.2. Количественная мера информации р.Хартли

- •2.3. Мера информации к. Шеннона

- •2.4. Условная собственная информация. Взаимная информация

- •1 (Бит), где m – мощность алфавита.

- •Глава 3. Энтропия дискретной последовательности. Энтропия непрерывной случайной величины

- •3.1. Частная энтропия

- •Прологарифмировав последнее равенство, получим

- •3.2. Энропия типичных и нетипичных комбинаций

- •3.3. Условная энтропия

- •3.4. Энтропия объединения ансамблей

- •3.5. Канальные матрицы

- •3.6. Количество информации при неполной достоверности и статистической зависимости сообщений

- •3.7. Избыточность источника

- •3.8. Энтропия непрерывной случайной величины

- •3.9. Количество информации для непрерывных систем

- •3.10. Принцип экстремума энтропии и экстремальные распределения

- •Подставим (3.7) в (3.4):

- •3.11. Эпсилон энтропия

- •Глава 4. Общие сведения из теории сигналов

- •4.1. Классификация сигналов и систем

- •Характеристики сигналов передаваемых по каналу

- •4.3. Модуляция сигналов. Виды и характеристики носителей

- •4.4. Спектры сигналов

- •4.5. Тригонометрическая форма

- •4.6. Комплексная форма

- •4.7. Определение погрешности

- •Глава 5. Скорость передачи и пропускная способность канала связи

- •5.1. Скорость передачи информации в дискретной системе связи

- •5.2. Пропускная способность однородного симметричного канала связи

- •5.3. Пропускная способность непрерывного канала связи

- •5.4. Обмен мощности сигнала на ширину его спектра

- •5.5. Сравнение пропускной способности непрерывного и дискретного каналов связи.

- •5.6. Эффективность систем связи

- •Глава 6. Критерии описания реальных дискретных каналов

- •6.1. Описание источника ошибок на основе цепей Маркова

- •6.2. Описание источника ошибок на основе процессов восстановления

- •6.3. Описание источника ошибок на основе процессов накопления

- •6.4. Модель Гилберта

- •6.5. Модель Эллиота-Гилберта. Модель Элиота

- •6.6. Модель Беннета-Фройлиха

- •6.7. Модель Попова - Турина

- •Глава 7. Кодирование информации

- •7.1. Статистическое кодирование дискретных сообщений

- •7.2. Статистическое кодирование кодовых слов

- •Средняя длина кодового слова

- •7.3. Кодирование информации для канала с помехами

- •7.3. Разновидности помехоустойчивых кодов

- •7.4 Общие принципы использования избыточности

- •7.5. Связь корректирующей способности кода с кодовым расстоянием

- •7.6. Понятие качества корректирующего кода

- •7.7. Линейные коды

- •7.7. Математическое введение к линейным кодам

- •7.8. Линейный код как пространство линейного векторного пространства

- •7.9. Построение двоичного группового кода

- •7.10. Составление таблицы опознавателей

- •7.11. Определение проверочных равенств

- •7.12. Мажоритарное декодирование групповых кодов

- •7.13. Матричное представление линейных кодов

- •7.14. Построение циклических кодов

- •Математическое введение к циклическим кодам

- •7.17. Обнаружение одиночных ошибок

- •Исправление одиночных или обнаружение двойных ошибок

- •7.18. Обнаружение ошибок кратности три и ниже

- •7.19. Обнаружение и исправление независимых ошибок произвольной кратности

- •7.20. Методы образования циклического кода

- •7.21. Матричная запись циклического кода

- •7.22. Укороченные циклические коды

- •Глава 8. Сжатие информации

- •8.1. Основные понятия

- •8.2. Методы сжатия без потерь

- •8.3. Методы сжатия с потерями

- •8.4. Сжатие графики

- •Прямое дкп

- •8.5. Сжатие звука

- •8.6. Сжатие видеоинформации

- •Вопросы для самопроверки

- •Список литературы

![]()

Прямое дкп

,

Обратное

ДКП![]()

![]()

.

.

В способе вычисления

коэффициентов прямого ДКП имеется один

небольшой изъян – выделен частный

случай для вычисления

![]() .

Избавиться от этого недостатка можно,

если незначительно модифицировать

расчет элементов матрицыFN.

.

Избавиться от этого недостатка можно,

если незначительно модифицировать

расчет элементов матрицыFN.

Будем вычислять

![]() как и ранее по формуле (8.8) дляs

= 1, 2,…, N-1

и k

= 0, 1, . . .N-1.

Это все элементы матрицы FN

, кроме первой строки (с индексом 0).

Элементы же первой строки будут

вычисляться по формуле:

как и ранее по формуле (8.8) дляs

= 1, 2,…, N-1

и k

= 0, 1, . . .N-1.

Это все элементы матрицы FN

, кроме первой строки (с индексом 0).

Элементы же первой строки будут

вычисляться по формуле:

![]() ,

при k

= 0, 1, . . . N-1.

,

при k

= 0, 1, . . . N-1.

Если матрицу FN вычислять так, как это только что сказано, формулы для прямого и обратного ДКП приобретают такой окончательный вид:

![]() ,

для

0,

1,

. . . N-1

, (8.11)

,

для

0,

1,

. . . N-1

, (8.11)

![]() ,

для a0,

a1,

. . . aN-1.

(8.12)

,

для a0,

a1,

. . . aN-1.

(8.12)

Формулы ДКП получены для одномерного сигнала, за значения которого принимаются значения какой либо из компонент красного R, зеленного G или синего B элементов строки из N пикселов (рис. 8.1а). На практике рассматривают блок пикселов размером NN, где принимают N=8 (рис.8.1б).

В этом случае блок пикселов моделируется отсчетами двухмерного сигнала:

![]() , k

= 0, 1, … N-1,

l

= 0, 1, … N-1.

, k

= 0, 1, … N-1,

l

= 0, 1, … N-1.

Приемы, примененные для одномерного случая, аналогично переносятся и на двухмерный сигнал. Приведем окончательный результат.

В результате ДКП над сигналом получается матрица коэффициентов разложения по базисным функциям:

![]() ,

s

= 0, 1, … N-1,

r

= 0, 1, … N-1.

,

s

= 0, 1, … N-1,

r

= 0, 1, … N-1.

Формулы в матричной форме для выполнения прямого и обратного ДКП имеют вид:

![]() ,

(8.13)

,

(8.13)

![]() .

(8.14)

.

(8.14)

Элементы матрицы FN, как и ранее, находится по формулам:

![]() ,

при

k

= 0, 1, . . . N-1,

,

при

k

= 0, 1, . . . N-1,

![]() ,

при s

=

1, 2, . . . N-1

и k

=

0, 1, . . .N-1.

,

при s

=

1, 2, . . . N-1

и k

=

0, 1, . . .N-1.

Ранее говорилось, что замена описания сигнала, заданного его значениями, на описание коэффициентами преобразования Фурье может привести к сокращению объема данных. Однако количество элементов матриц прямого и обратного ДКП одинаково. Где же сжатие?

Чтобы ответить на этот вопрос, рассмотрим на численном примере последовательность действий, выполняемых при компрессии и декомпрессии.

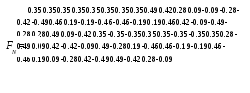

Матрица FN зависит только от N и может быть просчитана заранее. Ниже приводится ее значение при N = 8.

За значения атрибута пиксельного блока примем значения, приведенные в матрице a. Это может быть яркость какой-либо из компонент цвета R, G, B или яркость серого.

Шаг 1. Все данные смещаются на 128. Новое значение матрицы данных aСМ = a – 128. Это делается в соответствии с процедурой, установленной в методике сжатия JPEG.

Шаг 2. Выполняются

ДКП над смещенными данными:

![]() .

Результаты округляются до целых значений.

.

Результаты округляются до целых значений.

Шаг 3. Выполняется загрубение коэффициентов разложения. Этот вопрос требует особого пояснения. Обратимся к одномерному случаю. Коэффициент разложения s характеризует вклад s-й гармоники в формирование сигнала, в нашем случае изображения. Увеличение индекса s соответствует переходу к базисной функции следующей, большей частоты. С другой стороны, гармонические составляющие с большими частотами переносят все более мелкие подробности изображения. Идея сжатия – мелкие, малозначащие подробности изображения не учитывать. Это значит, что некоторые коэффициенты s ДКП могут быть отброшены и за счет этого уменьшен объем данных, если их хранить или передавать не как отсчеты сигнала, а как результаты ДКП. Весь вопрос в том, какими формальными правилами руководствоваться, отбрасывая некоторые коэффициенты преобразования? Подход здесь такой – коэффициентам s с большими индексами s устанавливать больший порог значимости. Существует множество алгоритмов решения такой задачи. Приведем один из них на конкретном примере.

Пусть

= {286, -6, 22, -3, -5, -10, 2, 7 }.

Поделим с точностью

до ближайшего

целого

все s

на делитель qs=(1+(1+s)Q)

при Q

= 4. Т.е.

![]() :

:

1 = (57, -1, 2, 0, 0, 0, 0, 0).

Полученный результат

помножим на qs,

таким образом

![]() :

:

загр = (285, -9, 26, 0, 0, 0, 0, 0).

Как видно малозначащие коэффициенты разложения здесь приняли нулевые значения. Теперь, если восстановить сигнал по коэффициентам и загр, то они будут мало отличаться. Параметр Q здесь следует понимать как задающий степень сжатия. При Q = 0 сжатия не будет, при увеличении Q порог значимости увеличивается и все большее число коэффициентов обнуляется.

Аналогично

одномерному случаю, загрубение

осуществляется и для двухмерного случая.

Не повторяя всех рассуждений, примем

![]() ,Q

= 4 и найдем элементы матрицы

,Q

= 4 и найдем элементы матрицы

![]() .

.

Шаг 4. кодирование данных. Данные из матрицы 1 формируют в линейную последовательность. Выстраивают в линейку их в таком порядке, как это показано на матрице стрелками (этот порядок соответствует возрастанию частоты базисных функций):

18

0 –4 –7 –4 –1 0 1 4 –3 –4 –2 0 1 0 0 0 –1 0 –2 –3

–1 2 2 0 0 0 0 0 0 0 0 0 0 0 –2 1 –1 0 0 0 0 0 0 0 0 0 0 0 0 0

0 0 0 0 0 0 0 0 0 0 0 0 0

К полученным данным применяют метод кодирования RLE и, в сочетании с кодированием, например, по Хаффману, достигается существенное сжатие данных. Действительно, в приведенной последовательности одна серия из 3 нулей, одна серия из 11 нулей и одна серия из 26 нулей!

Шаг 5. Это первый шаг декомпрессии. Из закодированной на шаге 4 последовательности восстанавливают сначала саму последовательность, а затем матрицу 1.

Шаг 6. Восстанавливают

![]() :

:

Шаг 7. Восстанавливают

исходные данные

![]() .

В результате операции

.

В результате операции![]() будут

восстановлены данные матрицыaСМ.

Прибавление к каждому элементу этой

матрицы величины 128 приведет к

восстановлению исходных данных матрицы

a.

будут

восстановлены данные матрицыaСМ.

Прибавление к каждому элементу этой

матрицы величины 128 приведет к

восстановлению исходных данных матрицы

a.

На этом завершена декомпрессия сжатых данных. Матрица a это исходные данные до компрессии, кодированная методом RLE последовательность данных, полученная на шаге 4, – это сжатые данные, матрица aВОСТ – восстановленные исходные данные.

Если сравнить исходные и восстановленные данные, то можно увидеть, что они нигде не совпадают, но везде отклонение меньше 10%. Такая разница во многих случаях может быть незаметна на глаз. Установив параметр Q = 0 можно получить 100% восстановление, но и ни какого сжатия при этом не будет достигнуто. Увеличение Q приводит к увеличению степени сжатия и, соответственно, к увеличению потерь при восстановлении.

Сжатие методом ДКП не может быть применено к палитровым изображениям, поскольку данные там указывают на регистр палитры. Даже соседние регистры палитры могут существенно отличаться по цвету. Поэтому погрешность при восстановлении данных может привести к значительным искажениям изображения. К палитровым изображениям могут быть применены только методы сжатия без потерь.

Изложенный метод служит основой сжатия данных по стандарту JPEG. Он также является основой метода сжатия видео сюжетов MPEG, который становится видеостандартом для персональных компьютеров.