- •О.Т.Данилова Теория информации

- •Введение

- •Глава 1. Основные понятия теории информации

- •1.1. Свойства информации

- •1.2. Этапы обращения информации

- •1.3. Определение системы передачи информации. Каналы связи.

- •1.4. Алфавит сообщения

- •1.5. Источник информации

- •Глава 2. Количество информации

- •2.1. Объемный подход к измерению информации

- •2.2. Количественная мера информации р.Хартли

- •2.3. Мера информации к. Шеннона

- •2.4. Условная собственная информация. Взаимная информация

- •1 (Бит), где m – мощность алфавита.

- •Глава 3. Энтропия дискретной последовательности. Энтропия непрерывной случайной величины

- •3.1. Частная энтропия

- •Прологарифмировав последнее равенство, получим

- •3.2. Энропия типичных и нетипичных комбинаций

- •3.3. Условная энтропия

- •3.4. Энтропия объединения ансамблей

- •3.5. Канальные матрицы

- •3.6. Количество информации при неполной достоверности и статистической зависимости сообщений

- •3.7. Избыточность источника

- •3.8. Энтропия непрерывной случайной величины

- •3.9. Количество информации для непрерывных систем

- •3.10. Принцип экстремума энтропии и экстремальные распределения

- •Подставим (3.7) в (3.4):

- •3.11. Эпсилон энтропия

- •Глава 4. Общие сведения из теории сигналов

- •4.1. Классификация сигналов и систем

- •Характеристики сигналов передаваемых по каналу

- •4.3. Модуляция сигналов. Виды и характеристики носителей

- •4.4. Спектры сигналов

- •4.5. Тригонометрическая форма

- •4.6. Комплексная форма

- •4.7. Определение погрешности

- •Глава 5. Скорость передачи и пропускная способность канала связи

- •5.1. Скорость передачи информации в дискретной системе связи

- •5.2. Пропускная способность однородного симметричного канала связи

- •5.3. Пропускная способность непрерывного канала связи

- •5.4. Обмен мощности сигнала на ширину его спектра

- •5.5. Сравнение пропускной способности непрерывного и дискретного каналов связи.

- •5.6. Эффективность систем связи

- •Глава 6. Критерии описания реальных дискретных каналов

- •6.1. Описание источника ошибок на основе цепей Маркова

- •6.2. Описание источника ошибок на основе процессов восстановления

- •6.3. Описание источника ошибок на основе процессов накопления

- •6.4. Модель Гилберта

- •6.5. Модель Эллиота-Гилберта. Модель Элиота

- •6.6. Модель Беннета-Фройлиха

- •6.7. Модель Попова - Турина

- •Глава 7. Кодирование информации

- •7.1. Статистическое кодирование дискретных сообщений

- •7.2. Статистическое кодирование кодовых слов

- •Средняя длина кодового слова

- •7.3. Кодирование информации для канала с помехами

- •7.3. Разновидности помехоустойчивых кодов

- •7.4 Общие принципы использования избыточности

- •7.5. Связь корректирующей способности кода с кодовым расстоянием

- •7.6. Понятие качества корректирующего кода

- •7.7. Линейные коды

- •7.7. Математическое введение к линейным кодам

- •7.8. Линейный код как пространство линейного векторного пространства

- •7.9. Построение двоичного группового кода

- •7.10. Составление таблицы опознавателей

- •7.11. Определение проверочных равенств

- •7.12. Мажоритарное декодирование групповых кодов

- •7.13. Матричное представление линейных кодов

- •7.14. Построение циклических кодов

- •Математическое введение к циклическим кодам

- •7.17. Обнаружение одиночных ошибок

- •Исправление одиночных или обнаружение двойных ошибок

- •7.18. Обнаружение ошибок кратности три и ниже

- •7.19. Обнаружение и исправление независимых ошибок произвольной кратности

- •7.20. Методы образования циклического кода

- •7.21. Матричная запись циклического кода

- •7.22. Укороченные циклические коды

- •Глава 8. Сжатие информации

- •8.1. Основные понятия

- •8.2. Методы сжатия без потерь

- •8.3. Методы сжатия с потерями

- •8.4. Сжатие графики

- •Прямое дкп

- •8.5. Сжатие звука

- •8.6. Сжатие видеоинформации

- •Вопросы для самопроверки

- •Список литературы

Глава 5. Скорость передачи и пропускная способность канала связи

5.1. Скорость передачи информации в дискретной системе связи

В дискретной системе связи при отсутствии помех информация на выходе канала связи (канала ПИ) полностью совпадает с информацией на его входе, поэтому скорость передачи информации численно равна производительности источника сообщений:

![]() .(5.1)

.(5.1)

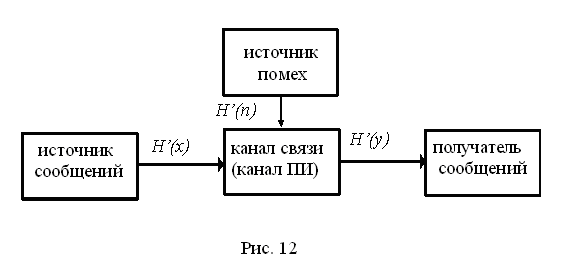

При наличии помех часть информации источника теряется и скорость передачи информации оказывается меньшей, чем производительность источника. Одновременно в сообщение на выходе канала добавляется информация о помехах (рис.12).

Поэтому при наличии помех необходимо учитывать на выходе канала не всю информацию, даваемую источником, а только взаимную информацию:

![]() бит/с. (5.2)

бит/с. (5.2)

На основании формулы (5.1) имеем

![]() или

или

![]() ,

(5.3)

,

(5.3)

где H(x) производительность источника;

H(x/y) ненадёжность “ канала(потери) в единицу времени;

H(y) энтропия выходного сообщения в единицу времени;

H(y/x)=H’(n) –энтропия помех ( шума) в единицу времени.

Пропускной способностью канала связи (канала передачи информации) C называется максимально возможная скорость передачи информации по каналу

![]() .(5.4)

.(5.4)

Для достижения максимума учитываются все возможные источники на выходе и все возможные способы кодирования.

Таким образом, пропускная способность канала связи равна максимальной производительности источника на входе канала, полностью согласованного с характеристиками этого канала, за вычетом потерь информации в канале из-за помех.

В канале без помех C=max H(x), так как H(x/y)=0. При использовании равномерного кода с основанием k, состоящего из n элементов длительностью э, в канале без помех

![]() ,

,

при k=2

![]() бит/c.

(5.5)

бит/c.

(5.5)

Для эффективного использования пропускной способности канала необходимо его согласование с источником информации на входе. Такое согласование возможно как для каналов связи без помех, так и для каналов с помехами на основании двух теорем, доказанных К.Шенноном.

1-ая теорема (для канала связи без помех):

Если источник сообщений имеет энтропию H (бит на символ), а канал связи – пропускную способность C (бит в секунду), то можно закодировать сообщения таким образом, чтобы передавать информацию по каналу со средней скоростью, сколь угодно близкой к величине C, но не превзойти её.

К.Шеннон предложил и метод такого кодирования, который получил название статистического или оптимального кодирования. В дальнейшем идея такого кодирования была развита в работах Фано и Хаффмена и в настоящее время широко используется на практике для “cжатия сообщений”.

5.2. Пропускная способность однородного симметричного канала связи

В однородном канале связи условные(переходные) вероятности p(y1/x1) не зависят от времени. Граф состояний и переходов однородного двоичного канала связи приведен на рис. 13.

Рис.13

На этом рисунке x1 и x2 – сигналы на входе канала связи, y1 и y2 – сигналы на выходе. Если передавался сигнал x1 и принят сигнал y1, это означает, что первый сигнал (индекс 1) не исказился. Если передавался первый сигнал (x1), а принят второй сигнал (y2), это означает, что произошло искажение первого сигнала. Вероятности переходов указаны на рис. 13. Если канал симметричный, то вероятности переходов попарно равны.

Обозначим: p(y2/x1)= p(y1/x2)=pэ – вероятности искажения элемента сигнала, p(y1/x1)= p(y2/x2)=1-pэ – вероятности правильного приёма элемента сигнала.

В соответствии с формулами (5.1) и (5.3)

![]() .

.

Если сигналы

x1

и x2

имеют

одинаковую длительность э,

то

![]() .

Тогда пропускная способность канала

будет равна

.

Тогда пропускная способность канала

будет равна

![]() .

(5.7)

.

(5.7)

В этой формуле maxH(y)=logk. Для двоичного канала (k=2) maxH(y)=1 и формула (5.4) примет вид

![]() .

(5.8)

.

(5.8)

Остаётся определить условную энтропию H(y/x). Для двоичного источника имеем

![]()

![]()

![]()

Подставив это значение условной энтропии в (5.8), получим окончательно

![]() .

(5.9)

.

(5.9)

На рис. 14 построен график зависимости пропускной способности двоичного канала от вероятности ошибки.

Для канала связи с k>2 пропускная способность определяется почти аналогичной формулой:

![]() . (5.10)

. (5.10)

В заключении

рассмотрим один пример. Пусть имеется

двоичный источник с производительностью

![]() бит/c.

бит/c.

Рис. 14

На рис. 14 построен график зависимости пропускной способности двоичного канала от вероятности ошибки.

Для канала связи с k>2 пропускная способность определяется почти аналогичной формулой:

![]() . (5.10)

. (5.10)

В заключении

рассмотрим один пример. Пусть имеется

двоичный источник с производительностью

![]() бит/c.

бит/c.

Если вероятность искажения pэ=0,01, то из этого следует, что из 1000 элементов сигнала, переданных за одну секунду, в среднем 990 элементов будут приняты без искажений и только 10 элементов будут искажены. Казалось бы, пропускная способность в этом случае будет составлять 990 бит в секунду. Однако вычисление по формуле (5.9) даёт нам величину, значительно меньшую (C=919 бит/с). В чём здесь дело? А дело в том, что мы получили бы C=990 бит/с, если бы точно знали, какие именно элементы сообщения искажены. Незнание этого факта (а это практически знать невозможно) приводит к тому, что 10 искажённых элементов настолько сильно снижают ценность принимаемого сообщения, что пропускная способность резко уменьшается.

Другой пример. Если pэ=0,5, то из 1000 переданных элементов 500 не будут искажены. Однако теперь уже пропускная способность будет составлять не 500 бит/с, как можно было бы предполагать, а формула (5.9) даст нам величину C=0. Действительно при pэ=0,5 сигнал по каналу связи фактически уже не проходит и канал связи просто эквивалентен генератору шума.

При pэ1 пропускная способность приближается к максимальной величине. Однако в этом случае сигналы на выходе системы связи необходимо инвертировать.