- •О.Т.Данилова Теория информации

- •Введение

- •Глава 1. Основные понятия теории информации

- •1.1. Свойства информации

- •1.2. Этапы обращения информации

- •1.3. Определение системы передачи информации. Каналы связи.

- •1.4. Алфавит сообщения

- •1.5. Источник информации

- •Глава 2. Количество информации

- •2.1. Объемный подход к измерению информации

- •2.2. Количественная мера информации р.Хартли

- •2.3. Мера информации к. Шеннона

- •2.4. Условная собственная информация. Взаимная информация

- •1 (Бит), где m – мощность алфавита.

- •Глава 3. Энтропия дискретной последовательности. Энтропия непрерывной случайной величины

- •3.1. Частная энтропия

- •Прологарифмировав последнее равенство, получим

- •3.2. Энропия типичных и нетипичных комбинаций

- •3.3. Условная энтропия

- •3.4. Энтропия объединения ансамблей

- •3.5. Канальные матрицы

- •3.6. Количество информации при неполной достоверности и статистической зависимости сообщений

- •3.7. Избыточность источника

- •3.8. Энтропия непрерывной случайной величины

- •3.9. Количество информации для непрерывных систем

- •3.10. Принцип экстремума энтропии и экстремальные распределения

- •Подставим (3.7) в (3.4):

- •3.11. Эпсилон энтропия

- •Глава 4. Общие сведения из теории сигналов

- •4.1. Классификация сигналов и систем

- •Характеристики сигналов передаваемых по каналу

- •4.3. Модуляция сигналов. Виды и характеристики носителей

- •4.4. Спектры сигналов

- •4.5. Тригонометрическая форма

- •4.6. Комплексная форма

- •4.7. Определение погрешности

- •Глава 5. Скорость передачи и пропускная способность канала связи

- •5.1. Скорость передачи информации в дискретной системе связи

- •5.2. Пропускная способность однородного симметричного канала связи

- •5.3. Пропускная способность непрерывного канала связи

- •5.4. Обмен мощности сигнала на ширину его спектра

- •5.5. Сравнение пропускной способности непрерывного и дискретного каналов связи.

- •5.6. Эффективность систем связи

- •Глава 6. Критерии описания реальных дискретных каналов

- •6.1. Описание источника ошибок на основе цепей Маркова

- •6.2. Описание источника ошибок на основе процессов восстановления

- •6.3. Описание источника ошибок на основе процессов накопления

- •6.4. Модель Гилберта

- •6.5. Модель Эллиота-Гилберта. Модель Элиота

- •6.6. Модель Беннета-Фройлиха

- •6.7. Модель Попова - Турина

- •Глава 7. Кодирование информации

- •7.1. Статистическое кодирование дискретных сообщений

- •7.2. Статистическое кодирование кодовых слов

- •Средняя длина кодового слова

- •7.3. Кодирование информации для канала с помехами

- •7.3. Разновидности помехоустойчивых кодов

- •7.4 Общие принципы использования избыточности

- •7.5. Связь корректирующей способности кода с кодовым расстоянием

- •7.6. Понятие качества корректирующего кода

- •7.7. Линейные коды

- •7.7. Математическое введение к линейным кодам

- •7.8. Линейный код как пространство линейного векторного пространства

- •7.9. Построение двоичного группового кода

- •7.10. Составление таблицы опознавателей

- •7.11. Определение проверочных равенств

- •7.12. Мажоритарное декодирование групповых кодов

- •7.13. Матричное представление линейных кодов

- •7.14. Построение циклических кодов

- •Математическое введение к циклическим кодам

- •7.17. Обнаружение одиночных ошибок

- •Исправление одиночных или обнаружение двойных ошибок

- •7.18. Обнаружение ошибок кратности три и ниже

- •7.19. Обнаружение и исправление независимых ошибок произвольной кратности

- •7.20. Методы образования циклического кода

- •7.21. Матричная запись циклического кода

- •7.22. Укороченные циклические коды

- •Глава 8. Сжатие информации

- •8.1. Основные понятия

- •8.2. Методы сжатия без потерь

- •8.3. Методы сжатия с потерями

- •8.4. Сжатие графики

- •Прямое дкп

- •8.5. Сжатие звука

- •8.6. Сжатие видеоинформации

- •Вопросы для самопроверки

- •Список литературы

Подставим (3.7) в (3.4):

С учетом того, что

![]() ,

получим

,

получим

![]() (3.27)

(3.27)

Подставив (2.8) в (2.7), получим искомое выражение

(3.28)

(3.28)

В результате получили нормальный закон распределения вероятностей.

Выводы:

Если задана дисперсия состояний сообщений, то сообщение обладает наибольшей информативностью (максимальной энтропией) в том случае, когда состояния элементов распределены по нормальному закону.

Если задана средняя мощность помехи, то последняя является наиболее эффективной (энтропия помехи максимальна), когда состояния составляющих помеху элементов распределены по нормальному закону.

Второй случай. Определим вид функции w(x) , обеспечивающей максимальную энтропию сообщений при непрерывном распределении состояний элементов и произвольной дисперсии. Эта вариационная задача имеет только одно дополнительное условие.

![]() (3.29)

(3.29)

Решение задачи можно получить, положив в (2.5) λ2=0:

![]()

тогда уравнение

(3.28) будет равно

![]() .

Подставимw(x)

в (3.29) и возьмем пределы a

и b,

так как w(x)

не зависит от x:

.

Подставимw(x)

в (3.29) и возьмем пределы a

и b,

так как w(x)

не зависит от x:

![]() ,

,

откуда

![]() .

.

Так как функция плотности вероятности w(x) не зависит от x, то она является величиной постоянной во всем интервале существования случайной величины. Пусть состояния элементов сообщений существуют в интервале [a,b], тогда искомая функция распределения равна

![]() (3.30)

(3.30)

внутри интервала [a,b] и нулю вне пределов его.

Выводы. Если дисперсия состояний сообщений не ограничена, то сообщения обладают наибольшей информативностью (максимальной энтропией) в том случае, когда состояния элементов распределены по равновероятному закону.

Для сравнения сообщений, удовлетворяющих нормальному и равновероятному законам распределения вероятностей, необходимо предварительно вычислить энтропию этих сообщений.

Вычислим энтропию сообщений, состояния элементов которых распределены по нормальному закону:

Т.

к.

![]() ,

то

,

то![]() и

и

![]() (3.31)

(3.31)

Теперь найдем значение энтропии непрерывных сообщений для равновероятного закона распределения:

![]() ,

,![]() ,

,

![]() .

(3.32)

.

(3.32)

Рассмотрим два вида сообщений, обладающих одинаковой энтропией, но характеризуемых различными законами распределения состояний элементов: Hн(X) = Hр(X), где Hн(X) энтропия сообщений с нормальным распределением, Hр(X) энтропия сообщений с равновероятным распределением.

Согласно (3.31) и

(3.32)

![]() ,

что приводит к равенству

,

что приводит к равенству

![]() (3.33)

(3.33)

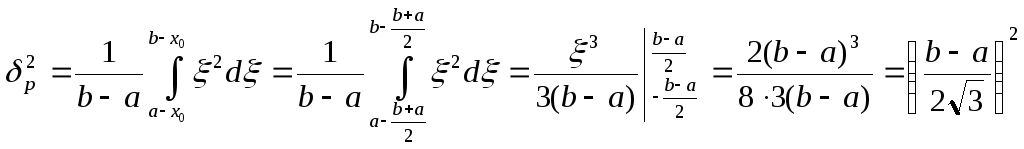

Дисперсия для

равновероятного закона распределения

определяется интегралом

![]() .

Обозначимx–x0=0,

тогда dx

= d,

.

Обозначимx–x0=0,

тогда dx

= d,

![]() ,

,

Откуда

![]() .

Полученное выражение подставим в (3.14):

.

Полученное выражение подставим в (3.14):

![]()

![]() или

или

![]() .

.

Таким образом, если имеются две системы с одинаковыми значениями энтропии по величине, то дисперсия системы при равновероятном распределении на 42% больше дисперсии системы, имеющей нормальное распределение состояния элементов. Т. к. дисперсия характеризует среднюю мощность сигналов, то выгоднее передавать сообщения по нормальному закону распределения элементов. Затраты на мощность при нормальном законе будут составлять 0,7 по сравнению с затратами мощности при равновероятном законе распределения элементов.