- •Вопросы

- •Виды параллельной обработки данных на эвм

- •Параллелизм на уровне машинных команд.

- •Структура оперативной памяти.

- •Секция ввода/вывода

- •Секция межпроцессорного взаимодействия

- •Регистровая структура Cray c90

- •Понятие векторн обр-ки, зацепл фу(Cray c90) Векторная обработка

- •Функциональные устройства

- •Независимость функциональных устройств

- •Зацепление функциональных устройств

- •Закон Амдала .Время разгона конвейера Закон Амдала и его следствия

- •Причины уменьшения производительности Cray c90

- •Суммарное влияние отрицательных факторов на производительность компьютера

- •Архитектура компьютера EarthSimulator.

- •Массивно-параллельные компьютеры, общие черты

- •Общая структура компьютера cray t3d

- •Вычислительные узлы и процессорные элементы

- •Коммуникационная сеть

- •Топология сети, чередование вычислительных узлов

- •Маршрутизация в сети и сетевые маршрутизаторы.

- •Нумерация вычислительных узлов.

- •Особенности синхронизации процессорных элементов

- •Причины уменьшения производительности компьютера Cray t3e/d.

- •Вычислительные кластеры:узлы,коммуникационная сеть (латентность, пропускная способность).

- •История проекта Beowulf

- •Общая характеристика Hewlett-PackardSuperdome.

- •Предсказание ветвлений

- •Причины уменьшения производительности

- •Графовые модели программ, их взаимосвязь.

- •Mpi. Терминология и обозначения

- •Общие процедуры mpi

- •Mpi: синхронное и асинхронное взаимодействие процессов. Прием/передача сообщений между отдельными процессами

- •Прием/передача сообщений с блокировкой

- •Совмещенные прием/передача сообщений

- •Mpi: коммуникаторы

- •Коллективные взаимодействия процессов

- •Mpi: глобальные операции, барьеры Синхронизация процессов в mpi происходит посредством единственной функции

- •Транспьютер: основы архитектуры и его характеристика.

- •Оценки быстродействия вычислительных систем. Тесты производительности сети. Тесты производительности файловой системы. Тесты производительности процессора. Комбинированные тесты

- •Тесты производительности сети

- •Тесты производительности файловой системы

- •Тесты производительности процессора

- •Комбинированные тесты

- •Терминология

- •Классификация Флинна

- •Дополнения Ванга и Бриггса к классификации Флинна

- •Классификация Фенга

- •Классификация Шора

- •Классификация Хендлера

- •Классификация Хокни

- •Классификация Шнайдера

- •Классификация Джонсона

- •Классификация Базу

- •Классификация Кришнамарфи

- •Классификация Скилликорна

- •Классификация Дазгупты

- •Классификация Дункана

- •Принципы разработки современных парраллельных компьютеров.

- •Конвейерная организация Простейшая организация конвейера и оценка его производительности

- •Структурные конфликты и способы их минимизации

- •Конфликты по данным, остановы конвейера и реализация механизма обходов

- •Сокращение потерь на выполнение команд перехода и минимизация конфликтов по управлению

- •Ожидающие функции

- •Виды функций активации

- •Алгоритм решения задач с помощью мсп

- •Формализация задачи

- •Методы обучения

- •Сеть с линейным поощрением

- •Место нейронных сетей среди других методов решения задач

Алгоритм решения задач с помощью мсп

Чтобы построить МСП, необходимо выбрать его параметры. Чаще всего выбор значений весов и порогов требует обучения, т.е. пошаговых изменений весовых коэффициентов и пороговых уровней.

Общий алгоритм решения:

1. Определить, какой смысл вкладывается в компоненты входного вектора x. Входной вектор должен содержать формализованное условие задачи, т.е. всю информацию, необходимую для получения ответа.

2. Выбрать выходной вектор y таким образом, чтобы его компоненты содержали полный ответ поставленной задачи.

3. Выбрать вид нелинейности в нейронах (функцию активации). При этом желательно учесть специфику задачи, т.к. удачный выбор сократит время обучения.

4. Выбрать число слоев и нейронов в слое.

5. Задать диапазон изменения входов, выходов, весов и пороговых уровней, учитывая множество значений выбранной функции активации.

6. Присвоить начальные значения весовым коэффициентам и пороговым уровням и дополнительным параметрам (например, крутизне функции активации, если она будет настраиваться при обучении). Начальные значения не должны быть большими, чтобы нейроны не оказались в насыщении (на горизонтальном участке функции активации), иначе обучение будет очень медленным. Начальные значения не должны быть и слишком малыми, чтобы выходы большей части нейронов не были равны нулю, иначе обучение также замедлится.

7. Провести обучение, т.е. подобрать параметры сети так, чтобы задача решалась наилучшим образом. По окончании обучения сеть готова решить задачи того типа, которым она обучена.

8. Подать на вход сети условия задачи в виде вектора x. Рассчитать выходной вектор y, который и даст формализованное решение задачи.

Формализация задачи

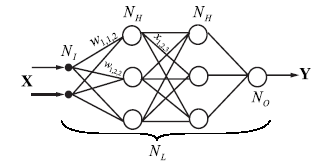

Многослойный

перцептрон может рассчитывать выходной

вектор y для любого входного вектора x

, т.е. давать значение некоторой векторной

функции y = f (x). Следовательно, условие

любой задачи, которая может быть

поставлена перцептрону, должно являться

множеством векторов

![]() с

NIкомпонентами каждый:

с

NIкомпонентами каждый: .

Решением задачи будет множество векторов

.

Решением задачи будет множество векторов![]() ,

каждый вектор ysс

NOкомпонентами; ys=f (xs),

где s =1..S — номер предъявленного образа.

,

каждый вектор ysс

NOкомпонентами; ys=f (xs),

где s =1..S — номер предъявленного образа.

Все, что способен сделать перцептрон — это сформировать отображение X →Y для xX . Данное отображение мы не можем "извлечь" полностью из перцептрона, а можем только посчитать отображение произвольного количества точек:

здесь множество векторов x1...xS— формализованное условие задачи, а множество y1…yS—формализованное решение. Задача формализации, т.е. выбора смысла, которым наделяются компоненты входного и выходного векторов, пока решается только человеком на основе практического опыта.

Вопрос№54

Классификация ИНС.

ИНС без обратных связей

однослойный персептрон

многослойный персептрон

ИНС с обратными связями

сети Хопфилда

сети ассоциативной двунаправленной памяти (ДАП)

сети (карты) Кохонена

сети адаптивной резонансной теории (АРТ)

Однослойный персептрон

Многослойный персептрон

Фиксируется ввод и вывод, меняются параметры. Обучение (настройка) – изменение весовых коэффициентов.

Сети Хомфилда

Если подать фрагмент и он однозначен, то сеть должна восстановить целое.

Сети ассоциативной двунаправленной памяти (ДАП)

Создаёт ассоциации: Аi Bi

Cети (карты) Кохонена

Обучение по принципу «победитель – забирает всё».

Самоорганизующаяся сеть (не знаем правильный выход). Учиться по алгоритму обучения (настройка весовых коэффициентов)

Сети адаптивной резонансной теории (АРТ)

Слой А – слой сравнения

Слой B – слой распознавания

Обладает свойством классичности, т.е. дообучаемости

Вопрос№55