Лаба 7

.docxМИНИСТЕРСТВО ЦИФРОВОГО РАЗВИТИЯ, СВЯЗИ И МАССОВЫХ КОММУНИКАЦИЙ

Ордена Трудового Красного Знамени

Федеральное государственное бюджетное образовательное учреждение высшего образования

«Московский технический университет связи и информатики»

Кафедра «Математическая кибернетика и информационные технологии»

Дисциплина «Большие данные»

Лабораторная работа №7

Москва, 2024

Содержание

1 Цель работы 3

2 Ход работы 3

3 Вывод 6

1 Цель работы

Получить навыки работы с Airflow.

2 Ход работы

Apache Airflow - это открытая платформа для создания, выполнения, отслеживания и управления операциями по обработке данных. Она позволяет разработчикам контролировать и мониторить сложные рабочие процессы, выполняемые в локальных и облачных средах.

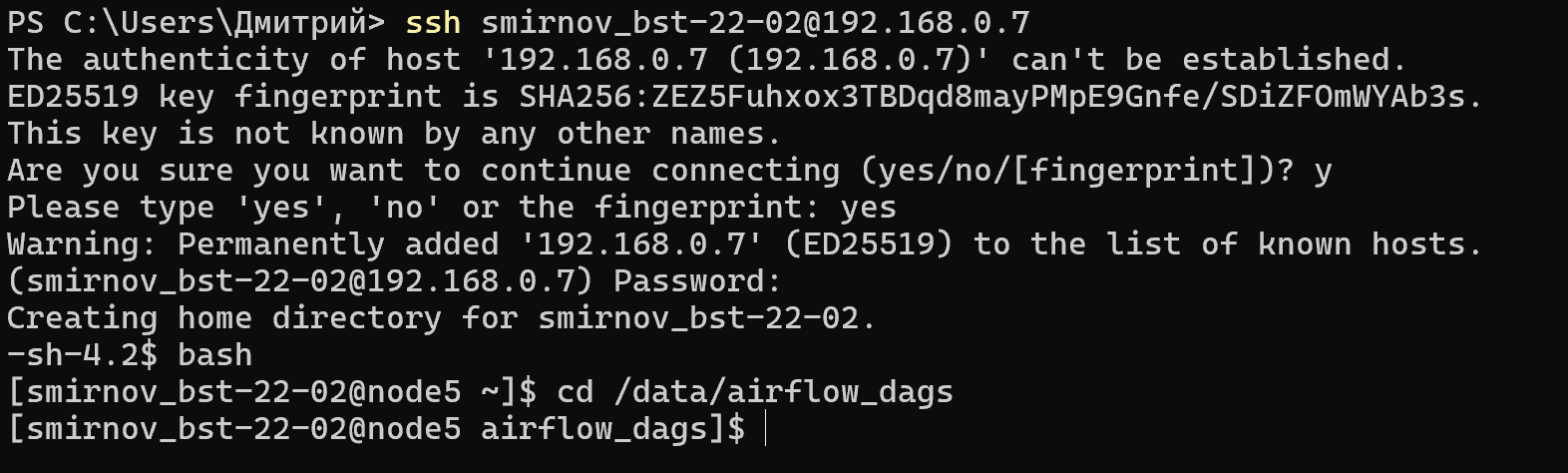

Зайдем на хост 192.168.0.7 и переместимся в директорию /data/airflow_dags.

Рисунок 1 – Запуск Airflow

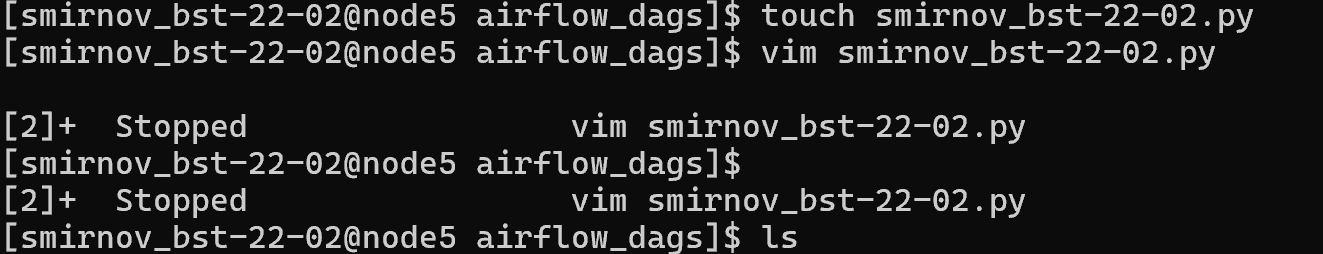

Создадим свой .py – файл (рисунок 2 - 3).

Рисунок 2 – Создание файла .ру

Рисунок 3 – Просмотр созданного файла

Внутри создадим даг из нескольких тасков:

— DummyOperator - «Пустой» оператор, который можно использовать для группировки задач

— BashOperator (с выводом даты) - Запуск Bash-скриптов

— PythonOperator (с выводом даты) - Исполнение Python-кода

Рисунок 4 – Код .ру файла

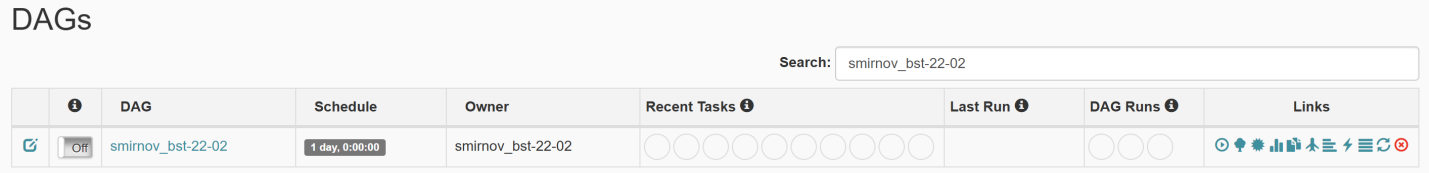

Через пару минут после сохранения файла он появится в UI Airflow. Проверим это (рисунок 5).

Рисунок 5 - Отображение DAG в UI Airflow

Запустим его вручную, покажем, что запуск произошёл корректно (рисунок 6).

Рисунок 6 – Запуск DAG вручную

Результат запуска представлен на рисунке 7.

Рисунок 7 – Результат корректного запуска сохранённого .py-файла

3 Вывод

Мы получили навыки работы с Airflow.