- •Сибирская Аэрокосмическая Академия

- •Статический метод

- •Энтропия и её свойства

- •Энтропия сложной системы

- •Условная энтропия. Объединение зависимых систем.

- •Полная условная энтропия

- •Теорема сложения энтропий

- •Определение информационных потерь в каналах связи

- •Энтропия и информация

- •Взаимная информация

- •Сумма равна единице

- •Частная информация о системе

- •Частная информация о событии, получаемая в результате сообщения о другом событии.

- •Энтропия и информация для систем с непрерывным множеством состояний

- •Условная энтропия непрерывной системы

- •Количественное определения избыточности

- •Блочное кодирование

- •Избыточность от округления

- •1 Символ – 4 бита

- •Код Хафмана

- •Процедура кодирования

- •Передача информации по дискретным каналам связи

- •Основная теорема Шеннона о кодировании для дискретного канала без помех

- •Дискретный канал с помехами

- •Теорема о кодировании Шеннона для дискретного канала с помехами

- •Корректирующие коды

- •Исправление ошибок с помощью полной кодовой таблицы

- •Разбиение

- •Систематические коды

- •Декодирование систематических кодов

- •Код Хэминга

- •Декодирование кода Хэминга

- •Особенности декодирования.

- •Циклические коды

- •Декодирование циклических кодов

- •Построение декодированного конкретного циклического кода

- •Обнаружение и определение ошибок

- •Коды, обнаруживающие трёхкратные ошибки

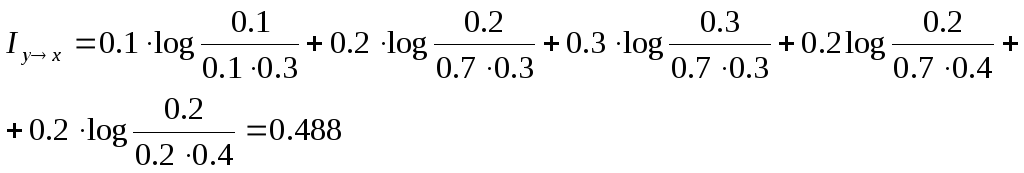

Взаимная информация

Имеется две системы: X и Y. Они взаимосвязаны. Необходимо определить, какое количество информации по системе X даст наблюдение за системой Y. Такую информацию определяют, как уменьшение энтропии системы X в результате получения сведений о системе Y.

Iyx = H(x) – H(x / y)

Iyx = Ixy = Ixy

Если системы X и Y независимы, то

H(x / y) = H(x) и Iyx = 0 - информации не будет

2) Система полностью зависимы

H(x / y) = H(y / x) = 0 Iyx = H(x) = H(y)

Выражения для взаимной информации можно получить через взаимную энтропию

H(x / y) = H(x, y) – H(y) Iyx = H(x) + H(y) – H(x, y)

Формула для расчёта взаимной информации

H(x) = M[ - log p(x)], H(y) = M[ - log p(y)] H(x, y) = M[ - log p(x, y)]

Iyx

= M[ - log

p(x) – log p(y) + log p(x, y)]

![]()

П

Этих

сведений достаточно, чтобы определить

взаим- ную

информацию, создавшуюся в системе Сумма равна единице

![]()

-

xi

& yi

xi

& yix1

x2

x3

rj

y1

0.1

0.2

0

0.3

y2

0

0.3

0

0.3

y3

0

0.2

0.2

0.4

pi

0.1

0.7

0.2

бит

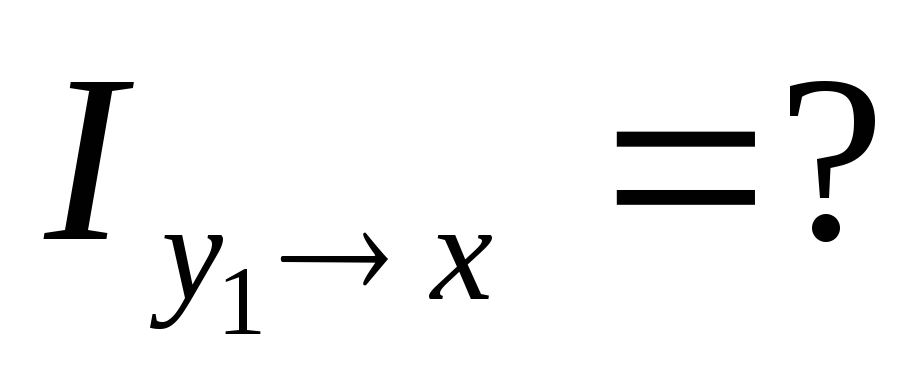

Частная информация о системе

Пусть имеется две системы X и Y и они взаимосвязаны. Определим частную информацию о системе X, содержащуюся в отдельном сообщении.

![]()

![]()

По теореме умножения вероятностей:

pi,j

= rj

* p(xi

/

yj)

– подставим в

![]()

![]()

![]() ;

; ![]()

Частная информация как и полная, не может быть отрицательной величиной. Для вычисления частной информации через совместные вероятности используют преобразования.

![]() ,

тогда

,

тогда ![]()

Пример: Система X и Y характеризуется таблицей вероятностей.

-

Определить частную информацию о системе х, содержащуюся в сообщении y1.

xi & yi

x1

x2

rj

y1

0.1

0.2

0.3

y2

0.3

0.4

0.7

pi

0.4

0.6

![]() бит

бит

Частная информация о событии, получаемая в результате сообщения о другом событии.

![]()

Если

вероятность события pi

увеличивает

вероятность, т.е. p(xi,

yj)

больше pi,

то информация

больше нуля (![]() ).

В противном случае, информация

).

В противном случае, информация![]() .

.

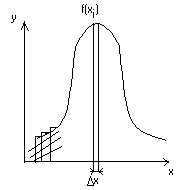

Энтропия и информация для систем с непрерывным множеством состояний

Существуют непрерывные системы. Например, время безотказной работы прибора, координаты точки попадания при выстреле.

Рассмотрим систему х, которая определяется непрерывной случайной величиной х с плотностью распределения f(x).

Определим энтропию системы. Заменим непрерывную кривую f(x) ступенчатой.

Площади прямоугольников f(xi)*x – вероятности попадания в них случайных величин.

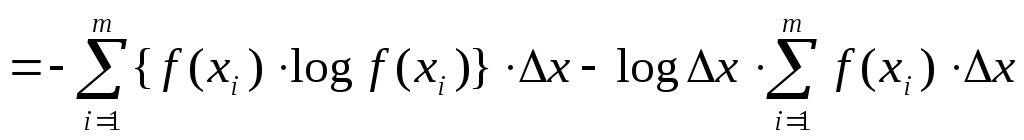

Энтропия системы:

![]()

При

достаточно малых

![]() сумму

можно заменить интегралами

сумму

можно заменить интегралами

![]()

![]() ,

т.к. интеграл вероятностей, следовательно

,

т.к. интеграл вероятностей, следовательно

![]() -

энтропия непрерывной системы

-

энтропия непрерывной системы

Когда

величина![]() ,

особый случай. В этом случае

,

особый случай. В этом случае![]() и

и

![]() ,

т.е. чем выше точностьопределения

состояния системы, тем выше неопределённость

(H(x)).

,

т.е. чем выше точностьопределения

состояния системы, тем выше неопределённость

(H(x)).

![]() -

приведённая

энтропия

-

приведённая

энтропия