- •Сибирская Аэрокосмическая Академия

- •Статический метод

- •Энтропия и её свойства

- •Энтропия сложной системы

- •Условная энтропия. Объединение зависимых систем.

- •Полная условная энтропия

- •Теорема сложения энтропий

- •Определение информационных потерь в каналах связи

- •Энтропия и информация

- •Взаимная информация

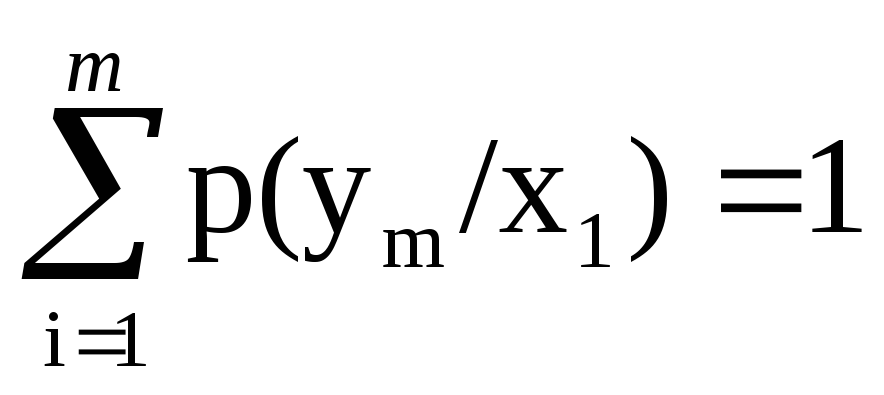

- •Сумма равна единице

- •Частная информация о системе

- •Частная информация о событии, получаемая в результате сообщения о другом событии.

- •Энтропия и информация для систем с непрерывным множеством состояний

- •Условная энтропия непрерывной системы

- •Количественное определения избыточности

- •Блочное кодирование

- •Избыточность от округления

- •1 Символ – 4 бита

- •Код Хафмана

- •Процедура кодирования

- •Передача информации по дискретным каналам связи

- •Основная теорема Шеннона о кодировании для дискретного канала без помех

- •Дискретный канал с помехами

- •Теорема о кодировании Шеннона для дискретного канала с помехами

- •Корректирующие коды

- •Исправление ошибок с помощью полной кодовой таблицы

- •Разбиение

- •Систематические коды

- •Декодирование систематических кодов

- •Код Хэминга

- •Декодирование кода Хэминга

- •Особенности декодирования.

- •Циклические коды

- •Декодирование циклических кодов

- •Построение декодированного конкретного циклического кода

- •Обнаружение и определение ошибок

- •Коды, обнаруживающие трёхкратные ошибки

Определение информационных потерь в каналах связи

Производится с помощью вычисления условной энтропии. Составляется канальная матрица. Пусть по каналу связи источником информации передаются сигналы x1, x2, …, xm . На другом конце канальной связи существует приёмник, который принимает сигнал y1, y2, …, ym . В канале существуют помехи. Правильный приём - если послан сигнал x1 и принят сигнал y1. Если послан сигнал х1, а принят yj - ошибка приёма.

Влияние помех описывается с помощью канальной матрицы - таблицы.

-

x

сумма всех вероятностей

условные вероятности

i & yjy1

y2

yi …

ym

x1

x1p(y1/x1)

p(y2/x1)

p(yj/x1)

p(ym/x1)

x2

p(y1/x2)

p(y2/x2)

p(yj/x2)

p(ym/x2)

xi

…

p(y1/xi)

…

p(y2/xi)

…

p(yj/xi)

…

p(ym/xi)

…

xm

p(y1/xm)

p(y2/xm)

p(yi/xm)

p(ym/xm)

Правильный приём

Вероятности стоящие на главной диагонали выражают правильный приём, а остальные ошибочный. Если в канале нет помех, то главная диагональ состоит из единиц, а остальные нуль. Если влияние помех очень большое, то вероятности стоящие на одной строке одинаковые. Данная канальная матрица указывает влияние помех со стороны источника сообщений, они используются для исследования помех со стороны источника.

Потери информации, которые приходятся на сигнал x1 можно подсчитать, как условную частную энтропию.

![]() -

подсчёт потерь

-

подсчёт потерь

При передачи всех сигналов, общие потери определятся как полная условная энтропия.

их вероятности потери

![]()

Вероятности по столбцам полную группу не образуют.

Если исследуется канал со стороны приёмника, то канальная матрица имеет другой вид:

-

xi & yi

y1

y2

yi …

ym

x1

p(y1/x1)

p(y2/x1)

p(yi/x1)

p(ym/x1)

x2

p(y1/x2)

p(y2/x2)

p(yi/x2)

p(ym/x2)

xi

…

p(y1/xi)

…

p(y2/xi)

…

p(yi/xi)

…

p(ym/xi)

…

xm

xmp(y1/xm)

p(y2/xm)

p(yi/xm)

p(ym/xm)

(по столбцам) образ-т правильный приём

полную группу событий

![]()

Вероятности, стоящие на главной диагонали выражают правильный приём. Вероятности, которые стоят по столбцам, образуют полную группу событий.

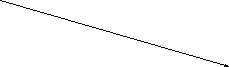

Пример: Влияние помех в канале связи описывается канальной матрицей. Требуется вычислить потери при передачи сигналов, если вероятность появления сигналов следующая:

p(x1) = 0.7 p(x2) = 0.2 p(x3) = 0.1

H(y / x) = -[0.7 * (0.98 log 0.98 + 2*0.01 log 0.01) + 0.2 * (0.15 log 0.15 + 0.75 log 0.75 + 0.1 log 0.1) + 0.1 * (0.3 log 0.3 + 0.2 log 0.2 + 0.5 log 0.5)] = 0.463 бит/символ .

Энтропия и информация

Пусть имеется система X с энтропией H(x). После получении информации о состоянии системы; система полностью определилась, т.е энтропия равна нулю, следовательно, информация, получаемая в результате выяснения состояния системы x равна уменьшению энтропии.

Ix = H(x) – 0 = H(x)

Количество информации приобретённое при полном выяснении состояния системы равна энтропии.

![]() -

часть информации о системе

-

часть информации о системе

![]() -

называют частной

информацией о системе или информацией

от отдельного сообщения.

-

называют частной

информацией о системе или информацией

от отдельного сообщения.

Для системы с равновозможными состояниями

![]()

Полная информация

![]()

Пример: На шахматной доске в одной из клеток поставлена фигура. Вероятность нахождения фигуры на любой клетке одинакова. Определить информацию, получаемую от сообщения о нахождении фигуры в какой-либо клетке.

Ix = log 64 = 6 бит

Пример 2: Определить частную информацию от сообщения о нахождении фигуры в одной из четырёх клеток.

P

=

![]() ;

- вероятность сообщения

;

- вероятность сообщения![]() = 4бит

= 4бит

Пример 3: Определить частную информацию, содержащаяся в сообщении случайного лица о своём дне рожденье.

![]() -

вероятность полученного сообщения;

-

вероятность полученного сообщения; ![]() бит – количество

информации

бит – количество

информации

Пример 4: Определить полную информацию от сообщения о дне рождения случайного лица.

x1

–

день рожденье ![]()

x2

– не

день рожденье ![]()

![]() бит

бит

Пример 5: По цели может быть произведено n выстрелов. Вероятность поражения цели при каждом выстреле p. После k-ого выстрела (1 к n) производятся разведка, сообщение поражена или не поражена цель. Определить к при условии, чтобы количество информации, доставляемая разведкой была максимальной.

xk – система (цель после к-ого выстрела) имеет два состояния:

x1 – цель поражена;

x2 – промах

p1 = 1 – (1 - p)k p2 = (1 - p)k

Информация будет максимальна, когда p1 = p2, следовательно

1

– (1 - p)k

= (1 - p)k

,

k =

![]()

p = 0.2; к = 3