ОТС 2 курс 2 семестр / ОТС 5

.docxМинистерство цифрового развития, связи и массовых коммуникаций

Федеральное государственное бюджетное образовательное учреждение высшего образования

«Поволжский государственный университет телекоммуникаций и информатики»

Факультет Базового телекоммуникационного образования

Направление

(специальность) Инфокоммуникационные технологии и системы связи

Предмет Общая теория связи

Лабораторная работа

Информационные характеристики дискретных источников

Выполнили студенты группы ИКТп – 91 Ядринцев С.

Махов Н.

Яковеннко А

Фамилия инициалы

Бригада № 5

Самара 2021г.

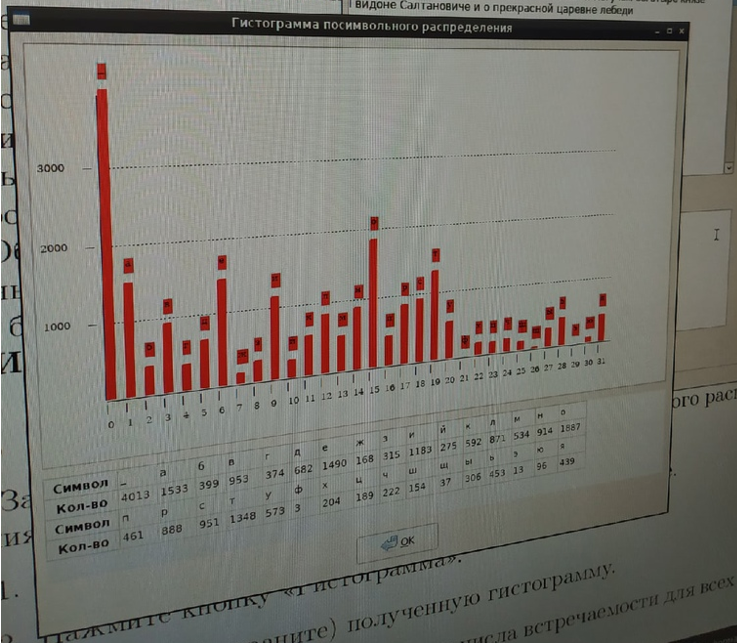

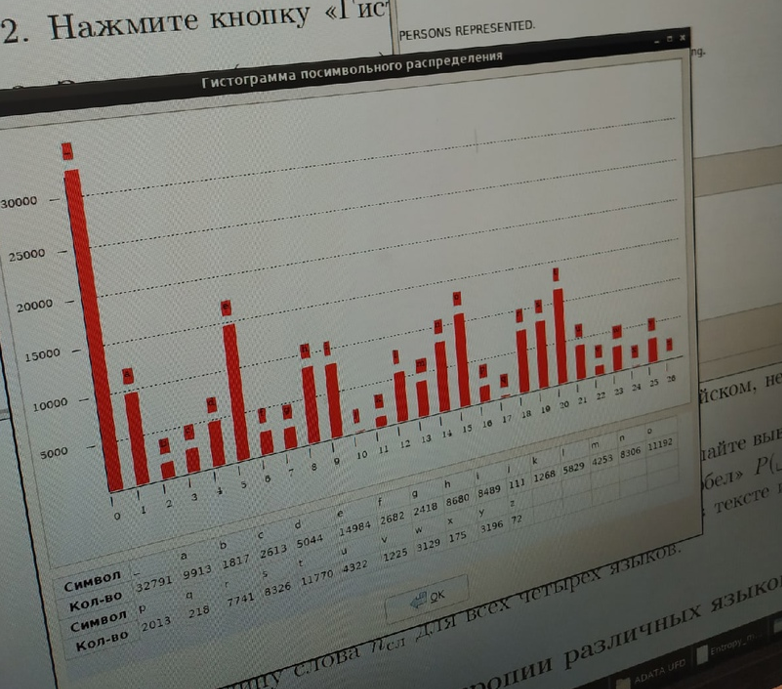

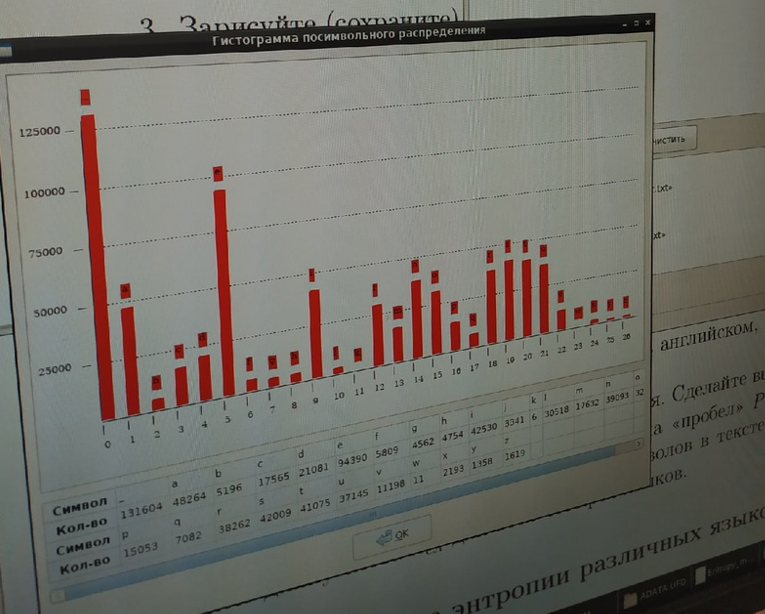

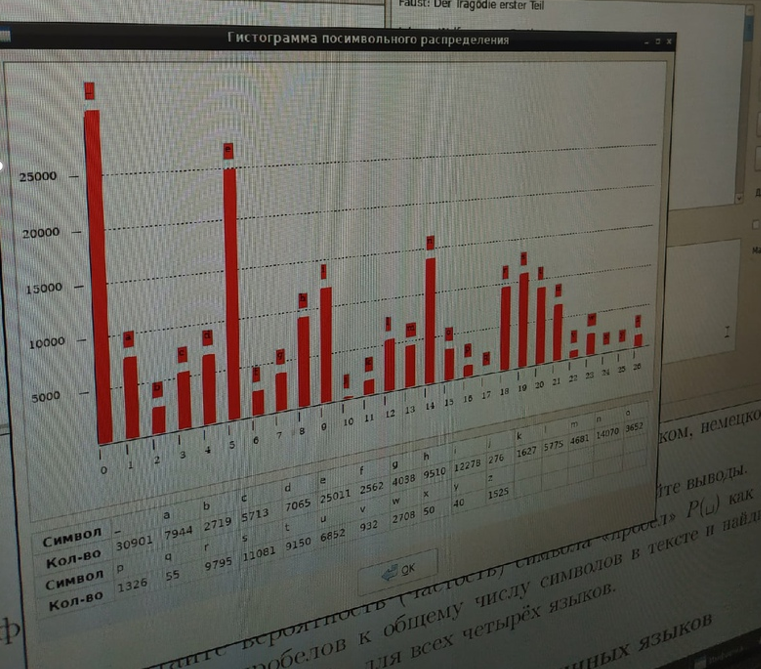

Снятие гистограмм распределения

Пушкин – Дубровский

Шекспир - Гамлет

Ницше – Зарастустра

Дюма – Монте-Кристо

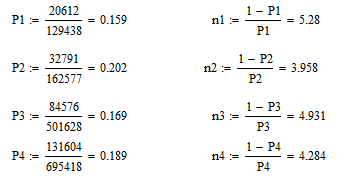

Расчёт частости пробела и средней длины слова

Исследование энтропии различных сигналов

Русский язык:

Длина n- граммы, n [симв] |

Энтропия n-граммы, H(An) [бит/симв] |

Удельная энтропия, H(An)/n [бит/симв] |

Условная энтропия, H(A|A’n−1) [бит/симв] |

1 |

4.37 |

4.37 |

- |

2 |

7.91 |

3.96 |

3.54 |

3 |

10.77 |

3.59 |

2.86 |

4 |

12.88 |

3.22 |

2.11 |

5 |

14.35 |

2.87 |

1.47 |

Английский:

Длина n- граммы, n [симв] |

Энтропия n-граммы, H(An) [бит/симв] |

Удельная энтропия, H(An)/n [бит/симв] |

Условная энтропия, H(A|A’n−1) [бит/симв] |

1 |

4.07 |

4.07 |

- |

2 |

7.37 |

3.69 |

3.3 |

3 |

10.00 |

3.33 |

2.63 |

4 |

12.05 |

3.01 |

2.05 |

5 |

13.66 |

2.73 |

1.61 |

Немецкий:

Длина n- граммы, n [симв] |

Энтропия n-граммы, H(An) [бит/симв] |

Удельная энтропия, H(An)/n [бит/симв] |

Условная энтропия, H(A|A’n−1) [бит/симв] |

1 |

4.00 |

4.00 |

- |

2 |

7.13 |

3.56 |

3.13 |

3 |

9.60 |

3.20 |

2.47 |

4 |

11.59 |

2.90 |

1.99 |

5 |

13.26 |

2.65 |

1.67 |

Французский:

Длина n- граммы, n [симв] |

Энтропия n-граммы, H(An) [бит/симв] |

Удельная энтропия, H(An)/n [бит/симв] |

Условная энтропия, H(A|A’n−1) [бит/симв] |

1 |

3.95 |

3.95 |

- |

2 |

7.12 |

3.56 |

3.17 |

3 |

9.71 |

3.24 |

2.59 |

4 |

11.81 |

2.95 |

2.10 |

5 |

13.54 |

2.71 |

1.73 |

Вывод: чем больше длина n-граммы, тем больше значение энтропии и меньше удельная и условная энтропия.

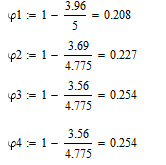

Расчёт избыточности для каждого языка:

Вывод: был произведён анализ информационных характеристик дискретных источников. Избыточность представленных языков, в данных текстах, примерно одинакова, также в данных языках наиболее часто встречающиеся звуки - гласные. Для передачи дискретного сообщения лучше использовать более длинную n-грамму.

Генератор случайных текстов

n = 1

т_иовп_оовкюхосис_еоал_кывааоя_зуо_лынаштм__сьзаиинсрдп_ггмвыэ_рвмраотывеяоаиал_арралиаяио_свьмлке_т

n = 2

хл_кугол_тегогаст_уконнесьшата_прелазатотномострахотрависки_би_товуроеве_чачаю_с_ый_уколо_и_кне_зней

n = 3

ачь_он_ком_увестоялишные_перски_гелаториех_скихо_провелона_менязалемся_кириных_гересчала_отоян_тросл

n = 4

и_повторовники_и_радобратясь_дела_нибудержа_он_у_ко_у_кистие_от_за_его_ста_друг_он_произненном_дубро

n = 5

ад_густал_и_прохожих_не_упое_а_из_здесь_к_бедное_обиду_куше_его_ему_маша_заметил_вытащились_и_тех_же

Вывод: при увеличении значения n программа начинает выдавать слова, наиболее близкие к исходному тексту.

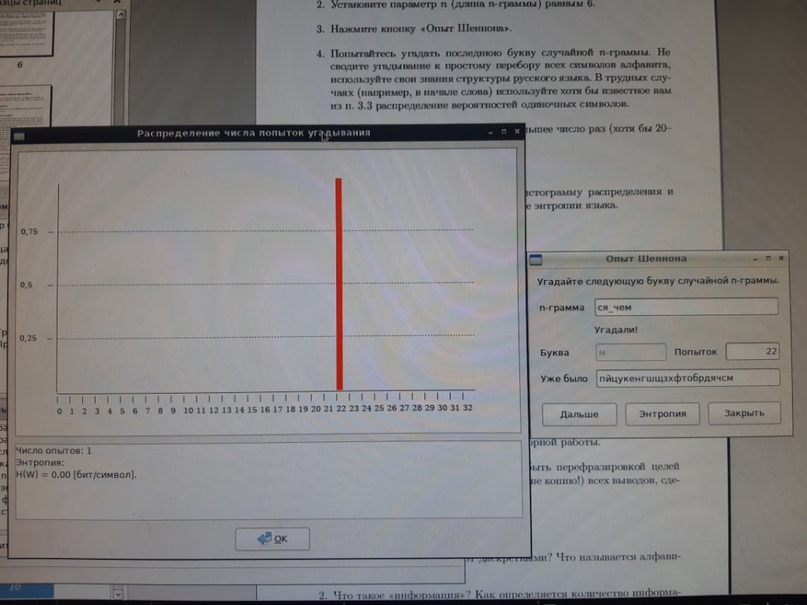

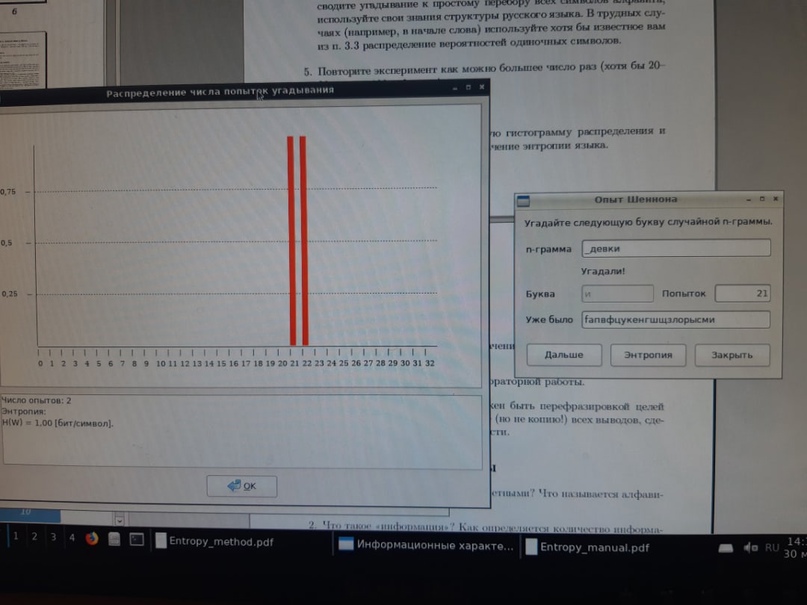

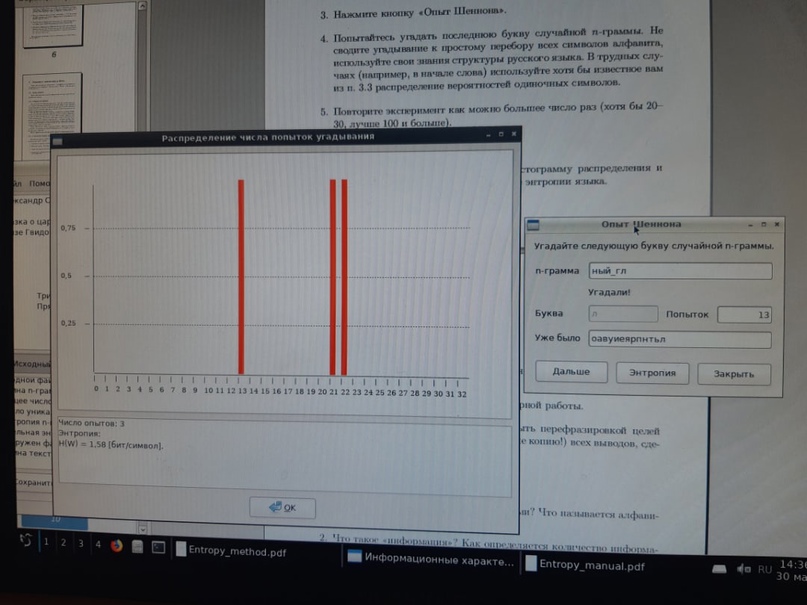

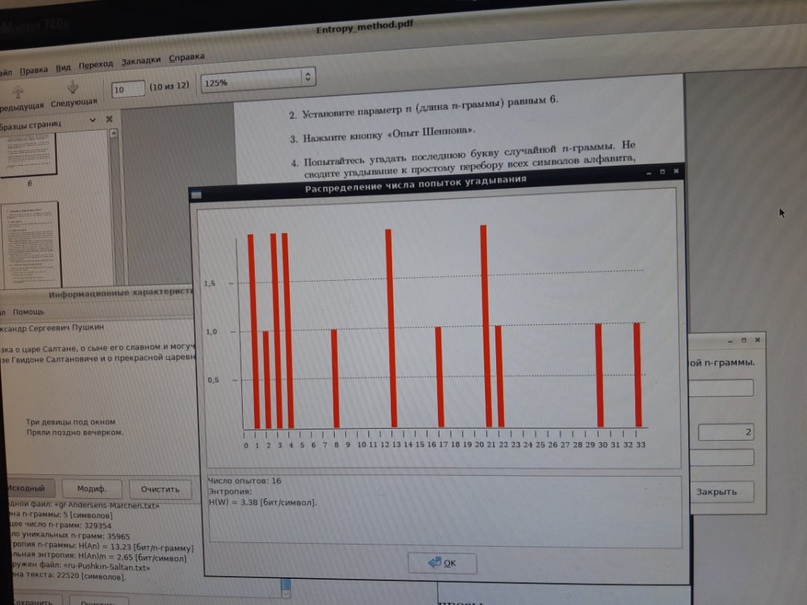

Опыт Шеннона

Вывод: при увеличении числа опытов энтропия увеличивается.