- •Оглавление

- •Искусственные нейронные сети (инс) Строение биологического нейрона

- •Биологический нейрон и его состав.

- •Искусственный нейрон и его состав.

- •Как работают нейросети (почему они могут решать задачи) 2 2 2

- •Синапсы

- •Уровень сложности нейросетей

- •6. Возможности компьютерного моделирования нейронных сетей.

- •7. Скорости обработки информации реализациями инс и мозгом человека

- •Классификация проблем по сложности

- •8. Типы задач, решаемых с помощью искусственных нейронных сетей (инс). Задачи, решаемые с помощью инс

- •12. Преимущества и недостатки нейронных сетей

- •Устойчивость к шумам входных данных

- •Адаптация к изменениям

- •3. Отказоустойчивость

- •Сверхвысокое быстродействие

- •Недостатки нейронных сетей

- •Ответ инс всегда приблизительный

- •Невозможно многошаговое принятие решений

- •27. Решение задачи принятия решения с помощью инс

- •3. Неспособность решать вычислительные задачи

- •3.Разновидности функций активации искусственного нейрона

- •1. Единичная ступенчатая функция

- •Сигмоидальная функция

- •4.Логистическая функция активации и ее преимущества.

- •3. Гиперболический тангенс

- •9. Виды инс

- •10. Инс со свойством кратковременной памяти.

- •60. Искусственные нейронные системы со свойством кратковременной памяти

- •Обучение нейронной сети

- •11. Обучение инс с учителем и без учителя

- •13. Состав персептрона Розенблатта

- •14. Значения выходов сенсоров, r-элементов, s-a и a-r связей в персептроне.

- •5. Нейронная сеть человека и ее оценки.

- •Разновидности персептронов.

- •19. Классификация персептронов

- •16. Отличие однослойного персептрона от искусственного нейрона

- •17. Задачи, решаемые с помощью персептронов.

- •18. Теоремы Розенблатта и условия их выполнения. Теорема Розенблатта.

- •Вторая теорема Розенблатта.

- •20. Линейная разделимость

- •22. Прикладные возможности нейронных сетей

- •23. Решение задач классификации и распознавания образов с помощью инс

- •24. Решение задач прогнозирования с помощью инс

- •25. Решение задач идентификации и управления динамическими процессами

- •26. Решение задач ассоциации с помощью инс

- •28. Черты искусственного интеллекта в нейронных сетях.

- •Модели нейронов и методы их обучения

- •29. Персептрон МакКаллока-Питса

- •30. Обучение персептрона. Правило Видроу-Хоффа

- •31. Сигмоидальный нейрон

- •32. Нейрон типа «адалайн»

- •33. Сеть мадалайн

- •34. Инстар и аутстар Гроссберга

- •35. Нейроны типа wta

- •36. Нейронная сеть типа wta и ее обучение

- •37. Проблема мертвых нейронов

- •38. Модель нейрона Хебба

- •39. Коэффициент забывания при обучении по правилу Хебба

- •40. Обучение линейного нейрона по правилу Ойя

- •41. Однонаправленные многослойные сети сигмоидального типа

- •42. Однослойная сеть. Ограниченность возможностей однослойных сетей

- •43. Решение проблемы нелинейного разделения применением двух линейных разделителей

- •44. Структура инс, выполняющей функцию xor

- •45. Многослойный персептрон

- •46. Алгоритм обратного распространения ошибки

- •47. Этапы алгоритма обратного распространения ошибки

- •48. Градиентные алгоритмы обучения сети

- •50. Математические основы теории радиальных инс

- •51. Простейшая нейронная сеть радиального типа

- •49. Радиальная нейронная сеть

- •52. Отличия радиальной инс от сигмоидальной

- •53. Сравнение радиальных и сигмоидальных инс

- •74. Алгоритм нейронного газа

- •75. Сети с самоорганизацией корреляционного типа

- •76. Нейронные сети рса

- •77. Нейронные ica-сети Херольта-Джуттена

- •Литература

- •Свёрточные нейронные сети

- •54. Сверточные нейронные сети (снс), их особенности и структура

- •Слои свёрточной нейронной сети

- •57. Преимущества снс

- •56. Параметры сверточного слоя в снс

- •55. Алгоритмы обучения снс

Слои свёрточной нейронной сети

Свёрточный слой и Слой субдискретизации

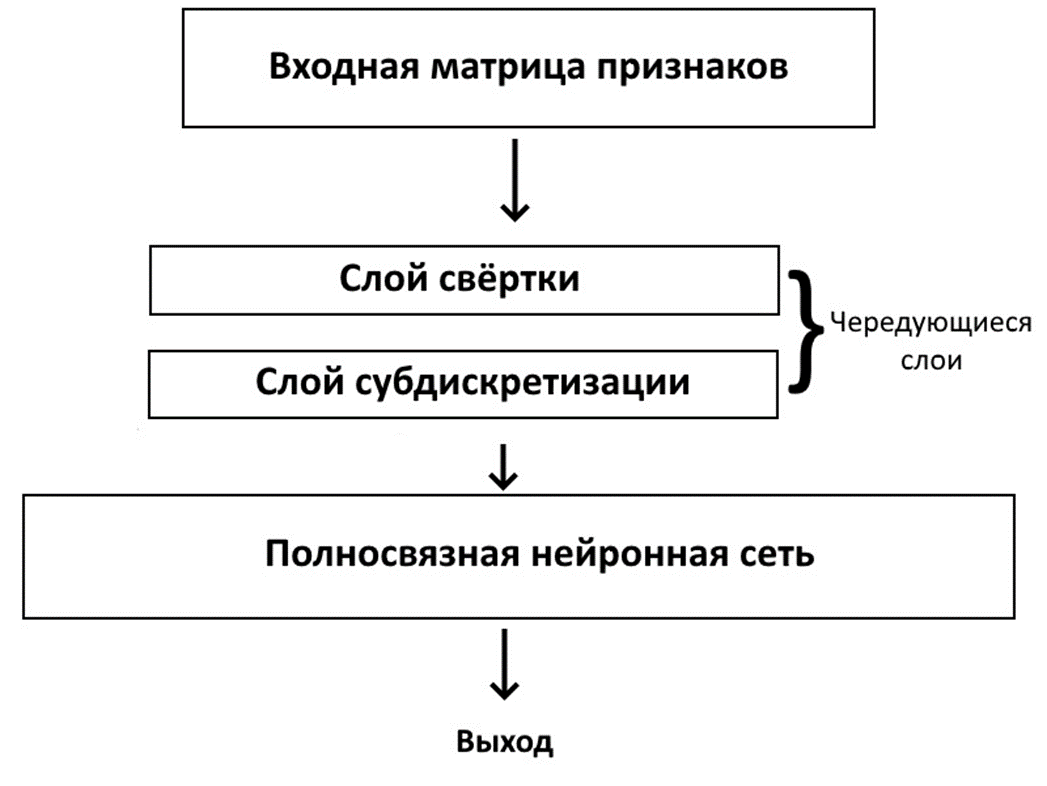

Свёрточная нейронная сеть состоит из следующих слоёв – слоя свёртки и субдискретизации.

Слои свёрточной нейронной сети

Свёрточный слой

Содержит ядро свёртки – матрицу весовых коэффицентов, устанавливающихся в процессе обучения. Этот слой выполняет функцию свёртки, обрабатывая с помощью ядра свёртки предыдущий слой по фрагментам и суммируя результаты матричного произведения для каждого фрагмента и выдаёт на выход карту признаков.

Скалярный результат свёртки попадает на нелинейную функцию активации. Часто в качестве функции активации в свёрточных нейронных сетях используют функцию ReLU. · rectifier («выпрямитель», ReLU) 𝐹(𝑥)=𝑚𝑎𝑥(0,𝑥)

Слой субдискретизации (пулинга, подвыборки)

Субдискретизация в свёрточных нейронных сетях это выделение наиболее значимых признаков предыдущего слоя и значитльное сокращение размерности последующих слоёв сети.

Этот слой производит нелинейное уплотнение карты признаков путём нелинейного преобразования, в результате чего группа признаков в матрице (как правило размера 2×2) уплотняется до одного элемента.

Процесс свёртки

+

![]()

Обычно свёрточная нейронная сеть состоит из нескольких слоёв свёртки и субдискретизации, за которыми следует слой полносвязной нейронной сети прямого распространения, который является выходным.

Свёрточная нейронная сеть — специальная архитектура искусственных нейронных сетей, предложенная Яном Лекуном и нацеленная на эффективное распознавание образов. Данной архитектуре удаётся гораздо точнее распознавать объекты на изображениях, так как, в отличие от многослойного персептрона, учитывается двухмерная топология изображения. При этом свёрточные сети устойчивы к небольшим смещениям, изменениям масштаба и поворотам объектов на входных изображениях.

Во многом, именно поэтому архитектуры, основанные на свёрточных сетях, до сих пор занимают первые места в соревнованиях по распознаванию образов, как, например, ImageNet.

Почему именно свёрточные сети?

Нейронные сети хороши в распознавании изображений. Причём хорошая точность достигается и обычными сетями прямого распространения, однако, когда речь заходит про обработку изображений с большим числом пикселей, то число параметров для нейронной сети многократно увеличивается. Причём настолько, что время, затрачиваемое на их обучение, становится невообразимо большим.

Так, если требуется работать с цветными изображениями размером 64х64, то для каждого нейрона первого слоя полносвязной сети потребуется 64·64·3 = 12288 параметров, а если сеть должна распознавать изображения 1000х1000, то входных параметров будет уже 3 млн! А помимо входного слоя есть и другие слои, на которых, зачастую, число нейронов превышает количество нейронов на входном слое, из-за чего 3 млн превращаются в триллионы! Такое количество параметров просто невозможно рассчитать быстро ввиду недостаточно больших вычислительных мощностей компьютеров.