- •Оглавление

- •Искусственные нейронные сети (инс) Строение биологического нейрона

- •Биологический нейрон и его состав.

- •Искусственный нейрон и его состав.

- •Как работают нейросети (почему они могут решать задачи) 2 2 2

- •Синапсы

- •Уровень сложности нейросетей

- •6. Возможности компьютерного моделирования нейронных сетей.

- •7. Скорости обработки информации реализациями инс и мозгом человека

- •Классификация проблем по сложности

- •8. Типы задач, решаемых с помощью искусственных нейронных сетей (инс). Задачи, решаемые с помощью инс

- •12. Преимущества и недостатки нейронных сетей

- •Устойчивость к шумам входных данных

- •Адаптация к изменениям

- •3. Отказоустойчивость

- •Сверхвысокое быстродействие

- •Недостатки нейронных сетей

- •Ответ инс всегда приблизительный

- •Невозможно многошаговое принятие решений

- •27. Решение задачи принятия решения с помощью инс

- •3. Неспособность решать вычислительные задачи

- •3.Разновидности функций активации искусственного нейрона

- •1. Единичная ступенчатая функция

- •Сигмоидальная функция

- •4.Логистическая функция активации и ее преимущества.

- •3. Гиперболический тангенс

- •9. Виды инс

- •10. Инс со свойством кратковременной памяти.

- •60. Искусственные нейронные системы со свойством кратковременной памяти

- •Обучение нейронной сети

- •11. Обучение инс с учителем и без учителя

- •13. Состав персептрона Розенблатта

- •14. Значения выходов сенсоров, r-элементов, s-a и a-r связей в персептроне.

- •5. Нейронная сеть человека и ее оценки.

- •Разновидности персептронов.

- •19. Классификация персептронов

- •16. Отличие однослойного персептрона от искусственного нейрона

- •17. Задачи, решаемые с помощью персептронов.

- •18. Теоремы Розенблатта и условия их выполнения. Теорема Розенблатта.

- •Вторая теорема Розенблатта.

- •20. Линейная разделимость

- •22. Прикладные возможности нейронных сетей

- •23. Решение задач классификации и распознавания образов с помощью инс

- •24. Решение задач прогнозирования с помощью инс

- •25. Решение задач идентификации и управления динамическими процессами

- •26. Решение задач ассоциации с помощью инс

- •28. Черты искусственного интеллекта в нейронных сетях.

- •Модели нейронов и методы их обучения

- •29. Персептрон МакКаллока-Питса

- •30. Обучение персептрона. Правило Видроу-Хоффа

- •31. Сигмоидальный нейрон

- •32. Нейрон типа «адалайн»

- •33. Сеть мадалайн

- •34. Инстар и аутстар Гроссберга

- •35. Нейроны типа wta

- •36. Нейронная сеть типа wta и ее обучение

- •37. Проблема мертвых нейронов

- •38. Модель нейрона Хебба

- •39. Коэффициент забывания при обучении по правилу Хебба

- •40. Обучение линейного нейрона по правилу Ойя

- •41. Однонаправленные многослойные сети сигмоидального типа

- •42. Однослойная сеть. Ограниченность возможностей однослойных сетей

- •43. Решение проблемы нелинейного разделения применением двух линейных разделителей

- •44. Структура инс, выполняющей функцию xor

- •45. Многослойный персептрон

- •46. Алгоритм обратного распространения ошибки

- •47. Этапы алгоритма обратного распространения ошибки

- •48. Градиентные алгоритмы обучения сети

- •50. Математические основы теории радиальных инс

- •51. Простейшая нейронная сеть радиального типа

- •49. Радиальная нейронная сеть

- •52. Отличия радиальной инс от сигмоидальной

- •53. Сравнение радиальных и сигмоидальных инс

- •74. Алгоритм нейронного газа

- •75. Сети с самоорганизацией корреляционного типа

- •76. Нейронные сети рса

- •77. Нейронные ica-сети Херольта-Джуттена

- •Литература

- •Свёрточные нейронные сети

- •54. Сверточные нейронные сети (снс), их особенности и структура

- •Слои свёрточной нейронной сети

- •57. Преимущества снс

- •56. Параметры сверточного слоя в снс

- •55. Алгоритмы обучения снс

40. Обучение линейного нейрона по правилу Ойя

Нестабильность правила Хебба в процессе обучения можно устранить ограничением вектора весов за счет операции ренормализации, т.е. таким подбором пропорционального коэффициента α на каждом шаге обучения, чтобы w’= αw при ||w’||=1. Этот метод достаточно сложен и требует дополнительных трудозатрат на этапе обучения.

Е.Ойя модифицировал

правило Хебба таким образом, что и без

ренормализации процесса обучения вектор

весов самостоятельно стремится к

||w||=1.

В соответствии с правилом Ойи уточнение

весов производится согласно выражению

![]() (38)

(38)

Это правило напоминает обратное распространение, поскольку сигнал хi модифицируется обратным сигналом, связанным с выходным сигналом y нейрона. Для каждого отдельно взятого нейрона правило Ойя может считаться локальным, так как в процессе модификации хi принимается во внимание только тот весовой коэффициент, значение которого подбирается в текущий момент времени.

Доказательство

ограниченности весов, уточняемых по

правилу Ойя, можно получить, заменяя

скалярное выражение (38) векторной формой,

которая с учетом упрощения η=1

и в соответствии с (38) приобретает

вид: ![]() (39)

(39)

Стабильность процесса обучения достигается, когда при достаточно длительном обучении обеспечивается ||Δw||=0, т. е.

![]() (40)

(40)

Результат применения правила Ойя

Итак, доказательство ограниченности весов, уточняемых по правилу Ойя, можно получить, заменяя скалярное выражение (38)

векторной формой (39)

Стабильность процесса обучения достигается, когда при достаточно длительном обучении обеспечивается ||Δw||=0, т. е.

(40)

Если собственное значение корреляционной матрицы С обозначить λ, а вектор w подбирать как связанный с ней собственный вектор, то по определению собственного значения имеем Cw = λw. Подставляя это выражение в формулу (39), получаем

![]() (41)

(41)

Из (41) следует, что применение для обучения модифицированного правила Хебба приводит к ограничению модуля вектора w единицей

| w | =1, обеспечивающему ограниченность значений весовых коэффициентов.

Стохастическая модель нейрона

В отличие от всех детерминированных моделей, определенных ранее, в стохастической модели выходное состояние нейрона зависит не только от взвешенной суммы входных сигналов, но и от некоторой случайной переменной, значения которой выбираются при каждой реализации из интервала (0,1).

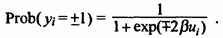

![]() В

стохастической модели нейрона выходной

сигнал yi

принимает

значения ±1 с вероятностью Prob(yi

= ±1) =

1/(1+exp(±2βui)),

где ui

обозначена

взвешенная сумма входных сигналов i-го

нейрона, а β

– это положительная константа, чаще

всего равная 1. Процесс обучения нейрона

в стохастической модели состоит из

следующих этапов:

В

стохастической модели нейрона выходной

сигнал yi

принимает

значения ±1 с вероятностью Prob(yi

= ±1) =

1/(1+exp(±2βui)),

где ui

обозначена

взвешенная сумма входных сигналов i-го

нейрона, а β

– это положительная константа, чаще

всего равная 1. Процесс обучения нейрона

в стохастической модели состоит из

следующих этапов:

Расчет для каждого нейрона сети взвешенной суммы

Расчет вероятности того, что уi принимает значение ±1 в соответствии с формулой

Генерация значения случайной переменной R ϵ (0,1) и формирование выходного сигнала yi = ±1, если R < Prob(yi = ±1) или в противном случае.

Определенный таким образом процесс осуществляется на случайно выбранной группе нейронов, вследствие чего их состояние модифицируется в соответствии с предложенным правилом.

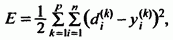

4. После фиксации состояния отобранных нейронов их весовые коэффициенты модифицируются по применяемому правилу уточнения весов. Например, при обучении с учителем по правилу Видроу-Хоффа адаптация весов проводится по формуле

![]()

Доказано, что такой способ подбора весов приводит в результате к минимизации целевой функции, определенной как среднеквадратичная погрешность

рассчитываемая по всем n нейронам и p обучающим выборкам.