- •Оглавление

- •Искусственные нейронные сети (инс) Строение биологического нейрона

- •Биологический нейрон и его состав.

- •Искусственный нейрон и его состав.

- •Как работают нейросети (почему они могут решать задачи) 2 2 2

- •Синапсы

- •Уровень сложности нейросетей

- •6. Возможности компьютерного моделирования нейронных сетей.

- •7. Скорости обработки информации реализациями инс и мозгом человека

- •Классификация проблем по сложности

- •8. Типы задач, решаемых с помощью искусственных нейронных сетей (инс). Задачи, решаемые с помощью инс

- •12. Преимущества и недостатки нейронных сетей

- •Устойчивость к шумам входных данных

- •Адаптация к изменениям

- •3. Отказоустойчивость

- •Сверхвысокое быстродействие

- •Недостатки нейронных сетей

- •Ответ инс всегда приблизительный

- •Невозможно многошаговое принятие решений

- •27. Решение задачи принятия решения с помощью инс

- •3. Неспособность решать вычислительные задачи

- •3.Разновидности функций активации искусственного нейрона

- •1. Единичная ступенчатая функция

- •Сигмоидальная функция

- •4.Логистическая функция активации и ее преимущества.

- •3. Гиперболический тангенс

- •9. Виды инс

- •10. Инс со свойством кратковременной памяти.

- •60. Искусственные нейронные системы со свойством кратковременной памяти

- •Обучение нейронной сети

- •11. Обучение инс с учителем и без учителя

- •13. Состав персептрона Розенблатта

- •14. Значения выходов сенсоров, r-элементов, s-a и a-r связей в персептроне.

- •5. Нейронная сеть человека и ее оценки.

- •Разновидности персептронов.

- •19. Классификация персептронов

- •16. Отличие однослойного персептрона от искусственного нейрона

- •17. Задачи, решаемые с помощью персептронов.

- •18. Теоремы Розенблатта и условия их выполнения. Теорема Розенблатта.

- •Вторая теорема Розенблатта.

- •20. Линейная разделимость

- •22. Прикладные возможности нейронных сетей

- •23. Решение задач классификации и распознавания образов с помощью инс

- •24. Решение задач прогнозирования с помощью инс

- •25. Решение задач идентификации и управления динамическими процессами

- •26. Решение задач ассоциации с помощью инс

- •28. Черты искусственного интеллекта в нейронных сетях.

- •Модели нейронов и методы их обучения

- •29. Персептрон МакКаллока-Питса

- •30. Обучение персептрона. Правило Видроу-Хоффа

- •31. Сигмоидальный нейрон

- •32. Нейрон типа «адалайн»

- •33. Сеть мадалайн

- •34. Инстар и аутстар Гроссберга

- •35. Нейроны типа wta

- •36. Нейронная сеть типа wta и ее обучение

- •37. Проблема мертвых нейронов

- •38. Модель нейрона Хебба

- •39. Коэффициент забывания при обучении по правилу Хебба

- •40. Обучение линейного нейрона по правилу Ойя

- •41. Однонаправленные многослойные сети сигмоидального типа

- •42. Однослойная сеть. Ограниченность возможностей однослойных сетей

- •43. Решение проблемы нелинейного разделения применением двух линейных разделителей

- •44. Структура инс, выполняющей функцию xor

- •45. Многослойный персептрон

- •46. Алгоритм обратного распространения ошибки

- •47. Этапы алгоритма обратного распространения ошибки

- •48. Градиентные алгоритмы обучения сети

- •50. Математические основы теории радиальных инс

- •51. Простейшая нейронная сеть радиального типа

- •49. Радиальная нейронная сеть

- •52. Отличия радиальной инс от сигмоидальной

- •53. Сравнение радиальных и сигмоидальных инс

- •74. Алгоритм нейронного газа

- •75. Сети с самоорганизацией корреляционного типа

- •76. Нейронные сети рса

- •77. Нейронные ica-сети Херольта-Джуттена

- •Литература

- •Свёрточные нейронные сети

- •54. Сверточные нейронные сети (снс), их особенности и структура

- •Слои свёрточной нейронной сети

- •57. Преимущества снс

- •56. Параметры сверточного слоя в снс

- •55. Алгоритмы обучения снс

35. Нейроны типа wta

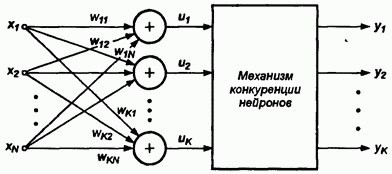

Нейроны типа WTA (англ.: Winner Takes All – Победитель получает все) имеют входной модуль в виде стандартного сумматора, рассчиты-вающего сумму входных сигналов с соответствующими весами wij .

Выходной сигнал i-го сумматора определяется согласно формуле

Группа конкурирующих между собой нейронов (рис. 9) получает одни и те же входные сигналы xj. В зависимости от фактических значений весовых коэффициентов суммарные сигналы ui, отдельных нейронов могут различаться. По результатам сравнения этих сигналов победителем признается нейрон, значение и, у которого оказалось наибольшим. Нейрон-победитель вырабатывает на своем выходе состояние 1, а остальные (проигравшие) нейроны переходят в состояние 0.

Рис. 9. Схема соединения нейронов типа WTA

Для обучения нейронов типа WTA не требуется учитель, оно протекает

аналогично обучению инстара, с использованием нормализованных входных векторов х. На начальном этапе случайным образом выбираются весовые коэффициенты каждого нейрона, нормализуемые относительно 1.

После подачи первого входного вектора х определяется победитель этапа. Победивший в этом соревновании нейрон переходит в состояние 1, что позволяет ему провести уточнение весов его входных линий (по правилу Гроссберга).

Проигравшие нейроны формируют на своих выходах состояние 0, что блокирует процесс уточнения их весовых коэффициентов. Вследствие бинарности значений выходных сигналов конкурирующих нейронов (0 или 1) правило Гроссберга может быть несколько упрощено:

![]()

На функционирование нейронов типа WTA оказывает существенное влияние нормализация входных векторов и весовых коэффициентов. Выходной сигнал ui i-го нейрона в соответствии с формулой (25) может быть описан векторным отношением

![]()

Поскольку ||w||=||x||=1, значение ui определяется углом между векторами w и x: ui = cos φi,

Поэтому победителем оказывается нейрон, вектор весов которого оказывается наиболее близким текущему обучающему вектору х. В результате победы нейрона уточняются его весовые коэффициенты, значения которых приближаются к значениям текущего обучающего вектора х. Если на вход сети будет подаваться множество близких по значениям векторов, побеждать будет один и тот же нейрон. Поэтому его веса станут равными усредненным значениям тех входных векторов, благодаря которым данный нейрон оказался победителем. Проигравшие нейроны не изменяют свои веса. Только победа при очередном представлении входного вектора позволит им произвести уточнение весовых коэффициентов и продолжить процесс обучения в случае еще одной победы.

36. Нейронная сеть типа wta и ее обучение

Нейронная сеть типа WTA

Структура нейронной сети типа WTA показана на рис. 10.

Следствием вышеописанной конкуренции становится самоорганизация процесса обучения. Нейроны уточняют свои веса таким образом, что при предъявлении группы близких по значениям входных векторов победителем всегда оказывается один и тот же нейрон.

В процессе функционирования именно этот нейрон благодаря соперничеству распознает свою категорию входных данных. Системы такого типа чаще всего применяются для классификации векторов.

Рис. 10. Нейронная сеть типа WTA

Процесс обучения нейронной сети типа WTA

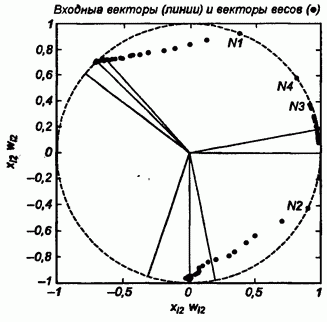

В качестве примера рассмотрим нейронную сеть, состоящую из четырех нейронов типа WTA и предназначенную для классификации входных двухкомпонентных векторов.

Входные обучающие векторы х представлены в нормализованной форме:

Процесс обучения сети представлен на рис. 11. Окружностями обозначены позиции очередных векторов весов тех нейронов, которые побеждали в соревновании.

Рис. 11. Процесс обучения нейронной сети

типа WTA

Можно отметить, что в процессе обучения побеждали только три нейрона. Четвертый нейрон остался мертвым (он не победил ни разу) и не настроился ни на одну категорию векторов.

Результаты обучения и проблемы WTA

При значении коэффициента обучения η=0,05 после 320 обучающих циклов были получены следующие веса трех первых нейронов:

Они отражают три категории входных векторов, на которые было самостоятельно разделено множество исходных данных.