- •1.2.2 Дискретный сигнал

- •Телегра́фный код

- •№ 9 Структурная схема системы передачи информации

- •Классификация

- •81 Пакетов в сети по необходимому адресу, то есть занимается маршрутизацией

- •Ширина спектра и длительность сигнала

- •Асинхронная передача

- •Синхронная передача

- •Дуплексная передача

- •Классификация модемов

- •Приемник состоит из:

- •Телематические службы и услуги. Качество предоставляемых телематических услуг и требования к ним

- •Структурная схема системы Видеотекс изображена на рис.6.

№1

Информация –это новые сведения которые подлежат приему и передаче.

Сообщение-форма представления информации.

Соообщение представленное в виде удобном для передачи на расстояние наз. Сигналом.

В современной науке рассматриваются два вида информации:

Объективная (первичная) информация — свойство материальных объектов и явлений (процессов) порождать многообразие состояний, которые посредством взаимодействий (фундаментальные взаимодействия) передаются другим объектам и запечатлеваются в их структуре[1].

Субъективная (семантическая,смысловая, вторичная) информация – смысловое содержание объективной информации об объектах и процессах материального мира, сформированное сознанием человека с помощью смысловых образов (слов, образов и ощущений) и зафиксированное на каком-либо материальном носителе.

Жизненный цикл сообщения выглядит следующим образом:

Отправитель кодирует идею или мысль в сообщение,

передаёт сообщение через среду общения получателю.

Получатель получает сообщение и декодирует смысл.

Типы сообщений: запрос/вопрос, ответ, команда, повествование, уведомление, предложение.

Сигнал (в теории информации и связи) — материальный носитель информации, используемый для передачи сообщений в системе связи. Сигнал может генерироваться, но его приём не обязателен, в отличие от сообщения, которое должно быть принято принимающей стороной, иначе оно не является сообщением. Сигналом может быть любой физический процесс, параметры которого изменяются в соответствии с передаваемым сообщением.

В теории информации и связи сигналом называется материальный носитель информации, используемый для передачи сообщений по системе связи. Сигналом может быть любой физический процесс, параметры которого изменяются в соответствии с передаваемым сообщением.

№2

1.2.2 Дискретный сигнал

<=""

p="">

<=""

p="">

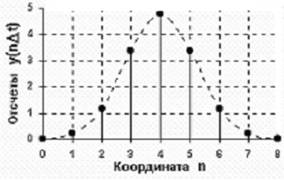

Рисунок 6. Дискретный сигнал.

Дискретный сигнал (discrete signal) по своим значениям также является непрерывной функцией, но определенной только по дискретным значениям аргумента. По множеству своих значений он является конечным (счетным) и описывается дискретной последовательностью отсчетов (samples) y(nt), где y1 y y2, t - интервал между отсчетами (интервал или шаг дискретизации, sample time), n = 0,1,2,...,N. Величина, обратная шагу дискретизации: f = 1/t, называется частотой дискретизации (sampling frequency). Если дискретный сигнал получен дискретизацией (sampling) аналогового сигнала, то он представляет собой последовательность отсчетов, значения которых в точности равны значениям исходного сигнала по координатам nt.

Непрерывные

сигналы характеризуются своим

спектром. Спектр

сигнала —

это эквивалентный ему набор синусоидальных

составляющих (называемых

также гармоникамиили частотными

составляющими).

Спектр сигнала получается разложением

функции, выражающей зависимость формы

сигнала от времени, в ряд

Фурье.

Спектр периодического сигнала —

линейчатый (дискретный), он состоит из

гармоник с кратными частотами. Спектр

непериодического сигнала — непрерывный.

Типичный спектр речевого сигнала показан

на рис. 1.

№3

Особенность доументальной электрой электросвязи состоит в том,что необходимо преобразовать все виды сигналов в код.

Документальной электросвязью называют вид электрической связи,

предназначенной для доставки сообщений, представленных в виде

документов.

№4

Базисным понятием всей теории информации является понятие энтропии. Энтропия – мера неопределенности некоторой ситуации. Можно также назвать ее мерой рассеяния и в этом смысле она подобна дисперсии. Но если дисперсия является адекватной мерой рассеяния лишь для специальных распределений вероятностей случайных величин (а именно – для двухмоментных распределений, в частности, для гауссова распределения), то энтропия не зависит от типа распределения. С другой стороны, энтропия вводится так, чтобы обладать, кроме универсальности и другими желательными свойствами. Так, если некий опыт имеет n равновероятных исходов, а другой опыт m равновероятных исходов, то составной опыт имеет nm таких исходов. Если мы вводим меру неопределенности f , то естественно потребовать, чтобы она была такова, чтобы во-первых, неопределенность росла с ростом числа возможных исходов, а во-вторых, неопределенность составного опыта была равна просто сумме неопределенности отдельных опытов, иначе говоря, мера неопределенности была аддитивной: f(nm)=f(n)+f(m). Именно такая удобная мера неопределенности была введена К. Шенноном:

H(X)=

—![]() P

(Xi)

log P (Xi),

P

(Xi)

log P (Xi),

где Х – дискретная случайная величина с диапазоном изменчивости N, P(Xi) – вероятность i – го уровня X.

Рассматривая

все возможные многоуровневые и многофазные

методы шифрования, теорема Шеннона —

Хартли утверждает, что пропускная

способность канала ![]() ,

означающая теоретическую верхнюю

границу скорости передачи данных,

которые можно передать с данной средней

мощностью сигнала

,

означающая теоретическую верхнюю

границу скорости передачи данных,

которые можно передать с данной средней

мощностью сигнала ![]() через

аналоговый канал связи, подверженный

аддитивному белому гауссовскому шуму

мощности

через

аналоговый канал связи, подверженный

аддитивному белому гауссовскому шуму

мощности ![]() равна:

равна:

![]()

где

— пропускная способность канала, бит/с;

![]() —

полоса пропускания

канала, Гц;

—

полоса пропускания

канала, Гц;

— полная мощность сигнала над полосой пропускания, Вт или В²;

— полная шумовая мощность над полосой пропускания, Вт или В²;

![]() —

частное от деления отношения

сигнала к его шуму (SNR) на

гауссовский шум, выраженное как отношение

мощностей.

—

частное от деления отношения

сигнала к его шуму (SNR) на

гауссовский шум, выраженное как отношение

мощностей.

Одно и то же сообщение можно закодировать различными способами. Оптимально закодированным будем считать такой код, при котором на передачу сообщений затрачивается минимальное время. Если на передачу каждого элементарного символа (0 или 1) тратиться одно и то же время, то оптимальным будет такой код, который будет иметь минимально возможную длину.

№5