Понятие информации

Термин информация происходит от латинского слова informatio, что означает «сведения, разъяснения, изложение». Информация - это настолько общее и глубокое понятие, что его нельзя объяснить одной фразой. В это слово вкладывается различный смысл в технике, науке и в житейских ситуациях. В обиходе информацией называют любые данные или сведения, которые кого-либо интересуют, например сообщение о каких-либо событиях, о чьей-либо деятельности и т. п. «Информировать» в этом смысле означает «сообщить нечто, неизвестное раньше».

|

Информация — сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые воспринимают информационные системы (живые организмы, управляющие машины и др.) в процессе жизнедеятельности и работы. |

Одно и то же информационное сообщение (статья в газете, объявление, письмо, телеграмма, справка, рассказ, чертеж, радиопередача и т. п.) может содержать разное количество информации для разных людей в зависимости от их накопленных знаний, от уровня понимания этого сообщения и интереса к нему. Так, сообщение, составленное на японском языке, не несет никакой новой информации человеку, не знающему этого языка, но может быть высокоинформативным для человека, владеющего японским. Никакой новой информации не содержит и сообщение, изложенное на знакомом языке, если его содержание непонятно или уже известно.

Информация есть характеристика не сообщения, а соотношения между сообщением и его потребителем. Без наличия потребителя, хотя бы потенциального, говорить об информации бессмысленно. В случаях, когда говорят об автоматизированной работе с информацией посредством каких-либо технических устройств, обычно в первую очередь интересуются не содержанием сообщения, а тем, сколько символов это сообщение содержит. Применительно к компьютерной обработке данных под информацией понимают некоторую последовательность символических обозначений (букв, цифр, закодированных графических образов и звуков и т. п.), несущую смысловую нагрузку и представленную в понятном компьютеру виде. Каждый новый символ в такой последовательности символов увеличивает информационный объем сообщения.

Информация может существовать в виде:

текстов, рисунков, чертежей, фотографий;

световых или звуковых сигналов;

радиоволн;

электрических и нервных импульсов;

магнитных записей;

жестов и мимики;

запахов и вкусовых ощущений;

хромосом, посредством которых передаются по наследству признаки и свойства организмов, и т. д.

Предметы, процессы, явления материального или нематериального свойства, рассматриваемые с точки зрения их информационных свойств, называются информационными объектами.

Что можно делать с информацией

создавать |

принимать |

комбинировать |

хранить |

передавать |

копировать |

обрабатывать |

искать |

воспринимать |

формализовать |

делить на части |

измерять |

использовать |

распространять |

упрощать |

разрушать |

запоминать |

преобразовывать |

собирать |

и т. д. |

Все эти процессы, связанные с определенными операциями над информацией, называются информационными процессами.

Существует три основные интерпретации понятия "информация" Научная интерпретация. Информация - исходная общенаучная категория, отражающая структуру материи и способы ее познания, несводимая к другим, более простым понятиям. Абстрактная интерпретация. Информация - некоторая последовательность символов, которые несут как вместе, так в отдельности некоторую смысловую нагрузку для исполнителя. Конкретная интерпретация. В данной плоскости рассматриваются конкретные исполнители с учетом специфики их систем команд и семантики языка. Так, например, для машины информация - нули и единицы; для человека - звуки, образы, и т.п.

Кибернетика

Теория информации рассматривается как существенная часть кибернетики.

Кибернетика — это наука об общих законах получения, хранения, передачи и переработки информации. Ее основной предмет исследования — это так называемые кибернетические системы, рассматриваемые абстрактно, вне зависимости от их материальной природы. Примеры кибернетических систем: автоматические регуляторы в технике, ЭВМ, мозг человека или животных, биологическая популяция, социум.

Часто кибернетику связывают с методами искусственного интеллекта, т. к. она разрабатывает общие принципы создания систем управления и систем для автоматизации умственного труда. Основными разделами (они фактически абсолютно самостоятельны и независимы) современной кибернетики считаются: теория информации, теория алгоритмов, теория автоматов, исследование операций, теория оптимального управления и теория распознавания образов.

Родоначальниками кибернетики (датой ее рождения считается 1948 год, год соответствующей публикации) считаются американские ученые Норберт Винер (Wiener, он — прежде всего) и Клод Шеннон (Shannon, он же основоположник теории информации).

Винер ввел основную категорию кибернетики — управление, показал существенные отличия этой категории от других, например, энергии, описал несколько задач, типичных для кибернетики, и привлек всеобщее внимание к особой роли вычислительных машин, считая их индикатором наступления новой НТР. Выделение категории управления позволило Винеру воспользоваться понятием информации, положив в основу кибернетики изучение законов передачи и преобразования информации.

Сущность принципа управления заключается в том, что движение и действие больших масс или передача и преобразование больших количеств энергии направляется и контролируется при помощи небольших количеств энергии, несущих информацию. Этот принцип управления лежит в основе организации и действия любых управляемых систем: автоматических устройств, живых организмов и т. п. Подобно тому, как введение понятия энергии позволило рассматривать все явления природы с единой точки зрения и отбросило целый ряд ложных теорий, так и введение понятия информации позволяет подойти с единой точки зрения к изучению самых различных процессов взаимодействия в природе.

В СССР значительный вклад в развитие кибернетики внесли академики Берг А. И. и Глушков В. М.

В нашей стране в 50-е годы кибернетика была объявлена лженаукой и была практически запрещена, что не мешало, однако, развиваться всем ее важным разделам (в том числе и теории информации) вне связи с обобщающим словом “кибернетика”. Это было связано с тем, что сама по себе кибернетика представляет собой род философии, в кое-чем конфликтной с тогдашней официальной доктриной (марксистско-ленинской диалектикой).

Теория информации тесно связана с такими разделами математики как теория вероятностей и математическая статистика, а также прикладная алгебра, которые предоставляют для нее математический фундамент. С другой стороны теория информации исторически и практически представляет собой математический фундамент теории связи.

Часто теорию информации вообще рассматривают как одну из ветвей теории вероятностей или как часть теории связи. Таким образом, предмет “Теория информации” весьма узок, т. к. зажат между “чистой” математикой и прикладными (техническими) аспектами теории связи.

Теория информации представляет собой математическую теорию, посвященную измерению информации, ее потока, “размеров” канала связи и т. п., особенно применительно к радио, телеграфии, телевидению и к другим средствам связи. Первоначально теория была посвящена каналу связи, определяемому длиной волны и частотой, реализация которого была связана с колебаниями воздуха или электромагнитным излучением. Обычно соответствующий процесс был непрерывным, но мог быть и дискретным, когда информация кодировалась, а затем декодировалась. Кроме того, теория информации изучает методы построения кодов, обладающих полезными свойствами.

Передача информации

Информация передаётся в виде сообщений от некоторого источника информации к её приёмнику посредством канала связи между ними. Источник посылает передаваемое сообщение, которое кодируется в передаваемый сигнал. Этот сигнал посылается по каналу связи. В результате в приёмнике появляется принимаемый сигнал, который декодируется и становится принимаемым сообщением.

Примеры:

сообщение, содержащее информацию о прогнозе погоды, передаётся приёмнику (телезрителю) от источника — специалиста-метеоролога посредством канала связи — телевизионной передающей аппаратуры и телевизора;

живое существо своими органами чувств (глаз, ухо, кожа, язык и т.д.) воспринимает информацию из внешнего мира, перерабатывает её в определенную последовательность нервных импульсов, передает импульсы по нервным волокнам, хранит в памяти в виде состояния нейронных структур мозга, воспроизводит в виде звуковых сигналов, движений и т.п., использует в процессе своей жизнедеятельности.

Передача информации по каналам связи часто сопровождается воздействием помех, вызывающих искажение и потерю информации.

Всякое событие, всякое явление служит источником информации.

Любое событие или явление может быть выражено по-разному, разным способом, разным алфавитом. Чтобы информацию более точно и экономно передать по каналам связи, ее надо соответственно закодировать.

Информация не может существовать без материального носителя, без передачи энергии. Закодированное сообщение приобретает вид сигналов-носителей информации. Они-то и идут по каналу. Выйдя на приемник, сигналы должны обрести вновь общепонятный вид.

С этой целью сигналы пробегают декодирующее устройство, приобретая форму, удобную для абонента. Система связи сработала, цель достигнута. Когда говорят о каналах связи, о системах связи, чаще всего для примера берут телеграф. Но каналы связи — понятие очень широкое, включающее множество всяких систем, самых разных.

Чтобы ясен был многоликий характер понятия “канал связи”, достаточно привести несколько примеров.

При телефонной передаче источник сообщения — говорящий. Кодирующее устройство, изменяющее звуки слов в электрические импульсы, — это микрофон. Канал, по которому передается информация — телефонный провод. Та часть трубки, которую мы подносим к уху, выполняет роль декодирующего устройства. Здесь электрические сигналы снова преобразуются в звуки. И наконец, информация поступает в “принимающее устройство” — ухо человека на другом конце провода. А вот канал связи совершенно другой природы — живой нерв. Здесь все сообщения передаются нервным импульсом. Но в технических каналах связи направление передачи информации может меняться, а по нервной системе передача идет в одном направлении.

Еще один пример — вычислительная машина. И здесь те же характерные черты. Отдельные системы вычислительной машины передают одна другой информацию с помощью сигналов. Ведь вычислительная машина — автоматическое устройство для обработки информации, как станок — устройство для обработки металла. Машина не создает из “ничего” информацию, она преобразует только то, что в нее введено.

Общая схема передачи информации

Измерение информации

В информатике используются различные подходы к измерению информации:

Содержательный подход к измерению информации. Сообщение – информативный поток, который в процессе передачи информации поступает к приемнику. Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными. Информация - знания человека, сообщение должно быть информативно. Если сообщение не информативно, то количество информации с точки зрения человека = 0. (Пример: вузовский учебник по высшей математике содержит знания, но они не доступны 1-класснику)

Алфавитный подход к измерению информации не связывает кол-во информации с содержанием сообщения. Алфавитный подход - объективный подход к измерению информации. Он удобен при использовании технических средств работы с информацией, т.к. не зависит от содержания сообщения. Кол-во информации зависит от объема текста и мощности алфавита. Ограничений на max мощность алфавита нет, но есть достаточный алфавит мощностью 256 символов. Этот алфавит используется для представления текстов в компьютере. Поскольку 256=28, то 1символ несет в тексте 8 бит информации.

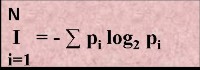

Вероятностный подход к измерения информации. Все события происходят с различной вероятностью, но зависимость между вероятностью событий и количеством информации, полученной при совершении того или иного события можно выразить формулой которую в 1948 году предложил Шеннон.

Количество информации - это мера уменьшения неопределенности.

1 БИТ – такое кол-во информации, которое содержит сообщение, уменьшающее неопределенность знаний в два раза. БИТ- это наименьшая единица измерения информации

Единицы измерения информации: 1байт = 8 бит

1Кб (килобайт) = 210 байт = 1024 байт

1Мб (мегабайт) = 210 Кб = 1024 Кб

1Гб (гигабайт) = 210 Мб = 1024 Мб

Формула

Шеннона

I - количество информации

N – количество возможных событий

pi – вероятности отдельных событий

Количество

информации достигает max значения,

если события равновероятны, поэтому

количество информации можно расcчитать

по формуле ![]()

Формальное представление знаний

При формальном представлении знаний каждому описываемому объекту или понятию ставится в соответствие некоторый числовой код.

Связи между кодируемыми сущностями также представляются кодами (адресами и указателями). Для такого перевода неформальных данных в формальный, цифровой вид должны использоваться специальные таблицы, сопоставляющие кодируемым сущностям их коды и называемые таблицами кодировки. Простейший пример такой таблицы — это ASCII (American Standard Code for Information Interchange), используемая повсеместно с вычислительной техникой. Она сопоставляет печатным и управляющим символам (управляющими являются, например, символы, отмечающие конец строки или страницы) числа от 0 до 127.

Следующая программа на языке Паскаль выведет на экран все печатные символы этой таблицы и их коды:

var i: byte;

begin

for i := 32 to 126 do

write(i:6, chr(i):2);

writeln

end.

На практике обычно используют не сам исходный ASCII, а так называемый расширенный ASCII (ASCII+), описывающий коды 256 символов (от 0 до 255). Первые 128 позиций расширенного ASCII совпадают со стандартом, а дополнительные 128 позиций определяются производителем оборудования или системного программного обеспечения. Кроме того, некоторым управляющим символам ASCII иногда назначают другое значение.

Хотя таблицы кодировки используются для формализации информации, сами они имеют неформальную природу, являясь мостом между реальными и формальными данными. Например, коду 65 в ASCII соответствует заглавная латинская буква A, но не конкретная, а любая.

Этому коду будет соответствовать буква A, набранная жирным прямым шрифтом, и буква A, набранная нежирным с наклоном вправо на 9.5 шрифтом, и даже буква A готического шрифта. Задача сопоставления реальной букве ее кода в выбранной таблице кодировки очень сложна и частично решается программами распознания символов (например, Fine Reader).

Аналоговая и цифровая информация, хранение и обработка

В информатике отдельно рассматривают аналоговую информацию и цифровую. Это важно, поскольку человек благодаря своим органам чувств, привык иметь дело с аналоговой информацией, а вычислительная техника, наоборот, в основном работает с цифровой информацией.

Человек так устроен, что воспринимает информацию с помощью органов чувств. Свет, звук и тепло -- это энергетические сигналы, а вкус и запах - это результат воздействия химических соединений, в основе которого тоже энергетическая природа. Человек испытывает энергетические воздействия непрерывно и может никогда не встретиться с одной и той же их комбинацией дважды. Мы не найдем двух одинаковых зеленых листьев на одном дереве и не услышим двух абсолютно одинаковых звуков -- это информация аналоговая. Если же разным цветам дать номера, а разным звукам -- ноты, то аналоговую информацию можно превратить в цифровую.

Музыка, когда мы ее слышим, несет аналоговую информацию, но стоит только записать ее нотами, как она становится цифровой. Мы легко различим разницу в одной и той же ноте, если исполнить ее на фортепиано и на флейте, хотя на бумаге эти ноты выглядят одинаково.

Разница между аналоговой информацией и цифровой прежде всего в том, что аналоговая информация непрерывна, а цифровая -- дискретна.