- •Введение

- •1. Случайные события и вероятность

- •1.1. Пространство элементарных событий. Случайные события. Алгебра событий

- •1.2. Классическое определение вероятности. Статистическое определение вероятности

- •1.3. Элементы комбинаторики. Некоторые содержательные задачи

- •1.4. Аксиоматическое введение вероятности

- •1.5. Теоремы о вероятностях случайных событий

- •1.6. Формула полной вероятности и формула Байеса

- •1.7. Геометрические вероятности

- •1.8. Схема независимых испытаний Бернулли. Формула Бернулли. Формула Пуассона. Локальная и интегральная теоремы Муавра-Лапласа

- •Вопросы для самопроверки

- •2. Случайные величины

- •2.1. Случайные величины. Случайные величины дискретного типа. Ряд распределения. Функция распределения

- •2.2. Случайная величина непрерывного типа. Плотность вероятности распределения случайной величины

- •2.3. Числовые характеристики случайной величины. Математическое ожидание и дисперсия, их свойства

- •2.4. Пуассоновский поток событий

- •Вопросы для самопроверки

- •3. Системы случайных величин

- •3.1. Закон распределения системы двух случайных величин. Функция распределения, плотность распределения системы двух случайных величин

- •3.2. Условные законы распределения. Зависимые и независимые случайные величины

- •3.3. Числовые характеристики системы двух случайных величин. Корреляционный момент. Коэффициент корреляции

- •Вопросы для самопроверки

- •4. Функции случайных величин

- •4.1. Преобразование случайных величин (случай двух переменных)

- •4.2. Распределение суммы, разности, произведения и частного двух случайных величин

- •4.3. Преобразование случайных величин (случай одной переменной)

- •4.5. Распределение Стьюдента

- •Вопросы для самопроверки

- •5. Закон больших чисел

- •5.1. Неравенства Чебышева

- •5.2. Теорема Чебышева

- •5.3. Теорема Бернулли

- •5.4. Центральная предельная теорема

- •Вопросы для самопроверки

- •6. Случайные процессы. Марковские случайные процессы. Системы массового обслуживания

- •6.1. Случайные процессы

- •6.2. Марковские случайные процессы. Марковские цепи

- •6.3. Марковские процессы с дискретными состояниями и непрерывным временем. Уравнения Колмогорова

- •6.4. Процессы гибели и размножения

- •6.5. Потоки случайных событий

- •6.6. Приложения марковских процессов

- •6.7. Системы массового обслуживания

- •6.8. Системы массового обслуживания с отказами Одноканальная смо с отказами

- •6.9. Системы массового обслуживания с очередями

- •Вопросы для самопроверки

- •7. Математическая статистика

- •7.1. Генеральная совокупность и выборка. Статистический ряд. Статистическая функция распределения. Гистограмма

- •7.2. Точечные оценки параметров генеральной совокупности по выборочным совокупностям, их свойства. Точечные оценки для математического ожидания и дисперсии случайной величины

- •7.3. Интервальные оценки. Доверительный интервал. Нахождение доверительных интервалов для математического ожидания и дисперсии нормального распределения случайной величины

- •1. Доверительный интервал для оценки математического ожидания нормального распределения случайной величины с известным

- •2. Доверительный интервал для оценки математического ожидания нормального распределения с неизвестным

- •3. Доверительные интервалы для оценки среднего квадратического отклонения нормального распределения

- •7.4. Построение прямых линий регрессии по выборочным данным

- •1. Нахождение параметров выборочных уравнений прямой линии регрессии по несгруппированным данным

- •2. Нахождение параметров выборочных уравнений прямой линии регрессии по сгруппированным данным

- •7.5. Нахождение оценки для коэффициента корреляции двух случайных величин

- •7.6. Статистическая проверка гипотез. Статистическая гипотеза. Нулевая и конкурирующая гипотеза. Статистический критерий. Критическая область

- •7.7. Проверка гипотезы о значимости выборочного коэффициента корреляции

- •7.8. Проверка гипотезы о распределении генеральной совокупности. Критерий 2 Пирсона

- •7.10. Сравнение генеральных средних двух нормально распределенных случайных величин (малые независимые выборки)

- •7.11. Сравнение двух дисперсий нормальных генеральных совокупностей

- •7.12. Сравнение наблюдаемой относительной частоты с гипотетической вероятностью наступления события

- •Вопросы для самопроверки

- •8. Варианты контрольной paбoты № 1 по теории вероятностей вариант 1

- •Вариант 2

- •Вариант 3

- •Вариант 4

- •Вариант 5

- •Вариант 6

- •Вариант 7

- •Вариант 8

- •Вариант 9

- •Вариант 10

- •9. Варианты контрольной работы № 2 по случайным процессам и математической статистике вариант 1

- •Вариант 2

- •Вариант 3

- •Вариант 4

- •Вариант 5

- •Вариант 6

- •Вариант 7

- •Вариант 8

- •Вариант 9

- •Вариант 10

- •Приложение

- •Суммарные вероятности для распределения Пуассона

- •Критические точки распределения Стьюдента

- •Библиографический список

6.3. Марковские процессы с дискретными состояниями и непрерывным временем. Уравнения Колмогорова

Пусть переход системы из одного состояния в другое может происходить в любой случайный момент времени. Марковский случайный процесс с дискретными состояниями и непрерывным временем часто называют непрерывной цепью Маркова. В этом случае не имеет смысла говорить о вероятностях перехода из одного состояния в другое, т.к. для любого момента времени t pij(t)=0. Вместо неё вводят плотность вероятности перехода из i-го в j-е состояние по формуле

![]()

Плотность вероятности перехода может быть как постоянной (λij=const), так и зависящей от времени (λij = λij(t)). В первом случае непрерывную цепь Маркова называют однородной, во втором - неоднородной. Простейшим примером однородной непрерывной цепи Маркова является случайный процесс X(t), представляющий собой число наступлений события А (успеха) до момента времени t в простейшем (пуассоновском) потоке событий.

При рассмотрении непрерывных цепей Маркова удобно представлять переходы системы из состояния в состояние как происходящие под влиянием потоков событий; при этом плотность вероятности перехода приобретает смысл интенсивностей λij соответствующих потоков событий. Потоком вероятности перехода из состояния si в состояние sj называется величина λij pi(t).

Для описания непрерывной цепи Маркова введем вероятности состояний

p1(t), p2(t), …,pn(t), (6.3.2)

где pi(t) вероятность того, что система в момент времени t находится в состоянии si. Очевидно, что в любой момент времени

![]() . (6.3.3)

. (6.3.3)

Для нахождения вероятностей состояния нужно решить систему дифференциальных уравнений (уравнений Колмогорова), имеющих вид:

,

i = 1, 2, 3, …, n. (6.3.4)

,

i = 1, 2, 3, …, n. (6.3.4)

В

уравнениях (6.3.4) интенсивности потоков

![]() могут

зависеть от времени t.

могут

зависеть от времени t.

Уравнения Колмогорова (6.3.4) можно составить, пользуюсь размеченным графом состояний и следующим мнемоническим правилом: производная вероятности каждого состояния равна сумме всех потоков вероятности, входящих в данное из других состояний, минус сумма всех выходящих из данного состояния потоков.

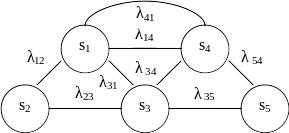

Пример 6.3.1. Пусть граф состояний непрерывной цепи Маркова имеет вид

Рис. 6.3.1.

Составить уравнения Колмогорова.

Решение. Пользуясь вышеуказанным правилом, имеем

![]() ;

;

![]() ;

;

![]() ;

;

![]() ;

;

![]() .

.

Часто возникает вопрос о предельном поведении вероятностей pi(t) при t ∞. В некоторых случаях существуют предельные (финальные) вероятности. Это означает, что со временем устанавливается стационарный режим, в ходе которого система переходит из одного состояния в другое, но вероятности состояний уже не меняются. Финальные вероятности могут быть интерпретированы как среднее относительное время пребывания системы в данном состоянии. В этом случае непрерывная цепь Маркова называется эргодической.

По графу состояний можно определить, существует финальные состояния или нет. Для этого вводятся существенные и несущественные состояния. Впервые такая классификация состояний для цепей Маркова была введена российским математиком А.Н. Колмогоровым.

Состояние si называется несущественным, если существуют такое состояние sj и такое n, что pij(n) > 0, но pji(m) = 0 для всех m. Иными словами, несущественное состояние обладает тем свойством, что из него можно с положительной вероятностью попасть в некоторое другое состояние, но из этого другого состояния вновь вернуться в первоначальное (несущественное) состояние уже нельзя.

Все состояния, отличные от несущественных, называются существенными. Пусть si и sj являются существенными и существуют такие натуральные m и n, что наряду с неравенством pij(m) > 0 выполняется неравенство pji(n) > 0; в этом случае они называются сообщающимися. Очевидно, что если si сообщается с sj, а sj сообщается sk, то si сообщается с sk. Таким образом, все существенные состояния разбиваются на классы ; все существенные состояния , принадлежащие одному классу, сообщаются, а принадлежащие разным классам – не сообщаются между собой. Если все состояния системы существенные, они образуют единственный класс.

Состояние si называют поглощающим, если pii = 1. Если для марковской цепи существует хотя бы одно поглощающее состояние и из любого не поглощающего состояния можно перейти в какое-нибудь поглощающее, цепь Маркова называют поглощающей.

Имеет место следующий результат:

Теорема 6.3.1. Для того, чтобы при конечном числе состояний для непрерывной цепи Маркова существовали предельные вероятности состояний, необходимо и достаточно, чтобы из каждого существенного состояния можно было перейти (за какое-нибудь определенное число шагов) в другое существенное состояние.

Из несущественных состояний система рано или поздно уйдет в одно из существенных состояний и больше в них не вернется. Финальные вероятности для них равны нулю.

Приведем также достаточное условие существования предельных вероятностей.

Теорема 6.3.2. Для существования предельных вероятностей достаточно, чтобы из любого состояния системы можно было (за определенное число шагов) перейти в любое другое.

Финальные вероятности могут быть получены из уравнений Колмогорова, если положить в них производные по времени равными нулю. В этом случае уравнения (6.3.4) можно записать в следующем виде:

![]() ,

i

= 1,2, …, n. (6.3.5)

,

i

= 1,2, …, n. (6.3.5)

Систему линейных алгебраических уравнений (6.3.5), из которых определяются финальные вероятности, можно составить непосредственно, руководствуясь следующим правилом: для каждого состояния суммарный входящий поток равен суммарному выходящему. Чтобы получить единственное решение системы (6.3.5), к ним следует добавить нормированное условие (6.3.3).