- •Введение

- •1. Случайные события и вероятность

- •1.1. Пространство элементарных событий. Случайные события. Алгебра событий

- •1.2. Классическое определение вероятности. Статистическое определение вероятности

- •1.3. Элементы комбинаторики. Некоторые содержательные задачи

- •1.4. Аксиоматическое введение вероятности

- •1.5. Теоремы о вероятностях случайных событий

- •1.6. Формула полной вероятности и формула Байеса

- •1.7. Геометрические вероятности

- •1.8. Схема независимых испытаний Бернулли. Формула Бернулли. Формула Пуассона. Локальная и интегральная теоремы Муавра-Лапласа

- •Вопросы для самопроверки

- •2. Случайные величины

- •2.1. Случайные величины. Случайные величины дискретного типа. Ряд распределения. Функция распределения

- •2.2. Случайная величина непрерывного типа. Плотность вероятности распределения случайной величины

- •2.3. Числовые характеристики случайной величины. Математическое ожидание и дисперсия, их свойства

- •2.4. Пуассоновский поток событий

- •Вопросы для самопроверки

- •3. Системы случайных величин

- •3.1. Закон распределения системы двух случайных величин. Функция распределения, плотность распределения системы двух случайных величин

- •3.2. Условные законы распределения. Зависимые и независимые случайные величины

- •3.3. Числовые характеристики системы двух случайных величин. Корреляционный момент. Коэффициент корреляции

- •Вопросы для самопроверки

- •4. Функции случайных величин

- •4.1. Преобразование случайных величин (случай двух переменных)

- •4.2. Распределение суммы, разности, произведения и частного двух случайных величин

- •4.3. Преобразование случайных величин (случай одной переменной)

- •4.5. Распределение Стьюдента

- •Вопросы для самопроверки

- •5. Закон больших чисел

- •5.1. Неравенства Чебышева

- •5.2. Теорема Чебышева

- •5.3. Теорема Бернулли

- •5.4. Центральная предельная теорема

- •Вопросы для самопроверки

- •6. Случайные процессы. Марковские случайные процессы. Системы массового обслуживания

- •6.1. Случайные процессы

- •6.2. Марковские случайные процессы. Марковские цепи

- •6.3. Марковские процессы с дискретными состояниями и непрерывным временем. Уравнения Колмогорова

- •6.4. Процессы гибели и размножения

- •6.5. Потоки случайных событий

- •6.6. Приложения марковских процессов

- •6.7. Системы массового обслуживания

- •6.8. Системы массового обслуживания с отказами Одноканальная смо с отказами

- •6.9. Системы массового обслуживания с очередями

- •Вопросы для самопроверки

- •7. Математическая статистика

- •7.1. Генеральная совокупность и выборка. Статистический ряд. Статистическая функция распределения. Гистограмма

- •7.2. Точечные оценки параметров генеральной совокупности по выборочным совокупностям, их свойства. Точечные оценки для математического ожидания и дисперсии случайной величины

- •7.3. Интервальные оценки. Доверительный интервал. Нахождение доверительных интервалов для математического ожидания и дисперсии нормального распределения случайной величины

- •1. Доверительный интервал для оценки математического ожидания нормального распределения случайной величины с известным

- •2. Доверительный интервал для оценки математического ожидания нормального распределения с неизвестным

- •3. Доверительные интервалы для оценки среднего квадратического отклонения нормального распределения

- •7.4. Построение прямых линий регрессии по выборочным данным

- •1. Нахождение параметров выборочных уравнений прямой линии регрессии по несгруппированным данным

- •2. Нахождение параметров выборочных уравнений прямой линии регрессии по сгруппированным данным

- •7.5. Нахождение оценки для коэффициента корреляции двух случайных величин

- •7.6. Статистическая проверка гипотез. Статистическая гипотеза. Нулевая и конкурирующая гипотеза. Статистический критерий. Критическая область

- •7.7. Проверка гипотезы о значимости выборочного коэффициента корреляции

- •7.8. Проверка гипотезы о распределении генеральной совокупности. Критерий 2 Пирсона

- •7.10. Сравнение генеральных средних двух нормально распределенных случайных величин (малые независимые выборки)

- •7.11. Сравнение двух дисперсий нормальных генеральных совокупностей

- •7.12. Сравнение наблюдаемой относительной частоты с гипотетической вероятностью наступления события

- •Вопросы для самопроверки

- •8. Варианты контрольной paбoты № 1 по теории вероятностей вариант 1

- •Вариант 2

- •Вариант 3

- •Вариант 4

- •Вариант 5

- •Вариант 6

- •Вариант 7

- •Вариант 8

- •Вариант 9

- •Вариант 10

- •9. Варианты контрольной работы № 2 по случайным процессам и математической статистике вариант 1

- •Вариант 2

- •Вариант 3

- •Вариант 4

- •Вариант 5

- •Вариант 6

- •Вариант 7

- •Вариант 8

- •Вариант 9

- •Вариант 10

- •Приложение

- •Суммарные вероятности для распределения Пуассона

- •Критические точки распределения Стьюдента

- •Библиографический список

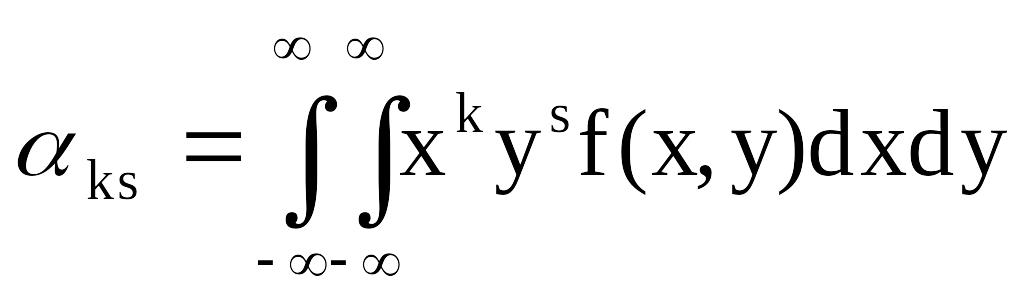

3.3. Числовые характеристики системы двух случайных величин. Корреляционный момент. Коэффициент корреляции

Законы распределения системы случайных величин являются ее исчерпывающими вероятностными характеристиками. Однако в случае, если закон распределения системы неизвестен (или не может быть построен), используют числовые характеристики системы.

Определение

3.3.1. Начальным

моментом

![]() порядка

k+s системы (X,Y) называется математическое

ожидание произведения k-й степени X на

s-ю степень Y:

порядка

k+s системы (X,Y) называется математическое

ожидание произведения k-й степени X на

s-ю степень Y:

![]() . (3.3.1)

. (3.3.1)

Формулы для начальных моментов имеют следующий вид:

- для системы (X,Y) дискретного типа

![]() ; (3.3.2)

; (3.3.2)

- для системы (X,Y) непрерывного типа:

. (3.3.3)

. (3.3.3)

На

практике наиболее употребительными

являются начальные моменты первого

порядка:

![]() ,

,

![]() ,

которые являются математическими

ожиданиями компонент системы (X,Y).

,

которые являются математическими

ожиданиями компонент системы (X,Y).

Точку

![]() называют центром

рассеивания системы на плоскости.

называют центром

рассеивания системы на плоскости.

Определение

3.3.2.

Центральным моментом

![]() порядка k+s системы (X,Y) называется

математическое ожидание произведения

k-й и s-й степеней соответствующих

центрированных величин:

порядка k+s системы (X,Y) называется

математическое ожидание произведения

k-й и s-й степеней соответствующих

центрированных величин:

![]() .

(3.3.4)

.

(3.3.4)

Формулы для вычисления моментов имеют следующий вид:

- для системы (X,Y) дискретного типа

![]() ;

(3.3.5)

;

(3.3.5)

- для системы (X,Y) непрерывного типа

![]() .

(3.3.6)

.

(3.3.6)

Наибольшее применение имеют центральные моменты второго порядка. Два из них представляют собой известные ранее дисперсии величин X и Y:

![]() ,

,

![]() .

.

Особую

роль играет второй смешанный центральный

момент

![]() ,

который называется корреляционным

моментом.

Он обозначается:

,

который называется корреляционным

моментом.

Он обозначается:

![]() . (3.3.7)

. (3.3.7)

Формулы для вычисления корреляционного момента имеют вид:

- для системы (X,Y) дискретного типа

![]() ; (3.3.8)

; (3.3.8)

- для системы (X,Y) непрерывного типа

. (3.3.9)

. (3.3.9)

Корреляционный

момент

![]() характеризует, помимо рассеяния системы

(X,Y) относительно точки рассеивания,

степень связи между компонентами X и Y.

характеризует, помимо рассеяния системы

(X,Y) относительно точки рассеивания,

степень связи между компонентами X и Y.

Определение 3.3.3. Случайные величины X и Y называются некоррелированными, если = 0.

Связь между некоррелированностью и независимостью выражается следующей теоремой.

Теорема 3.3.1. Если случайные величины X и Y независимы, то они некоррелированны.

Доказательство.

Пусть X, Y - независимые случайные величины.

Тогда, используя теорему о математическом

ожидании произведения независимых

случайных величин, имеем

![]() .

Но, очевидно,

.

Но, очевидно,

![]() (и аналогично

(и аналогично

![]() .

Тогда

.

Тогда

![]() .

.

Обратная теорема не имеет места, т. е. из некоррелированности случайных величин X и Y, вообще говоря, не вытекает их независимость.

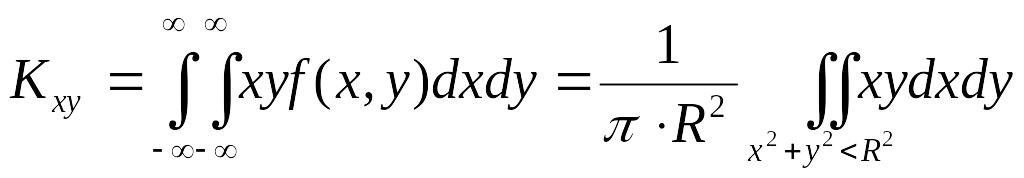

Пример

3.3.1. Пусть

система (X, Y) имеет равномерное распределение

внутри круга

![]() ,

причем

,

причем

![]() .

Тогда

.

Тогда

=

0.

=

0.

Следовательно, случайные величины X и Y некоррелированны. Но, с другой стороны, эти случайные величины являются зависимыми (см. задачу 3.2.2).

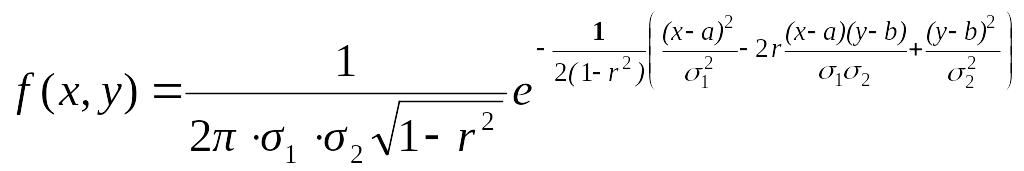

Пример 3.3.2. Показать, что в случае нормального распределения системы (X,Y) из некоррелированности вытекает их независимость.

Действительно, в случае нормального распределения плотность распределения системы имеет вид

.

.

Если компоненты X и Y некоррелированные, то r = 0 и имеет место равенство

,

,

что и означает независимость случайных величин X и Y.

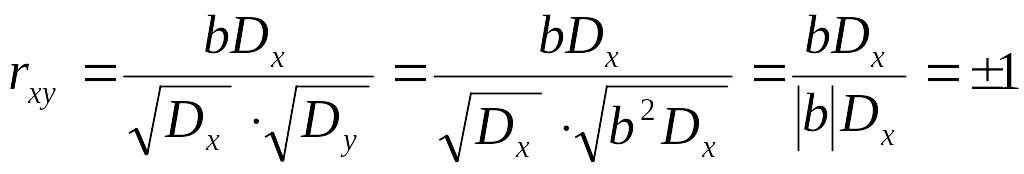

Для оценки степени связи обычно используют безразмерное отношение

![]() ,

(3.3.10)

,

(3.3.10)

которое называется коэффициентом корреляции случайных величин X и Y.

Можно

показать, что

![]() ,

поэтому

,

поэтому

![]() .

Если

.

Если

![]() ,

то говорят, что между X и Y существует

положительная

корреляция;

это означает, что с увеличением значений

одной случайной величины, другая имеет

тенденцию к возрастанию. Если

,

то говорят, что между X и Y существует

положительная

корреляция;

это означает, что с увеличением значений

одной случайной величины, другая имеет

тенденцию к возрастанию. Если

![]() ,

то говорят, что между X и Y существует

отрицательная

корреляция;

это означает, что с увеличением значений

одной случайной величины другая имеет

тенденцию к убыванию. Если

,

то говорят, что между X и Y существует

отрицательная

корреляция;

это означает, что с увеличением значений

одной случайной величины другая имеет

тенденцию к убыванию. Если

![]() ,

это означает, что случайные величины X

и Y некоррелированны.

,

это означает, что случайные величины X

и Y некоррелированны.

Если

между случайными величинами X и Y

существует линейная

зависимость,

то

![]() .

Действительно, пусть

.

Действительно, пусть

![]() .

В этом случае

.

В этом случае

![]() ;

;

![]() .

.

Тогда

.

.

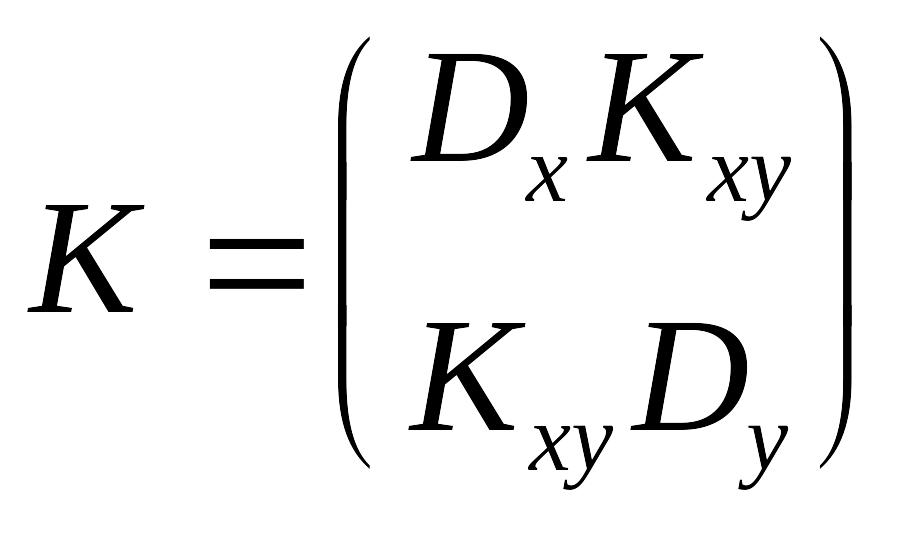

Информацию о связи между компонентами X и Y системы (X,Y) несет корреляционная матрица , которая имеет вид

.

.

Матрица

К является симметричной вследствие

равенства

![]() .

.

Кроме корреляционного момента и коэффициента корреляции , взаимная связь двух случайных величин может быть описана с помощью линий регрессии.

Действительно, при каждом значении Х = х величина Y остается случайной величиной, допускающей рассеяние своих значений, однако зависимость Y от Х сказывается также в изменении средних значений Y при переходе от одного значения X к другому. Эту зависимость и описывает кривая регрессии

![]() .

(3.3.11)

.

(3.3.11)

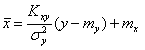

Аналогично, зависимость X от Y, которая сказывается в изменении средних значений X при переходе от одного значения Y = y к другому, описывается кривой регрессии

![]() .

(3.3.12)

.

(3.3.12)

Наиболее простым случаем будет тот, когда обе функции (3.3.11) и (3.3.12) линейны, так что обе линии регрессии будут прямыми линиями; они называются прямыми регрессии. В этом случае будем говорить о линейной корреляции между случайными величинами X и Y.

Выведем

уравнения прямых регрессии. Пусть MX

= mx,

MY

= my,

Dx

=

![]() ,

Dy =

,

Dy = ![]() ,

Kxy

– корреляционный момент случайных

величин X и Y. Будем искать уравнение

прямой регрессии Y на X

в виде

,

Kxy

– корреляционный момент случайных

величин X и Y. Будем искать уравнение

прямой регрессии Y на X

в виде

![]() ,

где параметры A и B подлежат определению.

,

где параметры A и B подлежат определению.

Взяв

математическое ожидание от обеих частей

последнего равенства и учитывая, что

![]() ,

имеем, что

,

имеем, что

![]() .

Далее

.

Далее

![]() ,

откуда

,

откуда

![]() .

.

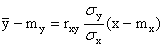

Таким образом, в случае линейной корреляции уравнение прямой регрессии Y на X имеет вид

![]() .

.

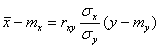

Аналогично уравнение прямой регрессии X на Y имеет вид

.

.

Если

учесть, что

![]() ,

то уравнения прямых регрессии могут

быть переписаны в симметричной форме:

,

то уравнения прямых регрессии могут

быть переписаны в симметричной форме:

; (3.3.13)

; (3.3.13)

.

(3.3.14)

.

(3.3.14)

Из уравнений прямых регрессии (3.3.13) и (3.3.14) видно, что обе прямые проходят через точку (mx,my). Угловые коэффициенты прямых регрессии равны соответственно:

![]() ,

,

![]() .

.

Так

как

![]() ,

прямая регрессии Y на X имеет меньший

угол наклона к оси Ох, чем прямая регрессии

X на Y. Чем ближе

,

прямая регрессии Y на X имеет меньший

угол наклона к оси Ох, чем прямая регрессии

X на Y. Чем ближе

![]() к 1, тем меньше угол между этими прямыми;

при

=

1 прямые регрессии сливаются. При

к 1, тем меньше угол между этими прямыми;

при

=

1 прямые регрессии сливаются. При

![]() прямые регрессии имеют уравнения

прямые регрессии имеют уравнения

![]() и

и

![]() ,

так что обе они параллельны соответствующим

осям координат. В этом случае величины

X и Y являются некоррелируемыми;

для них

,

так что обе они параллельны соответствующим

осям координат. В этом случае величины

X и Y являются некоррелируемыми;

для них

![]() ,

,![]() ,

т. е. условные математические ожидания

совпадают с безусловными.

,

т. е. условные математические ожидания

совпадают с безусловными.