- •Распознавание образов. Общие положения.

- •Объекты в распознавании образов

- •Классификация объектов. Понятие расстояния между объектами.

- •Две группы методов распознавания и их особенности.

- •Разделяющая функция. Решающее правило. Пример разделения на два класса.

- •Линейные разделяющие функции для n классов. 1-ый случай разделения

- •Линейные разделяющие функции для n классов. 2-ой случай разделения

- •Обучение в решении задачи классификации

- •Обучение с учителем и без учителя

- •11. Алгоритм класс-ции на базе контролируемого обучения (к-средних)

- •12. Алгоритм классификации на базе самообучения (Максимин)

- •13. Расстояние между классами (частный случай)

- •14. Расстояние между списками

- •15. Метод динамического программирования

- •16. Классификация объектов вероятностным подходом. Закон Бейеса.

- •17. Решающее правило при вероятностном подходе.

- •18. Разделение объектов на два класса при вероятностном подходе

- •19. Устройство автоматической классификации «Персептрон»

- •20. Критерий коррекции весовых коэф-в для классификации объектов

- •21. Алгоритм классификации объектов на n классов (Персептрон)

- •22. Метод потенциалов

- •23. Иерархическое группирование

- •24. Определение иерархии

- •25. Пример метода иерархической классификации

- •26. Постановка задачи синтаксического распознавания образов. Структурная схема системы распознавания. (V)

- •27. Понятия языка, строки, грамматики. Описание грамматики и ее компонентов.

- •28. Связь между автоматами и грамматиками при синтаксическом распознавании. (V)

- •29. Постановка задачи синтаксического распознавания образов. Грамматический разбор сверху вниз (привести пример) (V)

- •30. Постановка задачи синтаксического распознавания образов. Грамматический разбор снизу вверх (привести пример). (V)

- •31. Применение методов синтаксического распознавания для двумерных объектов. Использование языка описания изображений pdl (привести пример). (V)

- •32. Стохастические грамматики и языки (привести пример).

- •33. Алгоритм вывода цепочечных грамматик. (V)

- •3 Части построения Алгоритма:

- •34. Алгоритм вывода двумерных грамматик.(V)

- •35. Общие понятия систем распознавания

- •36. Проблематика задач создания систем распознавания

- •37. Формулировка задач создания систем распознавания и методы их решения. Задачи 1,2

- •38. Формулировка задач создания ср и их решение. Задачи 3,4

- •39. Формулировка задач создания ср и их решение. Задачи 5,6

- •40. Принципы классификации ср (1, 2)

- •Однородность информации для описания распознаваемых объектов и явлений

- •Способ получения апостериорной информации

- •41. Принципы классификации ср (3, 4)

- •Количество первоначальной априорной информации

- •Характер информации признаках распознавания

- •42. Обучающиеся и самообучающиеся ср (структурные схемы)

- •43. Биологические основы функционирования нейрона

- •44. Принципы построения и действия искусственной нейронной сети

- •45. Инс в виде многослойного персептрона

- •46. Решение задач с помощью нс на базе многослойного персептрона

44. Принципы построения и действия искусственной нейронной сети

Каждый нейрон можно считать своеобразным процессором. Он суммирует веса сигналов, приходящих от других нейронов, выполняет нелинейную решающую функцию и передает результат следующим нейронам.

Искусственная нейронная сеть – это совокупность моделей биологических нейронных сетей. Большинство моделей нейронных сетей требует обучения. В общем случае – это выбор параметров сети, при которых сеть лучше всего решает поставленную задачу.

Обучение – это задача многомерной оптимизации и для её решения существует множество алгоритмов.

Нейронная сеть – средство обработки информации, включающее в себя:

Гибкую модель для нелинейной аппроксимации многомерных функций

Средство прогнозирования во времени для процессов, зависящих от многих переменных

Классификатор по многим признакам, дающий разбиение входного пространства на области

Средство распознавания образов

Инструмент для поиска по ассоциациям

Современные искусственные сети демонстрируют свойства:

Обучаемость. Выбрав одну из моделей сети, построив сеть и обучив её, мы можем решать задачи, схожие с теми, на которых её обучали

Способность к обобщению. После обучения сеть становится нечувствительной к малым изменения входных сигналов (шума или небольших изменений входных образов) и даёт корректный результат на выходе.

Способность к абстрагированию. Если предъявить сети несколько искаженных вариантов входного образа, то она может создать на выходе корректный результат, с которым никогда не встречалась.

К задачам, успешно решаемым нейронной сетью, относят те, которые человек решает лучше, чем машина:

Распознавание различных образов

Ассоциативный поиск информации

Задачи прогнозирования и построения моделей

Ф ормальный

нейрон

ормальный

нейрон

– входные сигналы

– входные сигналы

– весовые коэффициенты

Несмотря на простоту формального нейрона, сети, построенные из таких элементов, могут сформировать произвольную многомерную функцию на выходе.

Нейрон состоит из взвешенного сумматора и нелинейного элемента. Функционирование нейрона определяется формулами:

– взвешенная сумма входных

сигналов. Её значение передается на

нелинейный элемент

– взвешенная сумма входных

сигналов. Её значение передается на

нелинейный элемент

– пороговый уровень

данного нейрона

– пороговый уровень

данного нейрона

- нелинейная функция

активации

- нелинейная функция

активации

Каждый

нейрон имеет несколько входов и 1

выходной сигнал (OUT).

Параметрами нейрона, определяющими его

работу является вектор

Выбор функции определяется

Спецификой задачи

Удобством реализации на вычислительной технике

Алгоритмом обучения

, поскольку некоторые алгоритмы накладывают ограничение на выбор функции активации.

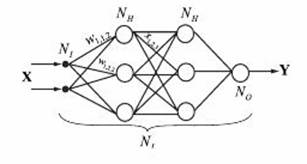

45. Инс в виде многослойного персептрона

Ф ормальные

нейроны могут объединяться в сети

различным образом. Однако, одним из

самых распространённых видов сети стал

многослойный персептрон.

ормальные

нейроны могут объединяться в сети

различным образом. Однако, одним из

самых распространённых видов сети стал

многослойный персептрон.

Сеть состоит из произвольного количества слоёв нейронов. Нейроны каждого слоя соединяются с нейронами предыдущего и последующего слоёв по принципу «каждый с каждым».

Первый слой называется сенсорным или входным. Внутренние слои – скрытыми или ассоциативными. Последний состоит из одного нейрона и называется выходным или результативным слоем. Количество нейронов в слоях может быть произвольным, но для удобства работы во всех скрытых слоях выбирают одинаковое количество нейронов.

Существует разночтение с подсчётом количества слоев в сети. Входной слой не выполняет никаких вычислений, а только распределяет входные сигналы. Поэтому иногда его не учитывают при подсчёте слоев.

Работа многослойного персептрона как абстрактной сети также определяется формулами

– сигнал j-го

нейрона в слое l

– сигнал j-го

нейрона в слое l

– пороговый уровень данного нейрона

- нелинейная функция активации

,

,

, где

, где

– номер входа,

– номер входа,

– номер нейрона

в слое,

– номер нейрона

в слое,

– номер слоя

– номер слоя

Каждый слой сети вычисляет нелинейное преобразование от линейной комбинации сигналов предыдущего слоя. Следовательно, линейная функция активации может применяться только для тех моделей сетей, где не требуется последовательное соединение слоёв нейронов друг за другом. Для многослойных сетей функция активации должна быть нелинейной, иначе можно построить эквивалентную однослойную сеть и многослойность окажется ненужно, т.к. линейная функция активации будет давать на выходе линейную комбинацию входов.

Многослойная сеть может формировать на выходе произвольную многомерную функцию при соответствующем выборе количества слоёв в диапазоне изменения сигналов и параметров нейронов.

В многослойном персептроне нет обратных связей, поэтому такие модели называются сетями прямого распространения. Они не позволяют без дополнительных действий моделировать развитие динамических систем.