- •5 Вопрос.

- •6 Вопрос

- •7 Вопрос.

- •8 Вопроc

- •9 Вопрос

- •10 Вопро.

- •11 Вопрос.

- •12 Вопрос.

- •13 Вопрос

- •14 Вопрос.

- •2. Побуквенное кодирование

- •15 Вопрос. Кодирование звуковой информации

- •Дискретизация звука

- •Характеристики качества звука:

- •1000 Измерений в 1 секунду - 1 кГц

- •8 КГц соответствует частоте радиотрансляции,

- •16 Вопрос.

- •17 Вопрос.

- •18 Вопрос.

- •19 Вопрос.

- •20 Вопрос.

- •21 Вопрос.

- •22 Вопрос.

- •23 Вопрос.

- •24 Вопрос.

- •Виды квантования

- •25 Вопрос.

- •26 Вопрос.

- •27 Вопрос.

- •28 Вопрос.

- •29 Вопрос.

- •30 Вопрос.

- •31 Вопрос.

- •32 Вопрос.

- •Определение

- •Примеры

- •33 Вопрос.

- •34 Вопрос.

- •Пример кодового дерева[править | править исходный текст]

- •35 Вопрос.

- •36 Вопрос.

- •37 Вопрос.

Ответы на вопросы к экзамену.

Вопрос. Информация – это сведения, представленные в форме, пригодные для восприятия субъектом.

Информация для человека имеет смысл и содержание некоторых новых сведений.

Данные - это информация, представленная в виде пригодном для автоматической обработки.

Для компьютерной техники данные – это результат отображения информации, находящейся на каком-либо носителе.

Свойства информации:

Достоверность — информация достоверна, если она отражает истинное положение дел. Недостоверная информация может привести к неправильному пониманию или принятию неправильных решений. Полнота — информация полна, если её достаточно для понимания и принятия решений. Точность — точность информации определяется степенью ее близости к реальному состоянию объекта, процесса, явления и т. п. ; Ценность — ценность информации зависит от того, насколько она важна для решения задачи, а также от того, насколько в дальнейшем она найдёт применение в каких-либо видах деятельности человека; Своевременность — только своевременно полученная информация может принести ожидаемую пользу. Понятность — информация становится понятной, если она выражена языком, на котором говорят те, кому предназначена эта информация; Доступность — информация должна преподноситься в доступной форме. Краткость — информацию по одному и тому же вопросу можно изложить кратко или пространно.

Копирование – размножение информации;

Передача от источника к потребителю;

Перевод с одного языка на другой;

Перенос на другой носитель.

2 Вопрос. Процессы, связанные с поиском, хранением, передачей, обработкой и использованием информации, называются информационными процессами.

1. Поиск. Поиск информации - это извлечение хранимой информации. Методы поиска информации:

непосредственное наблюдение;

общение со специалистами по интересующему вас вопросу;

чтение соответствующей литературы;

просмотр видео, телепрограмм;

прослушивание радиопередач, аудиокассет;

работа в библиотеках и архивах;

запрос к информационным системам, базам и банкам компьютерных данных;

другие методы.

2. Хранение. Хранение информации - это способ распространения информации в пространстве и времени. Способ хранения информации зависит от ее носителя.

3. Передача. В процессе передачи информации обязательно участвуют источник и приемник информации: первый передает информацию, второй ее получает. Между ними действует канал передачи информации - канал связи. Канал связи - совокупность технических устройств, обеспечивающих передачу сигнала от источника к получателю. Кодирующее устройство - устройство, предназначенное для преобразования исходного сообщения источника к виду, удобному для передачи. Декодирующее устройство - устройство для преобразования кодированного сообщения в исходное. В процессе передачи информация может теряться и искажаться: искажение звука в телефоне, атмосферные помехи в радио, искажение или затемнение изображения в телевидении, ошибки при передачи в телеграфе. Эти помехи искажают информацию. Существует наука, разрабатывающая способы защиты информации - криптология.

Каналы передачи сообщений характеризуются пропускной способностью и помехозащищенностью. Каналы передачи данных делятся на симплексные (с передачей информации только в одну сторону (телевидение)) и дуплексные (по которым возможно передавать информацию в оба направления (телефон, телеграф)). По каналу могут одновременно передаваться несколько сообщений. Пропускная способность канала определяется максимальным количеством символов, передаваемых ему в отсутствии помех. Эта характеристика зависит от физических свойств канала. 4. Обработка. Обработка информации - преобразование информации из одного вида в другой, осуществляемое по строгим формальным правилам.

Обработка информации по принципу "черного ящика" - процесс, в котором пользователю важна и необходима лишь входная и выходная информация, но правила, по которым происходит преобразование, его не интересуют и не принимаются во внимание.

"Черный ящик" - это система, в которой внешнему наблюдателю доступны информация на входе и на выходе этой системы, а строение и внутренние процессы неизвестны.

5. Использование. Информация используется при принятии решений.

Достоверность, полнота, объективность полученной информации обеспечат вам возможность принять правильное решение.

Ваша способность ясно и доступно излагать информацию пригодится в общении с окружающими.

Умение общаться, то есть обмениваться информацией, становится одним главных умений человека в современном мире. Компьютерная грамотность предполагает:

знание назначения и пользовательских характеристик основных устройств компьютера;

Знание основных видов программного обеспечения и типов пользовательских интерфейсов;

умение производить поиск, хранение, обработку текстовой, графической, числовой информации с помощью соответствующего программного обеспечения.

6. Защита. Защитой информации называется предотвращение:

доступа к информации лицам, не имеющим соответствующего разрешения;

непредумышленного или недозволенного использования, изменения или разрушения информации.

3 Вопрос.

Сигнал — материальный носитель информации, используемый для передачи сообщений в системе связи. Сигнал используется для передачи данных.

Виды сигнала:

- Аналоговый сигнал - сигнал данных, у которого каждый из представляющих параметров описывается функцией времени и непрерывным множеством возможных значений. Аналоговый сигнал всегда непрерывен и в каждый момент времени может принимать любые значения.

Дискретный сигнал - сигнал, имеющий конечное число значений. Обычно сигналы, передаваемые через дискретные каналы, имеют два или три значения.

4 Вопрос.

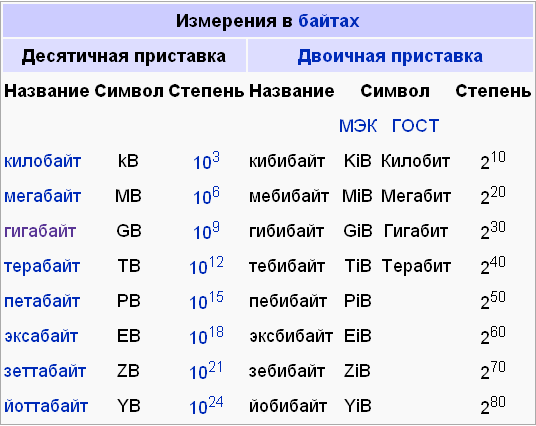

За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность в два раза. Такая единица называется бит. В вычислительной технике битом называют наименьшую "порцию" памяти, необходимую для хранения одного из двух знаков "0" и "1", используемых для внутримашинного представления данных и команд. Бит — слишком мелкая единица измерения. На практике чаще применяется более крупная единица — байт, равная восьми битам. Именно восемь битов требуется для того, чтобы закодировать любой из 256 символов алфавита клавиатуры компьютера (256=28). Широко используются также ещё более крупные производные единицы информации: • 1 Килобайт (Кбайт) = 1024 байт = 210 байт, • 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт, • 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт.

1 Терабайт = 1024 Гб

5 Вопрос.

Вероятностный подход к измерению информации. Все события происходят с различной вероятностью, но зависимость между вероятностью событий и количеством информации, полученной при совершении того или иного события можно выразить формулой которую в 1948 году предложил Шеннон.

Источник сообщений – объект, передающий сообщение по каналу связи.

Сообщение может быть случайным, то есть набор символов распределяется случайным образом. Символы появляются с разными вероятностями.

Источник дискретных сообщений – источник сообщений, который может в любой момент времени принимать одно из конечных возможных состояний.

6 Вопрос

Алфавитный подход - объективный подход к измерению информации. Кол-во информации зависит от объема текста и мощности алфавита.

Мощность алфавита – полное количество символов алфавита.

При алфавитном подходе к измерению информации количество информации зависит не от содержания, а от мощности, объёма текста.

Применение алфавитного подхода удобно при использовании технических средств работы и информации.

7 Вопрос.

Получение новой информации расширяет знания человека. Если какое-либо сообщение уменьшит неопределённость знаний, то можно говорить, что оно содержит информацию.

Информация одного и того же сообщения может быть разной для разных людей.

Чтобы сообщение было информировано, оно в 1-ую очередь должна быть понятна для человека, логически связанная с предыдущими знаниями.

Сообщение несёт информацию, если содержащиеся сведения являются новыми и понятными.

Такой подход является субъективным из за различия предыдущих знаний разных людей.

8 Вопроc

Энтропия — это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

Информационная энтропия — мера неопределённости или непредсказуемости информации, неопределённость появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения.

Впервые понятия энтропия и информация связал К.Шеннон в 1948 [299]. С его подачи энтропия стала использоваться как мера полезной информации в процессах передачи сигналов по проводам. Следует подчеркнуть, что под информацией Шеннон понимал сигналы нужные, полезные для получателя. Неполезные сигналы, с точки зрения Шеннона, это шум, помехи. К.Шеннон стоял на позиции функционалиста . Если сигнал на выходе канала связи является точной копией сигнала на входе то, с точки зрения теории информации, это означает отсутствие энтропии.

9 Вопрос

Алфавит – набор символов, предназначенный для отображения информации.

Алфавит может содержать разное количество символов. Даже один.

Вторичный алфавит имеет 2 знака, это любые символы, но в вычислительной технике знаки – 1 и 0, которые обозначают истину или ложь.

Код – правило, в соответствии с которым символ одного алфавита сопоставляется символу другого алфавита.

Азбука Морзе предполагает, что мы каждому символу другого языка сопоставляем уникальную комбинацию.

Кодирование, операция отождествления символов или групп символов одного кода с символами или группами символов другого кода. Необходимость кодирования возникает прежде всего из потребности приспособить форму сообщения к данному каналу связи или какому-либо другому устройству, предназначенному для преобразования или хранению информации. Так, сообщения, представленные в виде последовательности букв, например русского языка, и цифр, с помощью телеграфных кодов преобразуются в определённые комбинации посылок тока. При вводе в вычислительные устройства обычно пользуются преобразованием числовых данных из десятичной системы счисления в двоичную и т.д..

К. в информации теории применяют для достижения следующих целей: во-первых, для уменьшения так называемой избыточности сообщений и, во-вторых, для уменьшения влияния помех, искажающих сообщения при передаче по каналам связи. Поэтому выбор нового кода стремятся наиболее удачным образом согласовать со статистической структурой рассматриваемого источника сообщений. В какой-то степени это согласование имеется уже в коде телеграфном, в котором чаще встречающиеся буквы обозначаются более короткими комбинациями точек и тире.

В вычислительной технике широко применяется двоичный код. Возникла таблица кодировок, в которой используются двойные и шестнадцатеричные записи кода, но наихудшая обработка данных в двойном коде – байт, в котором содержатся биты.

Наибольший символ может быть любым и его выбирают обусловлено, целесообразно для применения в какой либо области технических устройств.

8 бит – это кодировка для представления десятичных цифр.

Во многих кодировках используется 7 бит, а потом появились более улучшенные.