- •Лекция 10. Способы представления исходной информации в интеллектуальных системах

- •10. 1 Обучение на основе примеров

- •10.2 Типы значений признаков:

- •10.3 Ранговая или порядковая шкала значений признаков

- •10.5 Выборка к-

- •10.6 Кластерный анализ

- •10.6.1 Пример процедуры кластерного анализа: .

- •10.6.2 Диаграмма рассеивания

- •10.6.3 Способы определения меры расстояния между кластерами

- •10.6.4 Работа кластерного анализа опирается на два предположения.

- •10.6.5 Рассмотрим пример.

- •10.6.6 Способы нормирования исходных данных: .

- •10.6.9 Пример вертикальной дендрограммы

- •10.6.10 Методы объединения или связи

- •Метод ближнего соседа или одиночная связь.

- •Метод Варда (Ward's method).

- •Метод наиболее удаленных соседей или полная связь.

- •Метод невзвешенного попарного среднего

- •Метод взвешенного попарного среднего

- •Невзвешенный центроидный метод

- •10.7 Задача обучения «без учителя»

- •10.8 Алгоритм, основанный на понятии порогового расстояния

- •10.8.1 Пример работы алгоритма, основанного на вычислении порогового расстояния.

- •Лекция 11. Алгоритмы обучения без учителя

- •11.1 Алгоритм maxmin

- •11.2 Алгоритм «к средних»

- •11.2.1 Пример работы алгоритма «к средних»

- •11.2.2 Проблемы алгоритма k-средних:

- •11.9. 1 Метод эталонных образов

- •11.9.2 Метод эталонных образов

- •13.2 Программированное обучение. Автор б.Ф. Скиннер

- •13.3 Основные формы программирования

- •13.3.1 Линейная программа

- •13.3.2 Разветвленная форма. Норман а. Кроудер

- •13.4 Автоматизация программированного обучения

- •13.5 Искусственный интеллект

- •13.6 Задача-максимум создания Искусственного Интеллекта

- •13.7 Автоматизированная обучающая система «Контакт»

- •13.8 Аос эвос и атос

- •13.9 Аос садко

- •13.10 Plato

- •13.11 В общем об обучающих системах

- •13.12 Интеллектуальные обучающие системы (иос)

- •13.12.1 Четыре этапа развития иос

- •13.12.2 Принципы организации и реализации интеллектуальных систем электронного обучения

- •13.13. 1 Особенности Образования Web 2.0 или Образования 2.0

- •13.14 Семантический Web (Web 3.0)

- •13.14. 1 Основыне принципы Образования 3.0

- •13.15 Иос на осве субз

- •13.16 Алгоритм муравья

- •13.17 Модель обучения в общем виде

- •13.18 Этапы создания иос от специалистов

- •13.19 Состав группы для разработки иос

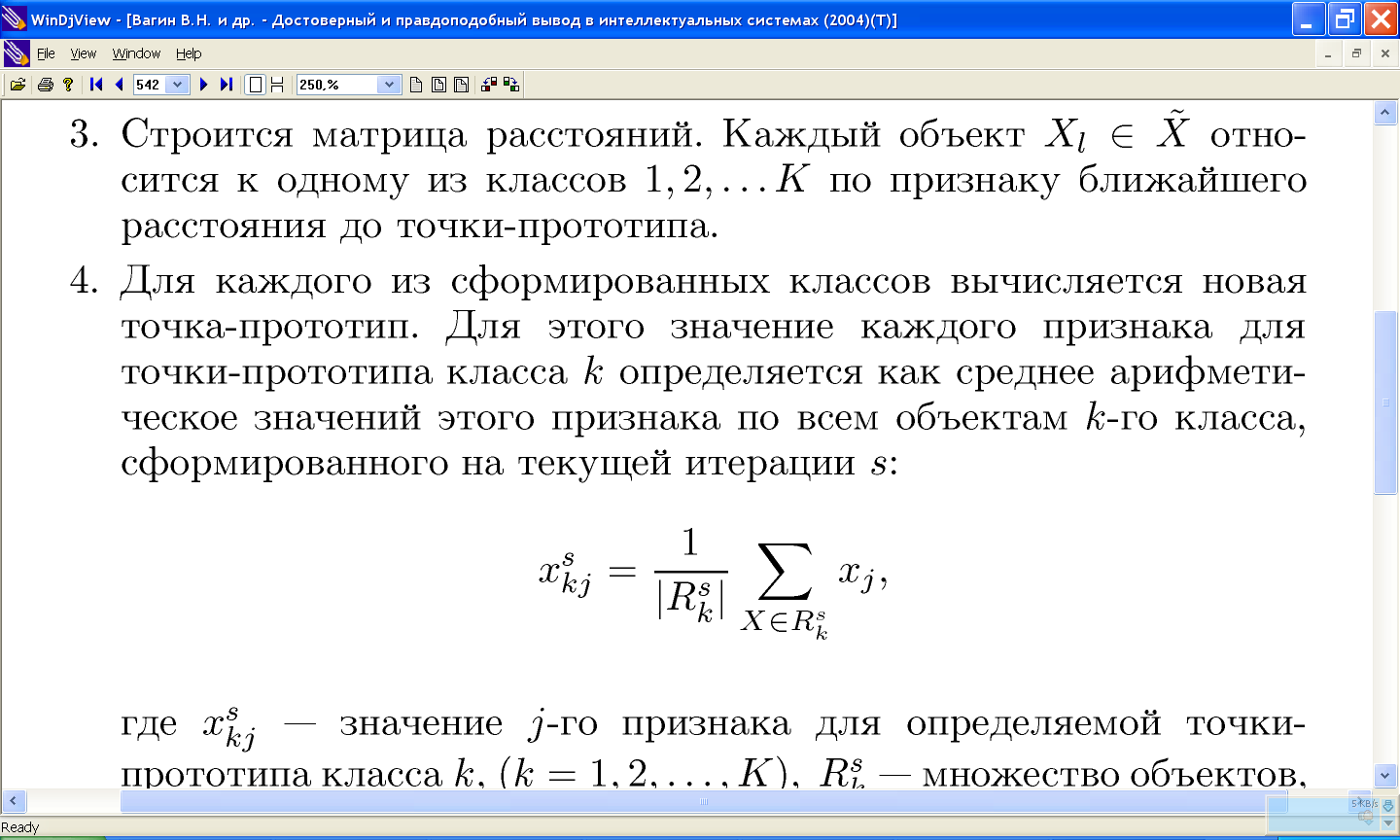

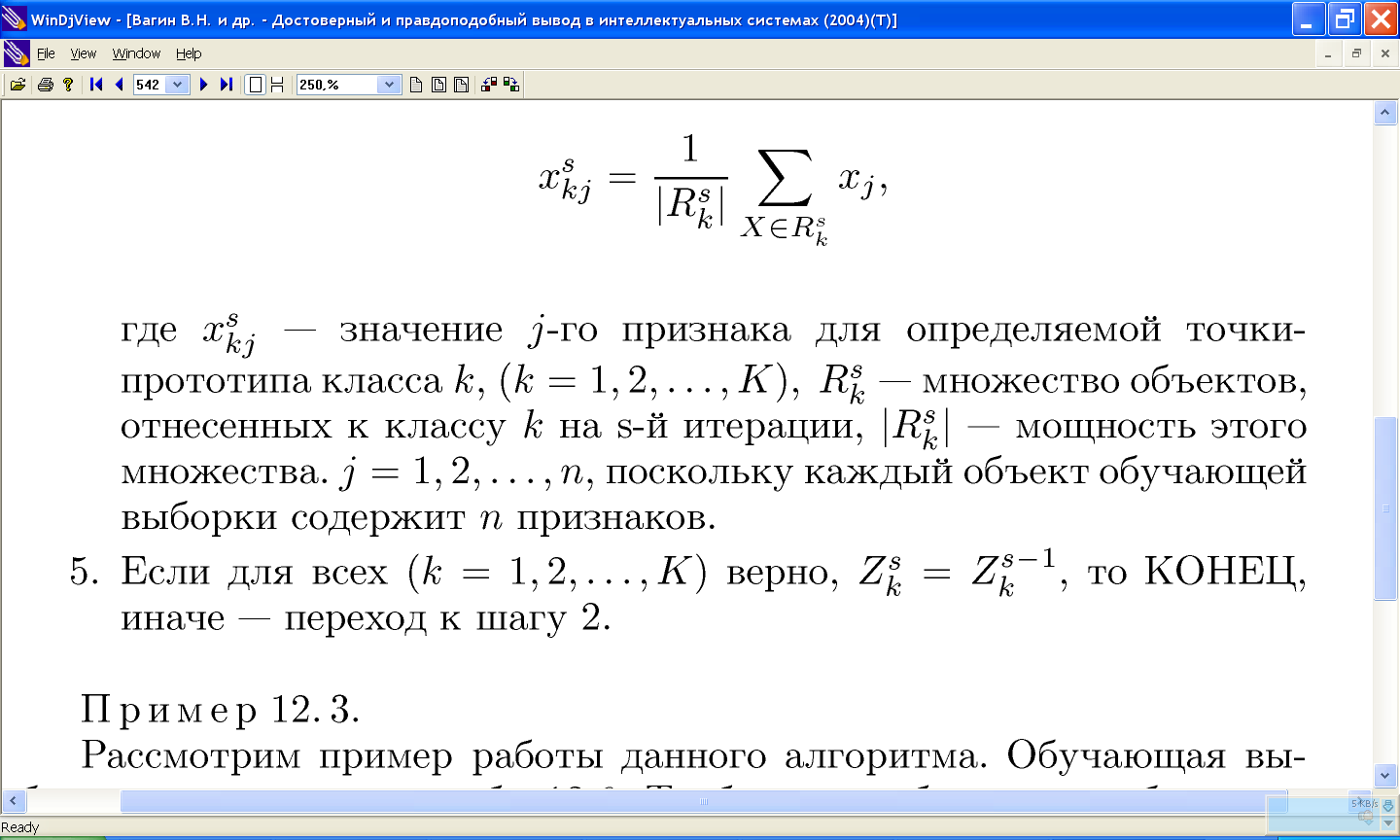

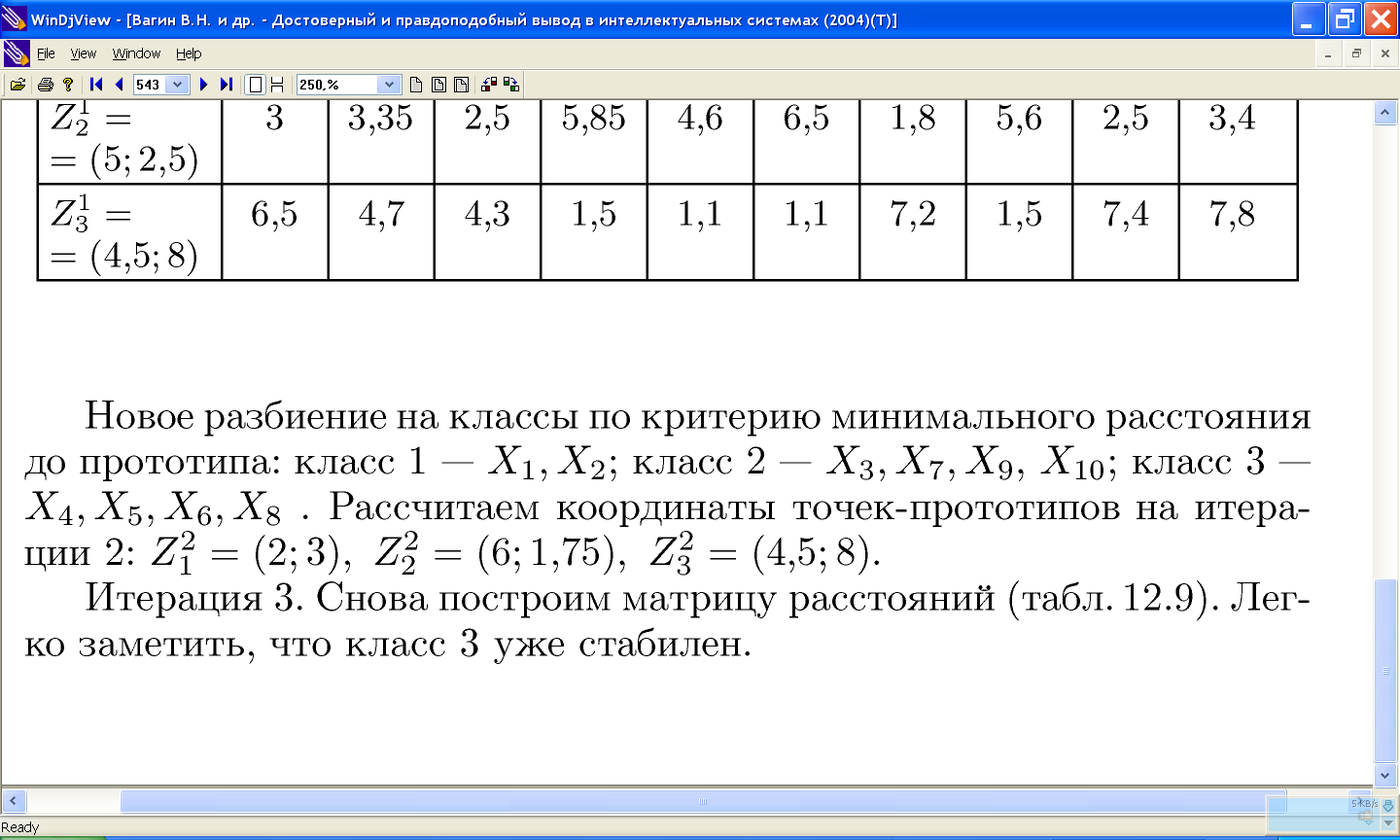

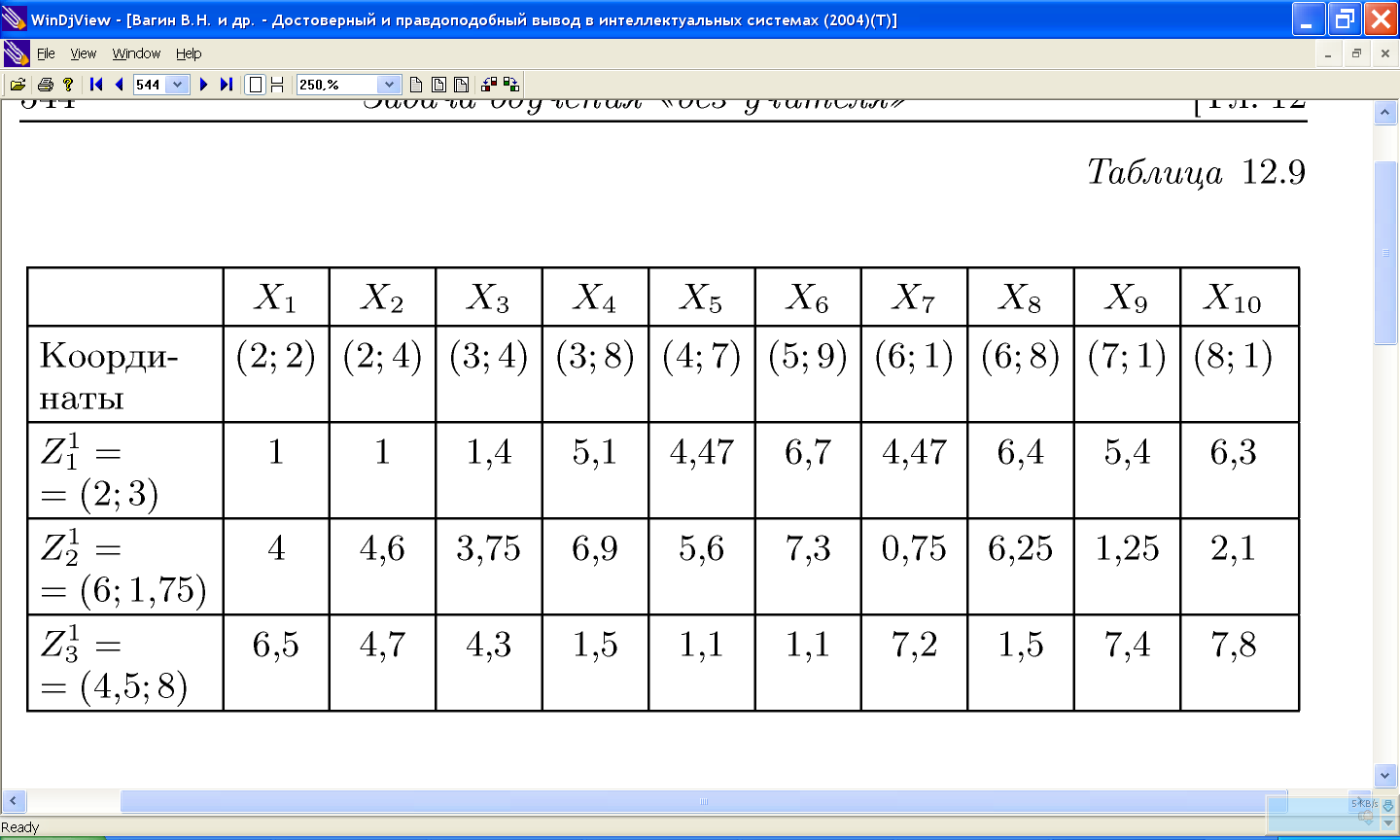

11.2 Алгоритм «к средних»

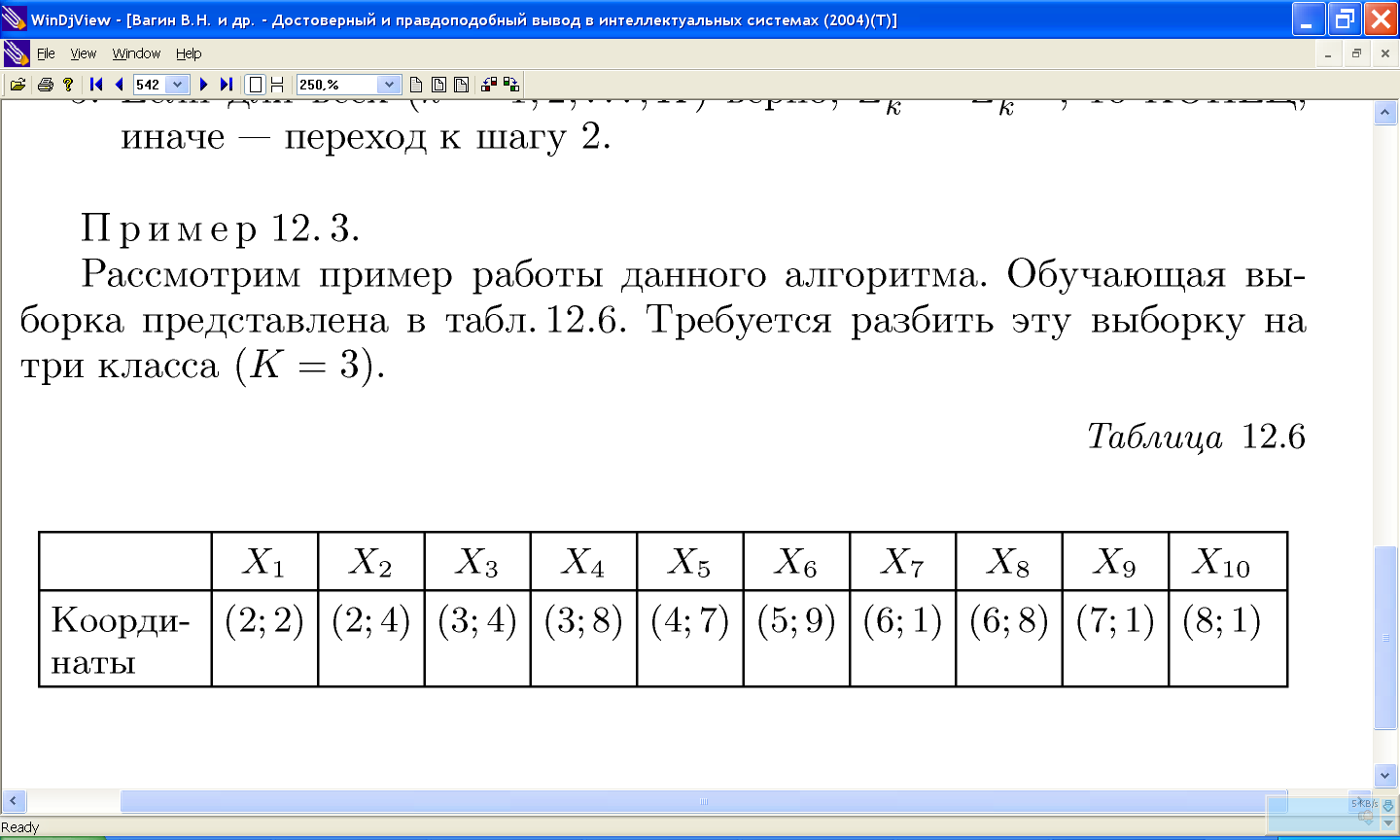

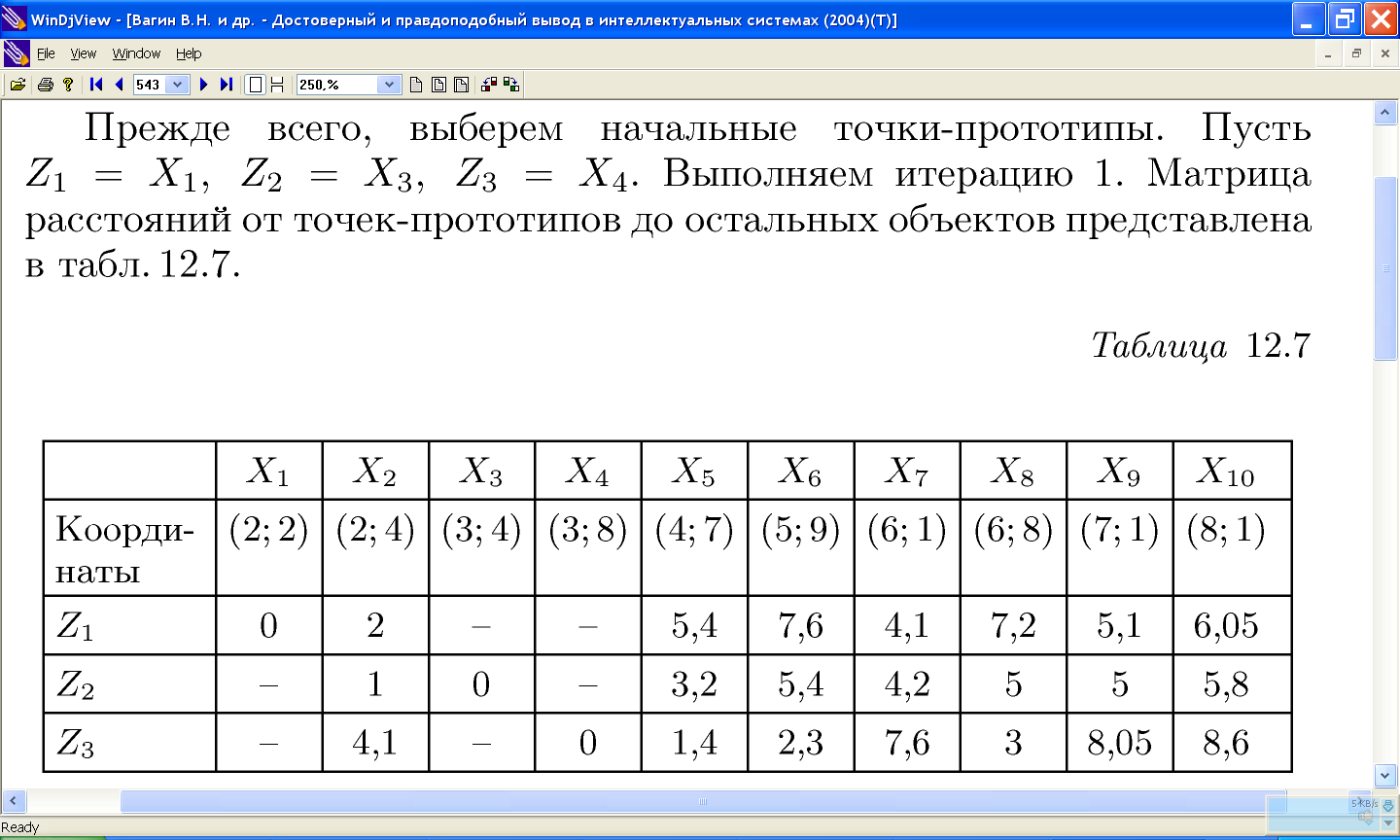

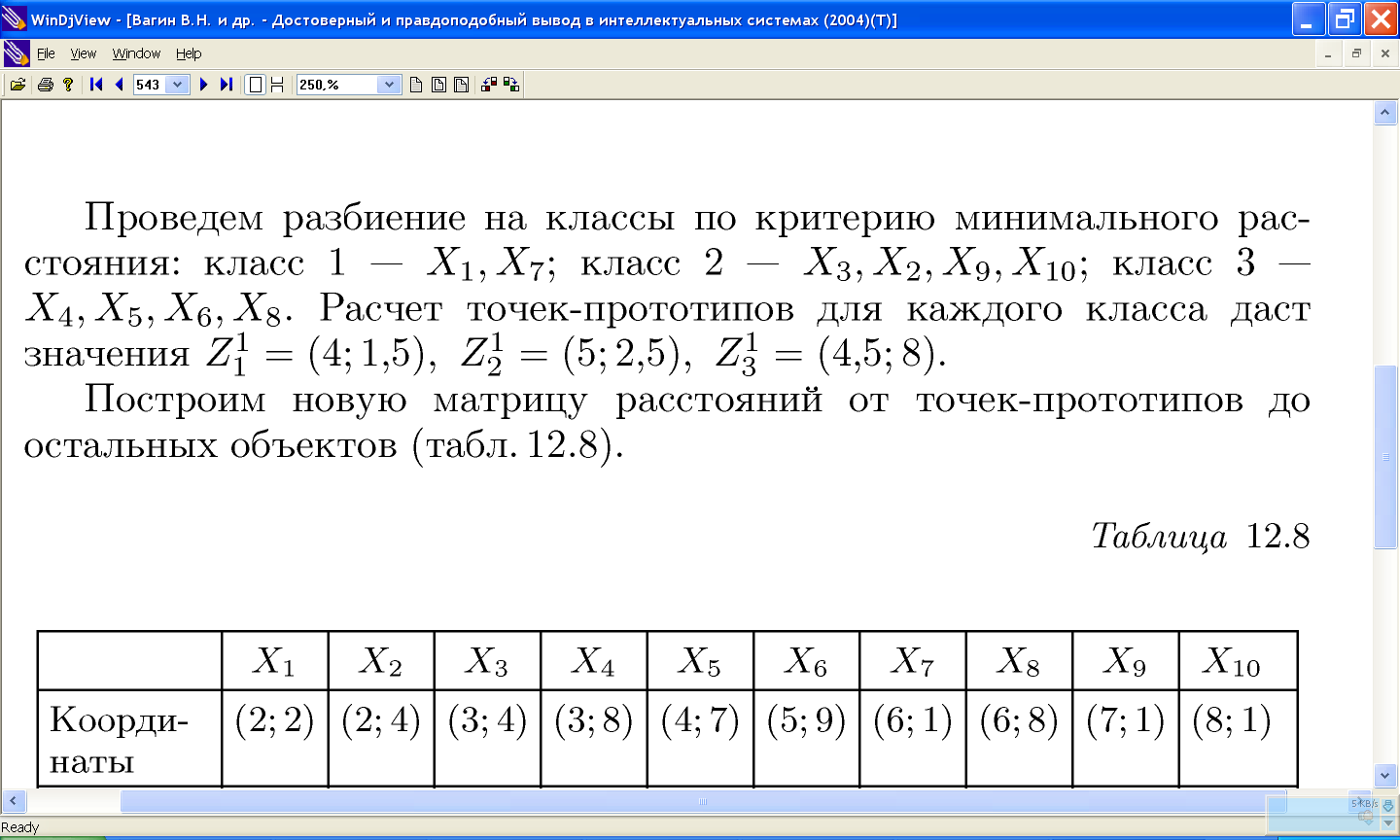

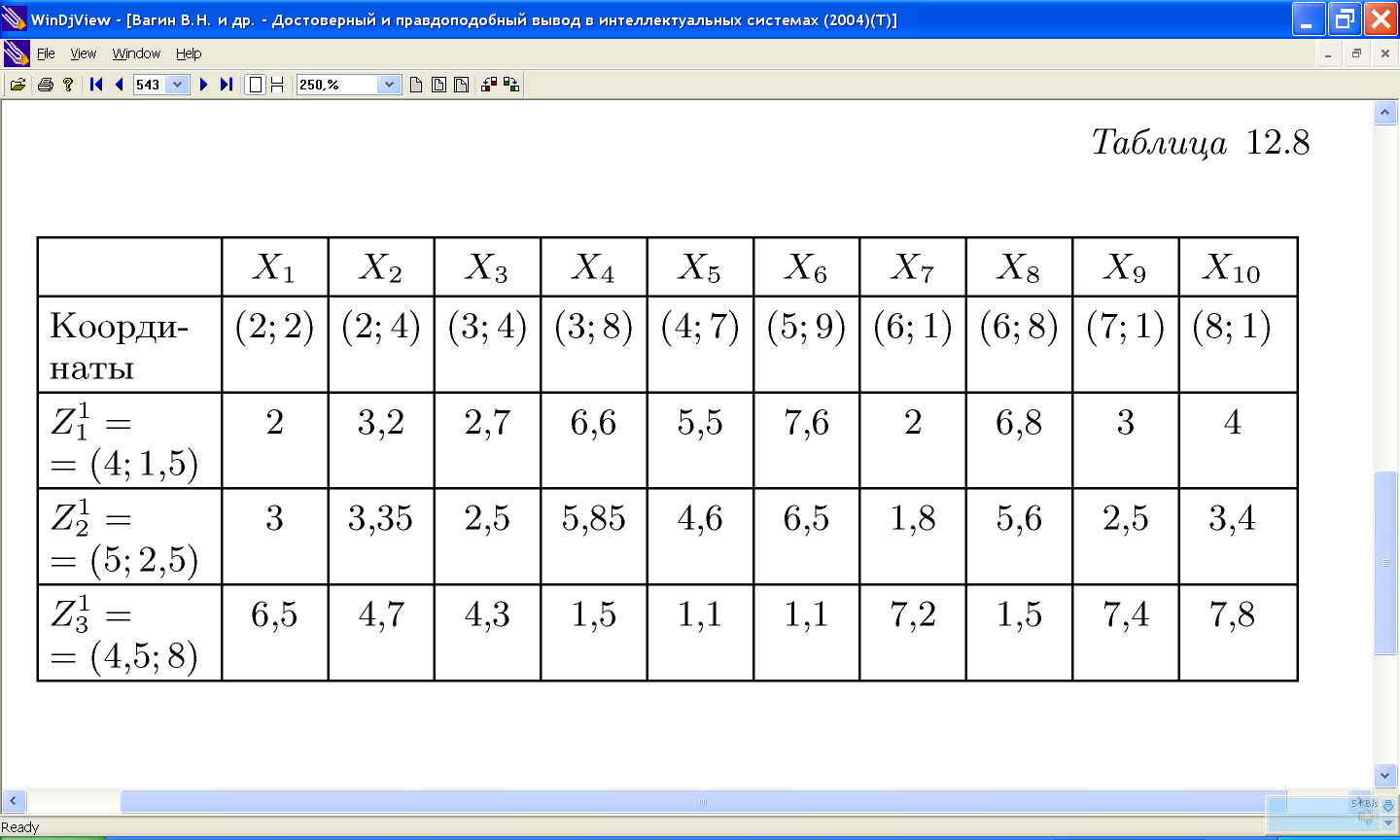

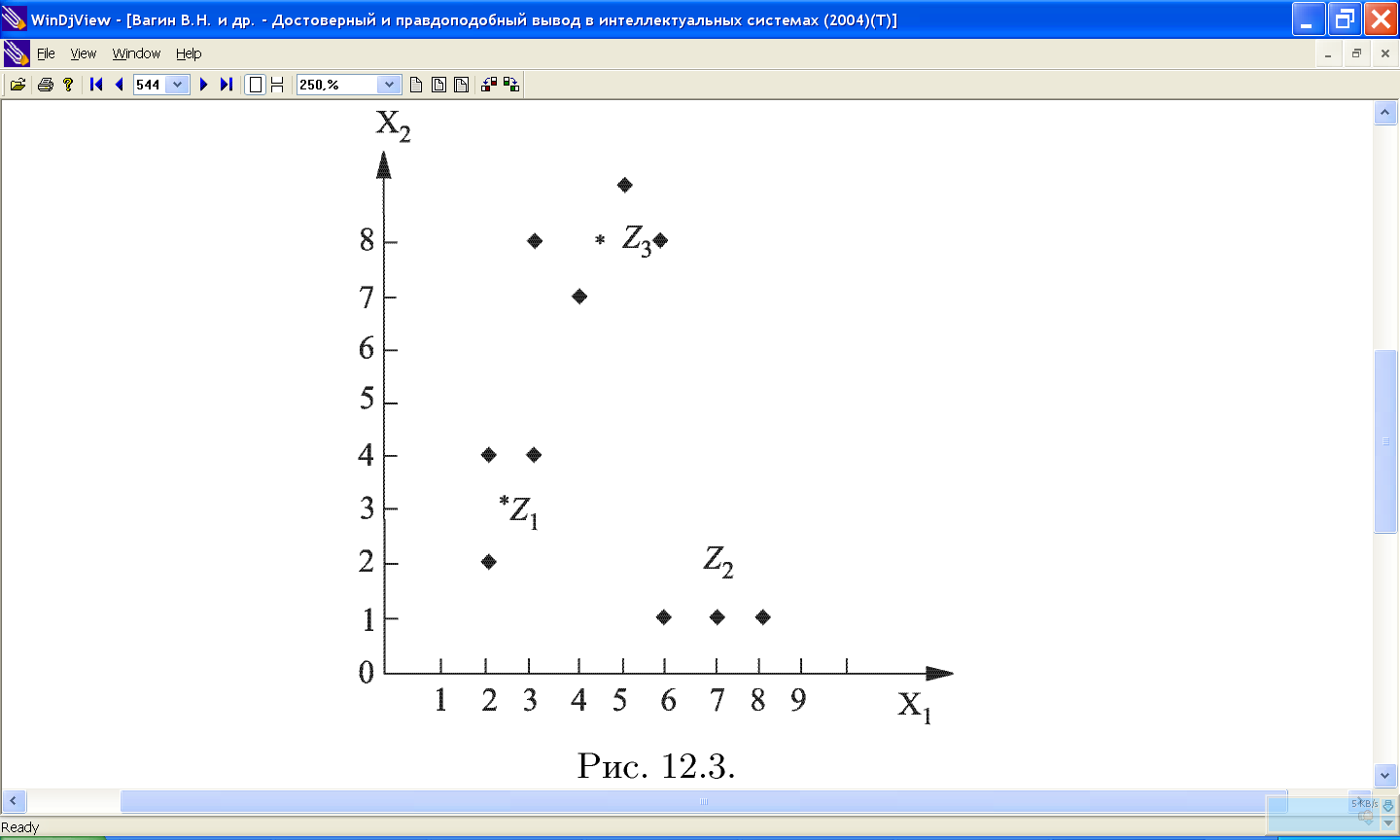

11.2.1 Пример работы алгоритма «к средних»

11.2.2 Проблемы алгоритма k-средних:

- необходимо заранее знать количество кластеров.

- алгоритм очень чувствителен к выбору начальных центров кластеров. Классический вариант подразумевает случайный выбор кластеров, что очень часто являлось источником погрешности. Как вариант решения, необходимо проводить исследования объекта для более точного определения центров начальных кластеров.

- не справляется с задачей, когда объект принадлежит к разным кластерам в равной степени или не принадлежит ни одному.

11.3 Алгоритмы расстановки центров кластеров

11.4 Алгоритм, основанный на методе просеивания

![]()

11.5 Нечеткий алгоритм кластеризации с-means

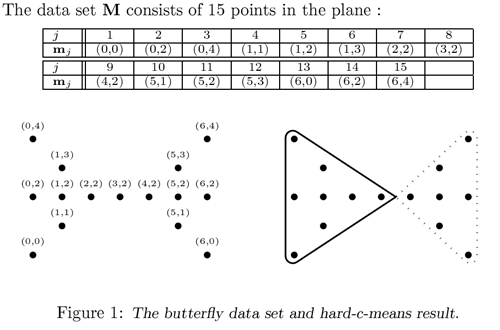

С последней проблемой k-means успешно справляется алгоритм с-means. Вместо однозначного ответа на вопрос, к какому кластеру относится объект, он определяет вероятность того, что объект принадлежит к тому или иному кластеру. Таким образом, утверждение «объект А принадлежит к кластеру 1 с вероятностью 90%, к кластеру 2 — 10% » верно и более удобно.

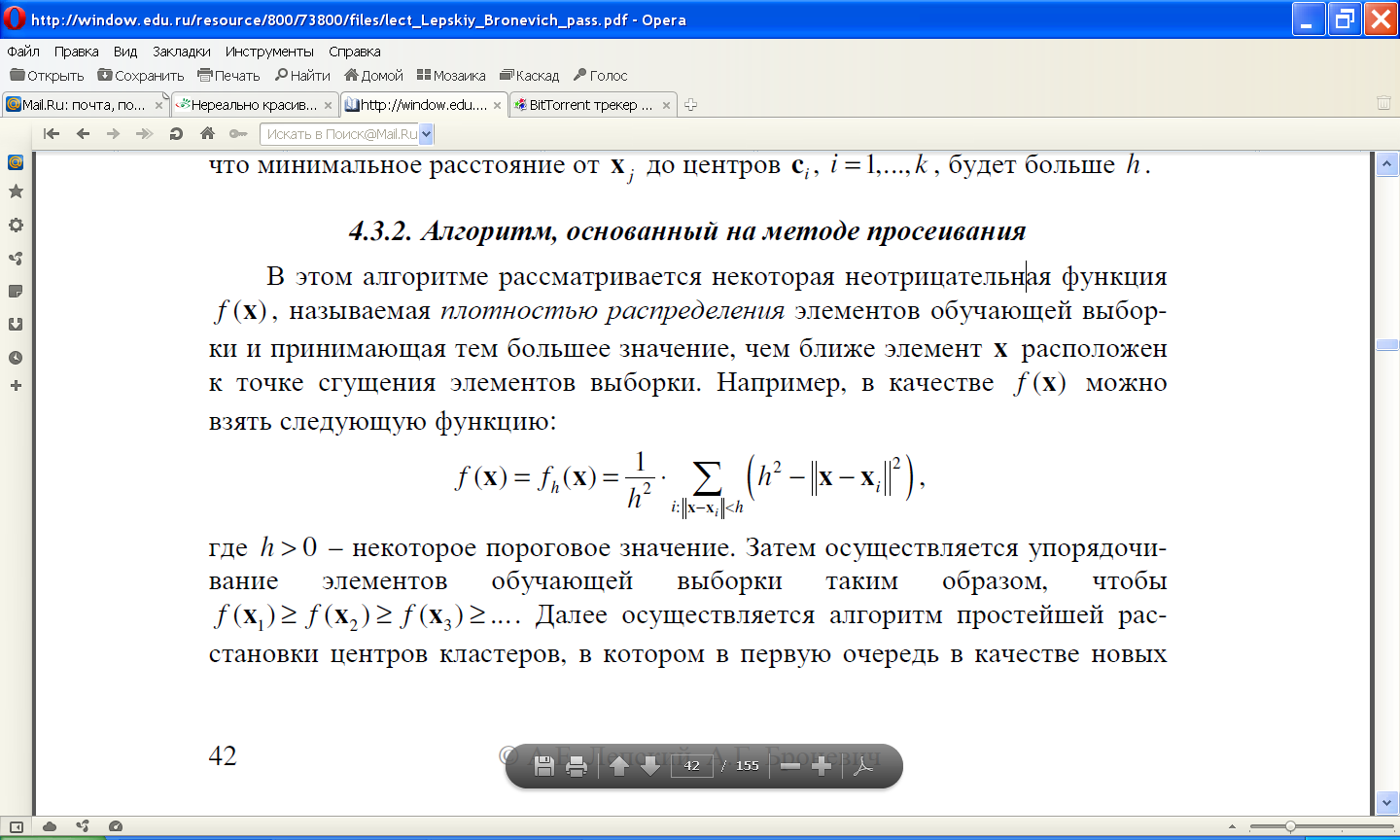

11.5.1 Классический пример с-means — т.н. «бабочка» (butterfly):

11.5.2 Алгоритм ISODATA

(Iterative Self-Organizing Data Analysis Techniques) основывается на алгоритме k средних, но включает набор оказавшихся полезными на практике эвристик и параметры по их настройке. Одним из задаваемых априори параметров является желаемое число кластеров K.

Это число выступает в качестве рекомендации: в результате работы алгоритма может быть построено как меньшее, так и большее число кластеров, но оно будет не сильно отличаться от значения K. Сам алгоритм здесь детально описываться не будет (в целом, в нем используются те же шаги, что и в алгоритме k средних); приведем лишь основные эвристики.

- Ликвидируются кластеры, в состав которых входит менее чем заданное число элементов.

- Для каждого текущего кластера определяется направление максимальной вытянутости. Наиболее вытянутый кластер может быть расщеплен на два.

- Решение о расщеплении принимается с учетом размера кластера в направлении вытянутости (этот размер может сравниваться с фиксированным порогом и отклонением от среднего размера всех кластеров, а также общего числа кластеров, которое должно быть мало (с учетом параметра K).

- Попарно сливаются кластеры, расстояние между центрами которых меньше заданного порога, если число кластеров велико (с учетом параметра K).

Использующиеся в алгоритме ISODATA эвристики помогают не только подбирать более подходящее число классов, но и находить более приемлемое решение, несколько ослабляя (но не убирая полностью) зависимость от начальной гипотезы.

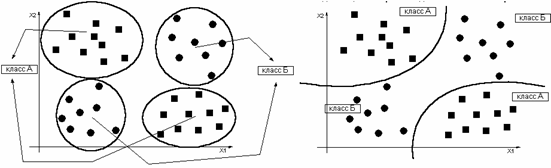

Алгоритмы, рассмотренные в этой главе, обладают одним общим свойством: в их помощью для обучающей выборки Х решается задача классификации, то есть строится разбиение примеров обучающей выборки на классы. Вспомним, что алгоритмы обобщения должны успешно решать задачу распознавания, то есть задачу распределения вновь предъявляемых примеров по классам. Последнее требует наличия четко сформулированного решающего правила, или алгоритма, позволяющего отвести новый Х к одному из классов.

11.6 Распознавание с использованием решающих функций

11.7 Построение решающих функций по критерию минимального расстояния

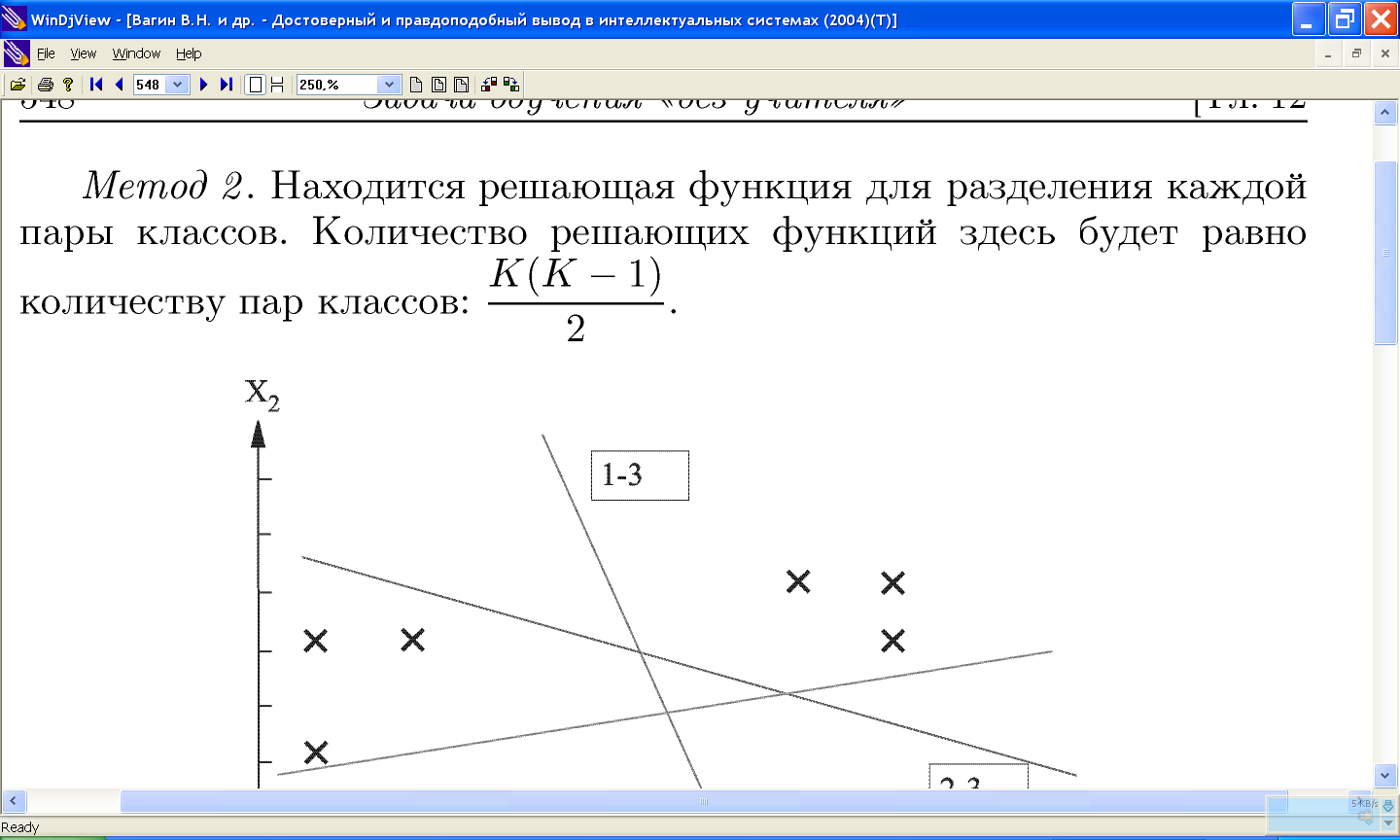

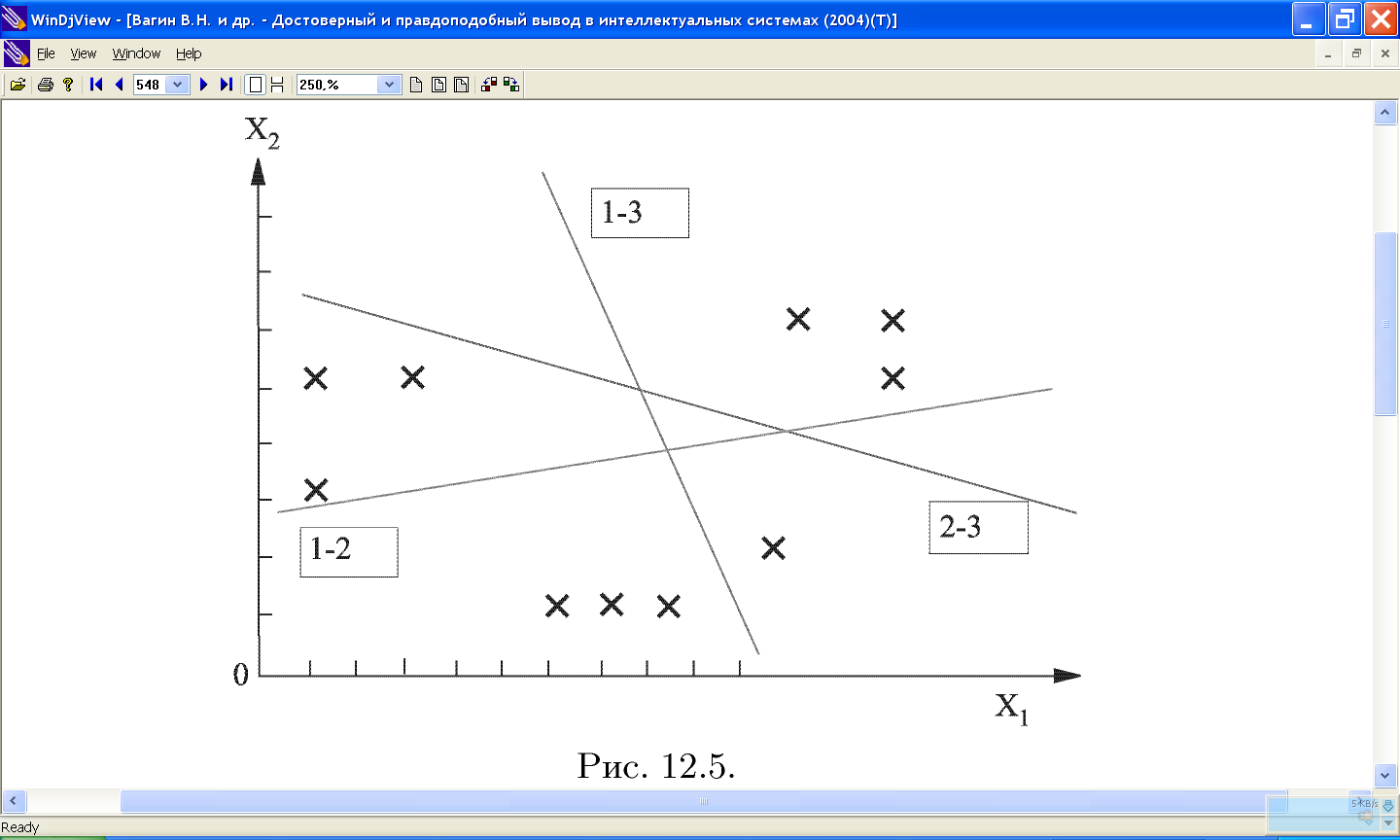

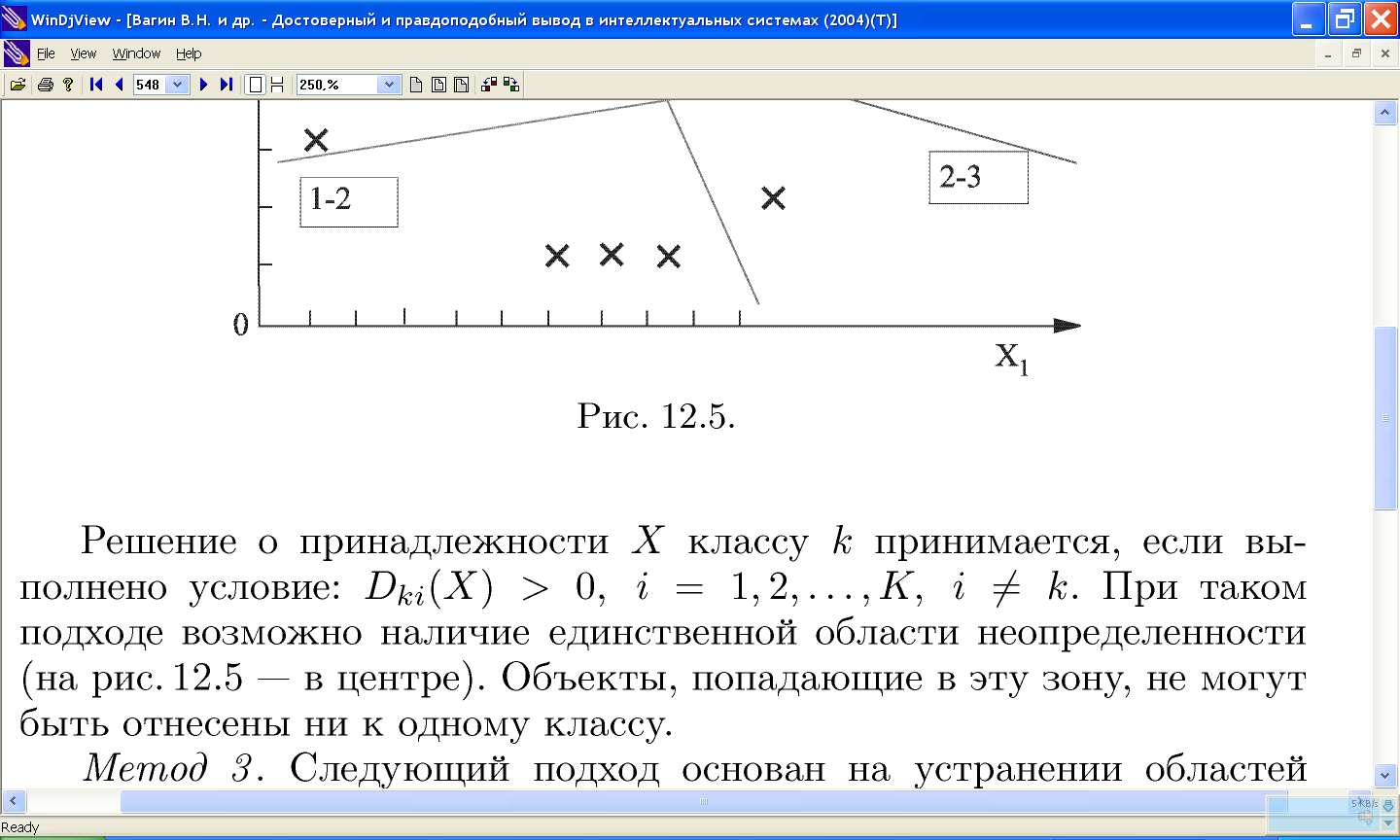

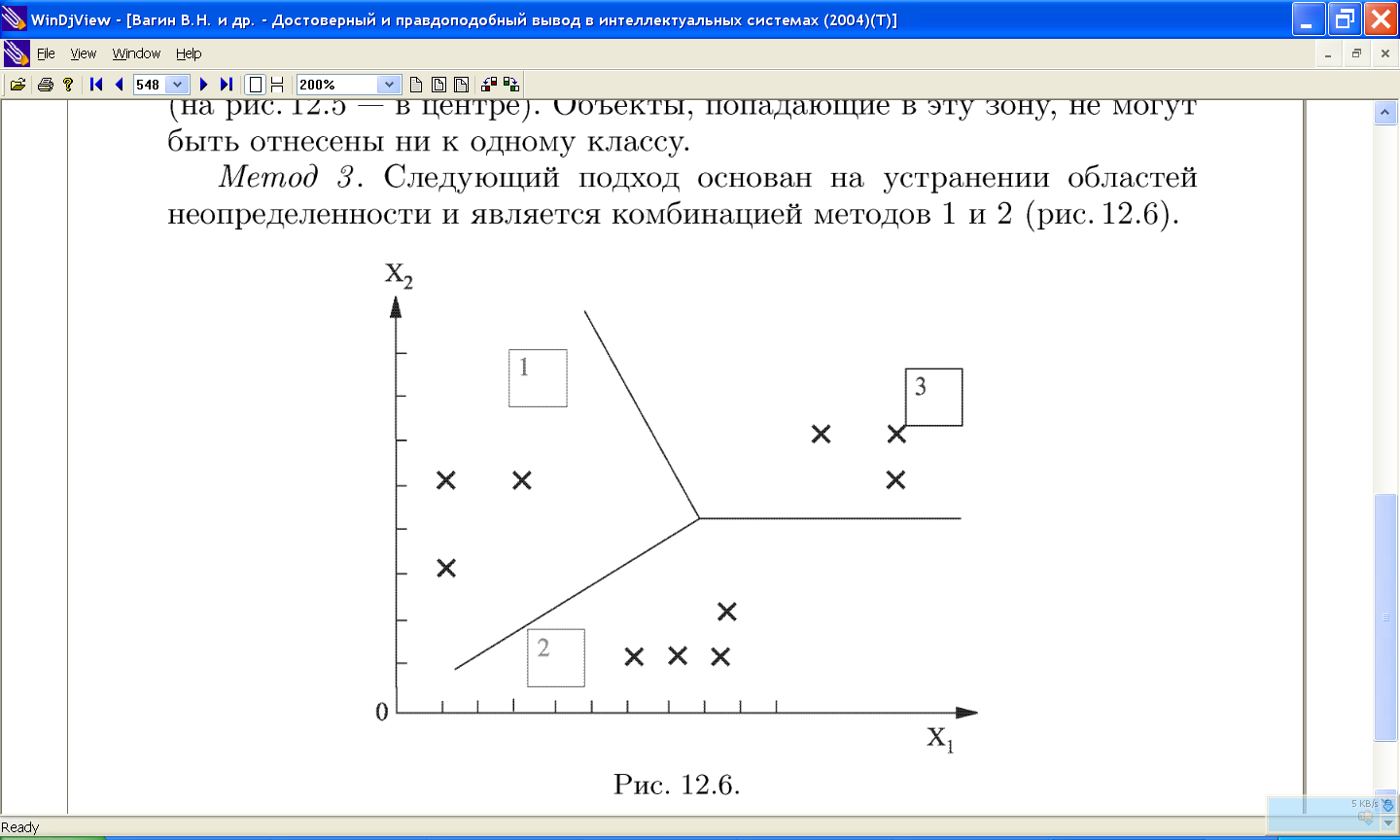

11.8 Разделяющие решающие функции

11.9 Распознавание образов

Задача минимизации количества решающих функций, достаточных для классификации образов, может быть очень важна, особенно если количество классов d велико. Если представить себе, с каким количеством классов объектов (или понятий) имеет дело человек, становится ясно, что решение этой проблемы в том или ином виде потребуется при разработке универсальной системы машинного обучения. Мы, однако, этот вопрос здесь рассматривать не будем, а перейдем к проблеме распознавания образов.

Прямого ответа на этот вопрос можно избежать, если конструировать методы распознавания на основе неких эвристических соображений. Два наиболее широко распространенных эвристических метода – это метод эталонных образов и метод ближайшего соседа.