- •Лекция 10. Способы представления исходной информации в интеллектуальных системах

- •10. 1 Обучение на основе примеров

- •10.2 Типы значений признаков:

- •10.3 Ранговая или порядковая шкала значений признаков

- •10.5 Выборка к-

- •10.6 Кластерный анализ

- •10.6.1 Пример процедуры кластерного анализа: .

- •10.6.2 Диаграмма рассеивания

- •10.6.3 Способы определения меры расстояния между кластерами

- •10.6.4 Работа кластерного анализа опирается на два предположения.

- •10.6.5 Рассмотрим пример.

- •10.6.6 Способы нормирования исходных данных: .

- •10.6.9 Пример вертикальной дендрограммы

- •10.6.10 Методы объединения или связи

- •Метод ближнего соседа или одиночная связь.

- •Метод Варда (Ward's method).

- •Метод наиболее удаленных соседей или полная связь.

- •Метод невзвешенного попарного среднего

- •Метод взвешенного попарного среднего

- •Невзвешенный центроидный метод

- •10.7 Задача обучения «без учителя»

- •10.8 Алгоритм, основанный на понятии порогового расстояния

- •10.8.1 Пример работы алгоритма, основанного на вычислении порогового расстояния.

- •Лекция 11. Алгоритмы обучения без учителя

- •11.1 Алгоритм maxmin

- •11.2 Алгоритм «к средних»

- •11.2.1 Пример работы алгоритма «к средних»

- •11.2.2 Проблемы алгоритма k-средних:

- •11.9. 1 Метод эталонных образов

- •11.9.2 Метод эталонных образов

- •13.2 Программированное обучение. Автор б.Ф. Скиннер

- •13.3 Основные формы программирования

- •13.3.1 Линейная программа

- •13.3.2 Разветвленная форма. Норман а. Кроудер

- •13.4 Автоматизация программированного обучения

- •13.5 Искусственный интеллект

- •13.6 Задача-максимум создания Искусственного Интеллекта

- •13.7 Автоматизированная обучающая система «Контакт»

- •13.8 Аос эвос и атос

- •13.9 Аос садко

- •13.10 Plato

- •13.11 В общем об обучающих системах

- •13.12 Интеллектуальные обучающие системы (иос)

- •13.12.1 Четыре этапа развития иос

- •13.12.2 Принципы организации и реализации интеллектуальных систем электронного обучения

- •13.13. 1 Особенности Образования Web 2.0 или Образования 2.0

- •13.14 Семантический Web (Web 3.0)

- •13.14. 1 Основыне принципы Образования 3.0

- •13.15 Иос на осве субз

- •13.16 Алгоритм муравья

- •13.17 Модель обучения в общем виде

- •13.18 Этапы создания иос от специалистов

- •13.19 Состав группы для разработки иос

10.6.4 Работа кластерного анализа опирается на два предположения.

Первое предположение - рассматриваемые признаки объекта в принципе допускают желательное разбиение пула (совокупности) объектов на кластеры

В начале лекции мы уже упоминали о сравнимости шкал, это и есть Второе предположение - правильность выбора масштаба или единиц измерения признаков. Выбор масштаба в кластерном анализе имеет большое значение.

10.6.5 Рассмотрим пример.

Представим себе, что данные признака х в наборе данных А на два порядка больше данных признака у: значения переменной х находятся в диапазоне от 100 до 700, а значения переменной у - в диапазоне от 0 до 1.

Тогда, при расчете величины расстояния между точками, отражающими положение объектов в пространстве их свойств, переменная, имеющая большие значения, т.е. переменная х, будет практически полностью доминировать над переменной с малыми значениями, т.е. переменной у. Таким образом из-за неоднородности единиц измерения признаков становится невозможно корректно рассчитать расстояния между точками.

Эта проблема решается при помощи предварительной стандартизации переменных. Стандартизация (standardization) или нормирование (normalization) приводит значения всех преобразованных переменных к единому диапазону значений путем выражения через отношение этих значений к некой величине, отражающей определенные свойства конкретного признака. Существуют различные способы нормирования исходных данных.

10.6.6 Способы нормирования исходных данных: .

Наиболее распространенный: деление исходных данных на среднеквадратичное отклонение соответствующих переменных

Наряду со стандартизацией переменных, существует вариант придания каждой из них определенного коэффициента важности, или веса, который бы отражал значимость соответствующей переменной. В качестве весов могут выступать экспертные оценки, полученные в ходе опроса экспертов - специалистов предметной области. Полученные произведения нормированных переменных на соответствующие веса позволяют получать расстояния между точками в многомерном пространстве с учетом неодинакового веса переменных

10.6.7 Методы кластерного анализа можно разделить на две группы:

- иерархические;

- неиерархические.

Суть иерархической кластеризации состоит в последовательном объединении меньших кластеров в большие или разделении больших кластеров на меньшие

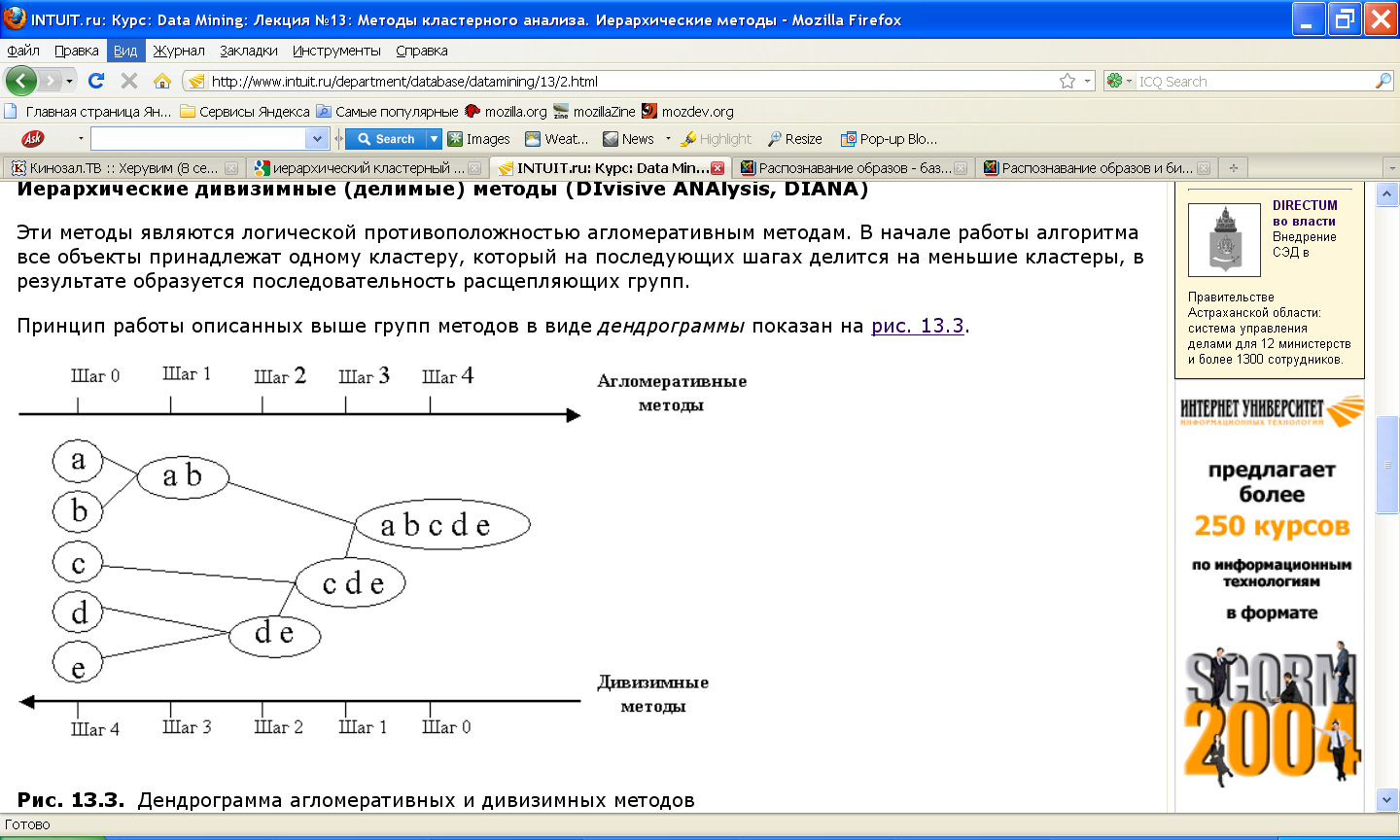

10.6.7.1 Иерархические агломеративные методы (Agglomerative Nesting, AGNES)

Эта группа методов характеризуется последовательным объединением исходных элементов и соответствующим уменьшением числа кластеров.

В начале работы алгоритма все объекты являются отдельными кластерами. На первом шаге наиболее похожие объекты объединяются в кластер. На последующих шагах объединение продолжается до тех пор, пока все объекты не будут составлять один кластер.

10.6.7.2 Иерархические дивизимные (делимые) методы (DIvisive ANAlysis, DIANA)

Эти методы являются логической противоположностью агломеративным методам. В начале работы алгоритма все объекты принадлежат одному кластеру, который на последующих шагах делится на меньшие кластеры, в результате образуется последовательность расщепляющих групп.

10.6.8 Программная реализация алгоритмов кластерного анализа

Программная реализация алгоритмов кластерного анализа широко представлена в различных инструментах Data Mining, которые позволяют решать задачи достаточно большой размерности. Например, агломеративные методы реализованы в пакете SPSS, дивизимные методы - в пакете Statgraf.

Иерархические методы кластеризации различаются правилами построения кластеров. В качестве правил выступают критерии, которые используются при решении вопроса о "схожести" объектов при их объединении в группу (агломеративные методы) либо разделения на группы (дивизимные методы).

Иерархические методы кластерного анализа используются при небольших объемах наборов данных.

Преимуществом иерархических методов кластеризации является их наглядность.

Иерархические алгоритмы связаны с построением дендрограмм (от греческого dendron - "дерево"), которые являются результатом иерархического кластерного анализа.

Дендрограмма описывает близость отдельных точек и кластеров друг к другу, представляет в графическом виде последовательность объединения (разделения) кластеров.

Существует много способов построения дендрограмм. В дендрограмме объекты могут располагаться вертикально или горизонтально.