- •Предисловие

- •Введение

- •Концептуальные основы информационных процессов.

- •О понятии «Информация» [1,2]

- •1.2. Виды и свойства информации [2].

- •1.3. Этапы обращения информации [1].

- •1.4. Информационные системы [1].

- •1.5. Система передачи информации [1].

- •1.6. Уровни проблем передачи информации [1].

- •1.7. О смысле «Теории информации» в системе связи [1].

- •2. Математические основы теории вероятностей [6,4].

- •2.1. Случайное событие и вероятность.

- •2.2 Случайные величины и их вероятностные характеристики.

- •Случайные функции и их вероятностное описание.

- •2.4 Корреляционные характеристики случайных процессов.

- •Дифференциальный; 2) интегральный;

- •3) Плотность вероятностей.

- •Дифференциальный; 2) интегральный; 3) числовой.

- •Свойства энтропии [1,3 и др.].

- •Условная энтропия и ее свойства [1,2 и др.].

- •Свойства условной энтропии

- •Энтропия непрерывного источника информации (дифференциальная энтропия) [1, 2 и др.].

- •Передача информации от дискретного источника [1 и др.].

- •Передача информации от непрерывного источника [1 и др.].

- •Основные свойства количества информации [1 и др.].

- •4. Информационные характеристики источника сообщений и канала связи.

- •4.1. Введение [1 и др.].

- •4.2. Информационные характеристики источника дискретных сообщений.

- •4.2.1 Модели источника дискретных сообщений [1 и др.].

- •4.2.2 Свойства эргодических последовательностей знаков [1 и др.].

- •4.2.3 Избыточность источника [1 и др.].

- •4.2.4 Производительность источника дискретных сообщений [1 и др.].

- •4.3. Информационные характеристики дискретных каналов связи.

- •4.3.1 Модели дискретных каналов [1, 4, 5 и др.].

- •Скорость передачи информации по дискретному каналу [1 и др.].

- •Пропускная способность дискретного канала без помех [1 и др.].

- •Пропускная способность дискретного канала с помехами [1 и др.].

- •Информационные характеристики непрерывных каналов связи [1 и др.].

- •Согласование физических характеристик сигнала и канала [1 и др.].

- •Согласование статистических свойств источника сообщений и канала связи [1 и др.].

- •4.6 Контрольные вопросы к разделам 3 и 4 в форме «Задание – тест» тема: «Количественная оценка информации».

- •1) Бод; 2) бит (двоичная цифра); 3) байт.

- •1) Сумма; 2) произведение; 3) разность.

- •1) Безусловной энтропией; 2) условной энтропией;

- •3) Совместной энтропией.

- •1) Объем алфавита;

- •2) Объем алфавита и вероятности создания источником отдельных знаков; 3) вероятности создания источником отдельных знаков.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Максимальная скорость; 2) пропускная скорость; 3) предел скорости.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •5.2. Классификация кодов [4 и др.].

- •5.3. Представление кодов [4 и др.].

- •5.4. Оптимальное (эффективное) статистическое кодирование [3 и др.].

- •5.4.1 Методы эффективного кодирования некоррелированной последовательности знаков [1 и др.].

- •Методика построения кода Шеннона – Фано [1].

- •Методика построения кода Хаффмена [2 и др.].

- •5.4.2 Свойство префиксности эффективных кодов [1 и др.].

- •5.4.3 Методы эффективного кодирования коррелированной последовательности знаков.

- •5.4.4 Недостатки системы эффективного кодирования.

- •1) Номер разряда;

- •2) Множитель, принимающий целочисленные значения;

- •3) Количество разрядов.

- •Всякий блочный код можно представить таблицей:

- •Всякий блочный код можно представить таблицей:

- •Литература:

- •Содержание

2.2 Случайные величины и их вероятностные характеристики.

Если случайная величина ξ может принимать конечное число дискретных значений xi, исчерпывающей вероятностной характеристикой ее служит распределение вероятностей этих значений Pi. (По аналогии со случайными функциями случайные величины обозначим буквами греческого алфавита, а их конкретные реализации – буквами латинского алфавита.)

Если случайная величина ξ непрерывна и может принимать любое значение на интервале [xmin, xmax], то ее статистической характеристикой может служить так называемый интегральный закон распределения F (x)=P(ξ<x), определяющий вероятность того, что случайная величина ξ не превзойдет значение x. Из определения интегрального закона распределения вытекает следующее очевидное соотношение:

![]()

где

![]() – вероятность того, что случайная

величина ξ не выйдет за пределы интервала

[x1,

x2].

– вероятность того, что случайная

величина ξ не выйдет за пределы интервала

[x1,

x2].

Очевидны следующие свойства функции F(x): F(x) – монотонная неубывающая функция;

![]()

![]()

Если функция F(x) дифференцируемая, то в качестве вероятностной характеристики случайной величины удобно использовать дифференциальный закон распределения или закон распределения плотности вероятности

![]() (2.15)

(2.15)

Очевидны следующие соотношения:

![]()

![]()

Помимо законов распределения, часто используются числовые характеристики случайных величин, так называемые моменты распределения. Моменты, характеризующие распределение случайных величин относительно нуля, называются начальными.

Для непрерывных случайных величин начальный момент k-го порядка определяется по формуле

![]() (2.16)

(2.16)

Для дискретной случайной величины ξ, принимающей значения x1, x2, …, xn с вероятностями P1, P2, …, Pn,

![]() (2.17)

(2.17)

Наиболее важное значение имеют моменты 1-го и 2-го порядков. Начальный момент 1-го порядка дает математическое ожидание или среднее значение случайной величины ξ:

![]() (2.18)

(2.18)

Разность Δξ=ξ – m1(ξ) называется отклонением случайной величины. Моменты распределения отклонений случайной величины называются центральными и обозначаются Mk(ξ). Нетрудно убедиться, что M1(ξ)=0.

Случайные величины с нулевым средним значением называются центрированными. Любые случайные величины можно свести к центрированным, если перейти к отклонениям Δξ.

Начальный момент 2-го порядка определяет средний квадрат случайной величины ξ:

![]() (2.19)

(2.19)

Центральный момент 2-го порядка называется дисперсией случайной величины:

![]() (2.20)

(2.20)

Отношение Δξ/σξ называется нормированным отклонением случайной величины.

Центральный и начальный момент 2-го порядка случайной величины связаны простым соотношением:

![]() (2.21)

(2.21)

Для совокупности двух случайных величин ξ1 и ξ2 исчерпывающей вероятностной характеристикой служит двумерный интегральный закон распределения F(x1, x2)=P(ξ1<x1, ξ2<x2), определяющий вероятность того, что случайные величины ξ1 и ξ2 не превосходят соответственно значений x1 и x2. Если функция F(x1, x2) дифференцируемая, то вероятностной характеристикой двумерной случайной величины может служить двумерный дифференциальный закон распределения или двумерная плотность вероятностей ω2(x1, x2)=∂2F(x1, x2)/∂x1∂x2. Аналогично могут быть введены многомерный интегральный закон распределения и многомерные функции распределения для совокупностей из любого числа случайных величин.

Можно также ввести числовые характеристики для совокупности двух случайных величин ξ1 и ξ2, имеющих двумерную плотность вероятностей ω2(x1, x2). Весьма важной числовой характеристикой совокупности двух случайных величин является смешанный второй центральный момент или ковариация случайных величин ξ1 и ξ2:

![]() (2.22)

(2.22)

Если случайные величины ξ1 и ξ2 независимы, то ω2(x1, x2)=ω(x1)ω(x2), и двукратный интеграл в (2.22) распадается на произведения двух однократных интегралов:

![]()

![]()

и, следовательно, M2(ξ1, ξ2)=0. Поэтому ковариация M2(ξ1, ξ2) может служить некоторой мерой зависимости между двумя случайными величинами. Чаще в качестве такой меры принимают безразмерный коэффициент корреляции

![]()

Две случайные величины, для которых коэффициент корреляции равен нулю, называются некоррелированными. Случайные величины, для которых 1-й начальный момент их произведения

![]()

называют ортогональными. Если средние значения случайных величин равно нулю, то понятия ортогональности и некоррелированности случайных величин совпадают.

Моменты распределения того или иного порядка, являясь важными числовыми характеристиками случайной величины, не являются, однако, их однозначной полной статистической характеристикой: случайные величины, имеющие одинаковые 1-й и 2-й моменты, могут иметь разные законы распределения.

Нормальный закон распределения.

Среди случайных величин особое место занимают нормальные случайные величины, подчиняются так называемому нормальному закону распределения:

![]() (2.23)

(2.23)

Определим 1-й начальный момент нормальной случайной величины ξ:

![]()

Сделав замену

![]() ,

получим

,

получим

![]()

так как первый из интегралов равен нулю в силу нечетности подынтегральной функции, а

![]()

Итак, a=m1(ξ).

Определим теперь 2-й центральный момент нормальной случайной величины ξ:

так как

![]()

Таким образом, величины a и σ2, полностью определяющие нормальный закон распределения, представляют собой соответственно среднее значение и дисперсию случайной величины ξ, т.е. нормальный закон распределения плотности определяется, если известны первые два момента. Из формулы (2.23) видно, что нормальное распределение симметрично относительно среднего значения случайной величины a. Максимум плотности вероятности, соответствующий x=a, равен

![]()

На рис 2.1 приведен вид нормального закона для различных σ при а=0.

Рис. 2.1

Нормальный закон

распределения занимает особое положение

в силу того, что большинство реальных

случайных величин имеет распределение,

близкое к нормальному. Последнее

обстоятельство связано с тем, что на

практике случайные величины обычно

являются результатом совокупного

действия многих независимых случайных

факторов и, при некоторых условиях, по

мере увеличения числа этих факторов

закон распределения асимптотически

приближается к нормальному. Условия

эти определяются центральной

предельной теоремой теории вероятности,

которая в упрощенном виде может быть

сформулирована следующим образом: если

независимые случайные величины ξ1,

ξ2,

…, ξn

имеют

одинаковые распределения с конечной,

отличной от нуля дисперсией σ2,

то при n→∞

сумма этих

величин стремится к нормальному

распределению со средним значением

![]() и дисперсией

и дисперсией

![]() .

.

А. М. Ляпунов показал, что тенденция к нормализации случайных величин имеет место и при более общих предположениях.

Рис. 2.2

Решение многих практических задач не столь критично к точности аппроксимации закона распределения и уже в случае, когда случайная величина определяется несколькими примерно равноценными независимыми факторами, закон ее распределения можно приближенно аппроксимировать нормальным законом.

Интегральный закон распределения, соответствующий нормальному закону (2.23), имеет вид:

![]() (2.24)

(2.24)

Если перейти к

нормированным отклонениям

![]() ,

то получим

,

то получим

![]() (2.25)

(2.25)

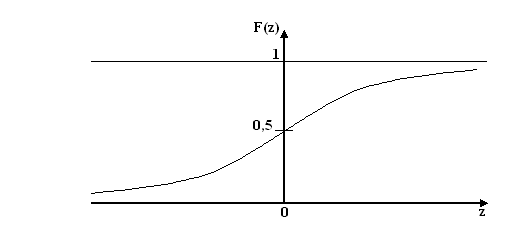

Функция

![]() ,

представляющая собой вероятность того,

что нормированное случайное отклонение

не превзойдет величину z,

называется

интегралом вероятности.

Вид этой функции приведен на

рис. 2.2.

,

представляющая собой вероятность того,

что нормированное случайное отклонение

не превзойдет величину z,

называется

интегралом вероятности.

Вид этой функции приведен на

рис. 2.2.

Поскольку

![]()

то F(-z)=1-F(z) и функцию F(z) достаточно определить в положительной области.

Вероятность того, что нормальная случайная величина ξ не выйдет за пределы интервала [x1, x2]

![]() (2.26)

(2.26)