- •Предисловие

- •Введение

- •Концептуальные основы информационных процессов.

- •О понятии «Информация» [1,2]

- •1.2. Виды и свойства информации [2].

- •1.3. Этапы обращения информации [1].

- •1.4. Информационные системы [1].

- •1.5. Система передачи информации [1].

- •1.6. Уровни проблем передачи информации [1].

- •1.7. О смысле «Теории информации» в системе связи [1].

- •2. Математические основы теории вероятностей [6,4].

- •2.1. Случайное событие и вероятность.

- •2.2 Случайные величины и их вероятностные характеристики.

- •Случайные функции и их вероятностное описание.

- •2.4 Корреляционные характеристики случайных процессов.

- •Дифференциальный; 2) интегральный;

- •3) Плотность вероятностей.

- •Дифференциальный; 2) интегральный; 3) числовой.

- •Свойства энтропии [1,3 и др.].

- •Условная энтропия и ее свойства [1,2 и др.].

- •Свойства условной энтропии

- •Энтропия непрерывного источника информации (дифференциальная энтропия) [1, 2 и др.].

- •Передача информации от дискретного источника [1 и др.].

- •Передача информации от непрерывного источника [1 и др.].

- •Основные свойства количества информации [1 и др.].

- •4. Информационные характеристики источника сообщений и канала связи.

- •4.1. Введение [1 и др.].

- •4.2. Информационные характеристики источника дискретных сообщений.

- •4.2.1 Модели источника дискретных сообщений [1 и др.].

- •4.2.2 Свойства эргодических последовательностей знаков [1 и др.].

- •4.2.3 Избыточность источника [1 и др.].

- •4.2.4 Производительность источника дискретных сообщений [1 и др.].

- •4.3. Информационные характеристики дискретных каналов связи.

- •4.3.1 Модели дискретных каналов [1, 4, 5 и др.].

- •Скорость передачи информации по дискретному каналу [1 и др.].

- •Пропускная способность дискретного канала без помех [1 и др.].

- •Пропускная способность дискретного канала с помехами [1 и др.].

- •Информационные характеристики непрерывных каналов связи [1 и др.].

- •Согласование физических характеристик сигнала и канала [1 и др.].

- •Согласование статистических свойств источника сообщений и канала связи [1 и др.].

- •4.6 Контрольные вопросы к разделам 3 и 4 в форме «Задание – тест» тема: «Количественная оценка информации».

- •1) Бод; 2) бит (двоичная цифра); 3) байт.

- •1) Сумма; 2) произведение; 3) разность.

- •1) Безусловной энтропией; 2) условной энтропией;

- •3) Совместной энтропией.

- •1) Объем алфавита;

- •2) Объем алфавита и вероятности создания источником отдельных знаков; 3) вероятности создания источником отдельных знаков.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Максимальная скорость; 2) пропускная скорость; 3) предел скорости.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •5.2. Классификация кодов [4 и др.].

- •5.3. Представление кодов [4 и др.].

- •5.4. Оптимальное (эффективное) статистическое кодирование [3 и др.].

- •5.4.1 Методы эффективного кодирования некоррелированной последовательности знаков [1 и др.].

- •Методика построения кода Шеннона – Фано [1].

- •Методика построения кода Хаффмена [2 и др.].

- •5.4.2 Свойство префиксности эффективных кодов [1 и др.].

- •5.4.3 Методы эффективного кодирования коррелированной последовательности знаков.

- •5.4.4 Недостатки системы эффективного кодирования.

- •1) Номер разряда;

- •2) Множитель, принимающий целочисленные значения;

- •3) Количество разрядов.

- •Всякий блочный код можно представить таблицей:

- •Всякий блочный код можно представить таблицей:

- •Литература:

- •Содержание

Энтропия непрерывного источника информации (дифференциальная энтропия) [1, 2 и др.].

В предыдущих параграфах была рассмотрена мера неопределенности выбора для дискретного источника информации. На практике мы в основном встречаемся с источниками информации, множество возможных состояний которых составляет континуум. Такие источники называют непрерывными источниками информации.

Во многих случаях они преобразуются в дискретные посредством использования устройств дискретизации и квантования. Вместе с тем существует немало и таких систем, в которых информация передается и преобразуется непосредственно в форме непрерывных сигналов. Примерами могут служить системы телефонной связи и телевидения.

Оценка неопределенности выбора для непрерывного источника информации имеет определенную специфику. Во-первых, значения, реализуемые источником, математические отображаются непрерывной случайной величиной. Во-вторых, вероятности значений этой случайной величины не могут использоваться для оценки неопределенности, поскольку в данном случае вероятность любого конкретного значения равна нулю.

Естественно, однако, связывать неопределенность выбора значения непрерывной случайной величины с плотностью распределения вероятностей этих значений, относящихся к любому сколь угодно малому интервалу непрерывной случайной величины, вероятность конечна, попытаемся найти формулу для энтропии непрерывного источника информации, используя операции квантования и последовательного перехода при уменьшении кванта до нуля

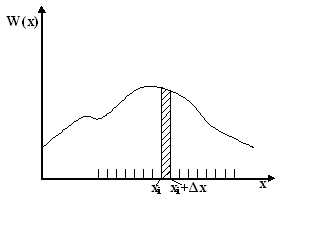

Рис. 3.3

С этой целью разобьем диапазон изменения непрерывной величины X характеризующейся плотностью распределения вероятностей W(x), на конечное число n малых интервалов шириной Δx (рис. 3.3). При реализации любого значения x, принадлежащего интервалу (xi, xi+Δx), будем считать, что реализовалось значение xi дискретной случайной величины X. Поскольку Δx мало, вероятность p(xi≤x≤xi+Δx) реализации значения x из интервала (xi, xi+Δx):

Тогда в соответствии с (3.5) информация на один отсчет такого квантованного сигнала равна (отсчеты полагаем некоррелированными):

так как

![]()

Переходя к пределу при Δx→0, получаем, что энтропия на один отсчет непрерывного источника сообщений равна

![]() (3.19)

(3.19)

Первый член правой части (3.19)

![]() (3.20)

(3.20)

называется дифференциальной энтропией непрерывного распределения (источника непрерывного сообщения). Величина h(x) имеет конечное значение. Она не зависти от шага квантования Δx, а зависит только от закона распределения непрерывной величины x. Второй член правой части (3.19), напротив, не зависит от характеристик источника сообщений, а определяется только шагом квантования Δx уровня сигнала. Можно легко проследить влияние его на энтропию сигнала: при увеличении или уменьшении величины Δx энтропия соответственно монотонно убывает или возрастает.

Свойства дифференциальной энтропии.

Дифференциальная энтропия в отличии от энтропии дискретного источника является относительной мерой неопределенности. Ее значение зависит от масштаба случайной величины X, а следовательно, и от выбора ее измерения.

Изменим масштаб случайной величины X, например, в k раз, оставив неизменным масштаб равномерно распределенной в единичном интервале случайной величины X, принятой за эталон. Если xk=kx, то W(xk)=W(x)/k.

Тогда

(3.21)

(3.21)

Если одновременно изменить масштаб величины X, то относительная неопределенность также изменится, так как значение эталона будет уже иным.

Из относительности дифференциальной энтропии следует, что энтропия может принимать положительные, отрицательные и нулевые значения.

Дифференциальная энтропия не зависит от конкретных значений случайной величины X и, в частности, от изменения всех ее значений на постоянное. Действительно, масштаб X при этом не меняется и справедливо равенство

(3.22)

(3.22)

Какие же непрерывные распределения обладают максимальной дифференциальной энтропией?

а) Если единственным ограничением для случайной величины X является область ее возможных значений [α, β], то максимальной дифференциальной энтропией обладает равномерное распределение вероятностей в этой области.

При доказательстве решается задача определения плотности распределения W(x), обеспечивающей максимальное значение функционала

![]()

при ограничении

![]()

Используя, например, метод неопределенных множителей Лагранжа. получим

![]() (3.23)

(3.23)

Нетрудно убедится в том, что найденная функция W(x) обеспечивает максимум функционала h(X), причем

![]() (3.24)

(3.24)

б) Если ограничения на область значений непрерывной случайной величины X отсутствуют, но известно, что дисперсия ее ограничена, то максимальной дифференциальной энтропией обладает нормальное распределение величины X.

При доказательстве решается задача определения функции W(x), обеспечивающей максимальное значение функционала

![]() (3.25)

(3.25)

при ограничениях

![]() и

и

![]()

где σ – среднеквадратическое отклонение от математического ожидания (σ – заданное ограничение).

Искомую плотность распределения W(x) находят, например, методом неопределенных множителей Лагранжа.

Она оказывается гауссовской:

(3.26)

(3.26)

Вычислив функционал (3.25) для этого распределения, получим значение максимальной дифференциальной энтропии hmax(X). В двоичных единицах неопределенности

![]() (3.27)

(3.27)

Поскольку в информационных системах сигнала, описываемый случайной величиной X, часто представляет собой электрическое напряжение (или ток), дисперсия X пропорциональна средней мощности сигнала. Тогда в соответствии с (3.26) можно утверждать, что при заданной мощности наибольшей средней неопределенностью выбора будет обладать источник, генерирующий сигналы, амплитуды которых распределены по нормальному закону.

Соотношения для дифференциальной энтропии объединения статистически зависимых непрерывных источников аналогичны соответствующим формулам для дискретных источников:

![]() (3.28)

(3.28)

где

![]()

Пример 3.4 Определить, насколько мы выиграем в мощности, используя для организации мешающего воздействия, характеризующегося энтропией, источник шума с гауссовской плотностью распределения по сравнению с источником, имеющим в интервале [α, β] равномерную плотность распределения.

В соответствии с (3.27) дифференциальная энтропия гауссовского распределения

![]()

где σг2 – дисперсия, характеризующая мощность, выделяемую на резисторе с сопротивлением в 1Ом.

Для равномерного распределения энтропия определена соотношением (3.24):

![]()

Вычислим дисперсию σр2 равномерного на интервале [α, β] распределения:

![]() (3.29)

(3.29)

Из условия обеспечения равенства энтропий следует

![]() (3.30)

(3.30)

![]() (3.31)

(3.31)

Возведя (3.31) в квадрат и подставив в (3.29) получим

![]()

Следовательно, искомый выигрыш составляет 42%.