- •Предисловие

- •Введение

- •Концептуальные основы информационных процессов.

- •О понятии «Информация» [1,2]

- •1.2. Виды и свойства информации [2].

- •1.3. Этапы обращения информации [1].

- •1.4. Информационные системы [1].

- •1.5. Система передачи информации [1].

- •1.6. Уровни проблем передачи информации [1].

- •1.7. О смысле «Теории информации» в системе связи [1].

- •2. Математические основы теории вероятностей [6,4].

- •2.1. Случайное событие и вероятность.

- •2.2 Случайные величины и их вероятностные характеристики.

- •Случайные функции и их вероятностное описание.

- •2.4 Корреляционные характеристики случайных процессов.

- •Дифференциальный; 2) интегральный;

- •3) Плотность вероятностей.

- •Дифференциальный; 2) интегральный; 3) числовой.

- •Свойства энтропии [1,3 и др.].

- •Условная энтропия и ее свойства [1,2 и др.].

- •Свойства условной энтропии

- •Энтропия непрерывного источника информации (дифференциальная энтропия) [1, 2 и др.].

- •Передача информации от дискретного источника [1 и др.].

- •Передача информации от непрерывного источника [1 и др.].

- •Основные свойства количества информации [1 и др.].

- •4. Информационные характеристики источника сообщений и канала связи.

- •4.1. Введение [1 и др.].

- •4.2. Информационные характеристики источника дискретных сообщений.

- •4.2.1 Модели источника дискретных сообщений [1 и др.].

- •4.2.2 Свойства эргодических последовательностей знаков [1 и др.].

- •4.2.3 Избыточность источника [1 и др.].

- •4.2.4 Производительность источника дискретных сообщений [1 и др.].

- •4.3. Информационные характеристики дискретных каналов связи.

- •4.3.1 Модели дискретных каналов [1, 4, 5 и др.].

- •Скорость передачи информации по дискретному каналу [1 и др.].

- •Пропускная способность дискретного канала без помех [1 и др.].

- •Пропускная способность дискретного канала с помехами [1 и др.].

- •Информационные характеристики непрерывных каналов связи [1 и др.].

- •Согласование физических характеристик сигнала и канала [1 и др.].

- •Согласование статистических свойств источника сообщений и канала связи [1 и др.].

- •4.6 Контрольные вопросы к разделам 3 и 4 в форме «Задание – тест» тема: «Количественная оценка информации».

- •1) Бод; 2) бит (двоичная цифра); 3) байт.

- •1) Сумма; 2) произведение; 3) разность.

- •1) Безусловной энтропией; 2) условной энтропией;

- •3) Совместной энтропией.

- •1) Объем алфавита;

- •2) Объем алфавита и вероятности создания источником отдельных знаков; 3) вероятности создания источником отдельных знаков.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) Нестационарным; 2) стационарным; 3) постоянным.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) С памятью; 2) без памяти; 3) регулярный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Симметричный; 2) несимметричный; 3) условный.

- •1) Максимальная скорость; 2) пропускная скорость; 3) предел скорости.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •1) Уменьшается; 2) увеличивается; 3) не изменяется.

- •5.2. Классификация кодов [4 и др.].

- •5.3. Представление кодов [4 и др.].

- •5.4. Оптимальное (эффективное) статистическое кодирование [3 и др.].

- •5.4.1 Методы эффективного кодирования некоррелированной последовательности знаков [1 и др.].

- •Методика построения кода Шеннона – Фано [1].

- •Методика построения кода Хаффмена [2 и др.].

- •5.4.2 Свойство префиксности эффективных кодов [1 и др.].

- •5.4.3 Методы эффективного кодирования коррелированной последовательности знаков.

- •5.4.4 Недостатки системы эффективного кодирования.

- •1) Номер разряда;

- •2) Множитель, принимающий целочисленные значения;

- •3) Количество разрядов.

- •Всякий блочный код можно представить таблицей:

- •Всякий блочный код можно представить таблицей:

- •Литература:

- •Содержание

Условная энтропия и ее свойства [1,2 и др.].

При оценке меры неопределенности выбора исхода опыта часто необходимо учитывать статистические связи, которые в большинстве случаев имеют место как между состояниями двух или нескольких источников, объединенных в рамках одной системы, так и между состояниями, последовательно выбираемыми одним источником.

Определим энтропию объединения двух статистически связанных ансамблей X и Y. Объединение ансамблей характеризуется матрицей p(X,Y) вероятностей p(xi, yj) всех возможных комбинаций состояний xi(1≤i≤N) ансамбля X и состояний yj(1≤j≤k) ансамбля Y:

![]() (3.12)

(3.12)

Суммируя столбы и строки матрицы (3.12), получим информацию об ансамблях X и Y исходных источников x и y:

![]()

При известных вероятностях p(xi, yj) появления пары (xi, yj) энтропия системы сигналов X, Y в соответствии с формулой (3.9) определяется выражением

(3.13)

Проанализируем это выражение. Согласно теореме умножения вероятностей,

![]() (3.14)

(3.14)

![]() (3.15)

(3.15)

Здесь p(yj)

и

p(xi)

– вероятности появления элементов

соответственно

![]() и

и

![]() ;

p(yj|xi)

– условная вероятность появления

элемента

при условии, что уже известен элемент

;

p(xi|yj)

– условная вероятность появления

элемента

при условии, что уже известен элемент

.

;

p(yj|xi)

– условная вероятность появления

элемента

при условии, что уже известен элемент

;

p(xi|yj)

– условная вероятность появления

элемента

при условии, что уже известен элемент

.

Подставив в формулу (3.13) и (3.14), получим

![]()

Учитывая, что log p(yj)p(xi|yj)=log p(yj)+log p(xi|yj), последнее выражение перепишем в виде

Имея в виду, что

![]() ,

получим

,

получим

![]()

Рассмотрим сумму

![]() .

Согласно формуле (3.5) эта сумма представляет

собой энтропию сигнала Y.

Сумма

.

Согласно формуле (3.5) эта сумма представляет

собой энтропию сигнала Y.

Сумма

![]() представляет собой случайную

величину, характеризующую неопределенность,

приходящуюся на одно состояние ансамбля

Y

при условии, реализовалась конкретное

состояние xi

ансамбля X.

Эта условная энтропия относительно

элемента yj

называется частной

условной энтропией.

Обозначим ее через H(X|yj).

В результате получим

представляет собой случайную

величину, характеризующую неопределенность,

приходящуюся на одно состояние ансамбля

Y

при условии, реализовалась конкретное

состояние xi

ансамбля X.

Эта условная энтропия относительно

элемента yj

называется частной

условной энтропией.

Обозначим ее через H(X|yj).

В результате получим

![]()

Сумма

![]() представляет собой усредненное значение

частной условной энтропии H(X|yj)

по всем возможным значениям сигнала Y

и называется

условной энтропией

сигнала X

относительно сигнала Y.

Обозначив условную энтропию через

H(X|Y),

получим

представляет собой усредненное значение

частной условной энтропии H(X|yj)

по всем возможным значениям сигнала Y

и называется

условной энтропией

сигнала X

относительно сигнала Y.

Обозначив условную энтропию через

H(X|Y),

получим

![]() (3.16)

(3.16)

Если в равенство (3.13) подставить выражение (3.15), а не (3.14), то после аналогичных преобразований получим

![]() (3.17)

(3.17)

Формулы (3.16) и (3.17) позволяет сделать вывод, что энтропия объединения двух сигналов X и Y равна энтропии одного из этих сигналов плюс условная энтропия второго сигнала относительно первого.

Свойства условной энтропии

Покажем, в каких пределах может изменятся энтропия объединения двух сигналов: X и Y. Выражение для условной энтропии в развернутой форме имеет вид

![]() (3.18)

(3.18)

Известно, что для независимых случайных событий условные вероятности равны безусловным. Предположив, что составляющие X и Y сигнала (X, Y) независимы, тогда в формуле (3.18) возможна замена p(xi|yj)=p(xi) и она может быть преобразована к виду

![]()

Учитывая, что

![]() ,

имеем

,

имеем

![]()

Таким образом, условная энтропия при независимых сигналах равна безусловной энтропии, и в этом случае формулы (3.16) и №.17) примут одинаковый вид: H(X, Y)=H(X)+H(Y).

Рассмотрим теперь другой крайний случай, когда сигналы X и Y полностью зависимы, т.е. если получена конкретная реализация сигнала X, то тем самым известна и реализация сигнала Y.

Пусть сигнал X принял значение xk. При этом известно, что сигнал Y с необходимостью примет значение ys. Это значит, что условная вероятность p(ys|xk)=1, все остальные условные вероятности p(yj|xi), (j, i)≠(s, k), примут нулевое значение. Тогда в формулу (3.18) будут входить слагаемые двух видов: либо p(xi)∙1∙log1, либо p(xi)∙0∙log0. И в этом и в другом случае эти слагаемые равны нулю, поэтому H(Y|X)=0.

Рассуждая аналогично, можно показать, что при полностью зависимых сигналах X и Y энтропия H(X|Y)=0.

Таким образом, в случае полной зависимости сигналов X и Y энтропия их объединения равна энтропии одного из этих сигналов H(X, Y)=H(X)=H(Y), т. е. каждый сигнал содержит всю информацию относительно другого сигнала.

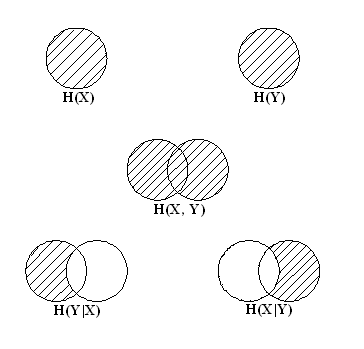

Уяснению соотношений между рассмотренными энтропиями дискретных источников информации (ансамблей) способствует их графическое отображение (рис. 3.2).

Рис. 3.2

Условное графическое представление H(X), H(Y), H(X, Y), H(Y|X) и H(X|Y).

Пример 3.3. Определить энтропию H(X), H(Y), H(X|Y), H(X, Y), если задана матрица вероятностей состояний системы, объединяющей источники x и y:

![]()

Вычисляем безусловные вероятности состояний каждой системы как суммы совместных вероятностей по строкам и столбцам заданной матрицы:

![]()

![]()

Определяем

условные вероятности

![]()

Проверим результат по формуле

![]()