- •1.Коньюнкция условий и разбиение пространства входа.

- •Композиция нечетких отношений.

- •Нечеткое инверсное управление и нечеткая система управления с внутренней моделью

- •Алгоритм жесткой кластеризации.

- •Операции над нечеткими множествами. Модификаторы.

- •8. Проектирование нечетких контроллеров (метод Мамдани)

- •2. Нечеткий контроллер с двумя входами и одним выходом

- •9.Нечеткая система управления с плановым изменением коэффициента.

- •10. Оценка параметров заключений по (мнк)

- •11. Адаптивные нейронные нечеткие системы инференции (anfis)

- •12.Импликация Мамдани. Внешнее произведение.Таблица импликаци

- •13. Нечеткая идентификация. Структура и параметры.

- •14. Нечеткий логический вывод для нескольких правил и нескольких входов.

- •Несколько входов (многомерная лингвистическая модель)

- •16. Функциональная схема нечеткого контроллера

- •17. Отношения между нечеткими множествами

- •18. Алгоритм нечеткой кластеризации с-средних

- •19. Моделирование статических объектов упр-я как аппроксимация функций с помощью нейронных сетей (есть только для динамических объектов)((((((((

- •20. Анализ устойчивости тс модели объекта управления в пространстве состояний.

- •22. Нечеткий логический вывод с исп-м отношений. Пример

- •24. Визуализация алгоритма нечеткого логического вывода.

- •25. Понятия о нечетких множествах

- •26. Обучение нейронной сети. Общие сведения.

- •27. Упрощение алгоритма нечеткого логического вывода.

- •28. Обратное распространение ошибки

- •29. Визуализация нечеткого логического вывода.Аккумуляция.

- •30. Параметры алгоритма с-средних

- •31. Проектирование нечетких контроллеров (метод Мамдани)

- •32. Нечеткая логика. Логические связки.

- •33.Проектирование нечетких контроллеров(метод Мамдани). Многомерный нечеткий контроллер.

- •34. Алгоритм обучения anfis

- •35. Максиминная композиция нечетких отношений. Внутренне произведение. Пример.

- •36. Преобразование вход-выход. Кривая управления. Пов-ть управления.

- •37. Табличное изменение коэффициента усиления (супервизорное управление)

- •38. Алгоритм нечеткой кластеризации Густафсона–Кесселя.

- •39. Генетические алгоритмы

- •40. Извлечение правил с помощью кластеризации

- •41.Нечеткий сумматор для контроллеров с 2 входами и 1 выходом

- •42. Нейросетевое прямое и косвенное адаптивное управление с эталонной моделью

- •43. Обратное распространение ошибки. Обновление весовых коэф-в скрытых слоев. Локальные градиенты.

- •44. Модель Такаги-Сугено как квазилинейное устройство

- •45. Контроллер типа Такаги-Сугено

- •46. Нейросетевое управление с адаптивной линеаризацией обратной связью

- •48. Такаги-Сугено модель оу в пространстве состояний

- •49. Нечеткие множества. Синглтоны и лингвистические переменные.

- •50. Моделирование нелинейных динамических оу с помощью нейронных сетей

- •51. Структура интеллектуальной системы управления

- •52. Многослойная нейронная сеть

- •53. Дефаззификация. Методы дефаззификации.

- •54. Нейронная сеть с радиальными базисными функциями

- •56. Синтез нечеткой обратной связи

- •57. Линейные матричные неравенства, основные понятия.

- •58. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •59. Классификация генетических нечетких систем

- •60. Синтез нейронных нечетких сетей. Структура anfis

- •19. Моделирование статических объектов управления как аппроксимация функций с помощью нейронных сетей.

- •Адаптивные нейронные нечеткие системы интерференции (anfis). . Синтез нечетких нейронных сетей

- •5.1. Введение

- •Адаптивные нейронечеткие системы инференции (anfis)

- •Импликация Мамдани. Внешнее произведение. Таблица импликации.

- •Нечеткая идентификация. Структура и параметры

- •Нечеткий логический вывод для нескольких правил и нескольких входов.

- •1. Настройка пид-регулятора

- •3. Перенос параметров пид-регулятора в нечеткий контроллер

- •Анализ устойчивости тс модели объекта управления в пространстве состояний. Анализ устойчивости тс модели объекта

- •1. Настройка пид-регулятора

- •Нечеткий логический вывод (инференция). Пример.

- •Визуализация нечеткого логического вывода. Агрегирование условий и активизация заключений.

- •Математическая модель нейрона. Математическая модель нейрона

- •Нечеткое управление с предсказанием.

- •Визуализация нечеткого логического вывода. Аккумуляция заключений.

- •5.1. Введение

- •Алгоритм обучения anfis

- •Максиминная композиция нечетких отношений. Внутреннее произведение. Пример.

- •Преобразование вход-выход для нечетких контроллеров. Кривая управления и поверхность управления.

- •2.4. Преобразование вход-выход

- •Табличное изменениекоэффициентаусиления (супервизорное управление).

- •2.8. Табличное изменение коэффициента усиления (супервизорное управление)

- •Алгоритм нечеткой кластеризации Густафсона-Кесселя.

- •Генетические алгоритмы. Генетические алгоритмы

- •Модель Такаги-Сугено как квазилинейное (аффинное) устройство. Модель Такаги-Сугено как квазилинейное устройство

- •Контроллер типа Такаги-Сугено.

- •Деффазификация. Методы деффазификации.

- •2.2.5. Дефаззификация

- •Теорема б универсальной аппроксимации.

- •Такаги-Сугено модель объекта управления в пространстве состояний.

- •Табличный контроллер. Билинейная интерполяция.

- •2.3. Табличный контроллер

- •Моделирование нелинейных динамических объектов управления с помощью нейронных сетей.

- •Моделирование нелинейных динамических процессов (объектов)

- •Упрощение алгоритма нечеткого логического вывода.

- •Обратное распространение ошибки. Обновление весовых коэффициентов выходного слоя.

- •4.6. Обратное распространение ошибки

- •Структура интеллектуальной системы управления.

- •Многослойная нейронная сеть. Многослойная нейронная сеть

- •5.1. Введение

- •Структура anfis

57. Линейные матричные неравенства, основные понятия.

58. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

Рассмотрим задачу

реализации нелинейных алгебраических

зависимостей нейронными сетями.

Приведенный выше персептрон может

аппроксимировать произвольную гладкую

функцию. В качестве примера запишем

выходной сигнал сети с одним выходом

y

и одним входом u,

состоящей из одного скрытого слоя с

двумя нелинейными нейронами и выходного

слоя из одного линейного нейрона (с

линейной активационной функцией)

.

(28). Внутренние входы v1

и v2

скрытых нейронов определяются выражениями

.

(29). Пусть функция активации f

(v)

скрытых нейронов является функцией

tangh(v)

(гиперболический

тангенс). При этом график зависимости

y=g(u)

при

найденных

в результате

обучения

значениях весовых коэффициентов w0

, wh

и смещений

bh

можно

построить, как показано на рис. 8. Здесь

=

,

![]() =

-

,

=

=1.

=

-

,

=

=1.

Рис. 8

Изменяя веса и смещения в соответствии с обучающей выборкой,

получаем гладкую кривую, аппроксимирующую вход нейронной сети.

Эффективность использования нейронных сетей устанавливается

теоремой о полноте. Смысл этой теоремы в том (Cybenko, 1989), что

персептрон, по меньшей мере, с одним скрытым слоем, способен

аппроксимировать любую непрерывную функцию с

произвольной степенью точности при условии выбора достаточного числа

нейронов скрытого слоя.

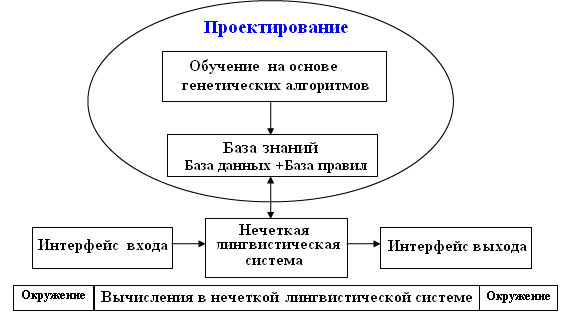

59. Классификация генетических нечетких систем

Нечеткие системы успешно применяются в задачах моделирования и управления, и в значительном числе приложений. В большинстве случаев ключом для успешного применения служит способность нечетких систем встраивать знания экспертов.

Появилось 2 подхода к изучению нечетких систем, дополненных способностями к обучению:

гибридизация, осуществленная в рамках мягких вычислений с помощью других технологий, таких как, нейронные сети и эволюционные вычисления, которые придают нечетким системам способность к обучению (рис. 5). Нейро-нечеткие системы являются одним из самых успешных и очевидных направлений этих усилий.

генетические нечеткие системы (ГНС).

ГНС в сущности представляет собой нечеткую систему, расширенную за счет процесса обучения, основанного на генетическом алгоритме (ГА). Самыми заметными приложениями ГНС являются генетические нечеткие лингвистические системы (ГНЛС), в которых генетический процесс обучает или настраивает различные компоненты нечетких лингвистических систем, т.е. систем построенных исключительно с помощью правил в отличие от нечетких систем Такаги-Сугено.

Недостатки проектирования нечетких лингвистических систем с помощью экспертов:

Не всегда можно найти сведущего эксперта;

Извлечение знаний из эксперта отнимает много времени;

Системы, построенные на приобретенных с помощью эксперта знаниях, работают плохо.

Присущая ГА гибкость и способность

встраивать полученные от экспертов

знания являются весьма важным свойством

с точки зрения решаемых задач. Другие

подходы включают генетические

нейронечеткие системы и генетическую

нечеткую кластеризацию.

Присущая ГА гибкость и способность

встраивать полученные от экспертов

знания являются весьма важным свойством

с точки зрения решаемых задач. Другие

подходы включают генетические

нейронечеткие системы и генетическую

нечеткую кластеризацию.

Проектирование нечетких систем

Нечеткие системы включают два главных компонента:

1.Базу знаний (БЗ), в которой хранятся доступные или приобретенные знания о задаче, требующей решения, в форме нечетких правил;

2.Механизм инференции, использующий методы нечетких рассуждений, базирующиеся на базе правил и входных сигналах, для получения выходного сигнала системы.

Оба этих компонента должны быть спроектированы так, чтобы построить систему для конкретного приложения:

БЗ формируют из знаний экспертов или путем обучения с помощью машинных методов;

Механизм инференции строят путем выбора нечетких операторов для каждого компонента (конъюнкция, импликация, дефаззификация и т.п.).

В ряде случаев операторы также параметризуются и могут быть настроены автоматическими методами.

Проектирование БЗ затрагивает две подзадачи:

1. Определение базы данных (БД):

Универсум для переменных;

Масштабирующие коэффициенты или функции;

Число лингвистических терм для каждой переменной;

Функции принадлежности, описывающие термы.

2. Составление базы правил (БП): формулировка базовых правил. Как уже отмечено, существуют два различных метода для проектирования базы знаний (БЗ): информация от экспертов и с помощью нечеткого моделирования.

Классификация генетических нечетких систем

Первый шаг в проектировании ГНЛС решить вопрос о том, какая часть нечеткой системы подлежит оптимизации путем кодирования ее параметров в хромосомы. В этом разделе мы представим классификацию ГНЛС, соответствующую различным частям нечеткой системы, кодируемым с помощью генетической модели. Обычно методы проектирования ГНЛС разделяют на два процесса, настройка (т.е. адаптация) и обучение.

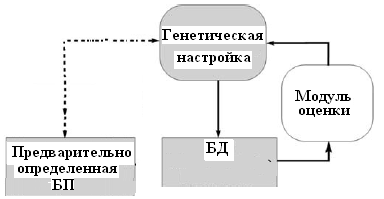

Генетическая настройка. Если существует БЗ, мы применяем процесс генетической настройки для улучшения свойств нечеткой системы, но не изменяем БП. Т.е. мы настраиваем параметры НЛС с целью улучшения ее свойств, сохраняя неизменной БП.

Генетическое обучение. Вторая возможность обучать компоненты БП, к которым можно отнести адаптацию механизма инференции. Т.е. мы затрагиваем обучение компонентов БП, наряду с другими компонентами НЛС.

Г

енетическая

настройка базы знаний. Осуществляется

путем определения предварительно вида

и параметров масштабирующих функций

входа и выхода, а также функций

принадлежности, и затем настройки этих

параметров и тем самым изменения формы

масштабирующих функций и функций

принадлежности с помощью ГА (рис.

справа).

енетическая

настройка базы знаний. Осуществляется

путем определения предварительно вида

и параметров масштабирующих функций

входа и выхода, а также функций

принадлежности, и затем настройки этих

параметров и тем самым изменения формы

масштабирующих функций и функций

принадлежности с помощью ГА (рис.

справа).Генетическое обучение базы правил. Генетическое обучение БП предполагает предопределенное множество функций принадлежности в БД, к которым правила обращается посредством лингвистических терм.

Имеется три главных подхода: питтсбургский, мичиганский и итеративный методы обучения. Питтсбургский «хромосома=набор правил», сохраняя неизменной популяцию кандидатов на роль правил и, используя селекцию, и генетические операторы для создания новых поколений наборов правил. Мичиганский «хромосома=правило» и набор правил представляется всей популяцией. В третьем случае, итеративном методе с помощью хромосом кодируют отдельные правила, и новое правило настраивается и добавляется в набор правил, итеративным способом.