- •1.Коньюнкция условий и разбиение пространства входа.

- •Композиция нечетких отношений.

- •Нечеткое инверсное управление и нечеткая система управления с внутренней моделью

- •Алгоритм жесткой кластеризации.

- •Операции над нечеткими множествами. Модификаторы.

- •8. Проектирование нечетких контроллеров (метод Мамдани)

- •2. Нечеткий контроллер с двумя входами и одним выходом

- •9.Нечеткая система управления с плановым изменением коэффициента.

- •10. Оценка параметров заключений по (мнк)

- •11. Адаптивные нейронные нечеткие системы инференции (anfis)

- •12.Импликация Мамдани. Внешнее произведение.Таблица импликаци

- •13. Нечеткая идентификация. Структура и параметры.

- •14. Нечеткий логический вывод для нескольких правил и нескольких входов.

- •Несколько входов (многомерная лингвистическая модель)

- •16. Функциональная схема нечеткого контроллера

- •17. Отношения между нечеткими множествами

- •18. Алгоритм нечеткой кластеризации с-средних

- •19. Моделирование статических объектов упр-я как аппроксимация функций с помощью нейронных сетей (есть только для динамических объектов)((((((((

- •20. Анализ устойчивости тс модели объекта управления в пространстве состояний.

- •22. Нечеткий логический вывод с исп-м отношений. Пример

- •24. Визуализация алгоритма нечеткого логического вывода.

- •25. Понятия о нечетких множествах

- •26. Обучение нейронной сети. Общие сведения.

- •27. Упрощение алгоритма нечеткого логического вывода.

- •28. Обратное распространение ошибки

- •29. Визуализация нечеткого логического вывода.Аккумуляция.

- •30. Параметры алгоритма с-средних

- •31. Проектирование нечетких контроллеров (метод Мамдани)

- •32. Нечеткая логика. Логические связки.

- •33.Проектирование нечетких контроллеров(метод Мамдани). Многомерный нечеткий контроллер.

- •34. Алгоритм обучения anfis

- •35. Максиминная композиция нечетких отношений. Внутренне произведение. Пример.

- •36. Преобразование вход-выход. Кривая управления. Пов-ть управления.

- •37. Табличное изменение коэффициента усиления (супервизорное управление)

- •38. Алгоритм нечеткой кластеризации Густафсона–Кесселя.

- •39. Генетические алгоритмы

- •40. Извлечение правил с помощью кластеризации

- •41.Нечеткий сумматор для контроллеров с 2 входами и 1 выходом

- •42. Нейросетевое прямое и косвенное адаптивное управление с эталонной моделью

- •43. Обратное распространение ошибки. Обновление весовых коэф-в скрытых слоев. Локальные градиенты.

- •44. Модель Такаги-Сугено как квазилинейное устройство

- •45. Контроллер типа Такаги-Сугено

- •46. Нейросетевое управление с адаптивной линеаризацией обратной связью

- •48. Такаги-Сугено модель оу в пространстве состояний

- •49. Нечеткие множества. Синглтоны и лингвистические переменные.

- •50. Моделирование нелинейных динамических оу с помощью нейронных сетей

- •51. Структура интеллектуальной системы управления

- •52. Многослойная нейронная сеть

- •53. Дефаззификация. Методы дефаззификации.

- •54. Нейронная сеть с радиальными базисными функциями

- •56. Синтез нечеткой обратной связи

- •57. Линейные матричные неравенства, основные понятия.

- •58. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •59. Классификация генетических нечетких систем

- •60. Синтез нейронных нечетких сетей. Структура anfis

- •19. Моделирование статических объектов управления как аппроксимация функций с помощью нейронных сетей.

- •Адаптивные нейронные нечеткие системы интерференции (anfis). . Синтез нечетких нейронных сетей

- •5.1. Введение

- •Адаптивные нейронечеткие системы инференции (anfis)

- •Импликация Мамдани. Внешнее произведение. Таблица импликации.

- •Нечеткая идентификация. Структура и параметры

- •Нечеткий логический вывод для нескольких правил и нескольких входов.

- •1. Настройка пид-регулятора

- •3. Перенос параметров пид-регулятора в нечеткий контроллер

- •Анализ устойчивости тс модели объекта управления в пространстве состояний. Анализ устойчивости тс модели объекта

- •1. Настройка пид-регулятора

- •Нечеткий логический вывод (инференция). Пример.

- •Визуализация нечеткого логического вывода. Агрегирование условий и активизация заключений.

- •Математическая модель нейрона. Математическая модель нейрона

- •Нечеткое управление с предсказанием.

- •Визуализация нечеткого логического вывода. Аккумуляция заключений.

- •5.1. Введение

- •Алгоритм обучения anfis

- •Максиминная композиция нечетких отношений. Внутреннее произведение. Пример.

- •Преобразование вход-выход для нечетких контроллеров. Кривая управления и поверхность управления.

- •2.4. Преобразование вход-выход

- •Табличное изменениекоэффициентаусиления (супервизорное управление).

- •2.8. Табличное изменение коэффициента усиления (супервизорное управление)

- •Алгоритм нечеткой кластеризации Густафсона-Кесселя.

- •Генетические алгоритмы. Генетические алгоритмы

- •Модель Такаги-Сугено как квазилинейное (аффинное) устройство. Модель Такаги-Сугено как квазилинейное устройство

- •Контроллер типа Такаги-Сугено.

- •Деффазификация. Методы деффазификации.

- •2.2.5. Дефаззификация

- •Теорема б универсальной аппроксимации.

- •Такаги-Сугено модель объекта управления в пространстве состояний.

- •Табличный контроллер. Билинейная интерполяция.

- •2.3. Табличный контроллер

- •Моделирование нелинейных динамических объектов управления с помощью нейронных сетей.

- •Моделирование нелинейных динамических процессов (объектов)

- •Упрощение алгоритма нечеткого логического вывода.

- •Обратное распространение ошибки. Обновление весовых коэффициентов выходного слоя.

- •4.6. Обратное распространение ошибки

- •Структура интеллектуальной системы управления.

- •Многослойная нейронная сеть. Многослойная нейронная сеть

- •5.1. Введение

- •Структура anfis

38. Алгоритм нечеткой кластеризации Густафсона–Кесселя.

В классическом алгоритме с-cредних

расстояние между вектором xj

и центром νi

кластера определяется, как евклидова

норма

классическом алгоритме с-cредних

расстояние между вектором xj

и центром νi

кластера определяется, как евклидова

норма

![]() (20).

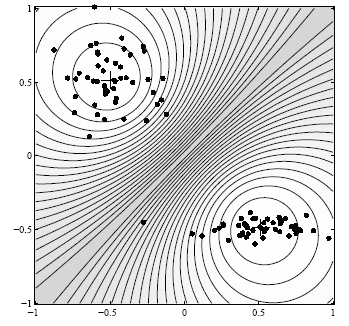

Определённое таким образом расстояние

учитывалось в формуле (16), характеризующей

значение целевой функции. При подобном

задании меры расстояния между двумя

векторами множество точек, равноудалённых

от центра кластера, (контурных линий)

принимает форму окружности с одинаковым

масштабом по всем координатам (рис. 8).

Если входные данные образуют группы,

форма которых отличается от окружности,

либо если шкалы значений отдельных

координат вектора сильно различаются,

рассчитанные значения не будут адекватно

отражать принадлежность векторов x

конкретным кластерам. В такой

ситуации качество группирования можно

существенно повысить за счет применения

усовершенствованной версии алгоритма

кластеризации, называемой алгоритмом

Густафсона – Кесселя( ГК-алгоритм).

Густафсон и Кессель расширили стандартный

алгоритм нечетких с-средних путем

использования адаптивной нормы расстояния

для того, чтобы обнаруживать кластеры

различной геометрической формы в одном

и том же множестве данных. По отношению

к алгоритму c-средних

главное изменение состоит в том, каждый

кластер имеет свою собственную

нормо-индуцирующую матрицу Аi.

При этом масштабированное расстояние

между вектором xj

и центром νi

определяется как норма внутреннего

произведения

(20).

Определённое таким образом расстояние

учитывалось в формуле (16), характеризующей

значение целевой функции. При подобном

задании меры расстояния между двумя

векторами множество точек, равноудалённых

от центра кластера, (контурных линий)

принимает форму окружности с одинаковым

масштабом по всем координатам (рис. 8).

Если входные данные образуют группы,

форма которых отличается от окружности,

либо если шкалы значений отдельных

координат вектора сильно различаются,

рассчитанные значения не будут адекватно

отражать принадлежность векторов x

конкретным кластерам. В такой

ситуации качество группирования можно

существенно повысить за счет применения

усовершенствованной версии алгоритма

кластеризации, называемой алгоритмом

Густафсона – Кесселя( ГК-алгоритм).

Густафсон и Кессель расширили стандартный

алгоритм нечетких с-средних путем

использования адаптивной нормы расстояния

для того, чтобы обнаруживать кластеры

различной геометрической формы в одном

и том же множестве данных. По отношению

к алгоритму c-средних

главное изменение состоит в том, каждый

кластер имеет свою собственную

нормо-индуцирующую матрицу Аi.

При этом масштабированное расстояние

между вектором xj

и центром νi

определяется как норма внутреннего

произведения

![]() (21).

Матрицы Аi

используются как оптимизируемые

переменные в целевой функции для

с-средних, что позволяет каждому

кластеру адаптировать норму расстояния

к топологической структуре данных.

Целевая функция для ГК алгоритма

определяется выражением

(21).

Матрицы Аi

используются как оптимизируемые

переменные в целевой функции для

с-средних, что позволяет каждому

кластеру адаптировать норму расстояния

к топологической структуре данных.

Целевая функция для ГК алгоритма

определяется выражением

.

Целевая функция для ГК алгоритма не

может быть непосредственно минимизирована

относительно Аi,

т.к. она (функция) является линейной по

отношению к Аi.

Чтобы найти допустимое (подходящее)

решение, надо каким-нибудь путем

ограничить Аi.

Обычный путь достигнуть этого ограничить

величину определителя Аi:

.

Целевая функция для ГК алгоритма не

может быть непосредственно минимизирована

относительно Аi,

т.к. она (функция) является линейной по

отношению к Аi.

Чтобы найти допустимое (подходящее)

решение, надо каким-нибудь путем

ограничить Аi.

Обычный путь достигнуть этого ограничить

величину определителя Аi:![]() .

Позволение матрице Аi

изменять свою величину при фиксированном

значении ее определителя соответствует

оптимизации формы кластера при сохранении

его объема постоянным. Путем использования

метода множителей Лагранжа Густафсоном

и Кесселем было найдено следующее

выражение для Аi:

.

Позволение матрице Аi

изменять свою величину при фиксированном

значении ее определителя соответствует

оптимизации формы кластера при сохранении

его объема постоянным. Путем использования

метода множителей Лагранжа Густафсоном

и Кесселем было найдено следующее

выражение для Аi:

![]() ,

где Fi

представляет собой нечеткую ковариационную

матрицу i-го кластера,

определяемую как

,

где Fi

представляет собой нечеткую ковариационную

матрицу i-го кластера,

определяемую как

.Заметим,

что подстановка двух последних выражений

в (21)

дает обобщенный квадрат нормы Махаланобиса

для расстояния. Алгоритм ГК является

более сложным, чем алгоритм нечетких

с-средних,

т.к. в каждой итерации должны быть

вычислены инверсия и определитель

ковариационной матрицы.

.Заметим,

что подстановка двух последних выражений

в (21)

дает обобщенный квадрат нормы Махаланобиса

для расстояния. Алгоритм ГК является

более сложным, чем алгоритм нечетких

с-средних,

т.к. в каждой итерации должны быть

вычислены инверсия и определитель

ковариационной матрицы.

Алгоритм Густафсона-Кесселя может быть сформулирован в следующем виде.

Дано

множество данных X,

выбрать число кластеров 1<c<K,

параметр нечеткости m>1

, критерий остановки алгоритма

и объемы кластеров

![]() i.

Инициализировать случайным образом

матрицу разделения M

(0).

i.

Инициализировать случайным образом

матрицу разделения M

(0).

Повторять для l=1,2,…

1.Рассчитать размещение центров (кластерных прототипов) в соответствии с формулой

,

,

![]()

2. Вычислить ковариационную матрицу для кластеров

,

,

3.Вычислить расстояния

4.Обновить

матрицу разделения (матрицу степеней

принадлежности всех векторов

![]() ,

j

= 1, 2,

...,K,

к

центрам νi,

i=

1, 2,

..., с,):

Для

,

j

= 1, 2,

...,K,

к

центрам νi,

i=

1, 2,

..., с,):

Для

![]() ,

Если

,

Если

![]() >0 для всех i=1,2,…,c

>0 для всех i=1,2,…,c

,

иначе

,

иначе

![]() =0,

если

>0, и

=0,

если

>0, и

![]() ,

,

![]() .

.

До ||M (l)- M (l-1)||< .

Если последние изменения положений центров и матрицы ковариации пренебрежимо малы по отношению к предыдущим значениям и не превышают изначально заданной пороговой величины ε, то завершить итерационный процесс; в противном случае перейти к п. 2.

Функционирующий таким образом алгоритм обучения параллельно генерирует все центры самоорганизующихся кластеров и связанные с ними нормо-индуцирующие матрицы, используемые при расчете расстояний. Значения элементов нормо-индуцирующих матриц и положения центров фиксируются по завершению процесса обучения и могут использоваться в режиме эксплуатации системы.