- •1.Коньюнкция условий и разбиение пространства входа.

- •Композиция нечетких отношений.

- •Нечеткое инверсное управление и нечеткая система управления с внутренней моделью

- •Алгоритм жесткой кластеризации.

- •Операции над нечеткими множествами. Модификаторы.

- •8. Проектирование нечетких контроллеров (метод Мамдани)

- •2. Нечеткий контроллер с двумя входами и одним выходом

- •9.Нечеткая система управления с плановым изменением коэффициента.

- •10. Оценка параметров заключений по (мнк)

- •11. Адаптивные нейронные нечеткие системы инференции (anfis)

- •12.Импликация Мамдани. Внешнее произведение.Таблица импликаци

- •13. Нечеткая идентификация. Структура и параметры.

- •14. Нечеткий логический вывод для нескольких правил и нескольких входов.

- •Несколько входов (многомерная лингвистическая модель)

- •16. Функциональная схема нечеткого контроллера

- •17. Отношения между нечеткими множествами

- •18. Алгоритм нечеткой кластеризации с-средних

- •19. Моделирование статических объектов упр-я как аппроксимация функций с помощью нейронных сетей (есть только для динамических объектов)((((((((

- •20. Анализ устойчивости тс модели объекта управления в пространстве состояний.

- •22. Нечеткий логический вывод с исп-м отношений. Пример

- •24. Визуализация алгоритма нечеткого логического вывода.

- •25. Понятия о нечетких множествах

- •26. Обучение нейронной сети. Общие сведения.

- •27. Упрощение алгоритма нечеткого логического вывода.

- •28. Обратное распространение ошибки

- •29. Визуализация нечеткого логического вывода.Аккумуляция.

- •30. Параметры алгоритма с-средних

- •31. Проектирование нечетких контроллеров (метод Мамдани)

- •32. Нечеткая логика. Логические связки.

- •33.Проектирование нечетких контроллеров(метод Мамдани). Многомерный нечеткий контроллер.

- •34. Алгоритм обучения anfis

- •35. Максиминная композиция нечетких отношений. Внутренне произведение. Пример.

- •36. Преобразование вход-выход. Кривая управления. Пов-ть управления.

- •37. Табличное изменение коэффициента усиления (супервизорное управление)

- •38. Алгоритм нечеткой кластеризации Густафсона–Кесселя.

- •39. Генетические алгоритмы

- •40. Извлечение правил с помощью кластеризации

- •41.Нечеткий сумматор для контроллеров с 2 входами и 1 выходом

- •42. Нейросетевое прямое и косвенное адаптивное управление с эталонной моделью

- •43. Обратное распространение ошибки. Обновление весовых коэф-в скрытых слоев. Локальные градиенты.

- •44. Модель Такаги-Сугено как квазилинейное устройство

- •45. Контроллер типа Такаги-Сугено

- •46. Нейросетевое управление с адаптивной линеаризацией обратной связью

- •48. Такаги-Сугено модель оу в пространстве состояний

- •49. Нечеткие множества. Синглтоны и лингвистические переменные.

- •50. Моделирование нелинейных динамических оу с помощью нейронных сетей

- •51. Структура интеллектуальной системы управления

- •52. Многослойная нейронная сеть

- •53. Дефаззификация. Методы дефаззификации.

- •54. Нейронная сеть с радиальными базисными функциями

- •56. Синтез нечеткой обратной связи

- •57. Линейные матричные неравенства, основные понятия.

- •58. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •59. Классификация генетических нечетких систем

- •60. Синтез нейронных нечетких сетей. Структура anfis

- •19. Моделирование статических объектов управления как аппроксимация функций с помощью нейронных сетей.

- •Адаптивные нейронные нечеткие системы интерференции (anfis). . Синтез нечетких нейронных сетей

- •5.1. Введение

- •Адаптивные нейронечеткие системы инференции (anfis)

- •Импликация Мамдани. Внешнее произведение. Таблица импликации.

- •Нечеткая идентификация. Структура и параметры

- •Нечеткий логический вывод для нескольких правил и нескольких входов.

- •1. Настройка пид-регулятора

- •3. Перенос параметров пид-регулятора в нечеткий контроллер

- •Анализ устойчивости тс модели объекта управления в пространстве состояний. Анализ устойчивости тс модели объекта

- •1. Настройка пид-регулятора

- •Нечеткий логический вывод (инференция). Пример.

- •Визуализация нечеткого логического вывода. Агрегирование условий и активизация заключений.

- •Математическая модель нейрона. Математическая модель нейрона

- •Нечеткое управление с предсказанием.

- •Визуализация нечеткого логического вывода. Аккумуляция заключений.

- •5.1. Введение

- •Алгоритм обучения anfis

- •Максиминная композиция нечетких отношений. Внутреннее произведение. Пример.

- •Преобразование вход-выход для нечетких контроллеров. Кривая управления и поверхность управления.

- •2.4. Преобразование вход-выход

- •Табличное изменениекоэффициентаусиления (супервизорное управление).

- •2.8. Табличное изменение коэффициента усиления (супервизорное управление)

- •Алгоритм нечеткой кластеризации Густафсона-Кесселя.

- •Генетические алгоритмы. Генетические алгоритмы

- •Модель Такаги-Сугено как квазилинейное (аффинное) устройство. Модель Такаги-Сугено как квазилинейное устройство

- •Контроллер типа Такаги-Сугено.

- •Деффазификация. Методы деффазификации.

- •2.2.5. Дефаззификация

- •Теорема б универсальной аппроксимации.

- •Такаги-Сугено модель объекта управления в пространстве состояний.

- •Табличный контроллер. Билинейная интерполяция.

- •2.3. Табличный контроллер

- •Моделирование нелинейных динамических объектов управления с помощью нейронных сетей.

- •Моделирование нелинейных динамических процессов (объектов)

- •Упрощение алгоритма нечеткого логического вывода.

- •Обратное распространение ошибки. Обновление весовых коэффициентов выходного слоя.

- •4.6. Обратное распространение ошибки

- •Структура интеллектуальной системы управления.

- •Многослойная нейронная сеть. Многослойная нейронная сеть

- •5.1. Введение

- •Структура anfis

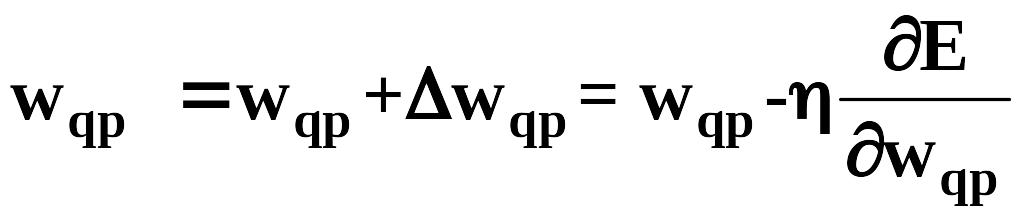

28. Обратное распространение ошибки

Метод обратного распространения ошибки

представляет собой популярную процедуру

обучения многослойного персептрона.

Он основан на дельта-правиле и использует

критерий качества обучения (сумму

квадратов ошибок ej=dj-yj)

(5) для нейронов выходного слоя. Этот

критерий есть сумма квадратов ошибок,

получаемых на выходе каждого нейрона

выходного слоя. Весовой коэффициент

(5) для нейронов выходного слоя. Этот

критерий есть сумма квадратов ошибок,

получаемых на выходе каждого нейрона

выходного слоя. Весовой коэффициент

![]() передачи

сигнала от p-го нейрона

предыдущего слоя к q-му

нейрону последующего слоя обновляется

в соответствии с обобщенным

дельта-правилом

передачи

сигнала от p-го нейрона

предыдущего слоя к q-му

нейрону последующего слоя обновляется

в соответствии с обобщенным

дельта-правилом (6).

Чтобы обозначения были более понятными,

мы опустили индекс обучающего образца

k; очевидно, что

уравнение (6) является рекуррентным,

т.е.

в его левой части представляет новое

значение весового коэффициента, в то

время как

в правой части является прежним весом.

Здесь

(6).

Чтобы обозначения были более понятными,

мы опустили индекс обучающего образца

k; очевидно, что

уравнение (6) является рекуррентным,

т.е.

в его левой части представляет новое

значение весового коэффициента, в то

время как

в правой части является прежним весом.

Здесь

![]() - параметр скорости обучения. В обобщенном

дельта-правиле корректировка весового

коэффициента

- параметр скорости обучения. В обобщенном

дельта-правиле корректировка весового

коэффициента

![]() пропорциональна градиенту ошибки

пропорциональна градиенту ошибки

![]() /

/![]() ,

другими словами, чувствительности

критерия качества к изменению весового

коэффициента. Чтобы применить данный

алгоритм, необходимы два цикла вычислений,

прямое распространение и обратное

распространение. В прямом цикле

вычислений веса остаются неизменными.

Прямое распространение сигнала начинается

в последнем скрытом слое, ведя счет от

выходного слоя, путем подачи на его вход

образцового входного векторного сигнала

и заканчивается в выходном слое после

вычисления сигнала ошибки (разности

между образцовым выходным сигналом и

выходным сигналом нейрона) для каждого

нейрона выходного слоя. Обратное

распространение сигнала начинается в

выходном слое и продолжается путем

распространения сигнала ошибки назад

справа налево через всю сеть, слой за

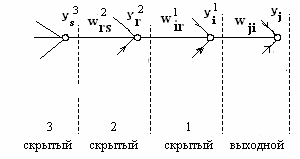

слоем. Для описания алгоритма обратного

распространения сигнала ошибки

предположим, что j

– й нейрон является нейроном выходного

слоя (рис. 7). На рис. 7 показаны в явном

виде связи между нейроном j

выходного слоя, нейроном i

скрытого слоя 1, нейроном r

скрытого слоя 2 и нейроном s

скрытого слоя 3.

,

другими словами, чувствительности

критерия качества к изменению весового

коэффициента. Чтобы применить данный

алгоритм, необходимы два цикла вычислений,

прямое распространение и обратное

распространение. В прямом цикле

вычислений веса остаются неизменными.

Прямое распространение сигнала начинается

в последнем скрытом слое, ведя счет от

выходного слоя, путем подачи на его вход

образцового входного векторного сигнала

и заканчивается в выходном слое после

вычисления сигнала ошибки (разности

между образцовым выходным сигналом и

выходным сигналом нейрона) для каждого

нейрона выходного слоя. Обратное

распространение сигнала начинается в

выходном слое и продолжается путем

распространения сигнала ошибки назад

справа налево через всю сеть, слой за

слоем. Для описания алгоритма обратного

распространения сигнала ошибки

предположим, что j

– й нейрон является нейроном выходного

слоя (рис. 7). На рис. 7 показаны в явном

виде связи между нейроном j

выходного слоя, нейроном i

скрытого слоя 1, нейроном r

скрытого слоя 2 и нейроном s

скрытого слоя 3.

З аменяя

в

(6) q на j

и p на i,

получаем формулу для настройки весовых

коэффициентов выходного слоя

аменяя

в

(6) q на j

и p на i,

получаем формулу для настройки весовых

коэффициентов выходного слоя

(6а).

Используя цепное правило дифференцирования,

запишем производную, входящую в уравнение

(6а), в виде

(6а).

Используя цепное правило дифференцирования,

запишем производную, входящую в уравнение

(6а), в виде (7). Здесь с учетом (5)

(7). Здесь с учетом (5)

![]() =

=![]() =

=![]() -

-![]() есть

ошибка j-го нейрона,

есть выход j-го

нейрона,

есть

ошибка j-го нейрона,

есть выход j-го

нейрона,

есть внутренний вход j-го

нейрона, полученный на основании (4c)

есть внутренний вход j-го

нейрона, полученный на основании (4c)

,

после суммирования взвешенных выходов

всех нейронов m1

предшествующего первого скрытого слоя,

в том числе выхода

,

после суммирования взвешенных выходов

всех нейронов m1

предшествующего первого скрытого слоя,

в том числе выхода

![]() i-го нейрона этого

слоя,

i-го нейрона этого

слоя,

![]() есть весовой коэффициент передачи

сигнала от i-го нейрона

первого скрытого слоя к входу j-го

нейрона выходного слоя. При этом

есть весовой коэффициент передачи

сигнала от i-го нейрона

первого скрытого слоя к входу j-го

нейрона выходного слоя. При этом

![]() ,где

,где

![]() -

активационная функция. Как

-

активационная функция. Как

![]() обозначена производная от функции

по ее аргументу. С учетом

(7) и (4c) при c=

m1, находим

с помощью

(6а)

обозначена производная от функции

по ее аргументу. С учетом

(7) и (4c) при c=

m1, находим

с помощью

(6а)

,

(8) где

,

(8) где

![]() (8a).

Как видим, для обновления весовых

коэффициентов выходного слоя надо

найти ошибку

,

выход

i-го первого скрытого

слоя и производную

.

(8a).

Как видим, для обновления весовых

коэффициентов выходного слоя надо

найти ошибку

,

выход

i-го первого скрытого

слоя и производную

.

Алгоритм. Алгоритм обратного распространения включает пять шагов.

а) Инициализация весовых коэффициентов. Установите все весовые коэффициенты равными небольшим случайным числам.

б) Предъявление входов и соответствующих им желаемых выходов (обучающие пары). Подаем на нейронную сеть вектор входа u и соответствующий желаемый вектор выхода d. Вход может быть новым в каждой новой попытке обучения или образцы из обучающего множества могут подаваться на сеть циклически до тех пор, пока весовые коэффициенты не стабилизируются, т.е. перестанут изменяться.

в) Вычисление действительных значений

выхода. Вычисляем вектор выхода

последовательно используя выражение

![]() ,

где f есть вектор

активационных функций.

,

где f есть вектор

активационных функций.

г) Настройка весовых коэффициентов. Начинаем настройку с весов выходного слоя и затем идем назад к последнему скрытому слою (считая справа налево). Весовые коэффициенты настраиваем с помощью

![]() (21).

В этом уравнении

есть весовой коэффициент соединения,

связывающего нейрон p

скрытого слоя с нейроном q

следующего слоя,

(21).

В этом уравнении

есть весовой коэффициент соединения,

связывающего нейрон p

скрытого слоя с нейроном q

следующего слоя,

![]() -

выход нейрона p (или

внешний вход для нейрона q),

есть параметр скорости обучения и

-

выход нейрона p (или

внешний вход для нейрона q),

есть параметр скорости обучения и

![]() -

градиент. Если нейрон q

является нейроном выходного слоя, то

вычисляется

с помощью (19)

-

градиент. Если нейрон q

является нейроном выходного слоя, то

вычисляется

с помощью (19)

![]() и если нейрон q

является нейроном скрытого слоя, то

определяется с помощью (20)

и если нейрон q

является нейроном скрытого слоя, то

определяется с помощью (20)

.

Ускорение сходимости можно иногда

обеспечить, если добавить значение

момента. Замечание. Для пакетного

режима обработки дельта-правило (6)

модифицируется

.

Ускорение сходимости можно иногда

обеспечить, если добавить значение

момента. Замечание. Для пакетного

режима обработки дельта-правило (6)

модифицируется

где

![]() вычисляется в режиме онлайн и затем

накапливается в процессе представления

обучающих данных для

вычисляется в режиме онлайн и затем

накапливается в процессе представления

обучающих данных для

![]() ,

как составная часть обратных вычислений.

Как видим, весовые коэффициенты

обновляются после представления всех

обучающих данных. Алгоритм онлайн проще

для реализации и требует меньше памяти,

чем алгоритм офлайн. Однако алгоритм

онлайн обеспечивает более точную оценку

вектора градиента и более простую

сходимость к локальному минимуму.

,

как составная часть обратных вычислений.

Как видим, весовые коэффициенты

обновляются после представления всех

обучающих данных. Алгоритм онлайн проще

для реализации и требует меньше памяти,

чем алгоритм офлайн. Однако алгоритм

онлайн обеспечивает более точную оценку

вектора градиента и более простую

сходимость к локальному минимуму.