- •1.Коньюнкция условий и разбиение пространства входа.

- •Композиция нечетких отношений.

- •Нечеткое инверсное управление и нечеткая система управления с внутренней моделью

- •Алгоритм жесткой кластеризации.

- •Операции над нечеткими множествами. Модификаторы.

- •8. Проектирование нечетких контроллеров (метод Мамдани)

- •2. Нечеткий контроллер с двумя входами и одним выходом

- •9.Нечеткая система управления с плановым изменением коэффициента.

- •10. Оценка параметров заключений по (мнк)

- •11. Адаптивные нейронные нечеткие системы инференции (anfis)

- •12.Импликация Мамдани. Внешнее произведение.Таблица импликаци

- •13. Нечеткая идентификация. Структура и параметры.

- •14. Нечеткий логический вывод для нескольких правил и нескольких входов.

- •Несколько входов (многомерная лингвистическая модель)

- •16. Функциональная схема нечеткого контроллера

- •17. Отношения между нечеткими множествами

- •18. Алгоритм нечеткой кластеризации с-средних

- •19. Моделирование статических объектов упр-я как аппроксимация функций с помощью нейронных сетей (есть только для динамических объектов)((((((((

- •20. Анализ устойчивости тс модели объекта управления в пространстве состояний.

- •22. Нечеткий логический вывод с исп-м отношений. Пример

- •24. Визуализация алгоритма нечеткого логического вывода.

- •25. Понятия о нечетких множествах

- •26. Обучение нейронной сети. Общие сведения.

- •27. Упрощение алгоритма нечеткого логического вывода.

- •28. Обратное распространение ошибки

- •29. Визуализация нечеткого логического вывода.Аккумуляция.

- •30. Параметры алгоритма с-средних

- •31. Проектирование нечетких контроллеров (метод Мамдани)

- •32. Нечеткая логика. Логические связки.

- •33.Проектирование нечетких контроллеров(метод Мамдани). Многомерный нечеткий контроллер.

- •34. Алгоритм обучения anfis

- •35. Максиминная композиция нечетких отношений. Внутренне произведение. Пример.

- •36. Преобразование вход-выход. Кривая управления. Пов-ть управления.

- •37. Табличное изменение коэффициента усиления (супервизорное управление)

- •38. Алгоритм нечеткой кластеризации Густафсона–Кесселя.

- •39. Генетические алгоритмы

- •40. Извлечение правил с помощью кластеризации

- •41.Нечеткий сумматор для контроллеров с 2 входами и 1 выходом

- •42. Нейросетевое прямое и косвенное адаптивное управление с эталонной моделью

- •43. Обратное распространение ошибки. Обновление весовых коэф-в скрытых слоев. Локальные градиенты.

- •44. Модель Такаги-Сугено как квазилинейное устройство

- •45. Контроллер типа Такаги-Сугено

- •46. Нейросетевое управление с адаптивной линеаризацией обратной связью

- •48. Такаги-Сугено модель оу в пространстве состояний

- •49. Нечеткие множества. Синглтоны и лингвистические переменные.

- •50. Моделирование нелинейных динамических оу с помощью нейронных сетей

- •51. Структура интеллектуальной системы управления

- •52. Многослойная нейронная сеть

- •53. Дефаззификация. Методы дефаззификации.

- •54. Нейронная сеть с радиальными базисными функциями

- •56. Синтез нечеткой обратной связи

- •57. Линейные матричные неравенства, основные понятия.

- •58. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •59. Классификация генетических нечетких систем

- •60. Синтез нейронных нечетких сетей. Структура anfis

- •19. Моделирование статических объектов управления как аппроксимация функций с помощью нейронных сетей.

- •Адаптивные нейронные нечеткие системы интерференции (anfis). . Синтез нечетких нейронных сетей

- •5.1. Введение

- •Адаптивные нейронечеткие системы инференции (anfis)

- •Импликация Мамдани. Внешнее произведение. Таблица импликации.

- •Нечеткая идентификация. Структура и параметры

- •Нечеткий логический вывод для нескольких правил и нескольких входов.

- •1. Настройка пид-регулятора

- •3. Перенос параметров пид-регулятора в нечеткий контроллер

- •Анализ устойчивости тс модели объекта управления в пространстве состояний. Анализ устойчивости тс модели объекта

- •1. Настройка пид-регулятора

- •Нечеткий логический вывод (инференция). Пример.

- •Визуализация нечеткого логического вывода. Агрегирование условий и активизация заключений.

- •Математическая модель нейрона. Математическая модель нейрона

- •Нечеткое управление с предсказанием.

- •Визуализация нечеткого логического вывода. Аккумуляция заключений.

- •5.1. Введение

- •Алгоритм обучения anfis

- •Максиминная композиция нечетких отношений. Внутреннее произведение. Пример.

- •Преобразование вход-выход для нечетких контроллеров. Кривая управления и поверхность управления.

- •2.4. Преобразование вход-выход

- •Табличное изменениекоэффициентаусиления (супервизорное управление).

- •2.8. Табличное изменение коэффициента усиления (супервизорное управление)

- •Алгоритм нечеткой кластеризации Густафсона-Кесселя.

- •Генетические алгоритмы. Генетические алгоритмы

- •Модель Такаги-Сугено как квазилинейное (аффинное) устройство. Модель Такаги-Сугено как квазилинейное устройство

- •Контроллер типа Такаги-Сугено.

- •Деффазификация. Методы деффазификации.

- •2.2.5. Дефаззификация

- •Теорема б универсальной аппроксимации.

- •Такаги-Сугено модель объекта управления в пространстве состояний.

- •Табличный контроллер. Билинейная интерполяция.

- •2.3. Табличный контроллер

- •Моделирование нелинейных динамических объектов управления с помощью нейронных сетей.

- •Моделирование нелинейных динамических процессов (объектов)

- •Упрощение алгоритма нечеткого логического вывода.

- •Обратное распространение ошибки. Обновление весовых коэффициентов выходного слоя.

- •4.6. Обратное распространение ошибки

- •Структура интеллектуальной системы управления.

- •Многослойная нейронная сеть. Многослойная нейронная сеть

- •5.1. Введение

- •Структура anfis

26. Обучение нейронной сети. Общие сведения.

Большая часть прикладных задач, решаемых нейронной сетью, может быть сведена к реализации некоторого сложного многомерного преобразования. В результате отображения вектора входа u=(u1, …,un) в вектор выхода y=(y1,…,ym) необходимо обеспечить формирование правильных выходных сигналов в соответствии:

со всеми примерами обучающей выборки (образцовых данных);

со всеми возможными входными сигналами, которые не вошли в обучающую выборку.

Второе требование в значительной степени усложняет задачу формирования обучающей выборки.

В общем виде эта задача в настоящее время еще не решена, однако во всех известных случаях может быть найдено частное решение. Очевидно, что процесс функционирования нейронной сети, сущность действий, которые она способна выполнять, зависит от величин синаптических (весовых коэффициентов усиления) связей между нейронами сети и смещений. Поэтому, задавшись определенной структурой сети (количеством слоев и нейронов, числом входов и выходов), соответствующей поставленной задаче, необходимо найти оптимальные или приемлемые значения всех весовых коэффициентов и смещений.

Этот этап называется обучением нейронной сети и от того, насколько качественно он будет выполнен, зависит способность сети решать во время функционирования, поставленные перед ней проблемы.

В процессе работы нейронная сеть формирует выходной векторный сигнал y в соответствии с входным векторным сигналом u, реализуя некоторую функцию g: y=g(u,W1 ,W2 ,…, Wm), где Wq – вектор весовых коффициентов связей q-слоя, m-число слоев. Если структура (архитектура) сети задана, то вид функции g определяется значениями весовых коэффициентов связей и смещений сети. Обозначим через G множество всех возможных функций g, соответствующих заданной структуре сети.

Пусть решение

некоторой задачи есть функция r:

d

= r(u),

заданная парами входных-выходных

векторных данных

![]() (обучающей

выборки), для

которых

(обучающей

выборки), для

которых

![]() .

.

Здесь

N

число обучающих

пар (выборок).

Пусть также

задана функция ошибки (критерий качества,

целевая функция) E

как правило,

сумма квадратов

ошибки

,

(5)

показывающая

для каждой из допустимых функций g

степень близости к r.

Здесь

ej,k=djk-yjk

представляет

собой ошибку (разность) между

скалярными желаемым djk

и действительным

yjk

выходами j

–го нейрона выходного слоя нейросети

для обучающей

пары векторов

,

(5)

показывающая

для каждой из допустимых функций g

степень близости к r.

Здесь

ej,k=djk-yjk

представляет

собой ошибку (разность) между

скалярными желаемым djk

и действительным

yjk

выходами j

–го нейрона выходного слоя нейросети

для обучающей

пары векторов![]() .

.

Решить поставленную

задачу с помощью нейросети заданной

структуры – это, значит, построить

(синтезировать) функцию

![]() ,

подобрав

параметры нейронов (весовые коэффициенты

синаптических связей Wq

и смещения) таким образом, чтобы критерий

качества (усредненная сумма квадратов

ошибок по всем выборкам)

,

подобрав

параметры нейронов (весовые коэффициенты

синаптических связей Wq

и смещения) таким образом, чтобы критерий

качества (усредненная сумма квадратов

ошибок по всем выборкам)

обращался

в минимум для всех пар

обращался

в минимум для всех пар

![]() .

Уточнение весов может проводиться после

предъявления каждой обучающей выборки

(так называемый режим «онлайн») либо

однократно после предъявления всех

выборок, составляющих цикл обучения,

другими словами, эпоху (в режиме

«офлайн» или режиме пакетной обработки

(batch mode)). В

дальнейшем изложении используется

критерий качества обучения вида (5),

которому соответствует оценка весов

после предъявления каждой выборки. Для

упрощения можно считать, что цель

обучения состоит в таком определении

весовых коэффициентов нейронов каждого

слоя сети, чтобы при заданном входном

векторе получить на выходе значения

сигналов yj

, совпадающие с требуемой точностью

c желаемыми значениями

dj

при j=1,2,…,m.

Итак, задача обучения нейросети

определяется совокупностью пяти

компонентов:<u,d,r,G,E>

.

Уточнение весов может проводиться после

предъявления каждой обучающей выборки

(так называемый режим «онлайн») либо

однократно после предъявления всех

выборок, составляющих цикл обучения,

другими словами, эпоху (в режиме

«офлайн» или режиме пакетной обработки

(batch mode)). В

дальнейшем изложении используется

критерий качества обучения вида (5),

которому соответствует оценка весов

после предъявления каждой выборки. Для

упрощения можно считать, что цель

обучения состоит в таком определении

весовых коэффициентов нейронов каждого

слоя сети, чтобы при заданном входном

векторе получить на выходе значения

сигналов yj

, совпадающие с требуемой точностью

c желаемыми значениями

dj

при j=1,2,…,m.

Итак, задача обучения нейросети

определяется совокупностью пяти

компонентов:<u,d,r,G,E>

О бучение

состоит в поиске (синтезе) функции g

, минимальной

по E

или по EN.

Оно требует длительных вычислений и

представляет собой итерационную

процедуру. Число итераций может составить

от 103 до

108.

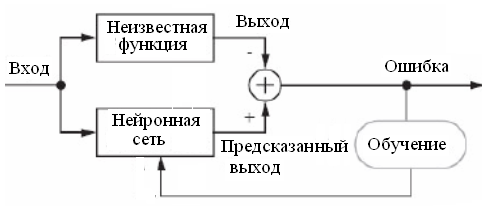

На рис. ниже показана в схематическом

виде задача обучения неросети.

бучение

состоит в поиске (синтезе) функции g

, минимальной

по E

или по EN.

Оно требует длительных вычислений и

представляет собой итерационную

процедуру. Число итераций может составить

от 103 до

108.

На рис. ниже показана в схематическом

виде задача обучения неросети.