- •36. Задача нелинейной безусловной оптимизации (одномерная, многомерная). Классический метод решения – условия оптимальности.

- •38. Задача одномерной безусловной оптимизации. Метод деления отрезка пополам (дихотомии). Величина интервала неопределенности после вычисления значения целевой функции в n промежуточных точках.

- •39. Задача одномерной безусловной оптимизации. Метод золотого сечения. Величина интервала неопределенности после вычисления значения целевой функции в n промежуточных точках.

- •40. Задача одномерной безусловной оптимизации. Метод чисел Фибоначчи. Величина интервала неопределенности после вычисления значения целевой функции в n промежуточных точках.

- •41. Задача одномерной безусловной оптимизации. Методы спуска к минимуму из некоторой начальной точки: метод последовательного перебора, метод квадратичной параболы, метод кубической параболы.

- •42. Задача многомерной безусловной оптимизации. Классификация численных методов поиска решения. Покоординатные методы: общий подход, метод Гаусса-Зейделя, метод Розенброка, метод Пауэлла.

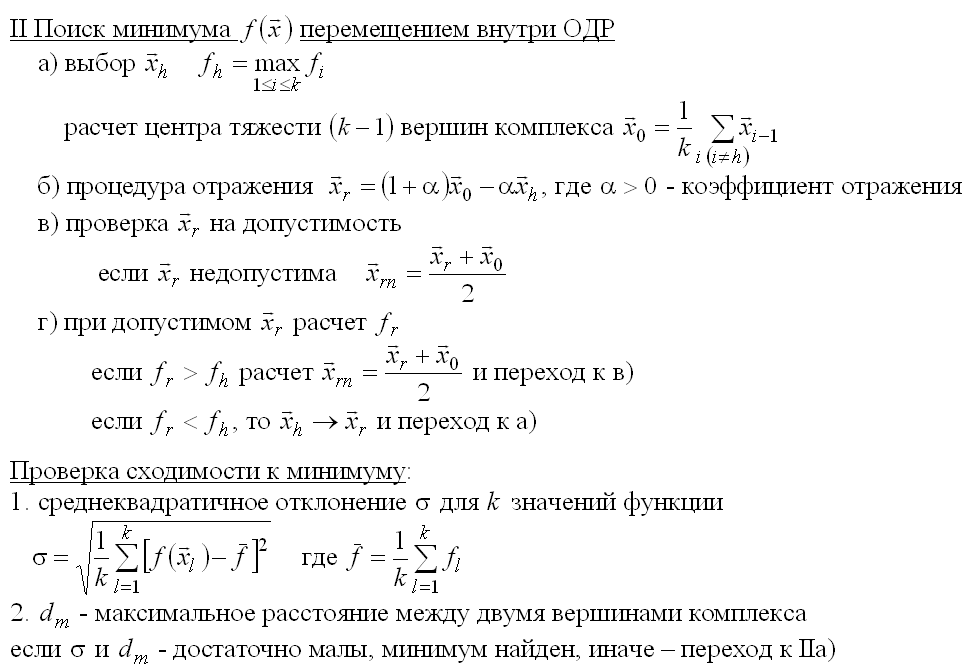

- •43. Задача многомерной безусловной оптимизации. Симплексный метод Нельдера-Мида.

- •Алгоритм

- •44. Задача многомерной безусловной оптимизации. Градиентные методы:

- •Метод наискорейшего спуска (метод градиента)

- •Алгоритм

- •45. Задача многомерной безусловной оптимизации. Метод Флетчера-Ривса (сопряженных градиентов). Метод оврагов.

- •46. Задача многомерной безусловной оптимизации. Семейство методов с переменной метрикой: основная идея всех методов, общий цикл вычислений, метод Давидона-Флетчера-Пауэлла, метод Гольдфарба.

- •47. Задача многомерной безусловной оптимизации. Методы II порядка: Ньютона и Ньютона-Рафсона. Сравнение методов решения задачи многомерной безусловной оптимизации.

- •Метод Ньютона — Рафсона

Метод Ньютона — Рафсона

Метод Ньютона — Рафсона является улучшением метода Ньютона нахождения экстремума, описанного выше. Основное отличие заключается в том, что на очередной итерации каким-либо из методов одномерной оптимизации выбирается оптимальный шаг:

![]()

где

![]() Для

оптимизации вычислений применяют

следующее улучшение: вместо того, чтобы

на каждой итерации заново вычислять

гессиан

целевой

функции,

ограничиваются начальным приближением

Для

оптимизации вычислений применяют

следующее улучшение: вместо того, чтобы

на каждой итерации заново вычислять

гессиан

целевой

функции,

ограничиваются начальным приближением

![]() и

обновляют его лишь раз в

шагов,

либо не обновляют вовсе.

и

обновляют его лишь раз в

шагов,

либо не обновляют вовсе.

48. Классификация задач на условный экстремум. Особенности решения задач на условный экстремум, возможные варианты положения экстремума в задаче математического программирования. Решение классической задачи на условный экстремум методом множителей Лагранжа.

Метод

множителей Лагранжа,

метод нахождения условного

экстремума

функции

![]() ,

где

,

где

![]() ,

относительно

ограничений

,

относительно

ограничений

![]() ,

,

![]() меняется

от единицы до

.

меняется

от единицы до

.

Составим функцию

Лагранжа в

виде линейной

комбинации

функции f

и функций

![]() ,

взятых с коэффициентами, называемыми

множителями

Лагранжа —

λi:

,

взятых с коэффициентами, называемыми

множителями

Лагранжа —

λi:

![]()

где

![]() .

.

Составим систему

из n

+ m

уравнений, приравняв к нулю частные

производные

функции Лагранжа

![]() по

xj

и λi.

по

xj

и λi.

Если полученная система имеет решение относительно параметров x'j и λ'i, тогда точка x' может быть условным экстремумом, то есть решением исходной задачи. Заметим, что это условие носит необходимый, но не достаточный характер.

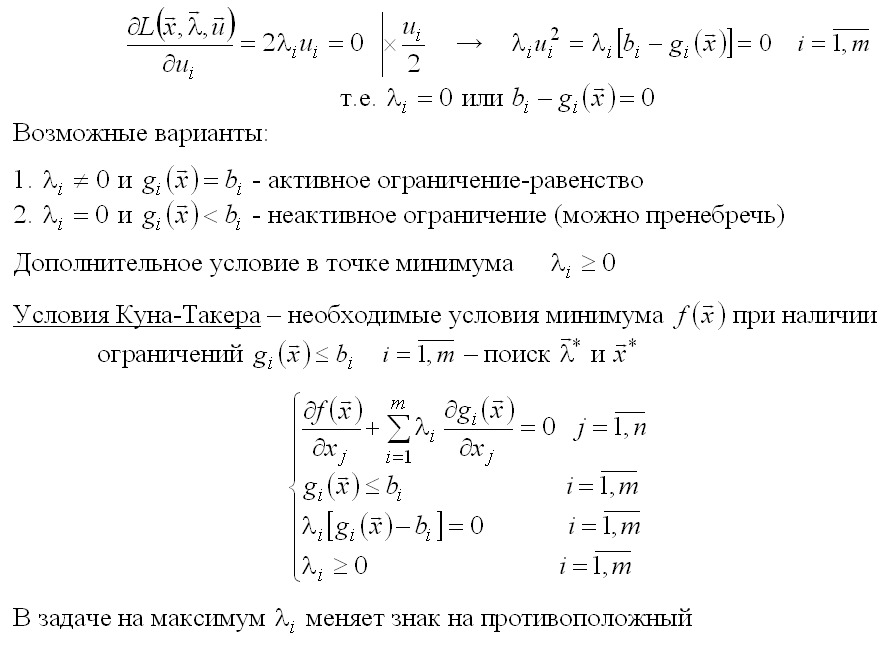

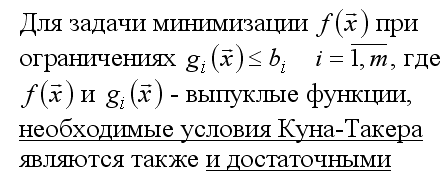

49. Распространение метода множителей Лагранжа на задачу математического программирования. Активные и неактивные ограничения. Условия Куна-Такера в задаче математического программирования.

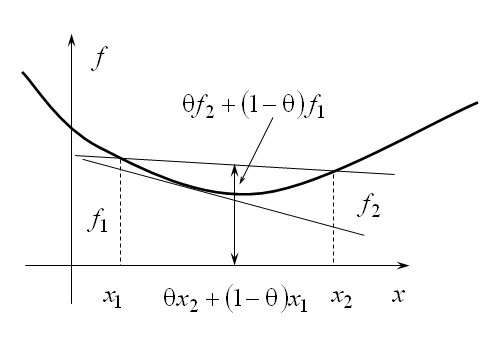

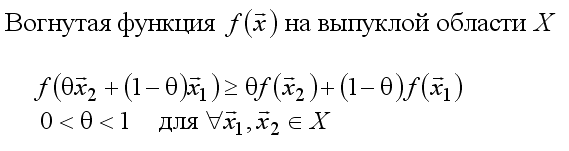

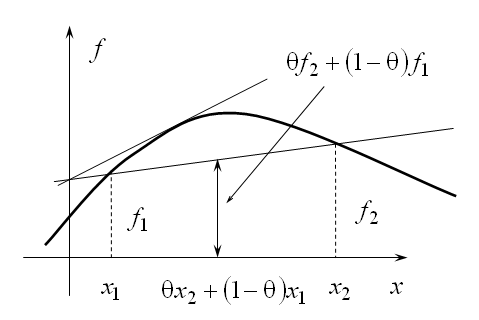

50. Задачи выпуклого программирования. Понятие выпуклой области, выпуклой (вогнутой) функции. Применение условий Куна-Такера при решении задачи выпуклого программирования.

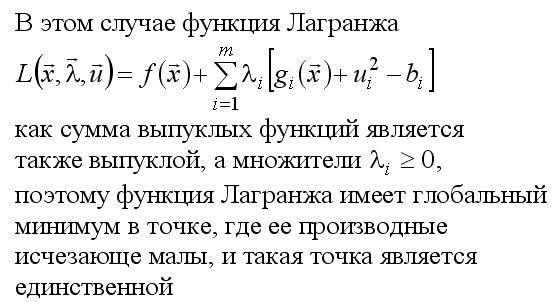

51. Численный методы решения задач условной оптимизации – комплексный метод Бокса.

52. Последовательная оптимизация без ограничений – метод штрафной функции. Численный алгоритм реализации метода штрафной функции - метод Кэрролла-Фиакко-Маккормика.