- •22. Класифікація сігналів и Завада. Детерміновані та випадкові сигнали.

- •23. Дискретизація аналогових сигналів. Теорема відліків.

- •24. Спектральне представлення детермінованих сигналів.

- •25. Випадкові сигнали та завади. Класифікація, основні характеристики.

- •26. Функції розподілу та числові характеристики випадкових сигналів.

- •27. Потенціальна завадостійкість. Розрахунок імовірності помилки для різних сигналів.

- •28. Оптимальний некогерентний прийом цифрових сигналів у гауссовому каналі.

- •29. Оптимальний когерентний прийом цифрових сигналів.

- •30. Інформаційні параметри повідомлень та сигналів. Поняття ентропії.

- •Ентропія. Властивості ентропії

- •Залежність h(X) від величини р

- •31. Інформаційні характеристики неперервних повідомлень. Епсілон- ентропія.

30. Інформаційні параметри повідомлень та сигналів. Поняття ентропії.

При введенні кількісної міри інформації було прийнято смисловий зміст повідомлень (семантику) не враховувати, а обмежитися тільки формальними ознаками, важливими з погляду передачі повідомлень по каналах зв’язку. У результаті враховуються тільки число N повідомлень, що підлягають передачі, і ймовірності р(хi) надходження їх на вхід каналу. Всю сукупність повідомлень представляють у вигляді деякої системи Х із станами xi

![]() ,

(1)

,

(1)

де: xi – окремі повідомлення (або їх типи, класи), p(xi) – апріорна ймовірність появи повідомлень xi.

В результаті передачі повідомлення xi по каналу зв’язку буде одержане повідомлення yj. Воно може з деякою ймовірністю бути схоже на будь-яке з (x1, x2,…xN) повідомлень. Зокрема воно може бути схоже на передане повідомлення xi. Апостеріорна (післядослідна) ймовірність присутності xi в yj дорівнює p(xi/ yj).

У основу міри кількості інформації встановлені зміни ймовірності появи повідомлень від апріорного значення p (xi) на вході каналу до апостеріорного значення p (xi/yj) на виході каналу, пов’язані із викривленнями інформації у каналі.

Порівнюючи ймовірність р(xi) і p (xi/yj) можна встановити міру кількості інформації, переданої через даний канал. Зручною мірою виявився логарифм відношення апостеріорної ймовірності до апріорної.

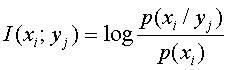

Кількість інформації, те, що міститься в події yj щодо події xi визначається по формулі:

Основою логарифма можуть бути: 2, е 2,72, або 10. Залежно від основи міняються одиниці вимірювання кількості інформації (біти дв. од.; ніт нат. од.; хартлі (діти) дес. од.)

Властивості кількості інформації I(xi; yi):

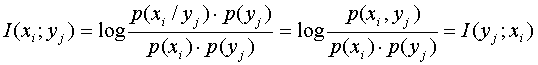

1. Властивість симетрії.

2. Властивість адитивності.

![]() .

.

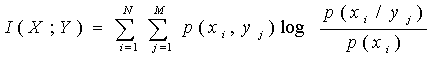

Середня кількість взаємної інформації виходить шляхом усереднювання (2) по всіх i і j :

1. Властивість симетрії. Інформація, що міститься в yj щодо xi, дорівнює інформації, що міститься в xi щодо yj. Це стає очевидним, якщо чисельник і знаменник в (1) помножити на p (yi) і виробити перетворення:

,

оскільки p (xi, yj) = p (yj), p(xi/ yj) = p (xi), p (yj/ xi) - ймовірність сумісної появи yj і xi.

В результаті вказаної властивості величину I(xi;yj) називають кількістю взаємної інформації між xi і yj.

2. Властивість адитивності. Інформація, що міститься в парі символів yj, zk щодо xi, дорівнює сумі інформації, що міститься в yj щодо xi і інформації, що міститься в zk щодо xi за умови, що значення yj відоме

. (3)

Кількість власної інформації у xi визначається з (2) при p(xi/ yj) = 1

![]() .

(4)

.

(4)

Ця величина визначає кількість інформації, необхідне для однозначного визначення xi на виході каналу.

З урахуванням введеного поняття (4) можна перетворити вираз (2) до вигляду

![]() ,

,

де I (xi / yj) = -log p (xi / yj) умовна власна інформація.

Середня кількість взаємної інформації виходить шляхом усереднювання (2) по всіх i і j :

![]() .

.