- •1. Определение модели, понятие о моделировании.

- •2. Классификация моделей

- •3. Линейная парная регрессия.

- •4. Нелинейная парная регрессия.

- •5. Линейная множественная регрессия.

- •6. Нелинейные уравнения множественной регрессии.

- •7. Исключение дублирующих и неэффективных аргументов. Доли вклада.

- •8. Используя принцип наименьших квадратов получите уравнение парной параболической регрессии 2-го порядка.

- •9. Что такое оптимизация и её математическая формулировка.

- •10. Основные понятия оптимизации, нормализация независимых переменных. Глобальный и локальный оптимумы.

- •11. Критерий качества (функция цели или критерия оптимальности)

- •12. Проблемы, возникающие при оптимизации параметров стока.

- •13. Общий подход к нелинейным методам оптимизации.

- •14. Метод градиента.

- •15. Метод наискорейшего спуска.

- •16. Метод шагов по оврагу.

- •17. Метод золотого сечения.

- •18. Метод деления интервалов пополам.

14. Метод градиента.

Заключается в следующем: вычисляются значения частных производных по всем направлениям. Затем делается шаг с точки 1 в точку 2.

![]() в

этом методе величина шага ΔХ будет

пропорциональна ДК по ДХ. В дали от точки

минимума ДК по ДХ довольно большие. При

приближении к точке оптимума (где ДК по

ДХ=0) величина градиента постепенно

уменьшается, в результате чего ΔХ

постепенно уменьшается. Это означает

что данный метод более плавно приближается

к оптимуму, то есть уменьшается вероятность

образования рыскания.

в

этом методе величина шага ΔХ будет

пропорциональна ДК по ДХ. В дали от точки

минимума ДК по ДХ довольно большие. При

приближении к точке оптимума (где ДК по

ДХ=0) величина градиента постепенно

уменьшается, в результате чего ΔХ

постепенно уменьшается. Это означает

что данный метод более плавно приближается

к оптимуму, то есть уменьшается вероятность

образования рыскания.

![]()

15. Метод наискорейшего спуска.

Относится к градиентным методам. Суть: как и в методе градиента в начальной точке вычисляется градиент критерия качества. На входе выбирается направление, а затем вдоль него каким либо методом делается серия шагов, до тех пор пока критерий качества не станет увеличиваться(пока выбранное направление не станет касательной к какой либо поверхности уровня). В той точке, в которой произошел рост критерия качества градиент не вычисляется а осуществляется возврат в предыдущую точку. И в ней вычисляется значение градиента(то есть тем самым определяется новое направление). Новое направление будет всегда перпендикулярно предыдущему. Довольно часто в этом алгоритме используется метод параболической аппроксимации.

;

;

Условия окончания:

чаще всего делают комбинированным в

данном методе в качестве такого условия

принимается длинна шага между двумя

точками, в которых вычисляется градиент![]() - заранее заданная точность. Критерий

качества в точке b

меньше чем в точке a.

- заранее заданная точность. Критерий

качества в точке b

меньше чем в точке a.

16. Метод шагов по оврагу.

Овраги появляются

в том случае, если два параметра

участвующих в оптимизации имеют либо

корреляционную зависимость друг от

друга, либо встречается в модели их

произведение друг на друга. Обычно при

спуске на дно оврага используется метод

наискорейшего спуска, затем делается

шаг по прямой проходящий через найденные

две точки на дне оврага в сторону от той

точки, в которой значение критерия

качества меньше на заранее заданную

величину «Н»оврага.

![]() условие окончания те же что и в наискорейшем

спуске. Количество шагов «Н»оврага

делается до тех пор, пока в последующие

точки на дне оврага значения критерия

качества не увеличится. После его

увеличения переход в эту точку не

осуществляется, а величина шага «Н»

оврага, делится на два, и спуск

осуществляется из дальнейшей точки.

Так происходит до тех пор пока «Н» оврага

не станет меньше заранее заданной

точности.

условие окончания те же что и в наискорейшем

спуске. Количество шагов «Н»оврага

делается до тех пор, пока в последующие

точки на дне оврага значения критерия

качества не увеличится. После его

увеличения переход в эту точку не

осуществляется, а величина шага «Н»

оврага, делится на два, и спуск

осуществляется из дальнейшей точки.

Так происходит до тех пор пока «Н» оврага

не станет меньше заранее заданной

точности.

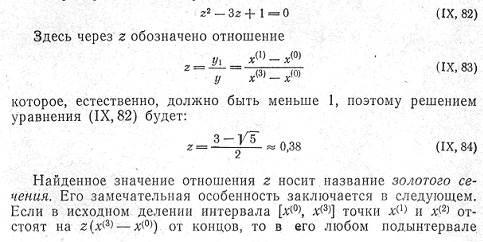

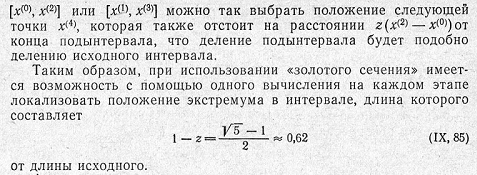

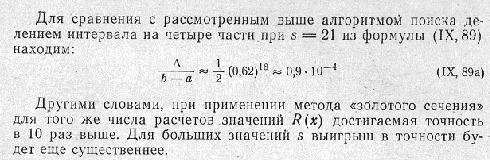

17. Метод золотого сечения.

18. Метод деления интервалов пополам.

Нужно найти минимум в интервале а-b. Интервал делится пополам а затем еще пополам, в каждой точке находится критерий качества, затем находится точка с наименьшим критерием качества. Смежный интервал с точкой имеющей наименьший критерий качества вновь делим пополам она образует новый интервал неопределенности. Так продолжать пока критерий качества не станет меньше заданной точности. Плюс в том что на каждое уменьшение в два раза расходуются две точки.