- •1 Информатика

- •1.1 Предмет и задачи информатики

- •1.2 Истоки и предпосылки информатики

- •1.3 Структура современной информатики

- •2 Понятие информации

- •2.1 Развитие представлений об информации

- •Современное представление об информации

- •2.2 Свойства информации

- •2.3 Мера информации Синтаксическая мера информации — бит и байт

- •Мера информации по Шеннону

- •Семантическая и прагматическая меры информации

- •2.4 Признаки классификации информации

- •2.5 Информационные процессы

- •Понятие сжатия информации

- •3 Кодирование, декодирование и шифрование информации

- •3.1 Основные понятия

- •6 Информационные системы

- •6.1 Понятие информационной системы

- •6.2 Структура информационных систем

- •6.3 Классификация информационных систем Классификация ис по признаку структурированности задач

- •Классификация ис по функциональному признаку и уровням управления

- •Классификация по степени автоматизации

- •Классификация по характеру использования информации

- •Классификация по сфере применения

- •7 Информационные технологии

- •7.1 Понятие информационной технологии

- •7.2 Этапы развития информационных технологий

- •7.3 Проблемы использования информационных технологий

- •1) Устаревание информационной технологии

- •2) Методология использования информационной технологии

- •3) Выбор вариантов внедрения информационной технологии в фирме

- •7.4 Виды информационных технологий

- •1. Ит обработки данных

- •2. Ит управления

- •3. Автоматизация офиса

- •4. Ит поддержки принятия решений

- •5. Ит экспертных систем

- •8 Аппаратное обеспечение компьютера. Базовая архитектура пк. Состав вычислительной системы

- •8.1 Аппаратное обеспечение

- •9.2 Классификация прикладных программных средств

- •9.3 Классификация служебных программных средств

- •10 Системы управления базами данных

- •10.1 Базы данных

- •Классификация баз данных

- •10.2 Виды моделей данных

- •Иерархическая модель данных

- •Сетевая модель данных

- •Реляционная модель данных

- •10.3 Реляционные бд

- •Нормализация отношении Понятие нормализации отношений

- •Типы связей

- •10.4 Построение инфологической модели

- •10.5 Функциональные возможности субд

- •11 Компьютерные сети. Интернет

- •11.1 Назначение и классификация компьютерных сетей

- •Классификация сетей:

- •11.2 Топологий сетей

- •11.3 Сетевые компоненты

- •7.9. Internet как иерархия сетей

- •7.9.1. Протоколы Интернет

- •7.9.2. Адресация в Интернет

- •7.9.3. Доменные имена

- •7.9.4. Варианты доступа в Интернет

- •7.9.5. Система адресации url

- •7.9.6. Сервисы Интернет

- •7.9.7. Поиск в Интернете

- •12 Понятие информационной безопасности. Основы и методы защиты информации

- •12. 1 Понятие «Информационная безопасность»

- •Основные составляющие информационной безопасности

- •Важность и сложность проблемы информационной безопасности

- •Основная литература

- •Дополнительная литература

2.3 Мера информации Синтаксическая мера информации — бит и байт

Синтаксическая форма адекватности информации характеризуется объемом данных и количеством информации. Объем данных чаще всего измеряется числом символов (разрядов) Vu в передаваемом сообщении. В двоичной системе один разряд — это бит (или байт = 8 бит), в десятичной системе — это число, представленное одной арабской цифрой (от 0 до 9).

Бит имеет всего два значения — логический 0 и 1 (или утверждения «Да» и «Нет» или «True» (Истина) и «False» (Фальшь или неправда). Бит может быть простейшим электрическим сигналом. Есть напряжение на проводе — это логическая единица, нет — логический ноль. Точная величина напряжения принципиального значения не имеет.

Роль двоичных чисел исключительно велика. Это связано с удобством их хранения в компьютерах, поскольку большинство запоминающих устройств построено на бинарных (двоичных) ячейках. Заряженный или разряженный конденсатор, намагниченный или размагниченный магнитный сердечник, триггер на транзисторах или электронных лампах — все это примеры устройств, имеющих два стабильных состояния равновесия.

Соединив последовательно N двоичных устройств, можно получить М-раз-рядное устройство, имеющее Т состояний равновесия. К примеру, для передачи 16 значений десятичных чисел от 0 до 15 придется использовать минимум четыре разряда двоичного числа (24 = 16).

По мере роста объема передаваемой информации пришлось перейти к более крупным единицам ее измерения. Оказалось, что для кодирования текстов самым приемлемым пакетом двоичных единиц информации стали байты — они содержат восемь двоичных единиц и, соответственно, имеют два в восьмой степени состояний (всего256 со значениями от 0 до 255). Итак, информацию можно оценивать ее объемом — байтами, килобайтами (1 кбайт = 1024 байта), мегабайтами (1 Мбайт = 1024 кбайт) и так далее.

С идеи двоичного кодирования началось развитие цифровых вычислительных машин. Этому способствовало и то, что были созданы простые электронные схемы с двумя устойчивыми состояниями равновесия — триггеры и запоминающие конденсаторные ячейки. Простота и миниатюрность этих устройств содействовала надежности их работы и возможности изготовления в составе интегральных микросхем.

Мера информации по Шеннону

Обычно нам приходится работать в условиях неполных знаний об интересующей нас информационной системе. Поступающая к нам информация носит, чаще всего, статистический характер. Мы можем, скажем, лишь отчасти знать, какой процент населения поддерживает нашего президента или какую часть новорожденных составляют мальчики. Абсолютно точно этого узнать нельзя из-за ошибок в подсчете и постоянного случайного изменения данных (информационного шума).

Допустим, что до получения информационного сообщения пользователь информационной системой имел предварительные (априорные) сведения о системе — α. Его неосведомленность о системе определяется энтропией H(α). С получением сообщения β неопределенность сведений о системе становится равной Hβ(а). Тогда количество информации в сообщении будет равно.

Iβ(α)= H(α)- Hβ(а).

Следовательно, количество информации определяется уменьшением неопределенности состояния системы. Если конечная неопределенность Hβ(а) становится равной 0, то неполное знание о системе H(α) будет заменено полным знанием, что означает Iβ(α)= H(α)

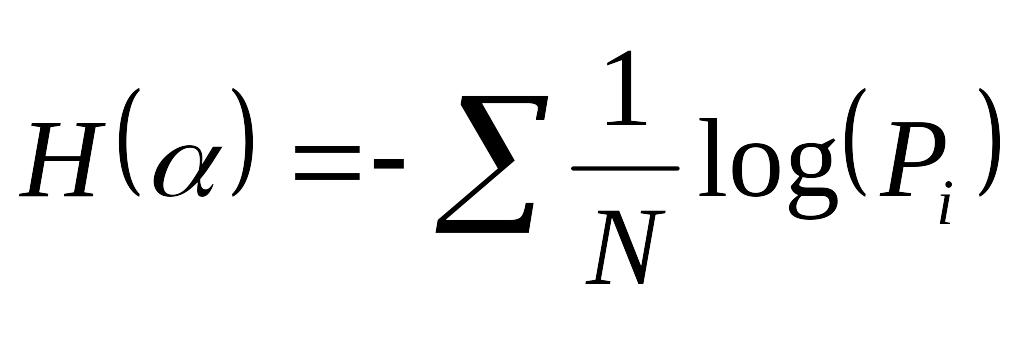

Пусть некоторая информационная система имеет N возможных состояний. Один из крупных специалистов в информатике Шеннон показал, что энтропия системы, как мера недостающей информации о ней, определяется выражением:

,

,

где pi — вероятность нахождения системы в i-м состоянии. Если все состояния системы равновероятны, то имеем:

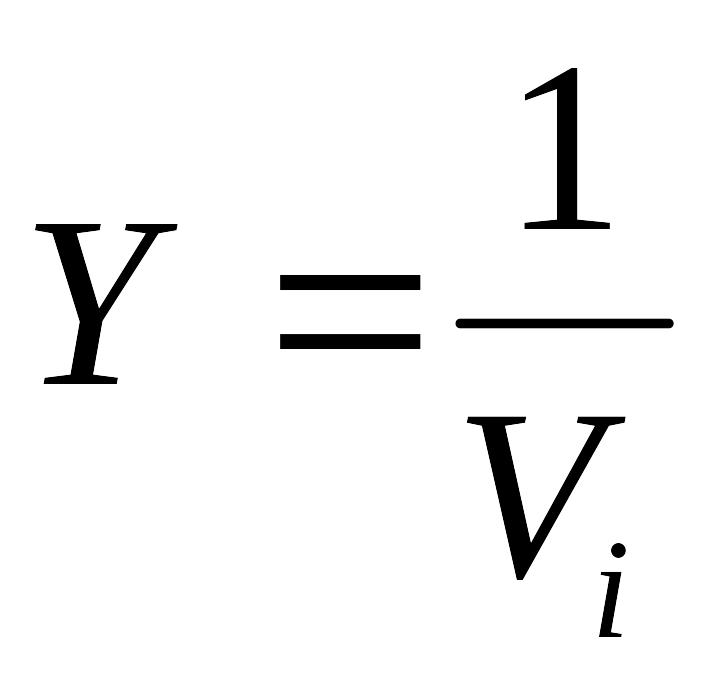

Заметим, что N = mn, где т — основание системы исчисления, n — число разрядов (символов) в сообщении. Коэффициентом или степенью информативности сообщения называют отношение количества информации I к объему данных в сообщении, т. е. величина

Эта величина лежит в интервале 0 < Y < 1 и является мерой лаконичности сообщения. Чем она выше, тем меньше объем работ по преобразованию информации.