- •Предмет эконометрики. Методология эконометрического исследования.

- •Типы моделей. Спецификации моделей.

- •Типы экономических данных.

- •Модель парной регрессии.

- •Параметры, характеризующие качество линейной модели.

- •Метод наименьших квадратов в регрессионном анализе.

- •Линейная модель регрессии.

- •Выражение параметров линейной модели регрессии через средние значения исходных данных.

- •Статистические характеристики оценок параметров парной линейной регрессии.

- •Теорема Гаусса-Маркова.

- •Проверка значимости параметров линейной модели.

- •Проверка значимости линейной модели в целом.

- •Нелинейная регрессия и ее классификация.

- •Варианты сведения нелинейной регрессии к линейной.

- •Оценка параметров линейной регрессии и коэффициента корреляции.

- •Прогнозирование в случае линейной модели регрессии, интервальные

- •Доверительные интервалы прогнозируемых значений линейной модели.

- •Варианты получения доверительных интервалов прогнозируемых значений и их характеристика.

- •Корреляция для нелинейной модели регрессии

- •Средняя ошибка аппроксимации.

- •Статистическая характеристика корреляции нелинейной модели регрессии .

- •Множественная линейная регрессия в скалярной и векторной формах.

- •Выбор структуры уравнения множественной регрессии.

- •Оценка параметров уравнения множественной регрессии.

- •Временные ряды, основные элементы временного ряда.

- •Автокорреляция уровней временного ряда и выявление его структуры.

- •Моделирование тенденции временного ряда.

- •Аддитивная модель временного ряда.

- •Мультипликативная модель временного ряда.

- •Моделирование сезонных и циклических колебаний временных рядов.

- •Метод скользящей средней в моделировании временных рядов.

- •Метод фиктивных переменных в моделировании сезонных колебаний

- •Моделирование тенденции временного ряда при наличии структурных изменений.

- •Временные ряды и прогнозирование.

- •Доверительные интервалы для прогнозируемых значений временных рядов.

- •Мультиколлинеарность данных.

Метод наименьших квадратов в регрессионном анализе.

В общем случае задача метода наименьших квадратов формулируется следующим образом. Пусть искомая функциональная зависимость величины у от величины х выражается формулой:

![]() (1)

(1)

где

![]() заданные

функции,

заданные

функции,

![]() искомые

параметры – коэффициенты уравнения

(1). Предполагается, что значения

аргумента х

установлены точно, а соответствующие

значения функции у

определены

в эксперименте с некоторой погрешностью.

Если бы измерения производились без

ошибок, то для определения параметров

искомые

параметры – коэффициенты уравнения

(1). Предполагается, что значения

аргумента х

установлены точно, а соответствующие

значения функции у

определены

в эксперименте с некоторой погрешностью.

Если бы измерения производились без

ошибок, то для определения параметров

![]() потребовалось

бы ровно т+1

измерений. Но из-за ошибок эксперимента

разные серии из т+1

измерений будут давать различные

значения параметров

.

Поэтому количество проводимых измерений

должно быть гораздо бо’льшим, чем

число т

определяемых параметров, для уменьшения

влияния ошибок эксперимента за счет

использования избыточной информации

и получения наилучших в некотором

смысле оценок определяемых параметров.

Итак, для получения оценок параметров

проводят

n

экспериментов, результаты которых дают

значения не этих параметров, а некоторой

функции (1), зависящей от них линейно.

потребовалось

бы ровно т+1

измерений. Но из-за ошибок эксперимента

разные серии из т+1

измерений будут давать различные

значения параметров

.

Поэтому количество проводимых измерений

должно быть гораздо бо’льшим, чем

число т

определяемых параметров, для уменьшения

влияния ошибок эксперимента за счет

использования избыточной информации

и получения наилучших в некотором

смысле оценок определяемых параметров.

Итак, для получения оценок параметров

проводят

n

экспериментов, результаты которых дают

значения не этих параметров, а некоторой

функции (1), зависящей от них линейно.

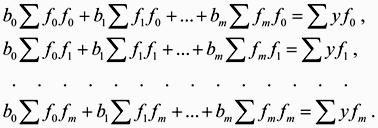

Метод наименьших квадратов состоит в том, что оценки параметров формулы (1) определяются из условия: сумма квадратов отклонений

![]() (2)

(2)

достигает наименьшего значения.

Для определения этих оценок нужно продифференцировать (2) по всем оценкам , приравнять все производные нулю и решить полученную линейную систему из т+1 уравнений относительно т+1 неизвестных оценок параметров :

(3)

(3)

Система уравнений (3) называется системой нормальных уравнений Гаусса. Здесь для краткости записи приняты следующие обозначения сумм:

![]() (4)

(4)

Следует отметить, что система уравнений (3) иногда оказывается плохо обусловленной, т.е. ее решения весьма чувствительны к малейшим изменениям в результатах измерений. Для плохо обусловленных систем в настоящее время разработаны специальные методы, например, метод регуляризации.

Линейная модель регрессии.

Линейная регрессия (англ. Linear regression) — используемая в статистике регрессионная модель зависимости одной (объясняемой, зависимой) переменной y от одной или нескольких других переменных (факторов, регрессоров, независимых переменных) x с линейной функцией зависимости.

Модель линейной регрессии является часто используемой и наиболее изученной в эконометрике. А именно изучены свойства оценок параметров, получаемых различными методами при тех или иных предположениях о вероятностных характеристиках факторов и случайных ошибок модели. Предельные (асимптотические) свойства оценок нелинейных моделей также выводятся исходя из аппроксимации последних линейными моделями. Необходимо отметить, что с эконометрической точки зрения более важное значение имеет линейность по параметрам, чем линейность по факторам модели.

Общая модель линейной регрессии

Введем

два вектора:

![]() —факторы регрессии и

—факторы регрессии и

![]() --

неизвестные параметры регрессии. Каждый

вектор есть вектор-столбец, а изображен

по горизонтали для удобства. Обозначать

вектора мы, как и ранее, будем жирным

шрифтом.

--

неизвестные параметры регрессии. Каждый

вектор есть вектор-столбец, а изображен

по горизонтали для удобства. Обозначать

вектора мы, как и ранее, будем жирным

шрифтом.

Рассматривается

модель регрессии, которая в курсе

«Эконометрика» называется простой

(линейной) регрессией:

![]()

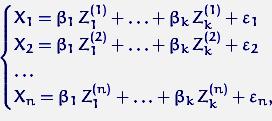

Пусть

в

![]() -м

эксперименте факторы регрессии принимают

заранее заданные значения

-м

эксперименте факторы регрессии принимают

заранее заданные значения![]() , где

, где![]() .

.

После![]() экспериментов получен набор откликов

экспериментов получен набор откликов![]() , где

, где

или,

в матричной форме,

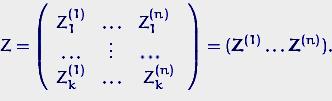

![]() , где матрица

, где матрица

![]() (матрица плана) равна

(матрица плана) равна

Вектор![]() состоит из случайных ошибок в данных

экспериментах.

состоит из случайных ошибок в данных

экспериментах.

Требуется

по данным матрице плана

![]() и вектору результатов

и вектору результатов

![]() найти оценки для параметров регрессии

найти оценки для параметров регрессии

![]() и параметров распределения вектора

ошибок

и параметров распределения вектора

ошибок

![]() .

.