- •1. Измерительные схемы aстатического уравновешивания.

- •2. Виды интерфейсов применяемых в авиационных приборах и ивк. Опишите предложенную структуру передачи информации.

- •3. Канал измерения расхода

- •4. Принцип работы скоростного (турбинного) расходомера. Измерение мгновенного и суммарного расхода. Погрешности.

- •5. Принцип работы, виды поплавковых топливомеров. Схема включения, погрешности.

- •6. Принцип работы конструкции, диапазон измерения, применение, погрешности емкостных топливомеров. Линеаризация характеристик.

- •7. Опишите принцип работы схемы. Виды погрешностей данного топливомера.

- •8. Опишите принцип работы представленного датчика. Типы, назначение, применение, погрешности датчиков давления в авиационной технике.

- •9. Принцип работы манометра с потенциометрическим преобразователем.

- •10. Принцип работы мостовой схемы включения и компенсационной схемы включения терморезистивного термометра.

- •11. Принцип работы термоэлектрического термометра. Структурная схема, погрешности, методы устранения.

- •12. Назначение тахометров, виды. Принцип работы показанной схемы.

- •13. Способы измерения высоты л.А. Опишите принцип действия и работу указанной схемы.

- •14. Виды измеряемых скоростей л.А. Принцип действия и работы указанной схемы.

- •15. Назначение, принципдействия вариометра. Работа указанной схемы. Погрешности вариометра

- •18. Назначение радиовысотомера. Радиовысотомер малых и больших высот. Принцип действия радиовысотомера и его работа по указанной схеме.

- •19. Принцип работы радиокомпаса, его место в курсовых системах. Комплексирование радиокомпаса с другими указателями курса.

- •20. Назначение и виды курсовых систем. Состав кс и ее работа по указанной схеме.

- •16. Назначение магнитного компаса. Принцип действия, девиация, погрешности.

- •21. Система отображения информации на элт

- •17. Назначение центральнойгировертикали. Принцип действия.

- •29. Статические параметры логических элементов.

- •22.Электронные средства в системах отражения информации: электролюминесцентные, светодиодные, газоразрядные и плазменные уои.

- •1.Электролюминесцентные уои

- •2. Светодиодные уои

- •3. Газоразрядные и плазменные уои

- •23. Лазерные и голографические уои

- •25. Назначение системы регулирования и ограничения температуры газа в гтд. Опишите принцип работы указанной схемы.

- •24. Жидкокристаллические уои. Новые технологии, разработки, перспективы развития уои

- •26. Позиционные системы счисления. Двоичная и шестнадцатеричная арифметика.

- •27. Точность представления чисел. Вычислительные погрешности.

- •28. Логические элементы. Положительная и отрицательная логика.

- •30. Быстродействие логических элементов. Мощности потребления логических элементов.

- •31. Особенности логических выходов цифровых элементов. Элементы с тремя состояниями выхода. Выход элемента с открытым коллектором.

- •32. Двоичные дешифраторы. Приоритетные и двоичные шифраторы.

- •33. Мультиплексоры и демультиплексоры.

- •34. Цифровые компараторы. Схемы контроля цу. Мажоритарные элементы.

- •35. Контроль по модулю 2. Схемы свёртки. Контроль с использованием кода Хэмминга.

- •36. Триггерные устройства. Классификация. Rs-, jk-, d- и t-триггеры и способы их описания.

- •37. Автоматы с памятью. Последовательностные схемы.

- •38. Регистры и регистрированные файлы. Сдвигающие и универсальные регистры. Буферные регистры. Шинные формирователи.

- •39. Классификация счетчиков. Двоичные счетчики.

- •41. Классификация зу.

- •42. Память с последовательным доступом: видеопамять, буфер fifo, кэш-память.

- •43. Пзу(rom)/ Масочные зу, зу типа prom, eprom, eeprom.

- •45. Структура микропроцессора.

- •48. Структура и формат команд мп. Способы адресации в мп.

- •46. Структура и функционирование мпс.

- •47. Управление памятью и внешними устройствами.

- •51. Амплитудно-импульсная модуляция. Спектр аим - колебаний. Почему она применена в представленной схеме уравновешивания?

- •49. Параллельные периферийные адаптеры.

- •55. Энтропия, количество информации по Шеннону.

- •50. Программируемые связные адаптеры.

- •52. Частотное и временное разделение каналов.

- •53. Фильтрация сигналов. Операторы фильтрации.

- •54. Вероятность и информация. Информационное содержание сигнала.

- •56. Описание непрерывных колебаний во временной и частотной областях.

- •57. Базисные функции. Ортогональные и ортонормированные функции.

- •58. Спектральная плотность случайных колебаний. “Белый шум” и его свойства.

- •66. Структурные меры информации.

- •59. Случайные колебания и корреляционные функции.

- •60. Способы повышения помехоустойчивости передачи информации.

- •61. Корреляционное разделение каналов и корреляционная фильтрация.

- •62. Демодуляция частотно – модулированных колебаний.

- •63. Виды каналов передачи информации.

- •64. Информация и фазы обращения информации.

- •65. Виды информации. Устранение избыточности информации.

- •67. Статистические меры информации. Информационное содержание сигнала.

- •68. Частотная модуляция. Спектры чм–колебаний.

- •69. Какие виды модуляции гармонических колебаний можно обнаружить в радиокомпасе и каковы их спектры?

- •70. Модуляция гармонических колебаний. Виды амплитудной модуляции и как они представлены в арк?

- •71. Дискретизация сигналов. Теорема Котельникова.

- •72. Систематические меры информации. Источники и приемники информации.

- •73. Геометрические меры информации. Каким образом они представлены в индикаторах сои?

- •79. Жизненный цикл изделия, ступени жизненного цикла по мс исо 9004.

- •74. Количество информации. Аддитивные меры Хартли.

- •75. Импульсная модуляция, шим, спектр широтно-импульсных колебаний.

- •76. Приведите структурную схему (содержание) производственного процесса (прп), показатели прп.

- •77. Типы производства изделий, признаки деления, сравнительная характеристика.

- •Подтипы серийного производства:

- •78. Технологический процесс (тп), определение, структуры и содержание, показатели тп.

- •80. Контроль качества печатных плат, классификация видов контроля, технологический процесс контроля. Характерные дефекты печатных плат.

- •81. Исходная информация при разработке тп сборки. Этапы разработки тп сборки, виды работ и документации по этапам.

- •82. Приведите классификацию видов пайки по различным признакам.

- •83. Технологическая система (тс) и ее структура, показатели качества функционирования тс.

- •84. Технологическая схема сборки (тсс), определение, виды тсс, порядок их разработки, документация.

- •95. Разработка маршрутного тп сборки модуля первого уровня (печатного узла), основные этапы (операции).

- •91. Технический контроль, основные операции входного контроля электронных элементов.

- •85. Качество изделия и его показатели, этапы и методы оценки качества.

- •86. Понятие технологичности конструкции изделий(тки), определение, системы показателей тки.

- •87. Порядок и зависимости при определении технологичности конструкции изделия по базовым показателям.

- •88. Виды электрических соединений, используемых при сборке ивк, основные параметры электрических соединений.

- •89. Приведите структурную схему типового тп сборки электронного узла ивк.

- •90. Технологическая подготовка производства (тпп), основные задачи, структура и стандарты единой тпп (естпп).

- •92. Виды и содержание основной технологической документации.

- •93. Этапы разработки тп сборки электронных узлов (аппаратуры).

- •94. Модульный принцип конструирования электронной аппаратуры, виды и содержание модулей.

- •96. Регулировка (настройка) электронной части ап (ивк), основные методы и их структура.

- •97. Методы обеспечения точности при сборке ап (ивк), их сущность и содержание.

- •98. Виды испытаний ап. Программа и методика климатических испытаний ап.

- •99. Понятие о точности размера детали или параметра. Шкала точностей (квалитеты), расчет единицы и величины допуска.

- •100. Маршрутный тп монтажа печатного узла с применением smd – компонентов.

- •101. Комплексы оборудования самолетов.

- •102. Основные характеристики и требования, предъявляемые к системам отображения информации.

- •103. Основные закономерности построения навигационных комплексов.

- •104. Навигационные комплексы на базе микропроцессоров.

- •105. Иерархические структуры навигационных комплексов. Системы искусственного интеллекта в навигационных комплексах.

- •106. Основные направления развития исследований и систем искусственного интеллекта.

- •107. Диалоговые системы искусственного интеллекта.

- •108. Навигационная бионика. Общность задач и основных принципов навигации в живой природе и технике.

- •109. Интеллектуальный биологический навигационный комплекс.

- •110. Системы искусственного интеллекта – системы, базирующиеся на знаниях.

- •111. Основные структуры систем искусственного интеллекта.

- •112. Представление знаний.

- •113. База знаний систем искусственного интеллекта.

- •114. Стратегия управления и механизм вывода в системах искусственного интеллекта.

- •115. Прямая цепочка рассуждений. База знаний. Обобщенный алгоритм работы.

- •База знаний.

- •Обобщённый алгоритм работы системы.

- •116. Обратная цепочка рассуждений. Дерево решений. База знаний. Обобщенный алгоритм работы.

- •117. Общие методы поиска решений в пространстве состояний.

- •118. Проблемы разработки бортовых оперативно-советующих экспертных систем.

- •119. Системы искусственного интеллекта с использованием нечеткой логики.

- •120. Нечеткие множества и лингвистические переменные.

- •121. Общие принципы построения интеллектуальных систем управления на основе нечеткой логики.

- •122. Процедура синтеза нечетких регуляторов.

- •123. Моделирование механизмов человеческого мышления. Модели нейронов.

- •124. Персептрон ф Розенблата

- •125. Общие принципы построения интеллектуальных сау с использованием нейронных сетей.

- •68. Частотная модуляция. Спектры чм – колебаний.

58. Спектральная плотность случайных колебаний. “Белый шум” и его свойства.

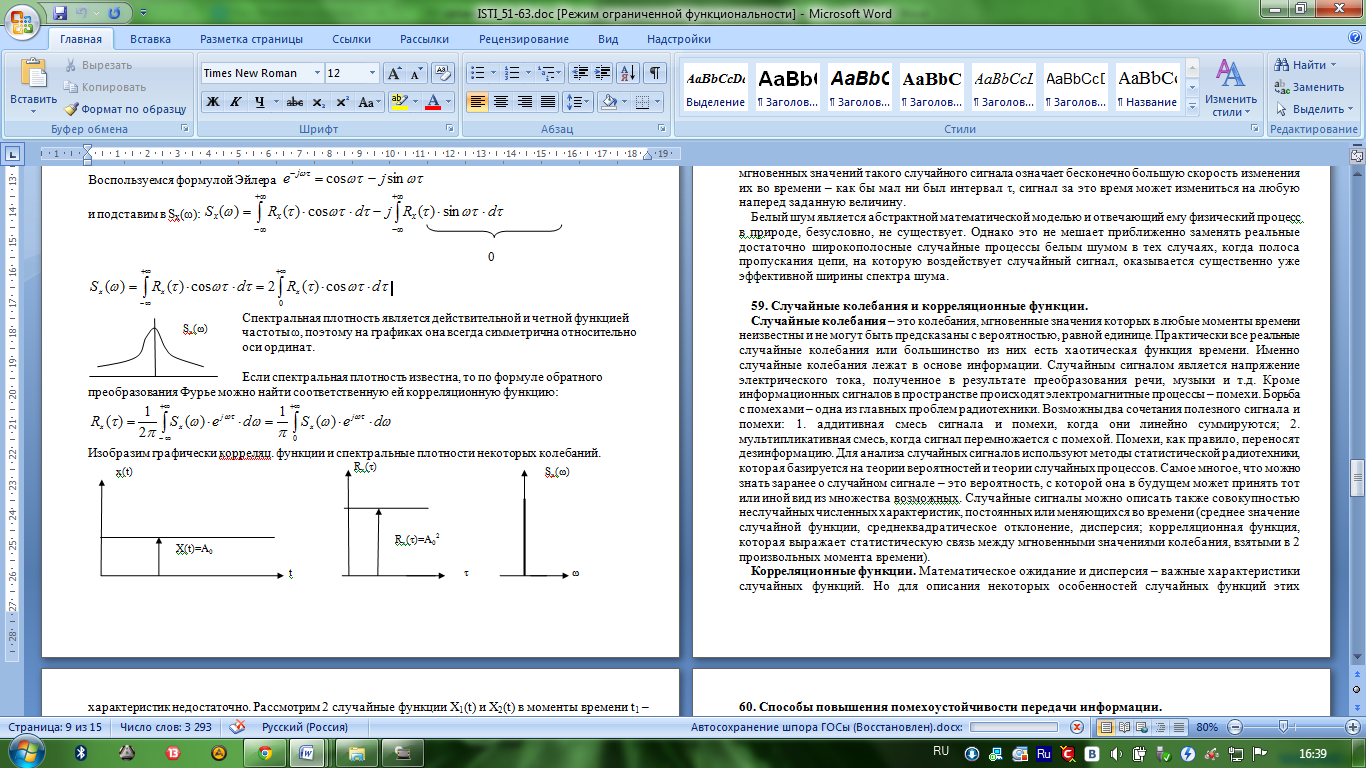

Спектральная плотность Sx(ω) случайного процесса x(t) определяется как преобразование Фурье корреляционной функции Rx(τ):

Воспользуемся

формулой Эйлера

и подставим в Sx(ω):

подставим в Sx(ω):

0

Спектральная

плотность является действительной и

четной функцией частоты ω, поэтому на

графиках она всегда симметрична

относительно оси ординат.

Спектральная

плотность является действительной и

четной функцией частоты ω, поэтому на

графиках она всегда симметрична

относительно оси ординат.

Если

спектральная плотность известна, то

по формуле обратного преобразования

Фурье можно найти соответственную ей

корреляционную функцию:

Изобразим графически корреляц. функции и спектральные плотности некоторых колебаний.

X(t)=Asin(ωt+φ0) Rx(τ)

(косинусоида)

Белый шум. Для анализа радиотехнических цепей и сигналов большой практический интерес представляет специфический случайный процесс, теоретически имеющий равномерный спектр мощности во всей полосе частот:

![]() (2.121)

(2.121)

Такой идеализированный случайный процесс получил название белый шум по аналогии с белым светом, имеющим в видимой части практически равномерный сплошной спектр.

Определим функцию корреляции белого шума. Используя формулы (2.117) и (2.121), запишем

![]() (2.122)

(2.122)

Средняя мощность белого шума неограниченно велика.

Белый шум является дельта-коррелированным случайным процессом. Некоррелированность мгновенных значений такого случайного сигнала означает бесконечно большую скорость изменения их во времени – как бы мал ни был интервал τ, сигнал за это время может измениться на любую наперед заданную величину.

Белый шум является абстрактной математической моделью и отвечающий ему физический процесс в природе, безусловно, не существует. Однако это не мешает приближенно заменять реальные достаточно широкополосные случайные процессы белым шумом в тех случаях, когда полоса пропускания цепи, на которую воздействует случайный сигнал, оказывается существенно уже эффективной ширины спектра шума.

66. Структурные меры информации.

Важнейшим вопросом в теории информации является установление меры, количества и качества информации.

Структурные меры информации.

При использовании их пользуются количеством содержащихся информационных элементов в информационном дискретном комплексе, связями м-ду ними или комбинациями из них. Под информационным элементом понимают неделимые части – кванты информации, а так же элементы алфавитов в числовых системах. Среди структурных схем различают: геометрическую, комбинаторную, аддитивную (мера Хартли) меры информации.

Геометрическая мера – количество информации определяется путём измерения длины линии, площади или объема геометрической модели в количестве дискретных единиц. Можно определить потенциальную, т.е. максимально возможное количество информации в заданных структурных габаритах, которые называют информационной ёмкостью исследуемой части информационный системы, она может представляться числом показывающем количество квантов в полном массиве информации. Если дискретные отчёты осуществляются через интервалы ∆Х, ∆t, ∆N, то непрерывные координаты распадаются на элементы, кванты, количество которых будет:

mX=X/∆X; mТ=T/∆T; mN=N/∆N;

а количество информации определяемым геометрическим методом :

М= mX*mТ *mN;

Комбинаторная мера – количество информации в этой мере вычисляется как количество комбинаторных элементов. В комбинаторике рассматриваются различные меры соединения элементов (сочетание, перестановка, размещение). В комбинаторике возможно в комплексах с неодинаковыми элементами переменными связями или разнообразными позициями. Образование комбинаторики есть одна из форм кодирования. Комбинаторика различает различные виды элементов: сочетание h по l; их возможное число:

перестановки

h:

Ph=1*2*3…h=h!;

размещение из h

по l:

Alh=h!/l!

;

перестановки

h:

Ph=1*2*3…h=h!;

размещение из h

по l:

Alh=h!/l!

;

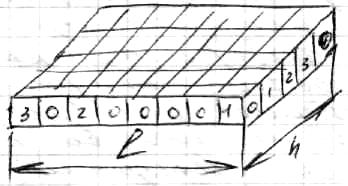

Аддитивная мера – введём понятие глубины h и длинны l числа.

Г лубиной

h

назовём количество элементов (знаков),

содержащихся в принятом алфавите.

Глубина числа соответствует основанию

системы счисления и кодирования. В

каждый момент реализуется один

какой-нибудь знак.

лубиной

h

назовём количество элементов (знаков),

содержащихся в принятом алфавите.

Глубина числа соответствует основанию

системы счисления и кодирования. В

каждый момент реализуется один

какой-нибудь знак.

Длинной l числа назовём количество повторения алфавита необходимых и достаточных для представления чисел нужной величины. l - соответствует разрядности системы счисления и кодирования. При глубине h и длине l количество чисел выразится Q=hl , т.е. ёмкость экспонента зависит от числа l. В следствии показательного закона зависимости Q(l) , Q не очень удобная мера для оценки информационный ёмкости, поэтому Хартли ввёл аддитивную двоичную логарифмическую меру, позволяющую вычислить количество информации в двоичных единицах (битах), для этого берётся не само число Q, а его двоичный логарифм: I= log2Q= log2hl= llog2h; бит.

Он обозначает количество информации по Хартли. Если количество разрядов (длинна l=1) и принять двоичную систему исчисления для которой глубина h=2, то log221=1 бит.

Это если единица информации принятая в системе оценки, она соответствует одному элементарному событию, которое может произойти или не произойти.

Аддитивная мера удобна тем, что обеспечивает возможное сложение а также пропорционально информационной длине числа l.