- •Оглавление

- •Глава 1. Оценивание контролируемых параметров по экспериментальным данным 12

- •Глава 2. Критерий качества задачи оценивания параметра 31

- •Глава 3. Выбор алгоритма обработки экспериментальных данных в автоматизированных системах управления и анализ их свойств 63

- •Глава 4. Формирование модели измерения задачи оценивания по экспериментальным данным 109

- •Глава 5. Формирование модели измерения в задаче оценивания параметра по экспериментальным данным на начальном этапе разработки нового электрооборудования 150

- •Глава 6. Создание устройств формирования модели измерения 176

- •Введение

- •Глава 1. Оценивание контролируемых параметров по экспериментальным данным

- •1.1. Общий анализ этапов структурирования эмпирической информации

- •1.2. Концептуальная модель процесса оценивания контролируемых параметров

- •1.3. Совершенствование алгоритмов обработки экспериментальных данных

- •1.4. Современная концепция оценивания измеряемого параметра

- •1.5. Классификация результатов измерения по характеру оценивания погрешности

- •1.6. Концептуальная модель задачи алгоритмизации оценивания результатов измерения

- •1.7. Ретроспективный анализ этапов развития теории оценивания

- •Контрольные вопросы

- •Глава 2. Критерий качества задачи оценивания параметра

- •2.1. Определение качества задачи оценивания измеряемого параметра

- •2.2. Формирование критерия качества гомоморфной математической модели измерения

- •2.3. Информационная мера степени изоморфности модели

- •2.4. Расчет информационной меры изоморфности

- •2.5. Оценка информационного объема и риска модели измерения

- •2.6. Асимптотическое оценивание пропускной способности математической модели измерения

- •2.7. Асимптотический метод выделения признаков модели измерения

- •Типовые задачи и примеры их решения

- •Контрольные вопросы

- •Глава 3. Выбор алгоритма обработки экспериментальных данных в автоматизированных системах управления и анализ их свойств

- •3.1. Особенности формирования алгоритмов оценивания в автоматизированных системах управления

- •3.2. Общий анализ алгоритмов оценивания по критерию минимума риска

- •3.3. Общий алгоритм оценки измеряемого параметра

- •3.4. Оптимальный одношаговый алгоритм

- •3.5. Модификации алгоритма обработки экспериментальных данных

- •3.6. Моделирование алгоритма обработки экспериментальных данных

- •3.7. Исследование сходимости алгоритма

- •3.8. Определение весовых коэффициентов алгоритма

- •3.9. Определение начальных условий алгоритма Язвинского при оценке результатов измерения

- •Типовые задачи и примеры их решения

- •Контрольные вопросы

- •Глава 4. Формирование модели измерения задачи оценивания по экспериментальным данным

- •4.1. Анализ задачи формирования модели измерения

- •4.2. Принципы построения модели измерения параметра контролируемого объекта

- •4.3. Этапы решения задачи формирования модели измерения

- •4.4. Общая постановка задачи формирования модели измерения

- •4.5. Выбор критерия близости

- •4.6. Способы преобразования переменных модели измерения

- •4.7. Общий анализ формирования модели контролируемого объекта

- •4.8. Решение задачи формирования модели контролируемого объекта

- •4.9. Оптимизация алфавита классов и словаря признаков

- •4.10. Взаимосвязь размерности алфавита классов и качества и эффективности модели измерения

- •4.11. Взаимосвязь размерности вектора признаков и вероятности правильности формирования модели измерения

- •4.12. Формализация задачи оптимального взаимосвязанного выбора алфавита классов и словаря признаков

- •4.13. Формирование оптимального алфавита классов и словаря признаков в условиях ограничений

- •Контрольные вопросы

- •Глава 5. Формирование модели измерения в задаче оценивания параметра по экспериментальным данным на начальном этапе разработки нового электрооборудования

- •5.1. Исследование условий формирования модели измерения задачи оценивания измеряемого параметра

- •5.2. Геометрический способ формирования модели измерения

- •5.3. Лингвистический алгоритм формирования модели измерения на начальных этапах оценивания

- •5.4. Обоснование выбора критерия расхождения для формирования модели измерения по экспериментальным данным

- •5.5. Метод формирования модели измерения

- •5.7. Синтез метода и алгоритма формирования стратегии постановки начальных экспериментов

- •Типовые задачи и примеры их решения

- •6. Найденный квант исключается из множества г, т.Е.

- •Контрольные вопросы

- •Глава 6. Создание устройств формирования модели измерения

- •6.1. Состав устройства формирования модели измерения

- •6.2. Общий анализ устройств формирования моделей измерения

- •6.3. Общий анализ моделирования устройств формирования модели измерения

- •6.4. Структура устройства формирования модели измерения

- •6.5. Моделирование контролируемого объекта

- •6.6. Моделирование средств измерения параметров контролируемого объекта

- •6.7. Моделирование каналов измерения

- •Типовые задачи и примеры их решения

- •6.8. Модель алгоритма формирования модели измерения

- •6.9. Модуль оценки качества и эффективности устройства формирования

- •6.10. Модуль управления моделью устройства формирования

- •6.11. Использование принципов опытно-теоретического метода при моделировании устройства формирования

- •6.12. Моделирование в задачах создания и оптимизации устройства формирования

- •Заключение

- •Библиографический список

- •Системы реального времени Синтез алгоритмов оценивания технологического параметра

- •346428, Г. Новочеркасск, ул. Просвещения, 132

4.5. Выбор критерия близости

Для определения качества процедуры формирования модели измерения, могут быть выбраны критерии близости, использующие разные подходы их формирования.

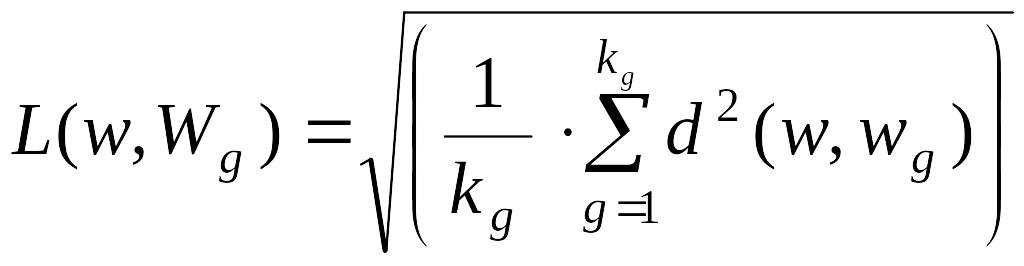

I. В алгоритмах формирования, использующих детерминированные признаки в качестве меры близости, естественно применить среднеквадратическое расстояние между данным объектом w и совокупностью объектов (w1, w2,...., wn), представляющих (описывающих) каждый класс. Для сравнения с классом Wg это выглядит так:

,

,

где kg – количество объектов, представляющих Wg-й класс.

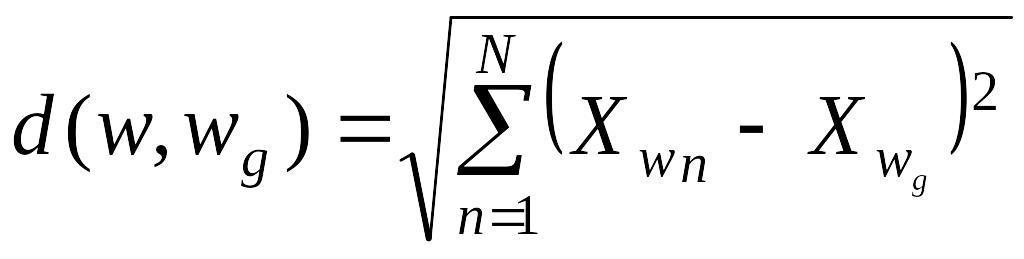

При этом в качестве методов измерений расстояния между объектами d(w, wg) могут использоваться любые методы. Так, если сравнивать непосредственно координаты (признаки), то

,

,

где N – размерность признакового пространства.

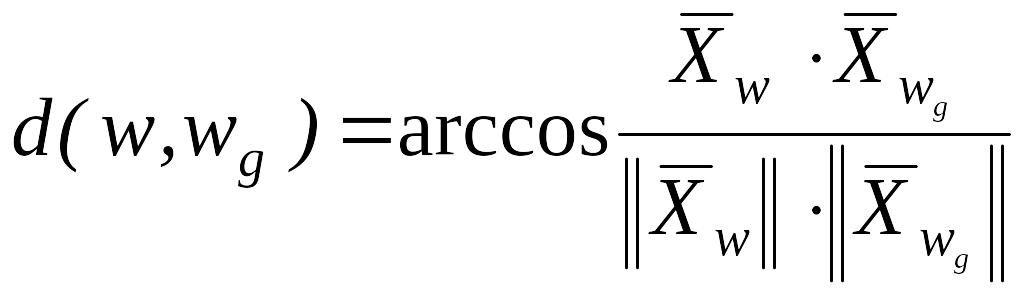

Если сравнивать угловые отклонения, то рассматривая вектора, составляющими которых являются признаки КО w и класса wg, будем иметь

,

,

где

![]() |

и

|

и

![]() – нормы соответствующих векторов.

– нормы соответствующих векторов.

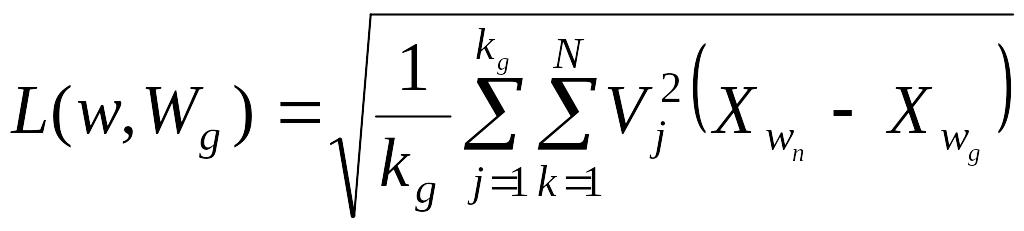

В алгоритме формирования, использующем детерминированные признаки можно учитывать и их веса Vj (устанавливать степень доверия или важности). Тогда рассмотренное среднеквадратическое расстояние принимает следующий вид:

.

.

II. В алгоритмах формирования, использующих вероятностные признаки, в качестве меры близости используется риск, связанный с решением о принадлежности объекта к классу Wi, где i – номер класса. (i = 1, 2,.., m.).

Пусть описание классов представлено

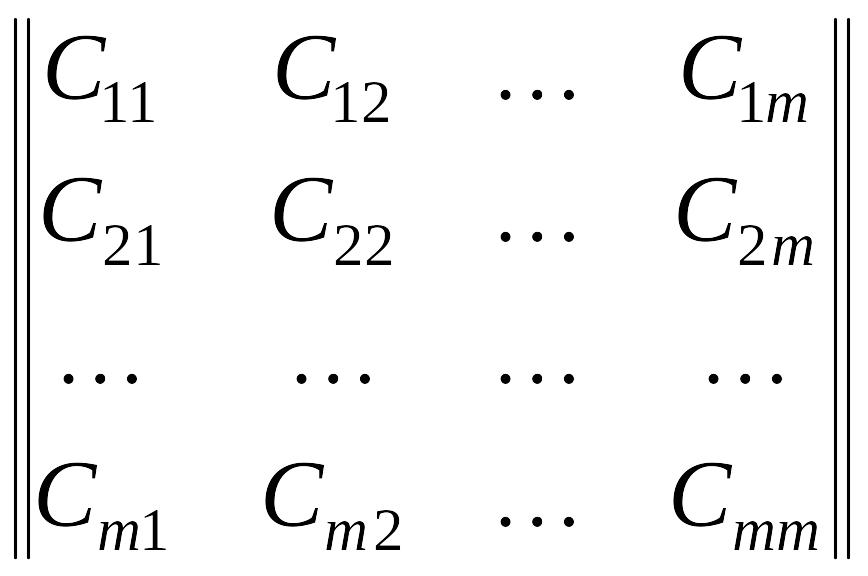

![]() .

.

В рассматриваемом случае к исходным данным для расчета меры близости относится платежная матрица вида

.

.

Здесь на главной диагонали – потери при правильных решениях. Обычно принимают Сii=0 или Cii<0.

Если

вектор признаков контролируемого

объекта w

–

![]() ,

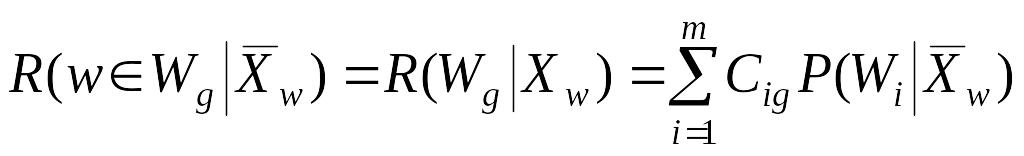

то риск, связанный с принятием решения

о принадлежности этого объекта к классу

Wg,

когда на самом деле он может принадлежать

классам W1,

W2,...,

Wm,

наиболее целесообразно определять как

среднее значение потерь

,

то риск, связанный с принятием решения

о принадлежности этого объекта к классу

Wg,

когда на самом деле он может принадлежать

классам W1,

W2,...,

Wm,

наиболее целесообразно определять как

среднее значение потерь

С1g, C2g,..., Cmg,

то есть потерь, стоящих в g-м столбце платежной матрицы. Тогда этот средний риск можно записать как

,

,

где

P(WiXw)

– апостериорная вероятность того, что

w![]() Wi.

Wi.

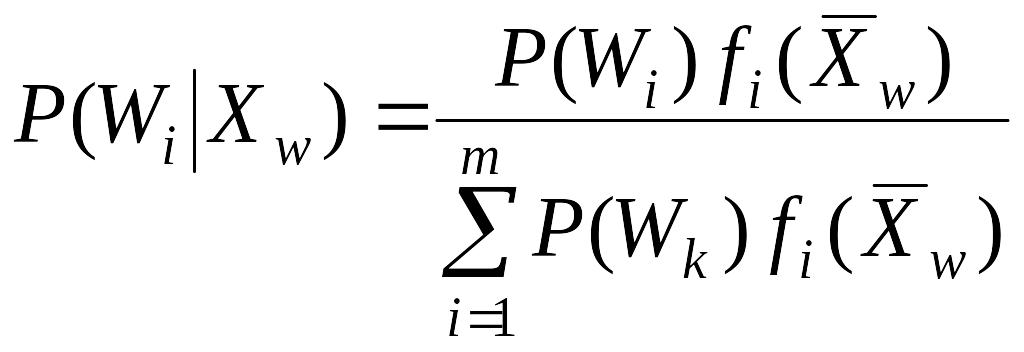

Для исходных данных, а именно описаний классов, эта вероятность легко может быть определена в соответствии с теоремой гипотез или по формуле Байеса:

.

.

III.

В наиболее общем случае, когда приходится

при формировании модели измерения

использовать информацию гетерогенного

характера, т.е. разнообразную по характеру

и содержанию, необходимо применять

информационный

критерий близости.

При этом статистика,

определенная разбиением

=

![]() ,

является достаточной для различения,

если

разбито на попарно непересекающиеся

множества и

,

является достаточной для различения,

если

разбито на попарно непересекающиеся

множества и

I(1:2)

=

,

,

где 2(E1) = P(xE1H2) – вероятность неправильного принятия гипотезы H1 (ошибка первого рода); 1(E2) = P(xE2H1) – вероятность неправильного принятия гипотезы H2 (ошибка второго рода).

Из общего анализа процедуры различения можно сформулировать характерные требования, которым должен удовлетворять критерий, определяющий различения между выборками, полученными в результате измерения. Так, в среднем различающая информация, получаемая из статистических наблюдений, положительна. Все x E, для которых выполнено условие равенства, можно рассматривать как эквивалентные в задаче различения. Если распределения, соответствующие обеим гипотезам совпадают, то различающая информация не существует. При этом группировка, сгущение или другие преобразования наблюдений с помощью статистики ведут в общем случае к потере информации. В случае достаточной статистики разбиения, когда самые крупные элементы группировки содержат в себе такую же информацию, как разбиение с элементами в виде точек исходного пространства, информация не теряется. Достаточность статистики для семейства распределений не нарушается при усечении или при отборе в соответствии с функцией (x) = (T(x)).

Если

разбиение пространства X

удовлетворяет необходимому и достаточному

условиям, т.е. если плотности распределения

x

при условии Ei

одни и те же для обеих гипотез по всем

членам разбиения, то можно определить

разбиение X

=

![]() как достаточное разбиение для различения.

При достаточности разбиение с самыми

крупными элементами группировки содержит

в себе такую же информацию, как разбиение

с элементами в виде точек пространства

X.

Понимая под статистикой разбиение

пространства X

на множества эквивалентных x,

можно сказать, что статистика, определенная

разбиением X

=

как достаточное разбиение для различения.

При достаточности разбиение с самыми

крупными элементами группировки содержит

в себе такую же информацию, как разбиение

с элементами в виде точек пространства

X.

Понимая под статистикой разбиение

пространства X

на множества эквивалентных x,

можно сказать, что статистика, определенная

разбиением X

=

![]() является достаточной для различения,

если необходимое и достаточное условие

того, что информация не уменьшается

после группировки

является достаточной для различения,

если необходимое и достаточное условие

того, что информация не уменьшается

после группировки

=

= выполнено, т.е. “статистика отбирает

для суммирования всю относящуюся к делу

информацию, доставляемую выборкой”

[77].

выполнено, т.е. “статистика отбирает

для суммирования всю относящуюся к делу

информацию, доставляемую выборкой”

[77].

Пусть

Y

= T(x)

– статистика, т.е. T(x)

является функцией с областью определения

X

и областью значений Y,

и пусть Г – аддитивный класс подмножеств

Y.

Предположим, что T(x)

– измеримая функция, т.е. для любого

множества G

Г полный прообраз T–

1(G)={x:

T(x)G}

[T–

1(G)

– есть совокупность элементов x

таких, что T(x)G]

прнадлежит классу S

измеримых подмножеств пространства X.

Класс всех множеств вида T–

1(G),

где GГ,

обозначается T–

1(Г). Таким

образом, имеем измеримое отображение

T

вероятностного пространства (X,

S,

i)

в вероятностное пространство (Y,

Г, vi),

где vi(G)

![]() i

(T–

1(G)).

i

(T–

1(G)).

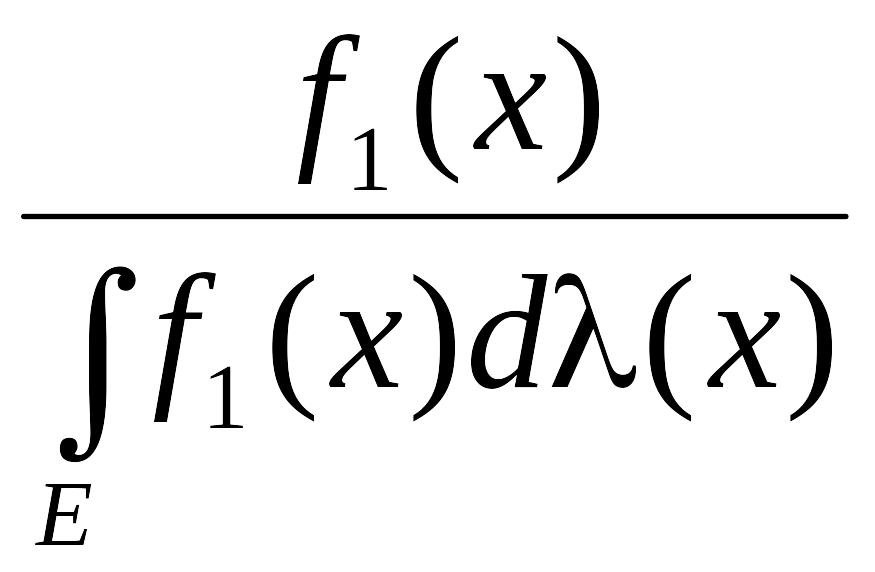

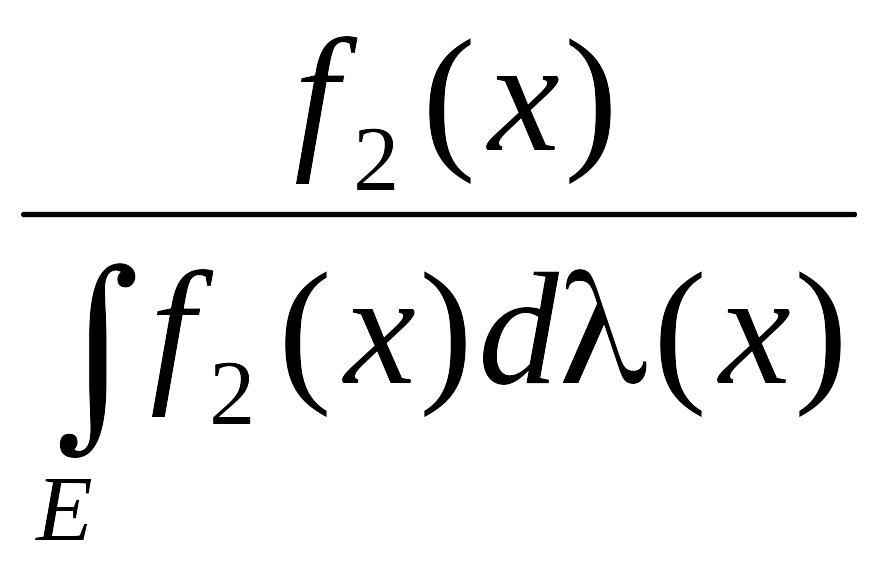

Если определить (G) = (T– 1(G)), v1 v2 (меры абсолютно непрерывны одна относительно другой), то теорема Радона – Никодима позволяет утверждать существование таких плотностей вероятности gi(y), i = 1, 2, что

vi(G)

=

![]() ,

i

= 1, 2, G

Г,

,

i

= 1, 2, G

Г,

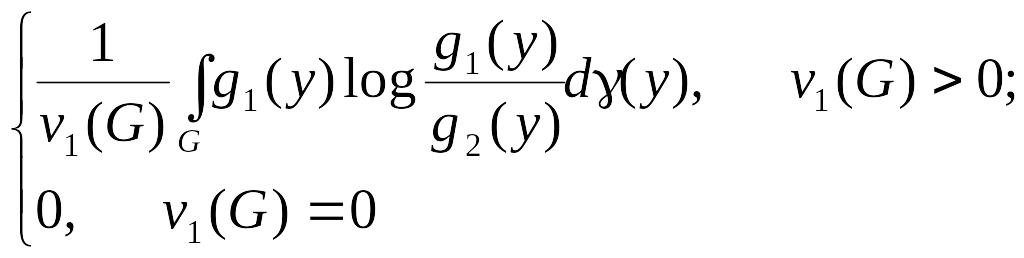

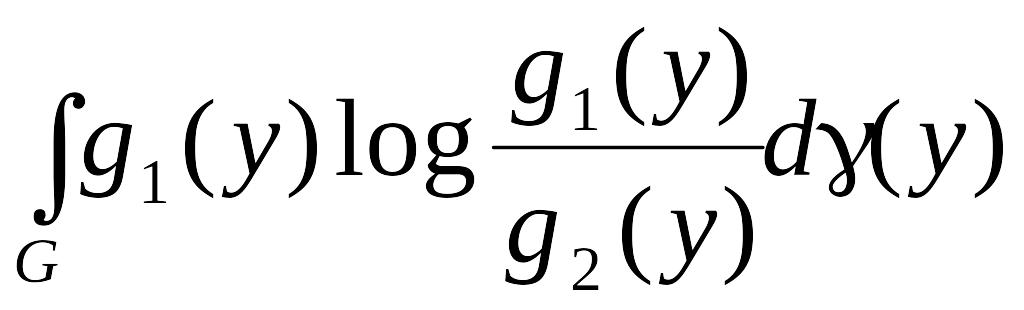

для всех G Г. Функция gi(y) является условным математическим f(x) при условии T(x) = y и обозначается E(fiy). В этом случае в терминах вероятностных пространств (Y, , vi), i = 1, 2, различающая информация определяется различием

I(1:2;

G)

=

и

I(1:2;

Y)

=

.

.

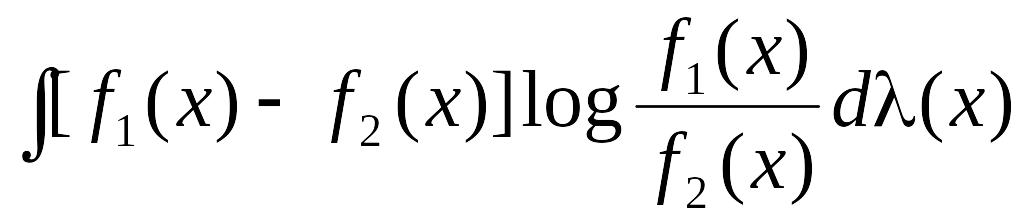

При этом вероятностные меры 1 и 2 должны быть абсолютно непрерывны одна относительно другой. Это требование связано с возможностью определения I(1:2) и I(2:1), чтобы могло существовать расхождение

J(1:2)

= I(1:2)

+ I(2:1)

=

,

,

которое и определяет информационное различие между двумя элементами.

IV. Для алгоритмов, основанных на логических признаках, достаточно подставить их в булевы соотношения между классами и признаками, чтобы сразу получить результат как истинность или ложность булевой функции описания того или иного класса.

V. Для алгоритмов, основанных на структурных (лингвистических) признаках, понятие “меры близости” более специфично.

С учетом того, что каждый класс описывается совокупностью предложений, характеризующих структурные особенности объектов соответствующих классов, выбор неизвестного объекта осуществляется идентификацией предложения, описывающего этот объект с одним из предложений в составе описания какого-либо класса. При этом идентификация может подразумевать наибольшее сходство предложения, описывающего контролируемый объект с предложениями из наборов описания каждого класса.

Формирование модели осуществляется последовательными приближениями по мере получения дополнительной информации. В этом ряду последовательных приближений главную роль играют признаки измерения. От эффективности их набора зависит эффективность модели контролируемого объекта в целом. В процессе совершенствования модели указанный набор пополняется, неэффективные признаки исключаются. Поэтому одной из задач формирования модели должна быть и задача перехода от априорного словаря признаков к рабочему. То же касается и априорного алфавита классов.