- •Оглавление

- •Глава 1. Оценивание контролируемых параметров по экспериментальным данным 12

- •Глава 2. Критерий качества задачи оценивания параметра 31

- •Глава 3. Выбор алгоритма обработки экспериментальных данных в автоматизированных системах управления и анализ их свойств 63

- •Глава 4. Формирование модели измерения задачи оценивания по экспериментальным данным 109

- •Глава 5. Формирование модели измерения в задаче оценивания параметра по экспериментальным данным на начальном этапе разработки нового электрооборудования 150

- •Глава 6. Создание устройств формирования модели измерения 176

- •Введение

- •Глава 1. Оценивание контролируемых параметров по экспериментальным данным

- •1.1. Общий анализ этапов структурирования эмпирической информации

- •1.2. Концептуальная модель процесса оценивания контролируемых параметров

- •1.3. Совершенствование алгоритмов обработки экспериментальных данных

- •1.4. Современная концепция оценивания измеряемого параметра

- •1.5. Классификация результатов измерения по характеру оценивания погрешности

- •1.6. Концептуальная модель задачи алгоритмизации оценивания результатов измерения

- •1.7. Ретроспективный анализ этапов развития теории оценивания

- •Контрольные вопросы

- •Глава 2. Критерий качества задачи оценивания параметра

- •2.1. Определение качества задачи оценивания измеряемого параметра

- •2.2. Формирование критерия качества гомоморфной математической модели измерения

- •2.3. Информационная мера степени изоморфности модели

- •2.4. Расчет информационной меры изоморфности

- •2.5. Оценка информационного объема и риска модели измерения

- •2.6. Асимптотическое оценивание пропускной способности математической модели измерения

- •2.7. Асимптотический метод выделения признаков модели измерения

- •Типовые задачи и примеры их решения

- •Контрольные вопросы

- •Глава 3. Выбор алгоритма обработки экспериментальных данных в автоматизированных системах управления и анализ их свойств

- •3.1. Особенности формирования алгоритмов оценивания в автоматизированных системах управления

- •3.2. Общий анализ алгоритмов оценивания по критерию минимума риска

- •3.3. Общий алгоритм оценки измеряемого параметра

- •3.4. Оптимальный одношаговый алгоритм

- •3.5. Модификации алгоритма обработки экспериментальных данных

- •3.6. Моделирование алгоритма обработки экспериментальных данных

- •3.7. Исследование сходимости алгоритма

- •3.8. Определение весовых коэффициентов алгоритма

- •3.9. Определение начальных условий алгоритма Язвинского при оценке результатов измерения

- •Типовые задачи и примеры их решения

- •Контрольные вопросы

- •Глава 4. Формирование модели измерения задачи оценивания по экспериментальным данным

- •4.1. Анализ задачи формирования модели измерения

- •4.2. Принципы построения модели измерения параметра контролируемого объекта

- •4.3. Этапы решения задачи формирования модели измерения

- •4.4. Общая постановка задачи формирования модели измерения

- •4.5. Выбор критерия близости

- •4.6. Способы преобразования переменных модели измерения

- •4.7. Общий анализ формирования модели контролируемого объекта

- •4.8. Решение задачи формирования модели контролируемого объекта

- •4.9. Оптимизация алфавита классов и словаря признаков

- •4.10. Взаимосвязь размерности алфавита классов и качества и эффективности модели измерения

- •4.11. Взаимосвязь размерности вектора признаков и вероятности правильности формирования модели измерения

- •4.12. Формализация задачи оптимального взаимосвязанного выбора алфавита классов и словаря признаков

- •4.13. Формирование оптимального алфавита классов и словаря признаков в условиях ограничений

- •Контрольные вопросы

- •Глава 5. Формирование модели измерения в задаче оценивания параметра по экспериментальным данным на начальном этапе разработки нового электрооборудования

- •5.1. Исследование условий формирования модели измерения задачи оценивания измеряемого параметра

- •5.2. Геометрический способ формирования модели измерения

- •5.3. Лингвистический алгоритм формирования модели измерения на начальных этапах оценивания

- •5.4. Обоснование выбора критерия расхождения для формирования модели измерения по экспериментальным данным

- •5.5. Метод формирования модели измерения

- •5.7. Синтез метода и алгоритма формирования стратегии постановки начальных экспериментов

- •Типовые задачи и примеры их решения

- •6. Найденный квант исключается из множества г, т.Е.

- •Контрольные вопросы

- •Глава 6. Создание устройств формирования модели измерения

- •6.1. Состав устройства формирования модели измерения

- •6.2. Общий анализ устройств формирования моделей измерения

- •6.3. Общий анализ моделирования устройств формирования модели измерения

- •6.4. Структура устройства формирования модели измерения

- •6.5. Моделирование контролируемого объекта

- •6.6. Моделирование средств измерения параметров контролируемого объекта

- •6.7. Моделирование каналов измерения

- •Типовые задачи и примеры их решения

- •6.8. Модель алгоритма формирования модели измерения

- •6.9. Модуль оценки качества и эффективности устройства формирования

- •6.10. Модуль управления моделью устройства формирования

- •6.11. Использование принципов опытно-теоретического метода при моделировании устройства формирования

- •6.12. Моделирование в задачах создания и оптимизации устройства формирования

- •Заключение

- •Библиографический список

- •Системы реального времени Синтез алгоритмов оценивания технологического параметра

- •346428, Г. Новочеркасск, ул. Просвещения, 132

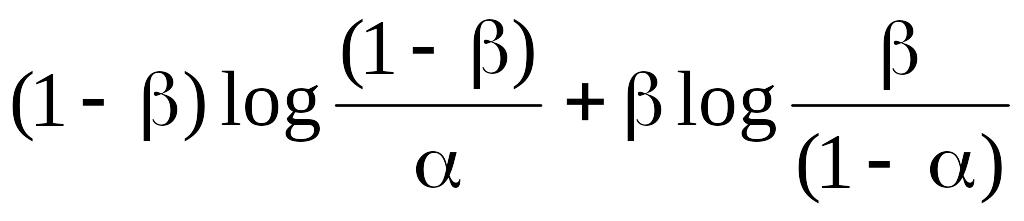

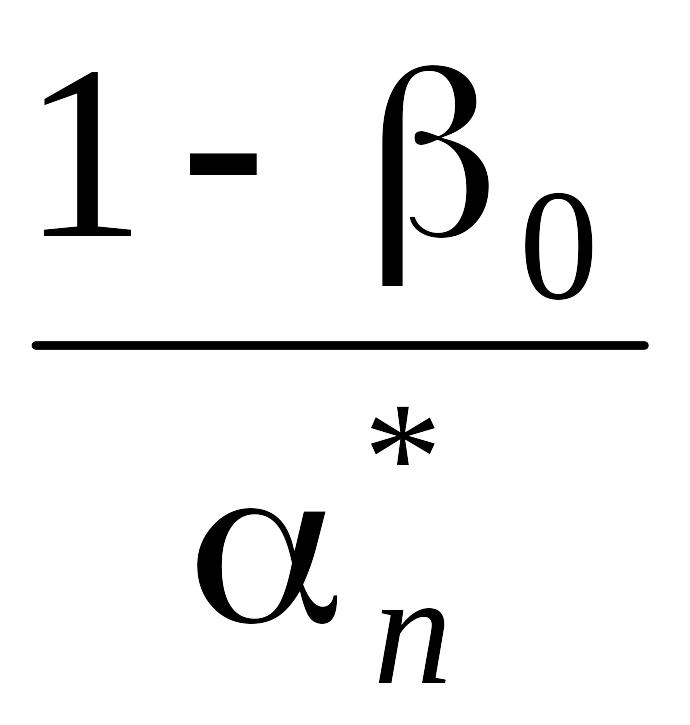

2.6. Асимптотическое оценивание пропускной способности математической модели измерения

При последовательном накоплении измеряемой информации возможно асимптотическое оценивание пропускной способности в соответствии с теоремой.

Теорема 2.6.1. Пропускная способность многопараметрической ММИ

П(Pi;

fi)

![]() ,

,

где

2(![]() )

=1 – ,

= P(x

EH2),

1(E)

= 1 – ,

= P(x

H1).

)

=1 – ,

= P(x

EH2),

1(E)

= 1 – ,

= P(x

H1).

Доказательство.

Поскольку для устройства измерения

лишь только одна k

– я переменная является доминирующей,

то из приведенной выше теоремы следует

![]() = 1 = Pk,

а предельный объем модели равен

= 1 = Pk,

а предельный объем модели равен

П(Pi;

fi)

=

![]() i(xi)logfi(xi)/f(x1,...,

xN)d(x).

i(xi)logfi(xi)/f(x1,...,

xN)d(x).

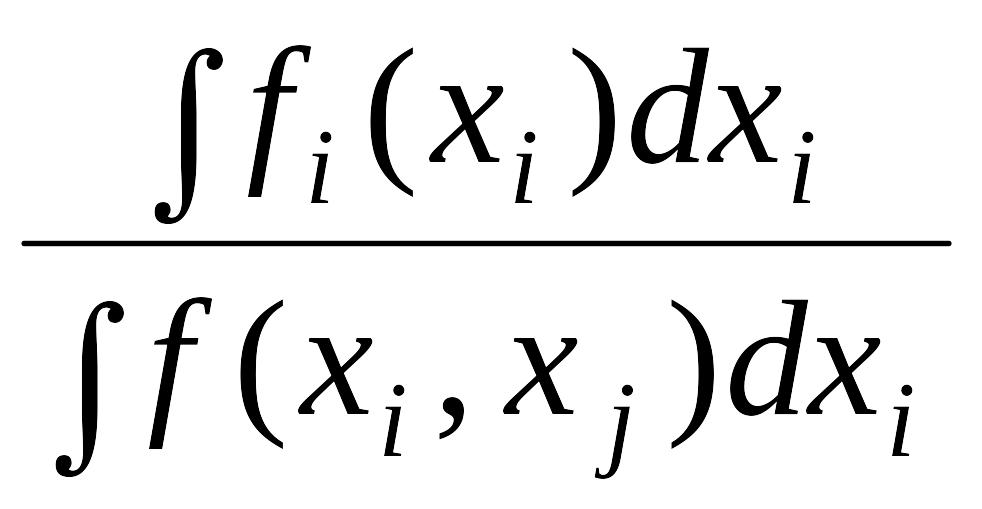

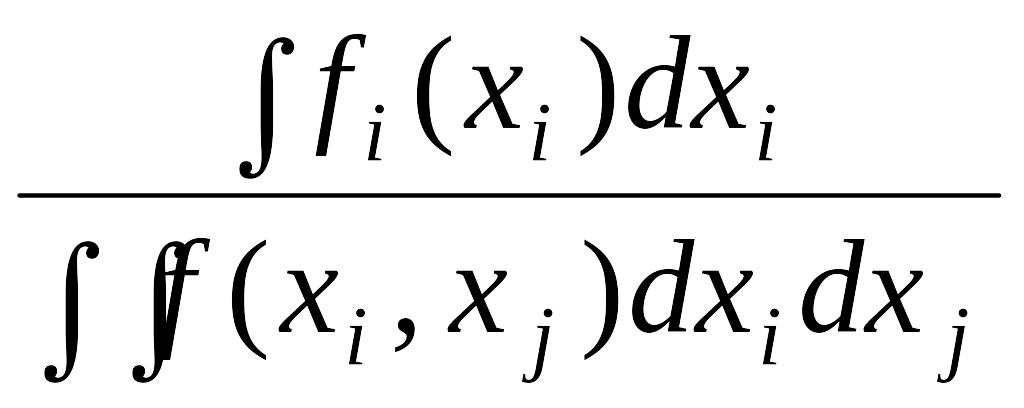

В частности, для модели, состоящей из двух обособленных (независимых) переменных xi E и xj , получаем

П(Pi;

fi)=![]() i(xi)logfi(xi)/f(xi,

xj)d(x)

i(xi)logfi(xi)/f(xi,

xj)d(x)![]() i(x

i)dxi)logd

i(x

i)dxi)logd xj

xj

![]() i(x

i)dxi)log

i(x

i)dxi)log

=

,

=

,

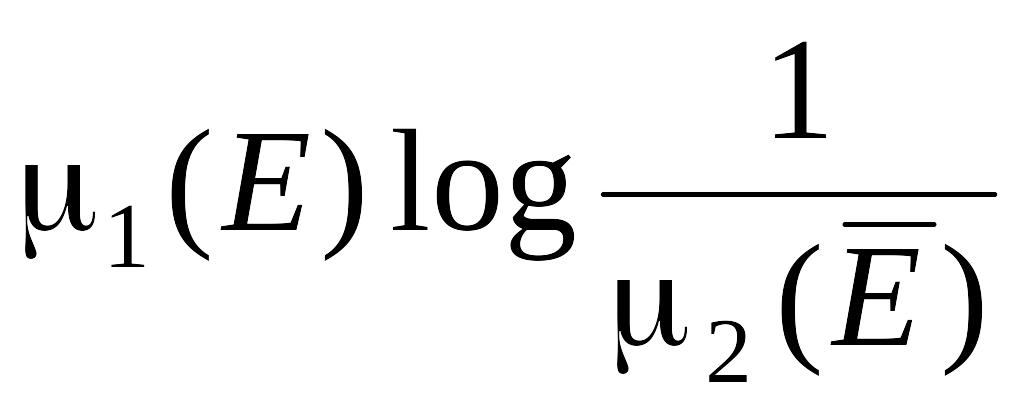

где 2( ) =1 – , = P(x EH2), 1(E) = 1 – , = P(x H1).

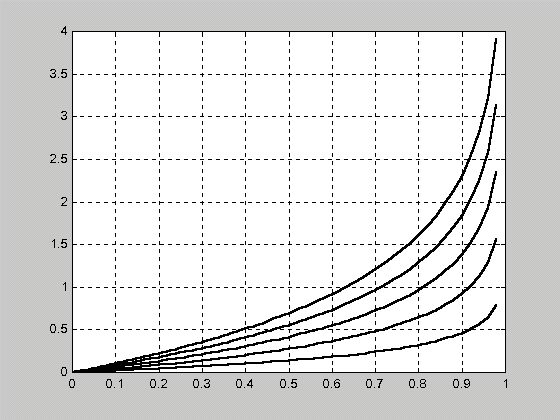

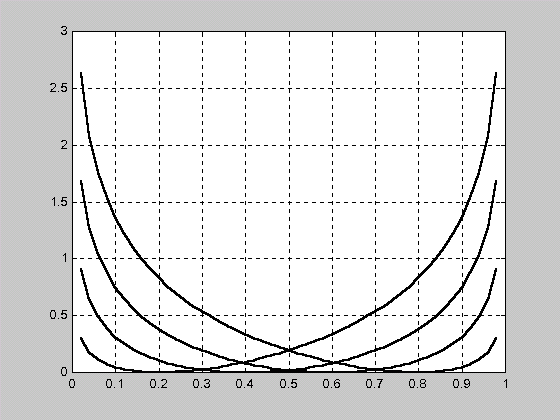

Полученная в теореме 2.6.1 зависимость пропускной способности многопараметрической ММИ от вероятностей ошибок первого и второго рода приведена на рис. 2.1. Из данной зависимости следует, что при последовательном накоплении измеряемой информации увеличение ошибок требует увеличения пропускной способности устройства измерения.

R()

=1

=0,8

=0,6

=0,4

=0,2

Рис. 2.1.

Зависимость пропускной способности

многопараметрической ММИ от вероятностей

ошибок первого и второго рода при

последовательном накоплении информации

контроля

2.7. Асимптотический метод выделения признаков модели измерения

Выделение

общей ММИ сводится к определению каждого

из ее признаков, т.е. выделение

соответствующего класса, который

определяется областью определения

этого признака в общей области определения

всей модели. Таким образом, задача

выделения признака ММИ, постановка

которой приведена в разд. 3.3, заключается

в разбиении области определения общей

ММИ на области определения каждого

признака. В частном случае, если область

определения двухпризнаковой общей

модели (пространство выборок в n

независимых наблюдений) X

разбита на непересекающиеся множества

E

и

![]() (Е

= 0, X =

E

)

индикатором множества E(x).

Причем процедура разбиения заключается

в том, что если выборка xE

(E(x)=1),

принимается гипотеза H1

(отвергается H2),

и если выборка x

(E(x)=0),

принимается гипотеза H2

(отвергается H1).

Гипотеза H2

рассматривается как нулевая гипотеза,

а E

является критической областью. Вероятность

неправильного принятия гипотезы H1,

ошибка первого рода, равна =P(xE1H2)=2(E1),

а вероятность неправильного принятия

гипотезы H2,

ошибка второго рода, равна

= P(x

E2H1)

= 1(E2).

(Е

= 0, X =

E

)

индикатором множества E(x).

Причем процедура разбиения заключается

в том, что если выборка xE

(E(x)=1),

принимается гипотеза H1

(отвергается H2),

и если выборка x

(E(x)=0),

принимается гипотеза H2

(отвергается H1).

Гипотеза H2

рассматривается как нулевая гипотеза,

а E

является критической областью. Вероятность

неправильного принятия гипотезы H1,

ошибка первого рода, равна =P(xE1H2)=2(E1),

а вероятность неправильного принятия

гипотезы H2,

ошибка второго рода, равна

= P(x

E2H1)

= 1(E2).

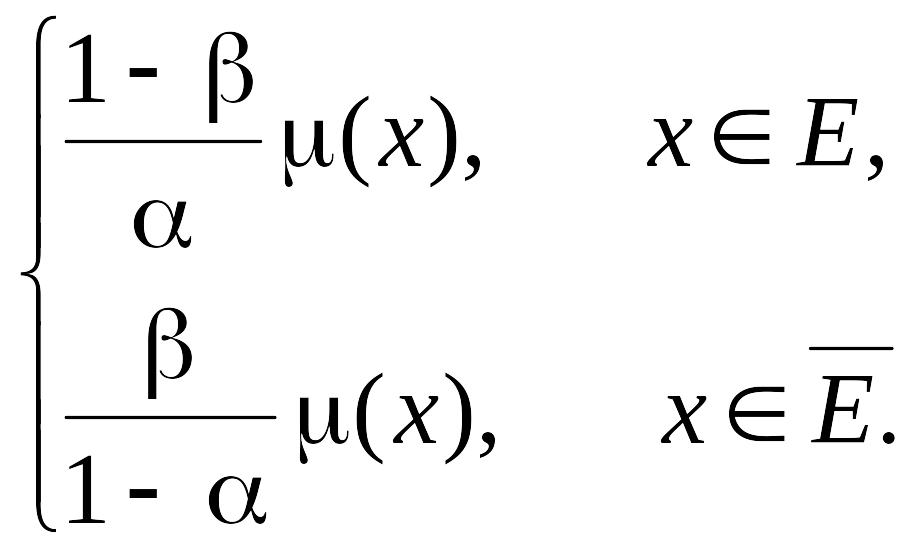

При этом риск разбиения, в соответствии с теоремой 3.1 [66], которая определяет условия минимума различающей информации, для статистики Т(x)=E(x) определяется выражением

Rр(1:2)

(2.20)

(2.20)

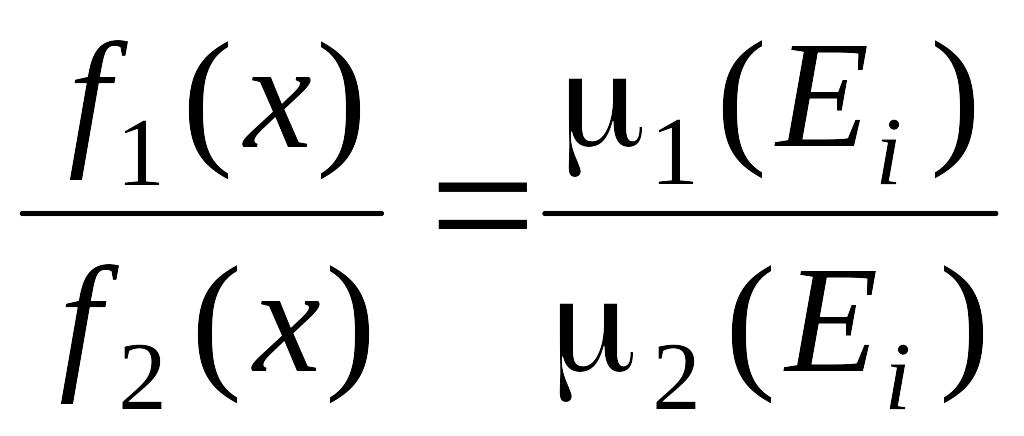

с равенством, совпадающим с минимумом, при

f1(x)

=

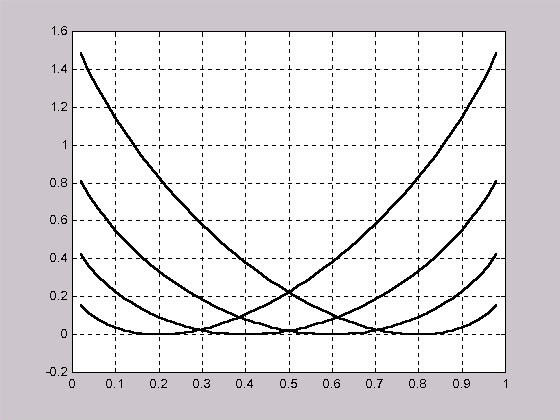

Установленные в данном выражении зависимости риска разбиения от вероятности ошибки первого и второго рода при последовательном накоплении информации измерения приведены на рис. 2.2 и 2.3 соответственно.

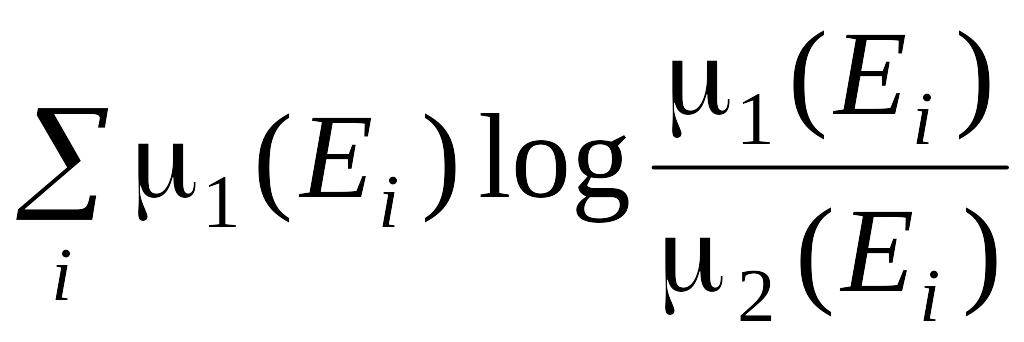

Данные выражения позволяют разбивать пространства X с ошибками , без потери информации, поскольку это разбиение достаточное. Причем риск выбора модели для соответствующих переменных при заданных значениях ошибок их идентификации , по областям определения можно получить, равным нулю (рис. 2.2, 2.3). В общем случае, если Ei S, i = 1,2,..., Ei Ej и X = Ei, т.е. если Х разбито на попарно непересекающиеся множества E1, E2,..., то в соответствии со следствием 3.3.2 [66]

Rр(1:2)

,

,

а равенство достигается при условии

для x Ei, i = 1, 2,...

R()

Рис. 2.2.

Зависимость риска разбиения от

вероятности ошибки первого рода при

последовательном накоплении измерительной

информации

=0,2

=0,4

=0,6

=0,8

R()

Рис. 2.3.

Зависимость риска разбиения от

вероятности ошибки второго рода при

последовательном накоплении измерительной

информации

=0,2

=0,4

=0,6

=0,8

При оценке качества асимптотического выделения признака ММИ методом последовательного анализа, необходимо использовать теорему 4.3.1 [66], которая совпадает с выражением, полученным в разделе 3.8.

Теорема:

Rр(On)

= nRр(O1)

log![]() + (1 – )log

+ (1 – )log![]() ,

,

где On – выборка в n независимых наблюдений, а O1 – выборка, состоящая из одного наблюдения.

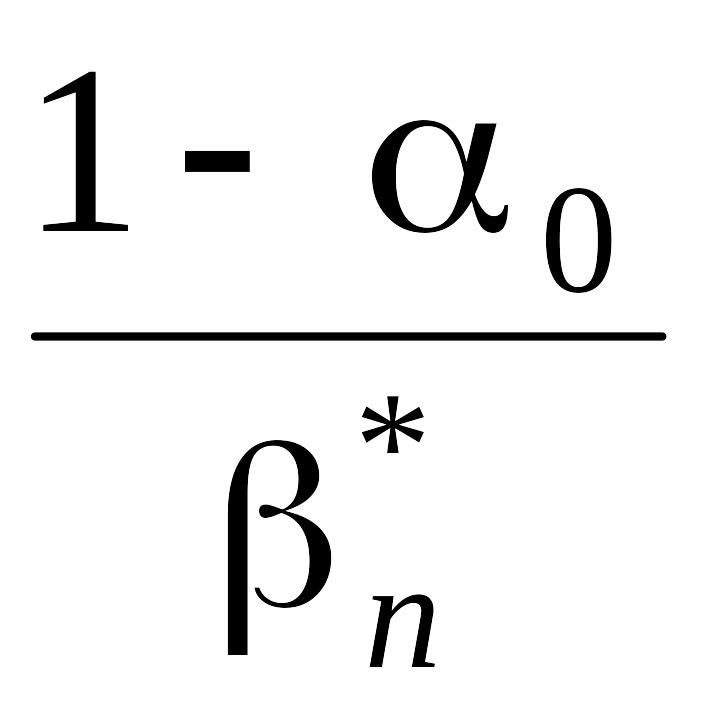

Для фиксированного значения , скажем 0, 0 < 0 < 1, нижняя граница минимума всех возможных = n* получается из формулы

Rр(O1)

n–10log + (1 – 0)log

+ (1 – 0)log .

.

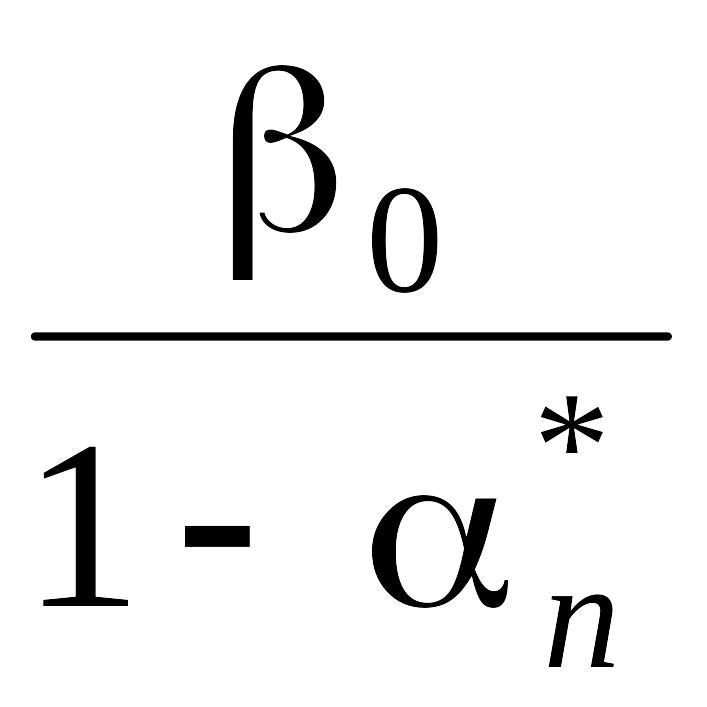

Аналогично, для фиксированного значения 0, 0<0<1, нижняя граница , n* получается из формулы

Rр(O1)

n–10log + (1 – 0)log

+ (1 – 0)log .

.

Величины Rр(1:2; X)/Rр(1:2; Y) и Rр(2:1; X)/Rр(2:1; Y) могут быть использованы (для больших выборок) как мера относительной эффективности конкурирующих переменных X и Y в том смысле, что

Rр(1:2; X)/Rр(1:2; Y) = ny/nx или Rр(2:1; X)/Rр(2:1; Y) = Ny/Nx,

где nx, ny и Nx, Ny – соответственно объемы выборок, необходимых для того, чтобы получить для данного 0 то же n* и для данного 0 – то же n*.