- •1. Теорема умножения вероятностей.

- •[Править]Проверка ограничений на параметры регрессии

- •[Править]Замечание

- •[Править]Проверка значимости линейной регрессии

- •[Править]Пример

- •2. Теорема сложения вероятностей.

- •3. Вероятность наступления хотя бы одного из нескольких попарно независимых событий.

- •Примеры f-тестов

- •Две выборки

- •Замечание

- •Проверка значимости линейной регрессии

Основные положения теории вероятностей

Окружающий нас мир полон случайностей. Номера выигрышных билетов в лотерее, количество солнечных дней в году, результаты спортивных состязаний, выпадение “решки” при подбрасывании монеты, неожиданная случайная встреча, кардинально переворачивающая судьбу – все это примеры случайных событий,происходящих в повседневной жизни и влияющих на нее.

Теория вероятностей не может предсказать, произойдет или не произойдет какое_то реальное событие, а лишь предлагает математический аппарат для анализа и прогнозирования вероятности его появления. Она изучает вероятностные закономерности случайных событий, существующие объективно,

т.е. независимо от наших желаний и предпочтений.

Исторически зарождение теории вероятностей связано с поиском закономерностей в азартных играх, таких как карты и кости. Именно тогда были предприняты первые попытки математического прогнозирования и количественного определения шансов на успех. Исходными понятиями здесь являются понятия “случайное событие” и “испытание” (опыт, эксперимент).

Случайное событие – это явление, которое при одних и техже условиях может или произойти, или не произойти.

Испытание – это создание и осуществление этих неопределенных условий. Любое испытание приводит к результату или исходу, который заранее невозможно точно предсказать. Случайные события происходят повсеместно – в природе, науке, технике, экономике, военном деле и т.д. Приведем простейшие

примеры испытаний и соответствующих им случайных событий.

Важно отметить, что на самом деле “случайные события” вовсе не случайныпросто для их расчета пришлось бы учесть такое количество факторов и произвести расчеты такой сложности, что никто этим не занимается. Однако с совершенстованием компьютеров и датчиков люди cмогут анализировать данные все

Табл 3. Примеры простейших испытаний и событий

быстрее и точнее и многие события перестают быть случайными.

Например, попадание снаряда в цель перестало быть случайным, когда в нем появился компьютер, рассчитывающий и корректирующий траекторию полета. Выигрыш в рулетку сотни лет считался случайностью, пока хитрые игроки не наловчились передавать данные об игре через видеокамеру в суперкомпьютер, который смог рассчитать, на какую цифру упадет шарик. С развитиемнанотехнологии компьютеры станут еще мощнее и компактнее, а значит, многие события перестанут быть случайными и станут не только предсказуемыми, но и управляемыми.

Случайные события могут быть:

а) достоверными или невозможными;

Достоверным называется событие, которое в данных условиях всегда происходит, невозможным – если оно никогда не может быть результатом данного испытания. Например, при бросании монеты событие А – “Выпадение какой_либо стороны монеты” будет достоверным, а B – “Одновременное выпа дение “решки” и “орла”” – невозможным.

б) зависимыми или независимыми;

Если появление одного события влечет за собой появление другого, то говорят, что второе событие зависит от первого.

в) равновероятными или неравновероятными;

Например, в случае бросания игральной кости события выпадения каждой цифры равновероятны (если, конечно, это “честная” кость, без смещенного центра тяжести).

А вот вероятности события “В полдень в Москве выпадет снег” будут сильно различаться в зависимости от времени года, соответствующего данному испытанию.

К определению самого понятия вероятности существует несколько различных подходов. Мы рассмотрим лишь те из них, которые необходимы нам для понимания изучаемых квантовых явлений, а именно – классический и статистический подходы.

Вероятность – это отношение числа благоприятных событию исходов m к общему числу всех равновозможных исходов n |

Обычно вероятность обозначают буквой P (от англ. “probability” _ вероятность). Вероятность в данном случае понимается как количественная мера объективной возможности появления случайного события А и определяется формулой:

![]()

В нашем примере событиям выпадения красного, зеленого и желтого шара будут соответствовать вероятности 6/10, 3/10 и 1/10.

Функция вероятности обладает некоторыми специальными свойствами:

1. 0<P<1 , так как количество благоприятных исходов не может быть больше их общего числа.

2. Вероятность достоверного события = 1

3. Вероятность невозможного события = 0

Статистическое определение вероятности

Классическим подходом к вероятности удобно пользоваться,

когда количество всех равновозможных исходов в опыте ограничено и не

слишком велико. Однако эти условия не всегда соблюдаются на практике: иногда

приходится решать задачи, в которых число исходов постоянно меняется или бесконечно велико. Кроме того, не всегда события могут быть равновероятными.

Практика показывает, что массовые случайные явления обладают одним уникальным свойством: с увеличением числа испытаний повышается устойчивость их появления. Например,если повторить опыт бросания монетки 100 раз, то примерно в50% испытаний выпадет “орел”, а в 50% _ “решка”. Если увеличить число испытаний до 1000 раз, это в конце концов приведет к еще большей устойчивости частоты полученных значений, а это уже определенная закономерность.

При статистическом подходе нас интересует не исход отдельно взятогоиспытания, а то, что получается в результате его многократного повторения, то есть в качестве статистической вероятности события принимают частоту появления того или иного события при неограниченном увеличении числа испытаний.

Например, если в результате достаточно большого числа испытаний оказалось, что относительная частота весьма близка к 0.4, то это число можно принять за статистическую вероятность события.

Статистический вероятностный подход используется повсеместно для анализа и прогнозирования событий, процессов,явлений. На его основе построены некоторые научные теории физики, квантовой механики, эволюции, генетики, информатики и др. Вероятностно_статистические методы широко при меняются в промышленности для контроля качества продукции, технической диагностики оборудования, организации массового обслуживания, астрономических наблюдений и т.д.

В рамках статистического подхода вводится понятие плотности распределения вероятности р(х), вид функции которой определяет закон распределения случайных величин. Существуют самые разные законы распределения: равномерное распределение, распределение Пуассона, распределение Бернулли и др., но наиболее распространено в природе так называемое нормальное распределение, илираспределение Гаусса. На рисунке представлен вид функции такого нормального распределения, а смысл его заключается в том, что в результате большого числаиспытаний относительная частота появления какого-то события группируется вокруг некоторого среднего числа, которое и можно принять за значение статистической вероятности.

Рис 39. График функции плотности вероятности при нормальном распределении

Следующий пример наглядно иллюстрирует данный закон распределения: предположим, мы высыпаем мешок гороха на пол, держа его в одном и том же вертикальном положении. В принципе, после этого существуют некоторая вероятность обнаружить горошину в любом месте комнаты, даже в самом дальнем углу. Однако вероятность того, что мы найдем горошину в самом центре образовавшейся на полу “кучки”, гораздо выше. Значение вероятности,соответствующее координате центра кучки, мы и принимаем за статистическую вероятность.

Другой пример: пусть производится серия выстрелов по цели. Если учесть, что стрелки палят не наобум, а прилагают все усилия, чтобы попасть в “яблочко”, то вероятность попадания пули будет возрастать с приближением к центру мишени.

Теория вероятностей позволяет определять вероятность события по известным вероятностям других событий, связанных с этим событием. В этом случае используют теоремы сложения и умножения вероятностей.

1. Теорема умножения вероятностей.

Прежде чем познакомиться с теоремой, введем сопутствующие понятия: зависимые и независимые события. Рассмотрим примеры:

а) Два спортсмена стреляют по мишени. Событие А- попал первый стрелок, вероятность появления этого события Р(А) , В- попал второй стрелок, вероятность Р(В). Появление или не появление события, например, А не повлияет на вероятность появления события В.

б) Бросают два одинаковых кубика. Событие С- выпало 2 очка на первом кубике, вероятность этого события Р(С). Событие Д- 3 очка на втором кубике, вероятность - Р(Д). Появление события Д не повлияет на вероятность появления события С.

В данных примерах описаны независимые события.

![]() Определение:

Определение:

Два события А и В называются независимыми, если появление одного из них не изменяет вероятности появления другого.

Рассмотрим другой пример:

В урне 2 белых и 2 черных шара. Событие А- вынут 1 белый шар, событие В- вынут 1 черный шар.

Вероятность их появления при испытании- из урны наудачу вынут один шар, одинакова и равна 1/2. Рассмотрим событие: первым вынут белый шар, т.е. происходит событие А, его вероятность 1/2, затем возвращается в урну и вторым вынимают черный шар, т.е. происходит событие В. Найдем вероятность события В в такой ситуации : Р(В)=2/4=1/2. Итак, появление события А не изменило появление события В.

Теперь изменим условия: вынутый первым белый шар не будем возвращать в урну, тогда вероятность события В будет равна Р(В)=2/3, сравнивая результаты 1/2 и 2/3 можно сделать вывод, что появление события А изменило вероятность появления события В. Такие события называются зависимыми , а вероятность события В, в данном случае называется условной вероятностью и обозначается РА(В), т.е. вероятность события В при условии, что А произошло.

Определения:

События А и В называются зависимыми, если появление одного из них изменяет вероятность появления другого.

Условной вероятностью РА(В) называется вероятность события В, вычисленная в предположении, что событие А уже произошло.

Теперь познакомимся с теоремами, которые позволяют вычислить вероятность совместного появления двух событий. В первой теореме речь идет о зависимых событиях, во второй- о независимых.

Теорема1: Вероятность произведения двух зависимых событий А и В равна произведению вероятности одного из них на условную вероятность другого, в предположении, что первое уже произошло, т.е. Р(АВ)= Р(А)РА(В).

Доказательство:

Пусть в результате опыта возможны N исходов, из них М благоприятствуют появлению события А, их этихМ- К исходов благоприятствуют событию В. Одновременному появлению событий А и В благоприятствуют L исходов из К.. По классической формуле имеем: Р(АВ)=L/N. Умножим и разделим на М:

![]()

Первая дробь- вероятность наступления события А, вторая- вероятность события В, при условии, что А уже произошло, т.е. условная вероятность события В, что и требовалось доказать.

Теорема2: Вероятность произведения двух независимых событий А и В равна произведению их вероятностей Р(АВ)=Р(А)Р(В).

Доказательство:

Т.к. события независимые, то верно равенство РА(В)=Р(В), тогда получим Р(АВ)=Р(А)Р(В).

Справедлива обратная теорема:

Если для событий А и В выполняется равенство Р(АВ)=Р(А)Р(В), то эти события независимы.

Решим задачи.

Пример1. По мишени стреляют три стрелка. Вероятности попадания соответственно равны 0,7; 0,8 и 0,9. Найти вероятность того, что попадут все три.

Решение:

Пусть событие А- попал 1-й, В- 2-й и С-3-й. Эти события независимые, тогда применяя соответствующую теорему получим, что вероятность совместного появления всех трех событий равна: Р(АВС)=Р(А)Р(В)Р(С)= 0,7·0,8·0,9=0,504.

Пример2. В урне находятся 3 белых, 2 черных и 4 синих шара. Какова вероятность того, что первым будет вынут белый шар, вторым- синий, третьим- черный. Шары не возвращаются.

Решение: Пусть события: А- вынут белый шар, В- вынут синий, С- черный. Вероятность, что первым вынут белый равнаF-тестом или критерием Фишера (F-критерием, φ*-критерием) — называют любой статистический критерий, тестовая статистика которого при выполнении нулевой гипотезы имеет распределение Фишера (F-распределение).

Статистика теста так или иначе сводится к отношению выборочных дисперсий (сумм квадратов, деленных на "степени свободы"). Чтобы статистика имела распределение Фишера необходимо, чтобы числитель и знаменатель были независимыми случайными величинами и соответствующие суммы квадратов имели распределение Хи-квадрат. Для этого требуется, чтобы данные имели нормальное распределение. Кроме того, предполагается, что дисперсия случайных величин, квадраты которых суммируются, одинакова.

Тест

проводится путем сравнения значения

статистики с критическим значением

соответствующего распределения Фишера

при заданном уровне значимости. Известно,

что если ![]() ,

то

,

то ![]() .

Кроме того, квантили распределения

Фишера обладают свойством

.

Кроме того, квантили распределения

Фишера обладают свойством ![]() .

Поэтому обычно на практике в числителе

участвует потенциально большая величина,

в знаменателе - меньшая и сравнение

осуществляется с "правой" квантилью

распределения. Тем не менее тест может

быть и двусторонним и односторонним. В

первом случае при уровне

значимости

.

Поэтому обычно на практике в числителе

участвует потенциально большая величина,

в знаменателе - меньшая и сравнение

осуществляется с "правой" квантилью

распределения. Тем не менее тест может

быть и двусторонним и односторонним. В

первом случае при уровне

значимости ![]() используется

квантиль

используется

квантиль ![]() ,

а при одностороннем тесте

,

а при одностороннем тесте ![]() [1].

[1].

Более

удобный способ проверки гипотез - с

помощью p-значения ![]() -

вероятностью того, что случайная величина

с данным распределением Фишера превысит

данное значение статистики. Если

(для

двустороннего теста -

-

вероятностью того, что случайная величина

с данным распределением Фишера превысит

данное значение статистики. Если

(для

двустороннего теста - ![]() ))

меньше уровня значимости

,

то нулевая гипотеза отвергается, в

противном случае принимается.

))

меньше уровня значимости

,

то нулевая гипотеза отвергается, в

противном случае принимается.

Содержание [убрать]

|

[править]Примеры F-тестов

[править]F-тест на равенство дисперсий

[править]Две выборки

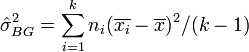

Пусть имеются две выборки объемом m и n соответственно случайных величин X и Y, имеющих нормальное распределение. Необходимо проверить равенство их дисперсий. Статистика теста

![]()

где ![]() - выборочная

дисперсия.

- выборочная

дисперсия.

Если статистика больше критического, то дисперсии не одинаковы, в противном случае дисперсии выборок одинаковы

[править]Несколько выборок

Пусть

выборка объемом N случайной

величины X разделена

на k групп

с количеством наблюдений ![]() в i-ой

группе.

в i-ой

группе.

Межгрупповая

("объясненная") дисперсия:

Внутригрупповая

("необъясненная") дисперсия:

![]()

Данный тест можно свести к тестированию значимости регрессии переменной X на фиктивные переменные-индикаторы групп. Если статистика превышает критическое значение, то гипотеза о равенстве дисперсий в выборках отвергается, в противном случае дисперсии можно считать одинаковыми.