- •3.3 Расширение языка c……………………………………………………….46

- •1.1 Задача Дирихле

- •1.2 Метод простых итераций

- •1.3 Методы Якоби

- •1.4 Методы Зейделя и его модификации

- •2 Параллельные методы решения задачи Дирихле для систем с общей памятью

- •2.1 Использование OpenMp для организации параллелизма

- •2.2 Проблема синхронизации параллельных вычислений

- •2.3 Возможность неоднозначности вычислений в параллельных программах

- •2.4 Исключение неоднозначности вычислений

- •2.5 Волновые схемы параллельных вычислений

- •3 Параллельные вычисления с использованием видеокарты

- •3.1 Общие сведения о gpu и nvidia cuda

- •3.1.1 Разница между cpu и gpu в параллельных расчётах

- •3.1.2 Первые попытки применения расчётов на gpu

- •3.1.3 Возможности nvidia cuda

- •3.1.4 Области применения параллельных расчётов на gpu

- •3.2 Аппаратная и программная реализация cuda

- •3.2.1 Состав nvidia cuda

- •3.2.2 Архитектура gpu

- •3.2.3 Модель программирования cuda: потоковая модель

- •3.2.4 Модель программирования cuda: модель памяти

- •3.3 Расширение языка c

- •3.3.1 Директива вызова ядра

- •3.3.2 Основы cuda host api

- •3.3.3 Работа с памятью в cuda

- •3.3.4 Использование событий для синхронизации на cpu

- •3.3.5 Получение информации об имеющихся gpu и их возможностях

- •3.3.6 Компиляция

- •Http://habrahabr.Ru/blogs/cuda/54707/

2 Параллельные методы решения задачи Дирихле для систем с общей памятью

Как следует из приведенного описания, сеточные методы характеризуются значительной вычислительной трудоемкостью T=kmN2, где N есть количество узлов по каждой из координат области D, m — число операций, выполняемых методом для одного узла сетки, k — количество итераций метода до выполнения условия остановки.

2.1 Использование OpenMp для организации параллелизма

Рассмотрим возможные способы организации параллельных вычислений для сеточных методов на многопроцессорных вычислительных системах с общей памятью. Будем предполагать, что имеющиеся в составе системы процессоры обладают равной производительностью, являются равноправными при доступе к общей памяти и время доступа к памяти является одинаковым.

В последнее время активно развивается подход к разработке параллельных программ, заключающийся в том, что указания программиста по организации параллельных вычислений добавляются в программу при помощи тех или иных внеязыковых средств языка программирования – например, в виде директив или комментариев, которые обрабатываются специальным препроцессором до начала компиляции программы. При этом исходный операторный текст программы остается неизменным, и по нему в случае отсутствия препроцессора компилятор построит исходный последовательный программный код. Препроцессор же, будучи примененным, заменяет директивы параллелизма на некоторый дополнительный программный код (как правило, в виде обращений к процедурам какой-либо параллельной библиотеки).

Рассмотренный выше подход является основой технологии OpenMP, наиболее широко применяемой в настоящее время для организации параллельных вычислений на многопроцессорных системах с общей памятью. А также по этому принципу строится технология CUDA применяемая для организации параллельных вычислений на видеокартах, речь о данной технологии пойдет в следующей главе. В рамках OpenMP директивы параллелизма используются для выделения в программе параллельных областей (parallel regions), в которых последовательный исполняемый код может быть разделен на несколько раздельных командных потоков (threads). Далее эти потоки могут исполняться на разных процессорах вычислительной системы. В результате такого подхода программа представляется в виде набора последовательных (однопотоковых) и параллельных (многопотоковых) участков программного кода (рис. 2). Подобный принцип организации параллелизма получил наименование "вилочного" (fork-join) или пульсирующего параллелизма.

Рис. 2 Параллельные области, создаваемые директивами OpenMP

2.2 Проблема синхронизации параллельных вычислений

Первый вариант параллельного алгоритма для метода сеток может быть получен, если разрешить произвольный порядок пересчета значений uij.

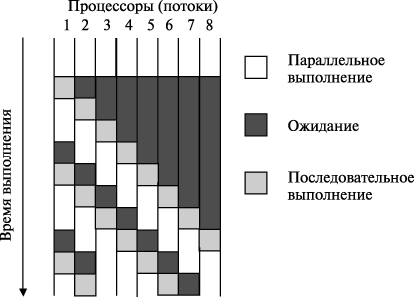

Данный подход обеспечивает достижение практически максимально возможного параллелизма – для выполнения программы может быть задействовано вплоть до N2 процессоров. Тем не менее результат не может быть признан удовлетворительным: программа будет работать медленно и вместо ускорения мы получим замедление вычислений. Основная причина такого положения дел – чрезмерно высокая синхронизация параллельных участков программы. В результате необходимости синхронизации доступа многопотоковая параллельная программа превращается фактически в последовательно выполняемый код, причем менее эффективный, чем исходный последовательный вариант. Т.к. организация синхронизации приводит к дополнительным вычислительным затратам – (рис. 3) Несмотря на идеальное распределение вычислительной нагрузки между процессорами, для приведенного на рис. 3 соотношения параллельных и последовательных вычислений, в каждый текущий момент времени (после момента первой синхронизации) только не более двух процессоров одновременно выполняют действия, связанные с решением задачи. Подобный эффект вырождения параллелизма из-за интенсивной синхронизации параллельных участков программы обычно именуется сериализацией (serialization).

Рис. 3 Пример возможной схемы выполнения параллельных потоков при наличии синхронизации (взаимоисключения)

Путь для достижения эффективности параллельных вычислений лежит в уменьшении необходимых моментов синхронизации параллельных участков программы.

Учитывая выше сказанное можно предложить следующий параллельный вариант решения задачи Дирихле. Можем ограничиться распараллеливанием только одного внешнего цикла for. Снижение количества возможных блокировок применяется многоуровневая схема расчета оценки максимальной погрешности: пусть параллельно выполняемый поток первоначально формирует локальную оценку погрешности dm только для своих обрабатываемых данных (одной или нескольких строк сетки), затем при завершении вычислений поток сравнивает свою оценку dm с общей оценкой погрешности dmax.

Количество обращений к общей переменной dmax уменьшается с N2 до N раз, что должно приводить к существенному снижению затрат на синхронизацию потоков и уменьшению проявления эффекта сериализации вычислений.