- •3.3 Расширение языка c……………………………………………………….46

- •1.1 Задача Дирихле

- •1.2 Метод простых итераций

- •1.3 Методы Якоби

- •1.4 Методы Зейделя и его модификации

- •2 Параллельные методы решения задачи Дирихле для систем с общей памятью

- •2.1 Использование OpenMp для организации параллелизма

- •2.2 Проблема синхронизации параллельных вычислений

- •2.3 Возможность неоднозначности вычислений в параллельных программах

- •2.4 Исключение неоднозначности вычислений

- •2.5 Волновые схемы параллельных вычислений

- •3 Параллельные вычисления с использованием видеокарты

- •3.1 Общие сведения о gpu и nvidia cuda

- •3.1.1 Разница между cpu и gpu в параллельных расчётах

- •3.1.2 Первые попытки применения расчётов на gpu

- •3.1.3 Возможности nvidia cuda

- •3.1.4 Области применения параллельных расчётов на gpu

- •3.2 Аппаратная и программная реализация cuda

- •3.2.1 Состав nvidia cuda

- •3.2.2 Архитектура gpu

- •3.2.3 Модель программирования cuda: потоковая модель

- •3.2.4 Модель программирования cuda: модель памяти

- •3.3 Расширение языка c

- •3.3.1 Директива вызова ядра

- •3.3.2 Основы cuda host api

- •3.3.3 Работа с памятью в cuda

- •3.3.4 Использование событий для синхронизации на cpu

- •3.3.5 Получение информации об имеющихся gpu и их возможностях

- •3.3.6 Компиляция

- •Http://habrahabr.Ru/blogs/cuda/54707/

3.3.5 Получение информации об имеющихся gpu и их возможностях

Перед тем как начать распараллеливание программы необходимо иметь информацию об имеющихся GPU, которые могут быть использованы CUDA, и обо всех возможностях графического процессора. Учет этих данных позволит решить задачу наиболее оптимально и эффективно. В связи с этим расскажем о простом способе получения таких данных, предоставляемый CUDA runtime Информация о возможностях GPU возвращается в виде структуры cudaDeviceProp.

struct cudaDeviceProp

{ char name[256]; - название устройства.

size_t totalGlobalMem; - полный объем глобальной памяти в байтах.

size_t sharedMemPerBlock; - объем разделяемой памяти в блоке в байтах.

int regsPerBlock; - количество 32-битовых регистров в блоке.

int warpSize; - размер варпа.

size_t memPitch; - максимальный pinch в байтах, допустимый функциями копирования памяти, выделенной через cudaMallocPitch

int maxThreadsPerBlock; - максимальное число активных нитей в блоке.

int maxThreadsDim [3]; - максимальный размер блока по каждому измерению.

int maxGridSize [3]; - максимальный размер сетки по каждому измерению.

size_t totalConstMem;- объем константной памяти в байтах.

int major; - Computer Capability, старший номер.

int minor; - Computer Capability, младший номер.

int clockRate; - частота в килогерцах.

size_t textureAlignment; - выравнивание памяти для текстур.

int deviceOverlap; - можно ли осуществлять копирование параллельно с вычислениями.

int multiProcessorCount; - количество мультипроцессоров в GPU. }

Для обозначение возможностей CUDA использует понятие Compute Capability, выражаемое парой чисел - major.minor. Первое число обозначает глобальную архитектурную версию, второе - небольшие изменение. Так как в дальнейшем будем писать программу для видеокарты GeForce 9600 GT, то остановимся на ее возможности. Она имеет Compute Capability равную 1.1, которая поддерживает атомарные операции над 32-битовыми словами в глобальной памяти.

3.3.6 Компиляция

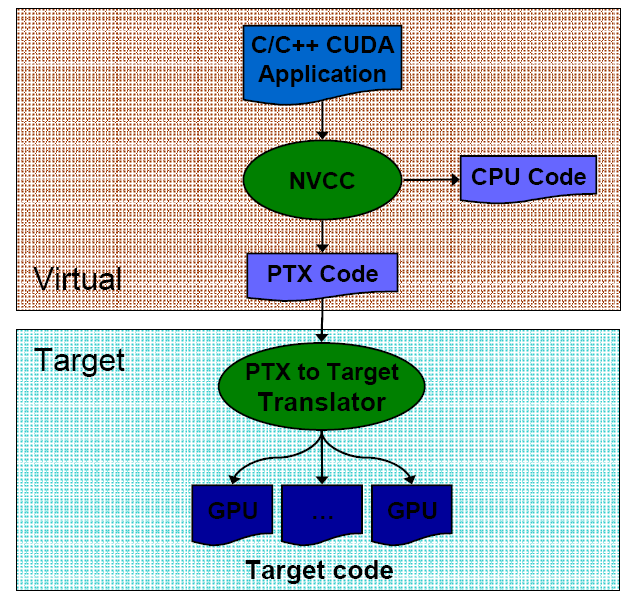

В завершении следует уделить внимание компиляции программы CUDA, которая осуществляется в два этапа. Сначала извлекается код, относящийся к CPU, который передаётся стандартному компилятору NVCC. Код, предназначенный для GPU, сначала преобразовывается в промежуточный язык PTX. Он подобен ассемблеру и позволяет изучать код в поисках потенциальных неэффективных участков. Наконец, последняя фаза заключается в трансляции промежуточного языка в специфические команды GPU и создании двоичного файла.

Рис. 18 Компиляция программы CUDA

Заключение

В данной работе рассмотрены вопросы организации параллельных вычислений для решения эллиптических уравнений. Описаны последовательные методы решения дифференциальных уравнений данного вида на примере задачи Дирихле для уравнения Пуассона. Последовательно разбираются возможные способы распараллеливания сеточных методов на многопроцессорных вычислительных системах с общей памятью. При этом большое внимание уделяется проблемам, возникающим при организации параллельных вычислений, анализу причин появления таких проблем и нахождению путей их преодоления.

Описываются особенности организации параллельных вычислений на видеокартах с использованием технологии CUDA. Для лучшего понимания механизма параллелизации рассматриваются архитектура графического процессора, потоковая модель и модель памяти CUDA. Также подробно разбирается расширения языка С, которые необходимы при написания кода для GPU. Применение технологии CUDA для распараллеливания сеточных методов на видеокарте будет реализовано в дальнейшем.

Список используемых источников