- •2. История развития методов оптимизации в экономике.

- •3. Основные понятия и обозначения в линейном программировании.

- •4. Классификация задач математического программирования.

- •5. Переход от исходной задачи линейного программирования к канонической. Экономический смысл дополнительных переменных.

- •6. Графическое решение задачи линейного программирования с двумя переменными.

- •7 . Возможные варианты графического решения b

- •8. Определения n-мерного пространства.

- •9. Фундаментальная теорема линейного программирования для ограниченной области допустимых решений.

- •10. Алгоритм симпликсного методы в полных таблицах.

- •12. Метод искусственного базиса. М-задача и ее решение.

- •13. Теоремы м-метода. Определение решения основной задачи по решению м-задачи.

- •14. Постановка и правила записи двойственной задачи.

- •15. Экономический смысл двойственной задачи и двойственных оценок.

- •16. Свойства двойственных задач (теоремы двойственности). Графический метод решения двойственной задачи.

- •17. Запись оптимального решения прямой и двойственной задач.

- •18. Анализ оптимального решения с помощью коэффициентов последней симпликсной таблицы и двойственных оценок ограничений.

- •19. Решение задач линейного программирования в приложении ms Excel «Поиск решения».

- •20. Постановка и математическая запись транспортной задачи.

- •21. Методы получения исходного опорного решения в транспортной задаче.

- •22. Метод потенциалов при решении транспортной задачи.

- •23. Открытая транспортная задача и возможность ее решения.

- •24. Блокировки перевозок и ограничения пропускной способности в транспортных задачах. Совместный учет производственных и транспортных затрат.

- •25. Решение транспортной задачи на max целевой функции.

- •26. Задача о «назначениях». Венгерский метод решения задач на минимум.

- •27. Задача о «назначениях». Венгерский метод решения задач на максимум.

- •28. Задача целочисленного программирования и ее решения.

- •29. Алгоритм метода Гомори для решения задач целочисленного программирования.

- •30. Понятие о методе ветвей и границ для решения задачи целочисленного программирования.

- •31. Постановка задачи параметрического программирования.

- •32. Последовательность решения задачи с параметром в целевой функции.

- •33. Описание динамического процесса управления. Примеры экономических задач, представленных в терминах динамического программирования.

- •34. Особенности многошаговых задач, решаемых методом динамического программирования. Принцип оптимальности р. Беллмана.

- •35. Схема решения задачи о распределении средств методом динамического программирования.

- •36. Классификация задач нелинейного программирования. Задачи на безусловный экстремум.

- •38. Общая задача выпуклого программирования. Методы решения задач выпуклого программирования.

- •39. Задача дробно-линейного программирования. Решение задач симплексным методом.

- •Алгоритм решения

- •40. Особенности решения задачи дробно-линейного программирования графическим методом. Возможные варианты графического решения. Асимптотическое решение.

34. Особенности многошаговых задач, решаемых методом динамического программирования. Принцип оптимальности р. Беллмана.

Схема процесса принятия решений:

ч/з x (x1, x2, ... , xn) – обозначаются шаговые управления

S - система: S0 – начальная система, Sn – конечное состояние системы.

Под управлением процессом в целом понимается последовательность шаговых управлений.

Уравнение состояния системы:

Sk = φk (Sk-1; xk).

Sk-1 – предшествующее состояние системы

xk – шаговое управление на k-шаге

φk – некоторая функция.

Целевая функция:

fk – некоторая функция, определяющая критерий эффективности k-шага.

Z – «выигрыш».

Постановка задачи: определить такое допустимое управление x, переводящее систему S из состояния S0 в состояние Sn, при котором целевая функция Z принимает наибольшее/ наименьшее значение.

Принцип Беллмана - вычислительная схема:

Какого бы ни было состояние системы, в результате к.-либо числа шагов, на ближайшем шаге управление надо выбирать так, чтобы оптимальной была сумма выигрышей на всех оставшихся до конца процесса шагах, включая выигрыш на данном шаге.

2 этапа:

1. Этап условной оптимизации (предварительный):

2. Этап безусловной оптимизации:

В основе решения задач динамического программирования лежит принцип оптимальности Беллмана: на каждом этапе принимается такое решение, которое обеспечивает оптимальность с данного этапа до конца процесса, то есть на каждом этапе необходимо принимать решение, просматривая его последствия до самого конца процесса. Так как последовательность решений следует просматривать до самого конца процесса, то варианты анализируют с конца процесса.

Функциональные уравнения Беллмана – это математическая формулировка принципа оптимальности Беллмана. Оптимальное управление обладает следующим свойством: каковы бы ни были начальное состояние S0 и решение в начальный момент времени, последующие решения должны составлять оптимальное управление относительно состояния, полученного в результате предыдущего решения.

35. Схема решения задачи о распределении средств методом динамического программирования.

Оптимальное распределение ресурсов

Пусть имеется некоторое количество ресурсов х, которое необходимо распределить между п различными предприятиями, объектами, работами и т.д. так, чтобы получить максимальную суммарную эффективность от выбранного способа распределения.

Сумма прибыли от k-ого предприятия = общая прибыль. Прибыль не зависит от вложения в другие предприятия.

Число шагов = число предприятий.

Все средства должны быть распределены.

На каждом шаге системы (Sk) определяется количество средств, которые остаются после k-ого шага.

Выигрышем на k-ом шаге является прибыль, которую приносит k-ое предприятие при Xk.

Определяем функциональное уравнение на последнем шаге (сколько средств осталось)

Составляем уравнение Беллмана:

36. Классификация задач нелинейного программирования. Задачи на безусловный экстремум.

Задачи нелинейного программировая:

1. Общая задача нелинейного программирования.

2. Задача выпуклого программирования – задачи min-ции выпуклой вниз гладкой функции/ max-ции выпуклой вверх гладкой функции при ограничениях, заданных нелинейными/ линейными неравенствами, определяющими выпуклое множество.

1) Общая задача выпуклого программирования – целевая функция выпуклая и система ограничений также состоит из выпуклой функции.

2) Специальная задача – выпуклая целевая функция и линейная система ограничений.

3) Задача квадратического программирования – квадратическая целевая функция и линейная система ограничений.

3. Динамическое программирование – задачи, у которых целевая функция обладает свойством аддитивности (т.е. когда она представлена в виде суммы слагаемых функции, зависящих от ограниченного числа переменных/ зависящих только от одной переменной).

Z = f1(x1) + f2(x2) + … + fn(xn)

Оптимизация — это выбор наилучшего варианта из множества возможных. Если критерий выбора известен и вариантов не много, то решение может быть найдено простым перебором и сравнением всех вариантов. Однако часто бывает так, что количество возможных вариантов велико и перебор практически невозможен. Тогда приходится формализовать задачу, составлять ее математическую модель и применять специальные методы поиска наилучшего решения.

Среди

множества оптимизационных задач выделяют

группу классических задач

оптимизации или задач на безусловный

экстремум. Общая постановка этих задач

такова: найти вектор ![]() ,

при котором достигается наибольшее или

наименьшее значение скалярной

непрерывно дифференцируемой функции

,

при котором достигается наибольшее или

наименьшее значение скалярной

непрерывно дифференцируемой функции ![]() :

:

![]() .

.

В основе методов решения классических задач оптимизации лежит теория дифференциального исчисления.

Пусть ![]() —

действительная дважды непрерывно

дифференцируемая функция аргумента

—

действительная дважды непрерывно

дифференцируемая функция аргумента ![]() ,

, ![]() .

Требуется найти наибольшее (или

наименьшее) значение данной функции и

такое значение аргумента

.

Требуется найти наибольшее (или

наименьшее) значение данной функции и

такое значение аргумента ![]() (оптимальное

решение), при котором этот экстремум

достигается.

(оптимальное

решение), при котором этот экстремум

достигается.

Если точка является точкой экстремума функции, то она является стационарной точкой функции, т.е. частные производные в этой точке равны нулю:

![]() ,

, ![]() .

.

Таким образом, экстремумы функции следует искать среди ее стационарных точек. Однако, возможно, не каждая стационарная точка является точкой экстремума.

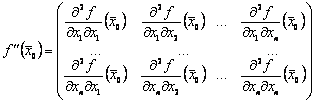

Для решения вопроса о наличии экстремума функции многих переменных в стационарной точке находят значения вторых частных производных в этой точке и из полученных чисел составляют матрицу, называемую матрицей Гессе:

Для того чтобы функция имела в стационарной точке локальный минимум, необходимо и достаточно, чтобы в этой точке все главные диагональные миноры матрицы Гессе были положительны.

Для того чтобы функция имела в стационарной точке локальный максимум, необходимо и достаточно, чтобы у матрицы Гессе главные диагональные миноры нечетных степеней были отрицательны в этой точке, а миноры четных степеней — положительны.