- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

2.1.3. Условная энтропия

Найдем энтропию сложного опыта α ^ β в том случае, если опыты не являются независимыми, т.е. если на исход β оказывает влияние результат опыта α. Например, если в ящике всего два разноцветных шара и α состоит в извлечении первого, а β - второго из них, то а полностью снимает неопределенность сложного опыта α ^ β, т.е. оказывается Н(α ^ β) = H(α), a не сумме энтропии, как следует из (2.5).

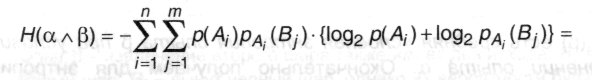

Связь между α и β состоит в том, что какие-то из исходов A(α) могут оказывать влияние на исходы из В(β), т.е. некоторые пары событий Ai ^ Bj не являются независимыми. Но тогда в (2.6) p(Ai ^ Bj) следует заменять не произведением вероятностей, а, согласно (А.14):

![]()

где - рAi (Bj) вероятность наступления исхода В, при условии, что в первом опыте имел место исход Аi.

Тогда

![]()

При подстановке в (2.6) получаем:

![]()

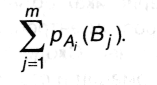

В первом слагаемом индекс j имеется только у B; изменив порядок суммирования, получим члены вида:

Однако,

поскольку

образует достоверное событие (какой-либо из исходов опыта β все равно реализуется). Следовательно, первое слагаемое оказывается равным:

Во втором слагаемом члены вида

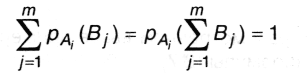

![]()

имеют смысл энтропии опыта β при условии, что в опыте а реализовался исход Аi - будем называть ее условной энтропией. Если ввести данное понятие и использовать его обозначение, то второе слагаемое будет иметь вид:

![]()

где Hα(β) есть средняя условная энтропия опыта β при условии выполнении опыта α. Окончательно получаем для энтропии сложного опыта:

![]()

Полученное выражение представляет собой общее правило нахождения энтропии сложного опыта. Совершенно очевидно, что выражение (2.5) является частным случаем (2.10) при условии независимости опытов α и β.

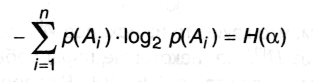

Относительно условной энтропии можно высказать следующие утверждения:

Условная энтропия является величиной неотрицательной. Hα(β) = 0 только в том случае, если любой исход а полностью определяет исход β (как в примере с двумя шарами), т.е.

![]()

В этом случае Н(α ^ β) = Н(α).

Если опыты α и β независимы, то Нα(β) = Н(β), причем это оказывается наибольшим значением условной энтропии. Другими словами, опыт α не может повысить неопределенность опыта β; он может либо не оказать никакого влияния (если опыты независимы), либо понизить энтропию β.

Приведенные утверждения можно объединить одним неравенством:

![]()

т.е. условная энтропия не превосходит безусловную.

Из соотношений (2.10) и (2.11) следует, что

![]()

причем равенство реализуется только в том случае, если опыты α и β независимы.

Пример 2.2

В ящике имеются 2 белых шара и 4 черных. Из ящика извлекают последовательно два шара без возврата. Найти энтропию, связанную с первым и вторым извлечениями, а также энтропию обоих извлечений. Будем считать опытом α извлечение первого шара. Он имеет два исхода: A1 - вынут белый шар; его вероятность р(А1) = 2/6 = 1/3; исход А2 - вынут черный шар; его вероятность р(А2) = 1 - р(А1) = 2/3. Эти данные позволяют с помощью (2.4) сразу найти Н(α):

Н(α) = - р(А1)log2 р(А1) - р(А2)log2 р(А2) = -1/3 log21/3 - 2/3 log22/3 = 0,918 бит.

Опыт β - извлечение второго шара также имеет два исхода: В1 - вынут белый шар; В2 - вынут черный шар, однако их вероятности будут зависеть от того, каким был исход опыта α. В частности:

при A1: рА1(B1) = 1/5 рА1(B2) = 4/5;

при A2: рA2(B1) = 2/5 рA2(B2) = 3/5.

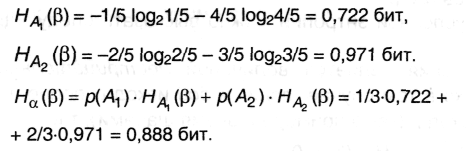

Следовательно, энтропия, связанная со вторым опытом, является условной и, согласно (2.8) и (2.9), равна:

Наконец, из (2.10): Н(α β) = 0,918 + 0,888 =1,806 бит.

Пример 2.3

Имеется три тела с одинаковыми внешними размерами, но с разными массами х1, х2 и х3. Необходимо определить энтропию, связанную с нахождением наиболее тяжелого из них, если сравнивать веса тел можно только попарно.

Последовательность действий достаточно очевидна: сравниваем вес двух любых тел, определяем из них более тяжелое, затем с ним сравниваем вес третьего тела и выбираем наибольший из них. Поскольку внешне тела неразличимы, выбор номеров тел при взвешивании будет случаен, однако общий результат от этого выбора не зависит. Пусть опыт ее состоит в сравнении веса двух тел, например, 1-го и 2-го. Этот опыт, очевидно, может иметь два исхода: А1 – х1 > х2; его вероятность р(А1) = 1/2; исход А2 - x1 < х2; также его вероятность р(А2) = 1/2.

![]()

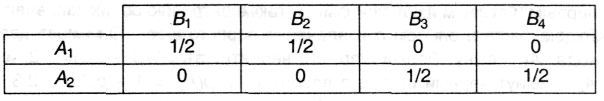

Опыт β - сравнение весов тела, выбранного в опыте α, и 3-го - имеет четыре исхода: B1, - х1 > х3, B2 – х1 < х3, B3 - х2 > х3, В4 - х2 < х3; вероятности исходов зависят от реализовавшегося исхода α - для удобства представим их в виде таблицы:

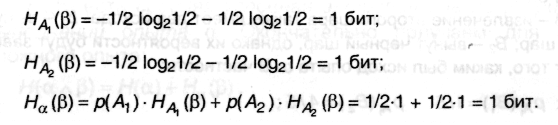

Вновь, воспользовавшись формулами (2.8) и (2.9) и с учетом свойства (1) п.2.1.2, находим:

Следовательно, энтропия сложного опыта, т.е. всей процедуры испытаний:

![]()