- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

2.1.2. Свойства энтропии

1) Как следует из

(2.4), Н = 0

только в двух случаях: (а) какая-либо из

p(Aj)

=

1; однако,

при этом из (А.7) следует, что все остальные

р(Аi)

=

0 (i≠j),

т.е. реализуется ситуация, когда один

из исходов является достоверным

(и общий итог

опыта перестает быть случайным); (b) все

р(Аi)

= 0, т.е. никакие

из рассматриваемых исходов опыта

невозможны, поскольку нетрудно показать,

что

![]() (р ∙

log

р)

= 0 во всех остальных случаях, очевидно,

что Н >

0.

(р ∙

log

р)

= 0 во всех остальных случаях, очевидно,

что Н >

0.

2) Очевидным следствием (2.1) будет утверждение, что для двух независимых опытов α и β

![]()

Энтропия сложного опыта, состоящего из нескольких независимых, равна сумме энтропии отдельных опытов.

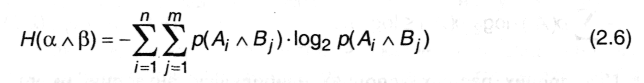

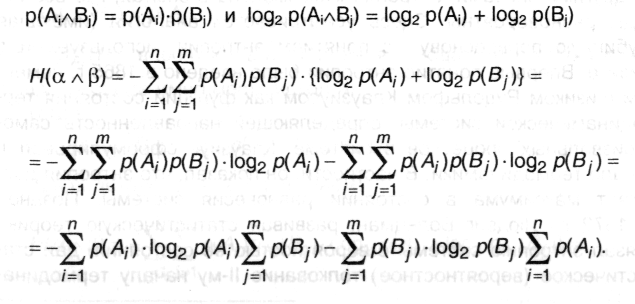

В справедливости (2.5) можно убедиться непосредственно: Пусть опыт α имеет п исходов А1, А2, … Ап, которые реализуются с вероятностями р(А1), р(А2), ... р(Ап), а событие β - т исходов B1, В2, ... Вт с вероятностями р(В1), р(В2), ... р(Вт). Сложный опыт α ^ β имеет п∙т исходов типа AiBj (i = 1... n, j = 1... т). Следовательно:

Поскольку α и β - независимы, то независимыми окажутся события в любой паре Ai ^ Bj. Тогда, согласно (А.9),

В слагаемых произведено изменение порядка суммирования в соответствии со значениями индексов. Далее, по условию нормировки (А.7):

а из (2.4)

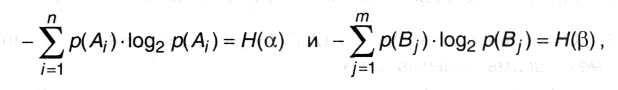

окончательно имеем:

![]()

что и требовалось доказать.

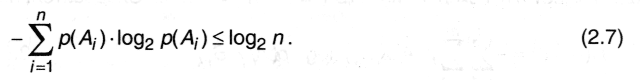

Теперь рассмотрим ситуацию, когда имеются два опыта с одинаковым числом исходов п, но в одном случае они равновероятны, а в другом - нет. Каково соотношение энтропии опытов? Примем без доказательства* следующее утверждение:

* При необходимости доказательство можно найти, например, в книгах: А.М. и И.М. Яглом [49, с.73-75]; Л. Бриллюэн [7, с.34-36].

При прочих равных условиях наибольшую энтропию имеет опыт с равновероятными исходами.

Другими словами, энтропия максимальна в опытах, где все исходы равновероятны. Здесь усматривается аналогия (имеющая глубинную первооснову!) с понятием энтропии, используемой в физике. Впервые понятие энтропии было введено в 1865 г. немецким физиком Рудольфом Клаузиусом как функции состояния термодинамической системы, определяющей направленность самопроизвольных процессов в системе. Клаузиус сформулировал II начало термодинамики. В частности, он показал, что энтропия достигает максимума в состоянии равновесия системы. Позднее (в 1872 г.) Людвиг Больцман, развивая статистическую теорию, связал энтропию системы с вероятностью ее состояния, дал статистическое (вероятностное) толкование II-му началу термодинамики и, в частности, показал, что вероятность максимальна у полностью разупорядоченной (равновесной) системы, причем, энтропия и термодинамическая вероятность оказались связанными логарифмической зависимостью. Другими словами, в физике энтропия оказывается мерой беспорядка в системе. При этом беспорядок понимается как отсутствие знания о характеристиках объекта (например, координат и скорости молекулы); с ростом энтропии уменьшается порядок в системе, т.е. наши знания о ней. Сходство понятий и соотношений между ними в теории информации и статистической термодинамике, как оказалось позднее, совершенно не случайно*.

* Подробнее об этом можно причитать в книгах Л.Бриллюэна [7] и Р.Л.Стратоновича [39].

Кстати, результат, полученный в рассмотренном выше примере 2.1, иллюстрирует справедливость формулы (2.7).