- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

A.3. Условная вероятность

Попробуем построить обобщенную формулу для вероятности суммарного события (А.5) на ситуацию, когда отдельные события А и В могут оказаться совместными, т.е. произойти одновременно. В этом случае p(A v B) ≠ p(A) + p(B). Действительно: пусть по-прежнему событие А выполняется при т1 из п равновероятных исходов опыта, а событие В - при m2 из тех же п возможных исходов. Однако из-за того, что возможно совместное наступление А и В, исходы m1 и т2 окажутся не полностью различными, т.е. среди них могут быть одни и те же. Тогда суммарное количество благоприятных исходов т ≤ т1 + т2 и, следовательно, p(A v B) ≤ р(А) + р(В).

Пусть среди т1 и т2 имеются т' общих исходов; очевидно, это те случаи, когда А и В наступают одновременно. Следовательно, вероятность совместного события

![]()

а общее количество различных благоприятных исходов оказывается равным т = т1 + т2 - т'. Тогда вероятность

![]()

Окончательно:

![]()

Таким образом, при определении вероятности суммы двух событий (A v B) в общем случае требуется находить и вероятность их произведения (А ^ В). Это несложно сделать, если события А и В независимы - в этом случае можно воспользоваться формулой (А.9), подстановка которой в (А. 12) дает:

![]()

Легко видеть, что (А.5) оказывается частным случаем (А. 12) при условии несовместности А и B - тогда р(А ^ В) = 0.

Пример А.5

Какова вероятность вынуть козыря или туза из колоды 36 карт, если козырной объявлена одна из мастей?

Событие А - получение козыря - имеет вероятность р(А) = 9/36 = 1/4, поскольку карт одной масти 9. Событие B - получение туза - имеет вероятность р(В) = 4/36 = 1/9, поскольку тузов 4; однако из них один - козырный (т.е. реализуются и А и B); вероятность его появления р(А ^ В) = р(A) ∙ р(B) = 1/36. Тогда, согласно (А.13), р(А ^ В) = р(А) + р(В) - р(A) ∙ р(В) = 1/4 + 1/9 - 1/36 = 12/36 = 1/3

Теперь при нахождении вероятности произведения событий р(A ^ B) попробуем учесть то обстоятельство, что события А и В не обязательно могут быть независимыми - очевидно, это наиболее общий случай. Отсутствие независимости случайных событий означает, что одно из них оказывает влияние на другое, т.е. вероятность второго события зависит от того, произошло ли первое. Например, вы случайно встретили знакомого на вечеринке (событие В); однако решение пойти на эту вечеринку (событие А) вы приняли случайно, выбирая из нескольких возможностей; таким образом, случайное событие В оказывается следствием случайного события А.

Вероятность события В при условии, что влияющее на него событие А имело место, называется условной вероятностью.

Обозначать условную вероятность будем рА(В). Объективности ради следует заметить, что вероятность любого случайного события зависит от каких-то условий, при которых возможно его наступление или ненаступление. Например, условием того, что вероятность выпадения всех цифр игральной кости одинакова и равна 1/6, является ее правильная геометрическая форма и однородность материала. Если условия изменятся (например, форма будет не куб, а параллелепипед), то изменится и вероятность. Просто условились считать вероятность событий, для которых условия не изменяются в различных сериях опытов, безусловной; если же условия могут изменяться - используется термин «условная вероятность». Достаточно очевидным представляется также утверждение: если А и B независимы, то рA(В) = р(В). Более того, данное утверждение можно считать математически точным определением понятия «независимые события»;

Два случайных события А и В являются независимыми, если их условные вероятности равны безусловным, т.е. рА(В) = р(В) и рВ(А) = р(А).

Пусть из п равновероятных исходов событие А реализуется т способами, из которых k являются благоприятными и для наступления события В, связанного с А. Тогда, очевидно:

![]()

Вероятность совместного выполнения событий А ^ В равна

![]()

Но

![]()

Окончательно имеем:

![]()

Полученное выражения является наиболее общим правилом умножения вероятностей; выражение (А.9), очевидно, оказывается частным случаем (А.14) при условии, что А и B независимы. Подстановка полученного выражения в формулу (А.12) позволяет получить общее правило сложения вероятностей:

![]()

Перечислим (без доказательства) некоторые свойства условной вероятности:

1) условная вероятность рA(iB) может быть как больше безусловной р(В), так и меньше ее (т.е. событие А может как понижать вероятность В, так и повышать ее); однако, всегда 0 ≤ РA(B) ≤ 1. Для ситуации, когда А с необходимостью влечет за собой В (например, А - выпадение четверки при бросании игральной кости, а B - выпадение четной цифры) будем использовать обозначение «» (А B - читается «A влечет B»). Очевидно, если А B, то рA(B) = 1. Если А и B несовместны, рА(В) = 0;

2) если B B', то рА(В) ≤ рA(B');

3) для дополнительных событий рA(В) = 1 – pA(B);

4) если B и С несовместны, то pA(B v С) = рА(В) + рА(С).

Пример А.6*

* Примеры А.6 и А.7 взяты из книги А.М Яглома. и И.М. Яглома [49.С.44-45]

Имеется три урны, содержащие белые и черные шары, причем, в первой урне 2 белых и 4 черных шара, во второй - 3 белых и 3 черных, в третьей - 4 белых и 2 черных. Из одной из урн (неизвестно из какой) наугад вынут шар. Какова вероятность того, что шар оказался белым при условии, что он вынут из первой урны?

Пусть событие А - вытаскивание белого шара, а B - то, что он вынут из первой урны. Из всех имеющихся шаров событию А благоприятствует 9; из которых лишь 2 благоприятствуют событию B. Таким образом рА(В) = 2/9.

Пример А.7

На карточках отдельными буквами написано слово «ПАПАХА». Карточки переворачивают, перемешивают и случайным образом открывают подряд 4 из них. Какова вероятность получить таким путем слово «ПАПА»?

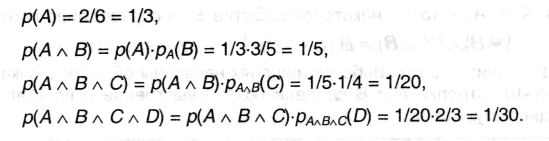

Пусть событие А - извлечение первой «П», событие В - извлечение второй «А», С - третьей «П» и D-четвертой «А». Тогда интересующее событие можно записать как A^В^С^D; его вероятность можно найти, применяя несколько раз формулу (А.14):