- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

А.2. Сложение и умножение вероятностей

Сложение вероятностей независимых, несовместных событий

Пусть среди возможных равновероятных исходов благоприятными оказывается любое из событий А или B, причем А и В - независимы (т.е. между ними отсутствуют причинно-следственные связи - А не влияет на B и наоборот) и несовместны (т.е. они не могут наступить одновременно, а наступает лишь одно из них). Путь из общего числа равновероятных исходов п событие А осуществляется т1 числом способов, а событие В - т2. Тогда

![]()

Спрашивается, как найти вероятность события С = (А или В)*? С называют также суммой событий A и В. Очевидно, общее число способов, которым может реализоваться С равно m1 + т2. Следовательно,

![]()

* Используя формализм математической логики, можно записать С = A v B.

Вероятность какого-либо одного из двух исходов независимых и несовместных событий равна сумме их вероятностей

![]()

Например, какова вероятность вынуть красный или зеленый шар в рассмотренном выше примере? р(А)= 5/10, р(В) = 3/10, следовательно, р(А v B) = 8/10.

Формулу (А.5) легко обобщить на произвольное число благоприятных исходов. Пусть из п несовместных событий k являются благоприятными исходами, причем, вероятности каждого составляют р1, р2,..., pk. Тогда вероятность наступления любого (хотя бы одного) из благоприятных событий будет равна

![]()

Из соотношения (А.6) условия нормировки вероятностей (А.2) легко вывести два следствия:

Следствие 1. Если общее количество всех возможных исходов равно п с вероятностями p1,..., рn, то

![]()

поскольку появление хоть какого-то из исходов достоверно. Это выражение можно считать обобщением условия нормировки.

Следствие 2. Если возможных исходов всего два (А или B), то наступление одного означает не наступление второго. Поэтому любой из них является противоположным другому (записывается В = ; читается «не А»). Поскольку р(А) + р(В) = 1, то р(B) = 1 - р(А) или

![]()

Например, если определили ранее (пример А.2), что вероятность вытащить красный или зеленый шар составляет 8/10, то это означает, что вероятность не вытащить любой из них будет равняться 1 - 8/10 = 2/10.

Умножение вероятностей независимых совместных событий Пусть событие А реализуется т1 способами из п1 равновероятных исходов одного опыта, а событие В - т2 способами из п2 равновероятных исходов другого опыта, независимого от первого. Спрашивается, какова вероятность одновременного наступления обоих событий (или сложного события С, состоящего в наступлении и А и B)? То есть хотим определить вероятность совместного события С = (А и B)*. Часто С называют произведением событий А и B. Поскольку каждому из п1 исходов первого опыта соответствует п2 исходов второго, то общее количество возможных равновероятных исходов, очевидно, становится равным п1∙п2. Из них благоприятными окажутся т1∙т2 исходов. Следовательно, вероятность совместного события оказывается равной:

![]()

* Используя формализм математической логики можно записать С = А ^ B.

Вероятность одновременного наступления двух благоприятных исходов независимых событий равна произведению их вероятностей

![]()

Пример А.3

Какова вероятность выбросить 2 раза подряд по 6 очков в двух бросках кубика (или, что эквивалентно, при однократном броске двух кубиков)? Поскольку р(А) = р(В) = 1/6, то р = 1/6 ∙ 1/6 = 1/36.

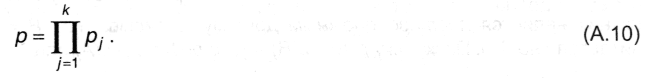

Как и в случае сложения вероятностей, формула (А.9) может быть обобщена на произвольное число совместных благоприятных событий в k независимых опытах. Если вероятности их наступления в каждом из опытов р1, p2,..., pk, то вероятность совместного события будет равна:

Следствие 3. Поскольку рj ≤ 1, очевидно, что р ≤ pj, т.е. вероятность совместного события не может превышать вероятность любого из них.

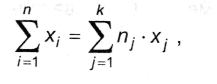

Следствие 4. Нахождение среднего для значений случайных независимых величин. Рассмотрим частную ситуацию, когда случайным событием является числовое значение некоторой величины. Например, число, указанное на грани кубика; сумма выигрыша в лотерею; номер этажа, на котором живет человек, масса атома химического элемента и т.п. Пусть этих значений п и они образуют дискретный ряд x1, х2, ..., xn. Среди этих значений могут оказаться одинаковые. Пусть таких групп одинаковых значений k. Очевидно, k ≤ п. Попробуем найти ответ на вопрос: каково среднее значение величины х? Например, сколько в среднем очков выпадает при одном броске кубика? Будем исходить из определения среднего значения:

![]()

Однако эта же сумма может быть получена, если провести суммирование по группам одинаковых значений:

где nj - количество значений в группе j. Тогда

![]()

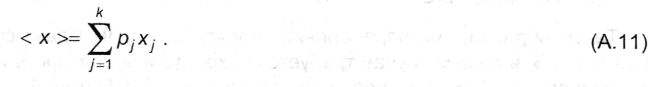

поскольку отношение пj/п есть ни что иное, как относительная частота появления результата из группы j, которая в пределе (при п→) превращается в вероятность рj. Таким образом, окончательно получаем, что

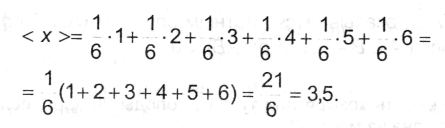

Пример А.4

Найти среднее количество очков, выпадающее при однократном броске игральной кости. Поскольку все рj = 1/6, а значения xj = 1, 2.....6, согласно (А.1).

Величина, определяемая соотношением (А.11), называется взвешенным средним для выборки х1; х2, ..., xk.