- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

Контрольные вопросы и задания

Приведите примеры терминов, имеющих несколько трактовок в различных науках, технике, быту.

Приведите примеры процессов, используемых для передачи информации, и связанных с ними сигналов кроме указанных в тексте.

Приведите примеры неоднозначного и однозначного соответствия между сообщением и содержащейся в нем информацией.

Почему хранение информации нельзя считать информационным процессом?

В чем состоит различие понятий «приемник сообщения» и «приемник информации»?

Органы чувств человека ориентированы на восприятие аналоговой информации. Означает ли это, что человек не может воспринимать информацию дискретную?

Приведите примеры знаков-символов. Могут ли символы образовывать алфавит?

В шестнадцатиричной системе счисления используются цифры А, В, С, D, Е и F. Следует ли эти знаки считать символами?

В тексте данной главы разграничиваются понятия «знак», «буква», «символ». Как соотносится с ними понятие «цифра»?

В чем состоит смысл и значение теоремы отсчетов?

Какое количество отсчетов за 1 с необходимо производить цифровому звукозаписывающему устройству, если требуется обеспечить качество записи (а) телефона; (b) лазерного диска.

Как следует понимать термины «оцифровка изображения» и «оцифровка звука»? Какими устройствами производятся данные операции?

Приведите примеры преобразований типа D1 → D2, при которых информация, содержащаяся в исходном сообщении, может не сохраняться.

Почему для представления дискретных сообщений в качестве базового выбирается двоичный алфавит?

Почему компьютер является универсальным устройством по обработке информации?

В чем состоит и как проявляется несимметричность непрерывной и дискретной форм представления информации?

Глава 2. Понятие информации в теории Шеннона

Материал данной главы опирается на понятия и соотношения теории вероятностей. Для тех, кто не знаком с этой теорией, необходимые ее элементы изложены в приложении А. Текст главы содержит ссылки на некоторые формулы из этого приложения - они в качестве первого индекса имеют букву «А».

2.1. Понятие энтропии

2.1.1. Энтропия как мера неопределенности

Случайные события могут быть описаны с использованием понятия «вероятность» (см. приложение А). Соотношения теории вероятностей позволяют найти (вычислить) вероятности как одиночных случайных событий, так и сложных опытов, объединяющих несколько независимых или связанных между собой событий. Однако описать случайные события можно не только в терминах вероятностей.

То, что событие случайно, означает отсутствие полной уверенности в его наступлении, что, в свою очередь, создает неопределенность в исходах опытов, связанных с данным событием. Безусловно, степень неопределенности различна для разных ситуаций. Например, если опыт состоит в определении возраста случайно выбранного студента 1-го курса дневного отделения вуза, то с большой долей уверенности можно утверждать, что он окажется менее 30 лет; хотя по положению на дневном отделении могут обучаться лица в возрасте до 35 лет, чаще всего очно учатся выпускники школ ближайших нескольких выпусков. Гораздо меньшую определенность имеет аналогичный опыт, если проверяется, будет ли возраст произвольно выбранного студента меньше 18 лет. Для практики важно иметь возможность произвести численную оценку неопределенности разных опытов. Попробуем ввести такую количественную меру неопределенности.

Начнем с простой ситуации, когда опыт имеет п равновероятных исходов. Очевидно, что неопределенность каждого из них зависит от n, т.е. мера неопределенности является функцией числа исходов f(n).

Можно указать некоторые свойства этой функции:

f(1) = 0, поскольку при п = 1 исход опыта не является случайным и, следовательно, неопределенность отсутствует;

f(n) возрастает с ростом п, поскольку чем больше число возможных исходов, тем более затруднительным становится предсказание результата опыта.

Для определения явного вида функции f(n) рассмотрим два независимых опыта α и β* с количествами равновероятных исходов, соответственно пα и пβ. Пусть имеет место сложный опыт, который состоит в одновременном выполнении опытов α и β; число возможных его исходов равно пα ∙ пβ, причем, все они равновероятны. Очевидно, неопределенность исхода такого сложного опыта α ^ β будет больше неопределенности опыта α, поскольку к ней добавляется неопределенность β; мера неопределенности сложного опыта равна f(nα ∙ nβ). С другой стороны, меры неопределенности отдельных α и β составляют, соответственно, f(nα) и f(nβ). В первом случае (сложный опыт) проявляется общая (суммарная) неопределенность совместных событий, во втором - неопределенность каждого из событий в отдельности. Однако из независимости α и β следует, что в сложном опыте они никак не могут повлиять друг на друга и, в частности, α не может оказать воздействия на неопределенность β, и наоборот. Следовательно, мера суммарной неопределенности должна быть равна сумме мер неопределенности каждого из опытов, т.е. мера неопределенности аддитивна:

![]()

* Для обозначения опытов со случайными исходами будем использовать греческие буквы (α, β и т.д.), а для обозначения отдельных исходов опытов (событий) - латинские заглавные (А, В и т.д.).

Теперь задумаемся о том, каким может быть явный вид функции f(n), чтобы он удовлетворял свойствам (1) и (2) и соотношению (2.1)? Легко увидеть, что такому набору свойств удовлетворяет функция log(n), причем можно доказать, что она единственная из всех существующих классов функций. Таким образом:

за меру неопределенности опыта с п равновероятными исходами можно принять число log(n).

Следует заметить, что выбор основания логарифма в данном случае значения не имеет, поскольку в силу известной формулы преобразования логарифма от одного основания к другому.

![]()

переход к другому основанию состоит во введении одинакового для обеих частей выражения (2.1) постоянного множителя logb а, что равносильно изменению масштаба (т.е. размера единицы) измерения неопределенности. Поскольку это так, имеется возможность выбрать удобное (из каких-то дополнительных соображений) основание логарифма. Таким удобным основанием оказывается 2, поскольку в этом случае за единицу измерения принимается неопределенность, содержащаяся в опыте, имеющем лишь два равновероятных исхода, которые можно обозначить, например, ИСТИНА (True) и ЛОЖЬ (False) и использовать для анализа таких событий аппарат математической логики.

Единица измерения неопределенности при двух возможных равновероятных исходах опыта называется бит*.

* Название бит происходит от английского binary digit, что в дословном переводе означает «двоичный разряд» или «двоичная единица».

Таким образом, нами установлен явный вид функции, описывающей меру неопределенности опыта, имеющего п равновероятных исходов:

![]()

Эта величина получила название энтропия. В дальнейшем будем обозначать ее Н.

Вновь рассмотрим опыт с п равновероятными исходами. Поскольку каждый исход случаен, он вносит свой вклад в неопределенность всего опыта, но так как все п исходов равнозначны, разумно допустить, что и их неопределенности одинаковы. Из свойства аддитивности неопределенности, а также того, что согласно (2.2) общая неопределенность равна log2 п, следует, что неопределенность, вносимая одним исходом составляет

![]()

где р = - вероятность любого из отдельных исходов.

Таким образом, неопределенность, вносимая каждым из равновероятных исходов, равна:

![]()

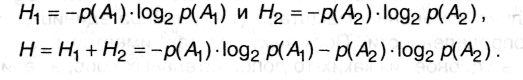

Теперь попробуем обобщить формулу (2.3) на ситуацию, когда исходы опытов неравновероятны, например, р(А1) и р(А2). Тогда:

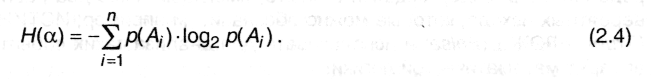

Обобщая это выражение на ситуацию, когда опыт α имеет п неравновероятных исходов А1, А2... Ап, получим:

Введенная таким образом величина, как уже было сказано, называется энтропией опыта ос. Используя формулу для среднего значения дискретных случайных величин (А.11), можно записать:

![]()

А(α) - обозначает исходы, возможные в опыте α.

Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна средней неопределенности всех возможных его исходов.

Для практики формула (2.4) важна тем, что позволяет сравнить неопределенности различных опытов со случайными исходами.

Пример 2.1

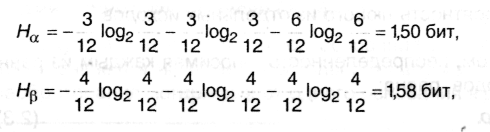

Имеются два ящика, в каждом из которых по 12 шаров. В первом -3 белых, 3 черных и 6 красных; во втором - каждого цвета по 4. Опыты состоят в вытаскивании по одному шару из каждого ящика. Что можно сказать относительно неопределенностей исходов этих опытов?

Согласно (2.4) находим энтропии обоих опытов:

Нβ > Нα, т.е. неопределенность результата в опыте β выше и, следовательно, предсказать его можно с меньшей долей уверенности, чем результат α.