- •160001, Г. Вологда, ул. Челюскинцев, 3.

- •Предисловие

- •Введение

- •Раздел 1. Теория информации

- •Глава 1. Исходные понятия информатики

- •1.1. Начальные определения

- •1.2. Формы представления информации

- •1.3. Преобразование сообщений

- •Контрольные вопросы и задания

- •Глава 2. Понятие информации в теории Шеннона

- •2.1. Понятие энтропии

- •2.1.1. Энтропия как мера неопределенности

- •2.1.2. Свойства энтропии

- •2.1.3. Условная энтропия

- •2.2. Энтропия и информация

- •2.3. Информация и алфавит

- •Контрольные вопросы и задания

- •Глава 3. Кодирование символьной информации

- •3.1. Постановка задачи кодирования, Первая теорема Шеннона

- •3.2. Способы построения двоичных кодов

- •3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- •3.2.2. Равномерное алфавитное двоичное кодирование. Байтовый код

- •3.2.3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •3.2.4. Блочное двоичное кодирование

- •Контрольные вопросы и задания

- •Глава 4. Представление и обработка чисел в компьютере

- •4.1. Системы счисления

- •4.2. Представление чисел в различных системах счисления

- •4.2.1. Перевод целых чисел из одной системы счисления в другую

- •4.2.2. Перевод дробных чисел из одной системы счисления в другую

- •4.2.3. Понятие экономичности системы счисления

- •4.2.4. Перевод чисел между системами счисления 2 ↔ 8 ↔ 16

- •4.2.5. Преобразование нормализованных чисел

- •4.3. Кодирование чисел в компьютере и действия над ними

- •4.3.1. Кодирование и обработка в компьютере целых чисел без знака

- •4.3.2. Кодирование и обработка в компьютере целых чисел со знаком

- •4.3.3. Кодирование и обработка в компьютере вещественных чисел

- •Контрольные вопросы и задания

- •Глава 5. Передача информации

- •5.1. Общая схема передачи информации в линии связи

- •5.2. Характеристики канала связи

- •5.3. Влияние шумов на пропускную способность канала

- •5.4. Обеспечение надежности передачи и хранения информации

- •5.4.1. Постановка задачи

- •5.4.2. Коды, обнаруживающие ошибку

- •5.4.3. Коды, исправляющие одиночную ошибку

- •5.5. Способы передачи информации в компьютерных линиях связи

- •5.5.1. Канал параллельной передачи

- •5.5.2. Последовательная передача данных

- •5.5.3. Связь компьютеров по телефонным линиям

- •Контрольные вопросы и задания

- •Глава 6. Хранение информации

- •6.1. Классификация данных. Проблемы представления данных

- •6.2. Представление элементарных данных в озу

- •6.3. Структуры данных и их представление в озу

- •6.3.1. Классификация и примеры структур данных

- •6.3.2. Понятие логической записи

- •6.3.3. Организация структур данных в озу

- •6.4. Представление данных на внешних носителях

- •6.4.1. Иерархия структур данных на внешних носителях

- •6.4.2. Особенности устройств хранения информации

- •Контрольные вопросы и задания

- •Раздел 2. Алгоритмы. Модели. Системы

- •Глава 7. Элементы теории алгоритмов

- •7.1. Нестрогое определение алгоритма

- •7.2. Рекурсивные функции

- •7.3. Алгоритм как абстрактная машина

- •7.3.1. Общие подходы

- •7.3.2. Алгоритмическая машина Поста

- •7.3.3. Алгоритмическая машина Тьюринга

- •7.4. Нормальные алгоритмы Маркова

- •7.5. Сопоставление алгоритмических моделей

- •7.6. Проблема алгоритмической разрешимости

- •7.7. Сложность алгоритма

- •Контрольные вопросы и задания

- •Глава 8. Формализация представления алгоритмов

- •8.1. Формальные языки

- •8.1.1. Формальная грамматика

- •8.1.2. Способы описания формальных языков

- •8.2. Способы представления алгоритмов

- •8.2.1. Исполнитель алгоритма

- •8.2.2. Строчная словесная запись алгоритма

- •8.2.3. Графическая форма записи

- •8.2.4. Классификация способов представления алгоритмов

- •8.3. Структурная теорема

- •Контрольные вопросы и задания

- •Глава 9. Представление о конечном автомате

- •9.1. Общие подходы к описанию устройств, предназначенных для обработки дискретной информации

- •9.2. Дискретные устройства без памяти

- •9.3. Конечные автоматы

- •9.3.1. Способы задания конечного автомата

- •9.3.2. Схемы из логических элементов и задержек

- •9.3.3. Эквивалентные автоматы

- •Контрольные вопросы и задания

- •Глава 10. Модели и системы

- •10.1. Понятие модели

- •10.1.1. Общая идея моделирования

- •10.1.2. Классификация моделей

- •Модели структурные и функциональные

- •Модели натурные и информационные

- •Модели проверяемые и непроверяемые

- •Модели по назначению

- •10.1.3. Понятие математической модели

- •10.2. Понятие системы

- •10.2.1. Определение объекта

- •10.2.2. Определение системы

- •10.2.3. Формальная система

- •10.2.4. Значение формализации

- •10.3. Этапы решения задачи посредством компьютера

- •10.4. Об объектном подходе в прикладной информатике

- •Контрольные вопросы и задания

- •Заключение

- •Приложение а. Элементы теории вероятностей

- •А.1. Понятие вероятности

- •А.2. Сложение и умножение вероятностей

- •A.3. Условная вероятность

- •Контрольные вопросы и задания

- •Приложение б. Некоторые соотношения логики

- •Глоссарий

- •Список литературы

- •Содержание

- •Глава 4. Представление и обработка чисел в компьютере 45

- •Глава 5. Передача информации 69

- •Глава 6. Хранение информации 83

- •Раздел 2. Алгоритмы. Модели. Системы 98

- •Глава 7. Элементы теории алгоритмов 99

- •Глава 8. Формализация представления алгоритмов 120

- •Глава 9. Представление о конечном автомате 134

- •Глава 10. Модели и системы 147

2.2. Энтропия и информация

Поучительность только что рассмотренного примера в том, что из него отчетливо видно как предшествующий опыт (α) может уменьшить количество исходов и, следовательно, неопределенность последующего опыта (β). Разность H(β) и Нα(β), очевидно, показывает, какие новые сведения относительно β получаем, произведя опыт α. Эта величина называется информацией относительно опыта β, содержащейся в опыте α.

![]()

Данное выражение открывает возможность численного измерения количества информации, поскольку оценивать энтропию уже умеем. Из него легко получить ряд следствий:

Следствие 1. Поскольку единицей измерения энтропии является бит, то в этих же единицах может быть измерено количество информации.

Следствие 2. Пусть опыт α = β, т.е. просто произведен опыт β. Поскольку он несет полную информацию о себе самом, неопределенность его исхода полностью снимается, т.е. Нβ(β) = 0. Тогда /(β, β) = Н(β), т.е. можно считать, что

энтропия равна информации относительно опыта, которая содержится в нем самом.

Можно построить уточнение:

энтропия опыта равна той информации, которую получаем в результате его осуществления.

Отметим ряд свойств информации:

/(α, β) ≥ 0, причем /(α, β) = 0 тогда и только тогда, когда опыты α и β независимы. Это свойство непосредственно вытекает из (2.10) и (2.13).

/(α, β) = /(β, α), т.е. информация симметрична относительно последовательности опытов.

Следствие 2 и представление энтропии в виде (2.4) позволяют записать:

![]()

т.е. информация опыта равна среднему значению количества информации, содержащейся в каком-либо одном его исходе. Рассмотрим ряд примеров применения формулы (2.14).

Пример 2.4

Какое количество информации требуется, чтобы узнать исход броска монеты?

В данном случае п = 2 и события равновероятны, т.е. p1 = р2 = 0,5. Согласно (2.14):

/ = - 0,5 ∙ log2 0,5 - 0,5 ∙ log2 0,5 = 1 бит.

Пример 2.5

Игра «Угадай-ка—4». Некто задумал целое число в интервале от 0 до 3. Наш опыт состоит в угадывании этого числа. На наши вопросы Некто может отвечать лишь «Да» или «Нет». Какое количество информации должны получить, чтобы узнать задуманное число, т.е. полностью снять начальную неопределенность? Как правильно построить процесс угадывания?

Исходами в данном случае являются: А1 - «задуман 0», А2 - «задумана 1», А3 - «задумана 2», A4 - «задумана 3». Конечно, предполагается, что вероятности быть задуманными у всех чисел одинаковы. Поскольку n = 4, следовательно, p(Ai) = 1/4, log2 р(Аi) = -2 и / = 2 бит. Таким образом, для полного снятия неопределенности опыта (угадывания задуманного числа) нам необходимо 2 бит информации.

Теперь выясним, какие вопросы необходимо задать, чтобы процесс угадывания был оптимальным, т.е. содержал минимальное их число. Здесь удобно воспользоваться так называемым выборочным каскадом:

Таким образом, для решения задачи оказалось достаточно 2-х вопросов независимо от того, какое число было задумано. Совпадение между количеством информации и числом вопросов с бинарными ответами неслучайно.

Количество информации численно равно числу вопросов с равновероятными бинарными вариантами ответов, которые необходимо задать, чтобы полностью снять неопределенность задачи.

В рассмотренном примере два полученных ответа в выборочном каскаде полностью сняли начальную неопределенность. Подобная процедура позволяет определить количество информации в любой задаче, интерпретация которой может быть сведена к парному выбору. Например, определение символа некоторого алфавита, использованного для представления сообщения. Приведенное утверждение перестает быть справедливым в том случае, если каждый из двух возможных ответов имеет разную вероятность – такая ситуация будет рассмотрена позднее.

Легко получить следствие формулы (2.14) для случая, когда все п исходов равновероятны (собственно, именно такие и рассматривались в примерах 2.4 и 2.5). В этом случае все

![]()

и, следовательно,

![]()

Эта формула была выведена в 1928 г. американским инженером Р. Хартли и носит его имя. Она связывает количество равновероятных состояний (п) и количество информации в сообщении (/), что любое из этих состояний реализовалось. Ее смысл в том, что, если некоторое множество содержит п элементов и х принадлежит данному множеству, то для его выделения (однозначной идентификации) среди прочих требуется количество информации, равное log2 п.

Частным случаем применения формулы (2.15) является ситуация, когда п = 2k; подставляя это значение в (2.15), очевидно, получим:

![]()

Именно эта ситуация реализовалась в примерах 2.4 и 2.5. Анализируя результаты решения, можно прийти к выводу, что k как раз равно количеству вопросов с бинарными равновероятными ответами, которые определяли количество информации в задачах.

Пример 2.6

Случайным образом вынимается карта из колоды в 32 карты. Какое количество информации требуется, чтобы угадать, что это за карта? Как построить угадывание?

Для данной ситуации п = 25, значит, k = 5 и, следовательно, / = 5 бит. Последовательность вопросов придумайте самостоятельно.

Пример 2.7

В некоторой местности имеются две близкорасположенные деревни: А и В. Известно, что жители А всегда говорят правду, а жители В - всегда лгут. Известно также, что жители обеих деревень любят ходить друг к другу в гости, поэтому в каждой из деревень можно встретить жителя соседней деревни. Путешественник, сбившись ночью с пути оказался в одной из двух деревень и, заговорив с первым встречным, захотел выяснить, в какой деревне он находится и откуда его собеседник. Какое минимальное количество вопросов с бинарными ответами требуется задать путешественнику?

Количество возможных комбинаций, очевидно, равно 4 (путешественник в А, собеседник из А; путешественник в А, собеседник из В; и т.д.), т.е. п = 22 и, следовательно значит, k = 2. Последовательность вопросов придумайте самостоятельно.

Попытаемся понять смысл полученных в данном разделе результатов. Необходимо выделить ряд моментов.

1. Выражение (2.14) является статистическим определением понятия «информация», поскольку в него входят вероятности возможных исходов опыта. По сути дается операционное определение новой величины, т.е. устанавливается процедура (способ) измерения величины. Как отмечалось ранее, в науке (научном знании) именно такой метод введения новых терминов считается предпочтительным, поскольку то, что не может быть измерено, не может быть проверено и, следовательно, заслуживает меньшего доверия.

Выражение (2.13) можно интерпретировать следующим образом: если начальная энтропия опыта Н1, а в результате сообщения информации / энтропия становится равной Н2 (очевидно, Н1 ≥ Н2), то

![]()

т.е. информация равна убыли энтропии. В частном случае, если изначально равновероятных исходов было п1, а в результате передачи информации / неопределенность уменьшилась, и число исходов стало п2 (очевидно, п2 ≤ п1), то из (2.15) легко получить:

![]()

Таким образом, можно дать следующее определение:

Информация - это содержание сообщения, понижающего неопределенность некоторого опыта с неоднозначным исходом; убыль связанной с ним энтропии является количественной мерой информации.

В случае равновероятных исходов информация равна логарифму отношения числа возможных исходов до и после (получения сообщения).

2. Как уже было сказано, в статистической механике энтропия характеризует неопределенность, связанную с недостатком информации о состоянии системы. Наибольшей оказывается энтропия у равновесной полностью беспорядочной системы - о ее состоянии наша осведомленность минимальна. Упорядочение системы (наведение какого-то порядка) связано с получением некоторой дополнительной информации и уменьшением энтропии. В теории информации энтропия также отражает неопределенность, однако, это неопределенность иного рода - она связана с незнанием результата опыта с набором случайных возможных исходов. Таким образом, хотя между энтропией в физике и информатике много общего, необходимо сознавать и различие этих понятий. Совершенно очевидно, что в дальнейшем понятие энтропии будет использоваться в аспекте теории информации.

3. Следствием аддитивности энтропии независимых опытов (2.5) оказывается аддитивность информации. Пусть с выбором одного из элементов (хA) множества А, содержащего пA элементов, связано /А = log2 пA информации, а с выбором хB из В с пB элементами информации связано IB = log2 пB и второй выбор никак не связан с первым, то при объединении множеств число возможных состояний (элементов) будет п = пА ∙ пB и для выбора комбинации хAхB потребуется количество информации:

![]()

4. Вернемся к утверждению о том, что количество информации может быть измерено числом вопросов с двумя равновероятными ответами. Означает ли это, что I должна быть всегда величиной целой? Из формулы Хартли (2.15), как было показано, I = k бит (т.е. целому числу бит) только в случае п = 2k. А в остальных ситуациях? Например, при игре «Угадай-ка - 7» (угадать число от 0 до 6) нужно в выборочном каскаде задать т ≥ log2 7 = 2,807, т.е. необходимо задать три вопроса, поскольку количество вопросов - это целое число.

Однако представим, что одновременно играем в шесть таких же игр. Тогда необходимо отгадать одну из возможных комбинаций, которых всего

![]()

Следовательно, для угадывания всей шестизначной комбинации требуется I = 17 бит информации, т.е. нужно задать 17 вопросов. В среднем на один элемент (одну игру) приходится 17/3 = 2,833 вопроса, что близко к значению log2 7. Таким образом,

величина I,

определяемая описанным выше образом,

показывает, сколько в среднем необходимо

сделать парных выборов для установления

результата (полного снятия неопределенности),

если опыт повторить многократно (n

→

![]() ).

).

5. Необходимо понимать также, что не всегда с каждым из ответов на вопрос, имеющий только с два варианта ответа (будем далее называть такие вопросы бинарными), связан ровно 1 бит информации. Рассмотрим опыт, реализующийся посредством двух случайных событий; поскольку их всего два, очевидно, они являются дополнительными друг другу. Если эти события равновероятны, р1 = р2 = 1/2, и I = 1 бит, как следует из формулы Хартли и (2.14). Однако, если их вероятности различны: р1 = р, то, согласно (А.8),

p2 = 1 - р, и из (2.14) получаем функцию:

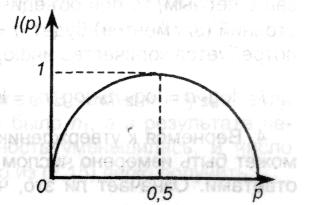

![]()

Легко показать, что при р → 0 и при р → 1 функция I(р) → 0. Ситуация может быть проиллюстрирована графиком, из которого, в частности, видно, что кривая симметрична относительно р = 0,5 и достигает максимума при этом значении. Если теперь считать, что событие 1 - это утвердительный ответ на бинарный вопрос, а событие 2 - отрицательный, то приходим к заключению:

Ответ на бинарный вопрос может содержать не более 1 бит информации; информация равна 1 бит только для равновероятных ответов; в остальных случаях она меньше 1 бит.

Пример 2.8

При угадывании результата броска игральной кости задается вопрос «Выпало 6?». Какое количество информации содержит ответ?

р= 1/6, 1 - р = 5/6, следовательно, из (2.14)

I(р) = 1/6 ∙ log2 6 + 5/6 ∙ log2 1,2 = 0,65 бит < 1 бит.

6. Формула (2.14) приводит еще к одному выводу. Пусть некоторый опыт имеет два исхода А и В, причем рА = 0,99 , а рB = 0,01. В случае исхода А получим количество информации IА = - log2 0,99 = 0,0145 бит. В случае исхода B количество информации оказывается равным IВ = - log2 0,01 = 6,644 бит. Другими словами, больше информации связано с теми исходами, которые менее вероятны. Действительно, то, что наступит именно А, почти наверняка знали и до опыта; поэтому реализация такого исхода очень мало добавляет к нашей осведомленности. Наоборот, исход В - весьма редкий; информации с ним связано больше (осуществилось трудно ожидаемое событие). Однако такое большое количество информации будем при повторах опыта получать редко, поскольку мала вероятность В. Среднее же количество информации согласно (2.14) равно I = 0,99 ∙ IА + 0,01 ∙ IВ ≈ 0,081 бит.

7. Нами рассмотрен вероятностный подход к определению количества информации. Он не является единственным. Как будет показано далее, количество информации можно связать с числом знаков в дискретном сообщении - такой способ измерения называется объемным. Можно доказать, что при любом варианте кодирования информации Iвер< Iоб.

8. Объективность информации. При использовании людьми одна и та же информация может иметь различную оценку с точки зрения значимости (важности, ценности). Определяющим в такой оценке оказывается содержание (смысл) сообщения для конкретного потребителя. Однако при решении практических задач технического характера содержание сообщения может не играть роли. Например, задача телеграфной (и любой другой) линии связи является точная и безошибочная передача сообщения без анализа того, насколько ценной для получателя оказывается связанная с ним информация. Техническое устройство не может оценить важности информации - его задача без потерь передать или сохранить информацию. Выше определили информацию как результат выбора. Такое определение не зависит от того, кто и каким образом осуществляет выбор, а связанная с ним количественная мера информации - одинаковой для любого потребителя. Следовательно, появляется возможность объективного измерения информации, при этом результат измерения - абсолютен. Это служит предпосылкой для решения технических задач. Нельзя предложить абсолютной и единой для всех меры ценности информации. С точки зрения формальной информации страница из учебника информатики или из романа «Война и мир» и страница, записанная бессмысленными значками, содержат одинаковое количество информации. Количественная сторона информации объективна, смысловая - нет. Однако, жертвуя смысловой (семантической) стороной информации, получаем объективные методы измерения ее количества, а также обретаем возможность описывать информационные процессы математическими уравнениями. Это является приближением и в то же время условием применимости законов теории информации к анализу и описанию информационных процессов.

9. Информация и знание. На бытовом уровне, в науках социальной направленности, например в педагогике «информация» отождествляется с «информированностью», т.е. человеческим знанием, которое, в свою очередь, связано с оценкой смысла информации. В теории информации же, напротив, информация является мерой нашего незнания чего-либо (но что в принципе может произойти); как только это происходит и узнаем результат, информация, связанная с данным событием, исчезает. Состоявшееся событие не несет информации, поскольку пропадает его неопределенность (энтропия становится равной нулю), и согласно (2.13) I = 0.

Последние два замечания представляются весьма важными, поскольку недопонимание указанных в них обстоятельств порождает попытки применения законов теории информации в тех сферах, где условия ее применимости не выполнены. Это, в свою очередь, порождает отрицательные результаты, которые служат причиной разочарования в самой теории. Однако любая теория, в том числе и теория информации, справедлива лишь в рамках своих исходных ограничений. С иными, в том числе философскими, аспектами понятия «информация» можно познакомиться в книге А.В. Могилева, Н. И. Пака, Е. К. Хеннера [30, с.27-30]; в ней же приводится список литературы по данному вопросу.